Kunstmatige intelligentie (AI) heeft talloze sectoren gerevolutioneerd, en een van de meest fascinerende toepassingen ervan is beeldgeneratie. Van het creëren van realistische gezichten tot het produceren van surrealistische kunstwerken, de mogelijkheid om AI-beelden te genereren heeft nieuwe mogelijkheden geopend in kunst, design en technologie. Dit artikel gaat dieper in op de mechanismen achter door AI gegenereerde beelden, de modellen die deze aansturen en de bredere implicaties van deze technologie.

De basisprincipes begrijpen: hoe werkt AI-beeldgeneratie?

Wat zijn generatieve modellen?

Generatieve modellen zijn een klasse AI-algoritmen die nieuwe data-instanties kunnen creëren die lijken op de trainingsdata. Bij het genereren van afbeeldingen leren deze modellen patronen van bestaande afbeeldingen en gebruiken deze kennis om nieuwe, vergelijkbare afbeeldingen te produceren.

De rol van neurale netwerken

De kern van AI-beeldgeneratie wordt gevormd door neurale netwerken, met name deep learning-modellen zoals convolutionele neurale netwerken (CNN's). CNN's zijn ontworpen om data te verwerken met een rasterachtige topologie, waardoor ze ideaal zijn voor beeldanalyse en -generatie. Ze detecteren patronen zoals randen, texturen en vormen, die essentieel zijn voor het begrijpen en reproduceren van beelden.

Belangrijkste AI-modellen bij het genereren van AI-beelden

Generatieve tegengestelde netwerken (GAN's)

GAN's, geïntroduceerd door Ian Goodfellow in 2014, bestaan uit twee neurale netwerken: een generator en een discriminator. De generator creëert beelden, terwijl de discriminator deze evalueert ten opzichte van echte beelden. Door dit proces verbetert de generator zijn output om steeds realistischere beelden te produceren.

StijlGAN

StyleGAN, ontwikkeld door NVIDIA, is een GAN-variant die bekendstaat om het genereren van hoogwaardige menselijke gezichten. Het introduceert een stijlgebaseerde generatorarchitectuur, die controle biedt over verschillende detailniveaus in de afbeelding. StyleGAN2 en StyleGAN3 verbeterden de beeldkwaliteit verder en pakten problemen zoals texture sticking aan.

Verspreidingsmodellen

Diffusiemodellen genereren afbeeldingen door te beginnen met willekeurige ruis en deze geleidelijk te verfijnen tot het gewenste resultaat. Ze zijn populair geworden vanwege hun vermogen om afbeeldingen van hoge kwaliteit te produceren en hun flexibiliteit in diverse toepassingen.

Stabiele diffusie

Stable Diffusion is een open-source diffusiemodel dat tekst-naar-afbeelding-generatie mogelijk maakt. Het kan ook in- en uitschilderen, wat beeldbewerking en -uitbreiding mogelijk maakt. Door het open-source karakter is het breed toegankelijk voor ontwikkelaars en kunstenaars.

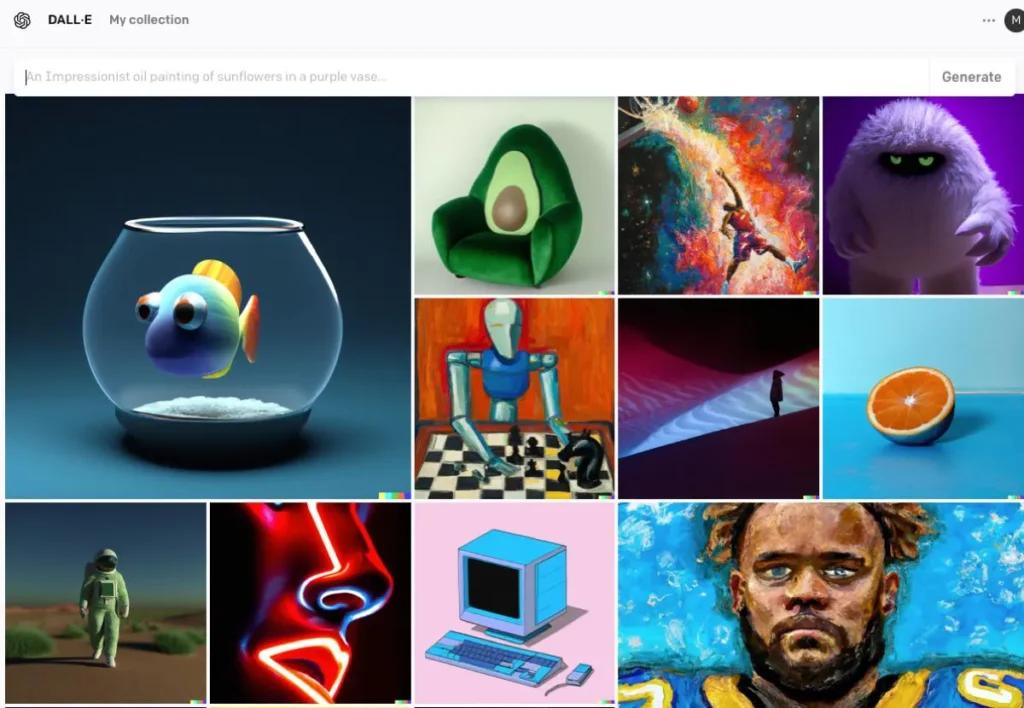

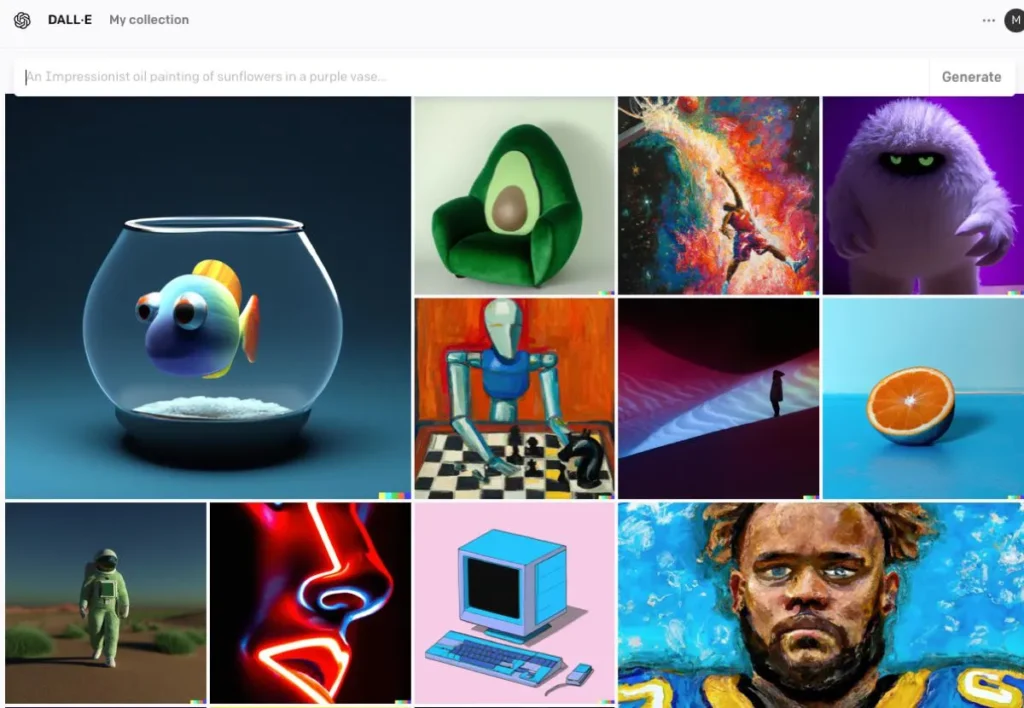

DALL · E

DALL·E, ontwikkeld door OpenAI, is een op transformers gebaseerd model dat afbeeldingen kan genereren op basis van tekstbeschrijvingen. DALL·E 2 en DALL·E 3 zijn verbeterd ten opzichte van het origineel en bieden een hogere resolutie en nauwkeurigere uitlijning van afbeelding en tekst. DALL·E 3 is geïntegreerd in ChatGPT voor verbeterde gebruikersinteractie.

Het proces van AI-beeldgeneratie

Het model trainen

AI-modellen vereisen uitgebreide training met grote datasets met afbeeldingen. Tijdens de training leert het model patronen en kenmerken in de afbeeldingen te herkennen, waardoor het nieuwe afbeeldingen kan genereren die de trainingsdata nabootsen.

Nieuwe afbeeldingen genereren

Nadat het model is getraind, kan het nieuwe afbeeldingen genereren door:

- Invoer ontvangen:Dit kan willekeurige ruis zijn (in GAN's), een tekstprompt (in DALL·E) of een bestaande afbeelding (ter bewerking). In deze stap wordt de semantische betekenis van de tekst vastgelegd, zodat de AI de inhoud en context kan begrijpen.

- Verwerking van invoer:Het model verwerkt de input via de neurale netwerklagen en past geleerde patronen en kenmerken toe. Met behulp van de gecodeerde tekst gebruikt de AI modellen zoals Generative Adversarial Networks (GAN's) of diffusiemodellen om afbeeldingen te creëren. Deze modellen genereren afbeeldingen door te beginnen met willekeurige ruis en deze te verfijnen zodat deze overeenkomt met de tekstuele beschrijving.

- Verfijning en evaluatie:De gegenereerde afbeelding wordt vervolgens verfijnd met behulp van aandachtmechanismen om de consistentie met de tekst te garanderen. Een discriminatormodel evalueert het realisme en de consistentie van de afbeelding met de invoer en geeft feedback voor verdere verfijning.

- Afbeelding uitvoeren:Het uiteindelijke resultaat is een nieuwe afbeelding die de kenmerken van de trainingsgegevens en de specifieke invoer weerspiegelt.

Codevoorbeeld van AI-beeldgeneratie

Hier zijn praktische Python-codevoorbeelden die laten zien hoe u afbeeldingen kunt genereren met behulp van drie belangrijke AI-modellen: Generative Adversarial Networks (GAN's), Stable Diffusion en DALL·E.

Generatieve Adversarial Networks (GAN's) met PyTorch

Generative Adversarial Networks (GAN's) bestaan uit twee neurale netwerken – de Generator en de Discriminator – die met elkaar concurreren om nieuwe, realistische data-instanties te genereren. Hier is een vereenvoudigd voorbeeld waarbij PyTorch wordt gebruikt om afbeeldingen te genereren:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Deze code definieert een eenvoudig generatornetwerk dat een 100-dimensionale ruisvector als invoer gebruikt en een 784-dimensionale uitvoer produceert, die kan worden omgevormd tot een 28×28-afbeelding. tanh De activeringsfunctie zorgt ervoor dat de uitvoerwaarden in het bereik liggen, wat gebruikelijk is voor beeldgegevens.

Stabiele diffusie met omhullende gezichtsdiffusers

Stable Diffusion is een krachtig tekst-naar-afbeeldingmodel dat afbeeldingen genereert op basis van tekstbeschrijvingen. Het omhelzende gezicht diffusers De bibliotheek biedt een eenvoudige interface om dit model te gebruiken:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Dit script laadt het Stable Diffusion-model en genereert een image op basis van de opgegeven prompt. Zorg ervoor dat de benodigde afhankelijkheden zijn geïnstalleerd en dat de GPU compatibel is voor optimale prestaties.

DALL·E met OpenAI API

DALL·E is een ander tekst-naar-afbeeldingmodel, ontwikkeld door OpenAI. Je kunt ermee communiceren via de API van OpenAI:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

vervangen "your-api-key" met uw daadwerkelijke OpenAI API-sleutel. Dit script stuurt een prompt naar het DALL·E-model en haalt de gegenereerde afbeelding op. De afbeelding wordt vervolgens lokaal opgeslagen.

CometAPI integreert ook DALL-E 3-API, u kunt ook de sleutel van CometAPI gebruiken om toegang te krijgen DALL-E 3-API, wat handiger en sneller is dan OpenAI.

Voor meer modelinformatie in Comet API, zie API-document.

Deze voorbeelden bieden een startpunt voor het genereren van afbeeldingen met behulp van verschillende AI-modellen. Elk model heeft zijn eigen unieke mogelijkheden en vereisten, dus kies het model dat het beste bij uw project past.

Conclusie

AI-beeldgeneratie bevindt zich op het snijvlak van technologie en creativiteit en biedt ongekende mogelijkheden voor het creëren van visuele content. Inzicht in hoe AI beelden genereert, de modellen die hierbij betrokken zijn en de implicaties van deze technologie is essentieel bij de integratie ervan in verschillende aspecten van de samenleving.

Toegang tot AI Image API in CometAPI

CometAPI biedt toegang tot meer dan 500 AI-modellen, waaronder open-source en gespecialiseerde multimodale modellen voor chat, afbeeldingen, code en meer. De belangrijkste kracht ligt in het vereenvoudigen van het traditioneel complexe proces van AI-integratie. Hiermee is toegang tot toonaangevende AI-tools zoals Claude, OpenAI, Deepseek en Gemini beschikbaar via één uniform abonnement. Je kunt de API in CometAPI gebruiken om muziek en artwork te creëren, video's te genereren en je eigen workflows te bouwen.

KomeetAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren GPT-4o-API ,Midjours-API Stabiele Diffusie API (Stabiele Diffusie XL 1.0 API) en Flux API(FLUX.1 API etc.) en nadat u zich heeft geregistreerd en ingelogd, ontvangt u $ 1 op uw account!

CometAPI integreert de nieuwste GPT-4o-image-API .