De GLM-4.5-serie, ontwikkeld door Zhipu AI (Z.ai), vertegenwoordigt een aanzienlijke vooruitgang in open-source grote taalmodellen (LLM's). GLM-4.5 is ontworpen om redenering, codering en agentische mogelijkheden te verenigen en biedt robuuste prestaties in diverse applicaties. Of u nu een ontwikkelaar, onderzoeker of liefhebber bent, deze handleiding biedt gedetailleerde informatie over hoe u de GLM-4.5-serie effectief kunt gebruiken.

Wat is de GLM-4.5-serie en waarom is deze belangrijk?

GLM-4.5 is een hybride redeneermodel dat twee verschillende modi combineert: een 'denkmodus' voor complexe redeneringen en het gebruik van tools, en een 'niet-denkmodus' voor directe reacties. Deze duale modus stelt het model in staat om een breed scala aan taken efficiënt uit te voeren. De serie omvat twee hoofdvarianten:

- GLM-4.5:Dit model beschikt over 355 miljard parameters in totaal, met 32 miljard actieve parameters. Het is ontworpen voor grootschalige implementatie in redeneer-, generatie- en multi-agenttaken.

- GLM-4.5-Lucht: Een lichtgewicht versie met 106 miljard totale parameters en 12 miljard actieve parameters, geoptimaliseerd voor on-device en kleinschaligere cloud-inferentie zonder dat dit ten koste gaat van de kerncapaciteiten.

Beide modellen ondersteunen hybride redeneermodi en bieden 'denkende' en 'niet-denkende' modi om complexe redeneertaken en snelle reacties in evenwicht te brengen. Ze zijn open source en vrijgegeven onder de MIT-licentie, waardoor ze toegankelijk zijn voor commercieel gebruik en secundaire ontwikkeling.

Architectuur- en ontwerpprincipes

In essentie maakt GLM-4.5 gebruik van MoE om tokens dynamisch te routeren via gespecialiseerde expert-subnetwerken, wat zorgt voor superieure parameterefficiëntie en schaalbaarheid (). Deze aanpak betekent dat er minder parameters per voorwaartse doorgang geactiveerd hoeven te worden, wat de operationele kosten verlaagt en tegelijkertijd de beste prestaties op het gebied van redeneer- en coderingstaken behoudt ().

Belangrijkste mogelijkheden

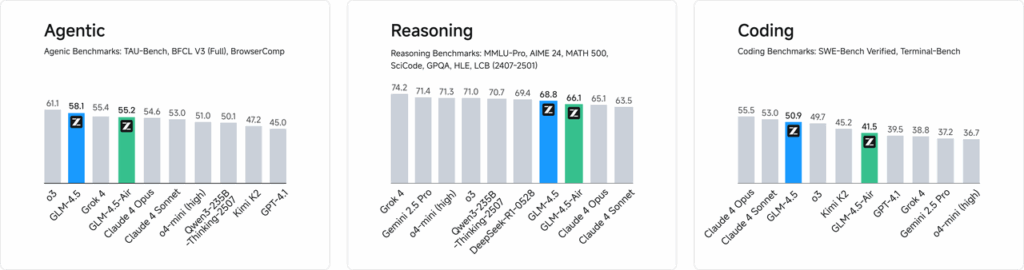

- Hybride redeneren en coderen: GLM-4.5 demonstreert SOTA-prestaties in zowel benchmarks voor het begrijpen van natuurlijke taal als in tests voor codegeneratie, en kan qua nauwkeurigheid en vloeiendheid vaak concurreren met gepatenteerde modellen.

- Agentische integratie: Ingebouwde interfaces voor het aanroepen van tools zorgen ervoor dat GLM-4.5 workflows met meerdere stappen, zoals databasequery's, API-orkestratie en interactieve front-endgeneratie, binnen één sessie kan orkestreren.

- Multimodale artefacten:Van HTML/CSS-miniapps tot Python-gebaseerde simulaties en interactieve SVG's, GLM-4.5 kan volledig functionele artefacten produceren, waardoor de betrokkenheid van gebruikers en de productiviteit van ontwikkelaars worden verbeterd.

Waarom is GLM-4.5 een game-changer?

GLM-4.5 is niet alleen geprezen vanwege de uitstekende prestaties, maar ook vanwege het feit dat het de waardepropositie van open-source LLM's in bedrijfs- en onderzoeksomgevingen opnieuw definieert.

Prestatiebenchmarks

In onafhankelijke evaluaties van 52 programmeertaken – van webontwikkeling en data-analyse tot automatisering – presteerde GLM-4.5 consistent beter dan andere toonaangevende open-sourcemodellen op het gebied van betrouwbaarheid van toolcalling en algehele taakvoltooiing. In vergelijkende tests met Claude Code, Kimi-K2 en Qwen3-Coder behaalde GLM-4.5 de beste scores in zijn klasse op benchmarks zoals het "SWE-bench Verified"-klassement.

Kostenefficiënt toezicht

Naast nauwkeurigheid verlaagt het MoE-ontwerp van GLM-4.5 de inferentiekosten aanzienlijk. De openbare prijzen voor API-aanroepen beginnen bij RMB 0.8 per miljoen inputtokens en RMB 2 per miljoen outputtokens – ongeveer een derde van de kosten van vergelijkbare eigen oplossingen. Gecombineerd met piekgeneratiesnelheden van 100 tokens/sec. ondersteunt het model implementaties met een hoge doorvoer en lage latentie zonder buitensporige kosten.

Hoe krijgt u toegang tot GLM-4.5?

1. Directe toegang via het Z.ai-platform

De eenvoudigste manier om met GLM-4.5 te communiceren is via het Z.ai-platform. Door chat.z.aiGebruikers kunnen het GLM-4.5-model selecteren en via een gebruiksvriendelijke interface direct met de app communiceren. Dit platform maakt direct testen en prototypen mogelijk zonder complexe integraties. Gebruikers kunnen linksboven het GLM-4.5- of GLM-4.5-Air-model selecteren en direct beginnen met chatten. Deze interface is gebruiksvriendelijk en vereist geen installatie, waardoor deze ideaal is voor snelle interacties en demonstraties.

2. API-toegang voor ontwikkelaars

Voor ontwikkelaars die GLM-4.5 in applicaties willen integreren, biedt het Z.ai API-platform uitgebreide ondersteuning. De API biedt OpenAI-compatibele interfaces voor zowel GLM-4.5- als GLM-4.5-Air-modellen, wat een naadloze integratie in bestaande workflows mogelijk maakt. Gedetailleerde documentatie en integratierichtlijnen zijn beschikbaar op Z.ai API-documentatie .

3. Open-source-implementatie

Voor degenen die geïnteresseerd zijn in lokale implementatie, zijn GLM-4.5-modellen beschikbaar op platforms zoals Hugging Face en ModelScope. Deze modellen worden vrijgegeven onder de MIT open-sourcelicentie, wat commercieel gebruik en secundaire ontwikkeling mogelijk maakt. Ze kunnen worden geïntegreerd met gangbare inferentieframeworks zoals vLLM en SGLang.

4. Integratie met CometAPI

KomeetAPI biedt gestroomlijnde toegang tot GLM-4.5-modellen via hun uniforme API-platform op DasboradDeze integratie vereenvoudigt authenticatie, snelheidsbeperking en foutafhandeling, waardoor het een uitstekende keuze is voor ontwikkelaars die op zoek zijn naar een probleemloze installatie. Bovendien maakt het gestandaardiseerde API-formaat van CometAPI eenvoudige modelwisseling en A/B-testen tussen GLM-4.5 en andere beschikbare modellen mogelijk.

Hoe krijgen ontwikkelaars toegang tot de GLM-4.5-serie?

Er zijn meerdere kanalen voor het verkrijgen en implementeren van GLM-4.5, van directe modeldownloads tot beheerde API's.

Via Hugging Face en ModelScope

Zowel Hugging Face als ModelScope hosten de volledige GLM-4.5-serie onder de zai-org-naamruimte. Na akkoord te zijn gegaan met de MIT-licentie, kunnen ontwikkelaars:

- Kloon de opslagplaats:

git clone https://huggingface.co/zai-org/GLM-4.5

- Afhankelijkheden installeren:

pip install transformers accelerate

- Laad het model:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Via CometAPI

KomeetAPI biedt een serverloze API voor GLM‑4.5 en GLM-4.5 Lucht API tegen betaling per token-tarieven, toegankelijk via, door het configureren van OpenAI-compatibele eindpunten, kunt u GLM-4.5 aanroepen via de Python-client van OpenAI met minimale aanpassingen aan bestaande codebases. CometAPI biedt niet alleen GLM4.5 en GLM-4.5-air, maar ook alle officiële modellen:

| Modelnaam | voorstellen | Prijs |

glm-4.5 | Ons krachtigste redeneermodel, met 355 miljard parameters | Invoertokens $0.48 Uitvoertokens $1.92 |

glm-4.5-air | Kosteneffectieve lichtgewicht sterke prestaties | Invoertokens $0.16 Uitvoertokens $1.07 |

glm-4.5-x | Hoge prestaties, sterk redeneren, ultrasnelle respons | Invoertokens $1.60 Uitvoertokens $6.40 |

glm-4.5-airx | Lichtgewicht, sterke prestaties, ultrasnelle respons | Invoertokens $0.02 Uitvoertokens $0.06 |

glm-4.5-flash | Sterke prestaties, uitstekend voor redeneren, codering en agenten | Invoertokens $3.20 Uitvoertokens $12.80 |

Python en REST API-integratie

Voor implementaties op maat kunnen organisaties GLM-4.5 hosten op speciale GPU-clusters met Docker of Kubernetes. Een typische RESTful-configuratie omvat:

Inference Server starten:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Verzoeken verzenden:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Wat zijn de beste werkwijzen voor het integreren van GLM-4.5 in applicaties?

Om het rendement op uw investering te maximaliseren en robuuste prestaties te garanderen, moeten teams rekening houden met het volgende:

API-optimalisatie en snelheidslimieten

- Batching-verzoeken: Groepeer vergelijkbare prompts om de overhead te verminderen en de GPU-doorvoer te optimaliseren.

- Veelvoorkomende query's cachen: Sla frequente aanvullingen lokaal op om redundante inferentieaanroepen te voorkomen.

- Adaptieve bemonstering: Dynamisch aanpassen

temperatureentop_pop basis van de complexiteit van de vraag, om creativiteit en determinisme in evenwicht te brengen.

Beveiliging en naleving

- Gegevensopschoning: Verwerk invoer vooraf om gevoelige informatie te verwijderen voordat deze naar het model wordt verzonden.

- Access Controle: Implementeer API-sleutels, IP-toestaanlijsten en snelheidsbeperking om misbruik te voorkomen.

- Auditregistratie: Registreer prompts, aanvullingen en metagegevens om te voldoen aan de vereisten van het bedrijf en de regelgeving, met name in de financiële of gezondheidszorgsector.

Beginnen

CometAPI is een uniform API-platform dat meer dan 500 AI-modellen van toonaangevende aanbieders – zoals de GPT-serie van OpenAI, Gemini van Google, Claude, Midjourney en Suno van Anthropic – samenvoegt in één, gebruiksvriendelijke interface voor ontwikkelaars. Door consistente authenticatie, aanvraagopmaak en responsverwerking te bieden, vereenvoudigt CometAPI de integratie van AI-mogelijkheden in uw applicaties aanzienlijk. Of u nu chatbots, beeldgenerators, muziekcomponisten of datagestuurde analysepipelines bouwt, met CometAPI kunt u sneller itereren, kosten beheersen en leveranciersonafhankelijk blijven – en tegelijkertijd profiteren van de nieuwste doorbraken in het AI-ecosysteem.

Voor ontwikkelaars die GLM-4.5 in hun applicaties willen integreren, biedt het CometAPI-platform een robuuste oplossing. De API biedt OpenAI-compatibele interfaces, wat een naadloze integratie in bestaande workflows mogelijk maakt. Gedetailleerde documentatie en gebruiksrichtlijnen zijn beschikbaar op de Comet API-pagina.

Ontwikkelaars hebben toegang tot GLM‑4.5 en GLM-4.5 Lucht API brengt KomeetAPIDe nieuwste modellen die vermeld staan, gelden vanaf de publicatiedatum van het artikel. Om te beginnen, verken de mogelijkheden van het model in de Speeltuin en raadpleeg de API-gids voor gedetailleerde instructies. Zorg ervoor dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen voordat u toegang krijgt. KomeetAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren.

Conclusie

GLM-4.5 vertegenwoordigt een aanzienlijke vooruitgang op het gebied van grote taalmodellen en biedt een veelzijdige oplossing voor een breed scala aan toepassingen. De hybride redeneerarchitectuur, agentische mogelijkheden en open-source karakter maken het een aantrekkelijke optie voor ontwikkelaars en organisaties die geavanceerde AI-technologieën willen benutten. Door de verschillende toegangsmethoden die in deze handleiding worden beschreven te verkennen, kunnen gebruikers GLM-4.5 effectief integreren in hun projecten en bijdragen aan de voortdurende ontwikkeling ervan.