OpenAI heeft onlangs verschillende updates aangekondigd, waaronder de release van het GPT-5-Codex-Mini-model, verbeteringen aan de snelheidslimiet voor hiërarchieën met meerdere gebruikers en optimalisaties om de verwerkingsefficiëntie van modellen te optimaliseren.

OpenAI's GPT-5-Codex-Mini is een onlangs aangekondigde, op ontwikkelaars gerichte variant van GPT-5-Codex: een kleiner, kosten- en doorvoergeoptimaliseerd model dat bedoeld is om de meeste codeerondersteuning van GPT-5-Codex te bieden, maar tegen veel lagere kosten en een hoger bruikbaar volume. De "Mini"-variant is gepositioneerd als een pragmatische keuze voor lange codeersessies, achtergrondautomatisering en hoogfrequente ontwikkelaarsworkflows waarbij de maximale capaciteit minder belangrijk is dan het verkrijgen van meer tokens/aanvragen voor hetzelfde plan.

Wat is GPT-5-Codex-Mini en wat zijn de kenmerken ervan?

GPT-5-Codex-Mini is een compacte, kostenefficiënte variant van OpenAI's GPT-5-Codex-familie, speciaal ontwikkeld voor de Codex-productoppervlakken (CLI- en IDE-integratie). Het wordt gepositioneerd als een "kleiner, kostenefficiënter" model dat een kleine piekcapaciteit inruilt voor een aanzienlijk lager resourceverbruik en een hogere bruikbare quota voor interactieve ontwikkelaarsworkflows. Het minimodel is bedoeld om ontwikkelaars in staat te stellen veel meer codeerbeurten te draaien (OpenAI beschrijft grofweg 4× meer gebruik voor hetzelfde ChatGPT-abonnementsniveau) terwijl de latentie en kosten laag blijven voor veelvoorkomende, goed gedefinieerde technische taken.

Qua mogelijkheden erft GPT-5-Codex-Mini de kernfuncties van de Codex-productlijn: diepgaande kennis van de codebase en de uitvoering van meerstapstaken op een 'agent'-manier. Dankzij de functies van de Codex CLI kunnen ontwikkelaars opdrachten in natuurlijke taal, codefragmenten, screenshots of interface-ontwerpdiagrammen naar Codex sturen via een interactieve terminal. Het model levert eerst een plan op en bladert vervolgens automatisch door bestanden, bewerkt code, voert opdrachten uit en test deze na goedkeuring van de gebruiker.

Vanuit een modaal perspectief maken Codex-producten het mogelijk om afbeeldingen (zoals UI-screenshots, ontwerptekeningen of screenshots van foutmeldingen) toe te voegen aan de sessie in de terminal of IDE. Het model kan zowel tekst als afbeeldingen begrijpen, maar de uitvoer bestaat nog steeds voornamelijk uit tekstcode en uitleg. Daarom kan GPT-5-Codex-Mini worden beschouwd als een codeproxymodel dat voornamelijk bestaat uit "tekst + afbeeldingsinvoer, tekstuitvoer" en geen taken uitvoert zoals het genereren van afbeeldingen, audio of video.

Hoe verhoudt GPT-5-Codex-Mini zich tot GPT-5-Codex?

Wat is er nieuw in Codex?

Naast de realisatie van GPT-5-Codex-Mini heeft OpenAI de Codex-snelheidslimiet uniform met 50% verhoogd voor ChatGPT Plus, Business en Edu-gebruikers, waardoor de beschikbare verzoeklimiet aanzienlijk is verhoogd. ChatGPT Pro-gebruikers krijgen bovendien prioriteit bij verwerkingsmachtigingen om de reactiesnelheid en de taakuitvoering te verbeteren.

Bovendien heeft OpenAI een kleine upgrade uitgevoerd aan het GPT-5-Codex-model, waardoor de prestaties in samenwerkingsscenario's zijn geoptimaliseerd. Het bijgewerkte model laat verbeteringen van enkele procentpunten zien op belangrijke evaluatiecijfers, een toename van ongeveer 3% in de efficiëntie van tokengebruik en een grotere robuustheid in het omgaan met edge cases, waardoor de behoefte aan gebruikersbegeleiding afneemt.

| gebruikers level | GPT-5-Codex | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Zakelijk/Onderwijs | verhoogt het berichtenvolume respectievelijk met 1.5x. | verhoogt het berichtenvolume respectievelijk met 6x. |

GPT-5-Codex-Mini versus GPT-5-Codex: verschillen in benchmarks

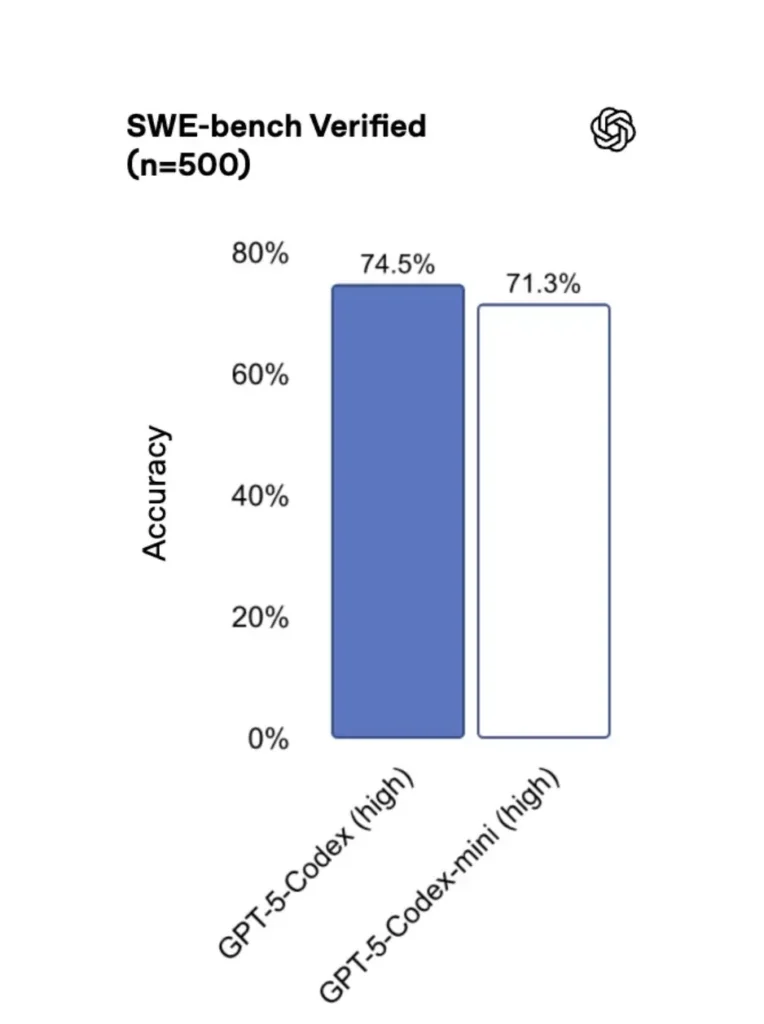

GPT-5-Codex-Mini presteert iets minder dan de originele versie, maar ontwikkelaars krijgen ongeveer vier keer zoveel credits voor het gebruik. In de SWE-bench Verified-test scoorde GPT-5 High 72.8%, GPT-5-Codex 74.5% en GPT-5-Codex-Mini 71.3%.

Codex (en de minivariant ervan) gebruiken aanzienlijk minder tokens voor lichte interacties. OpenAI's materialen beweren dat er voor eenvoudige prompts (bijvoorbeeld een geciteerd cijfer van ≈93.7% minder tokens (over lichtgewicht interacties voor de Codex-familie versus GPT-5 in sommige scenario's).

GPT-5-Codex-Mini versus GPT-5-Codex: functieverschillen

- Grootte en kosten: Mini is expliciet kleiner en kostenefficiënter; OpenAI stelt dat het ongeveer 4x meer gebruik mogelijk maakt onder dezelfde abonnementsbeperkingen. Dit is een quotum-/efficiëntie-optimalisatie voor routinematige taken voor ontwikkelaars.

- Capaciteitsenvelop: GPT-5-Codex blijft de optie met de hoogste capaciteit voor lange, complexe agenttaken (grote refactorings, diepgaande codereviews, uitgebreide testcycli). Mini is geoptimaliseerd voor snellere en minder resource-intensieve interacties met frequente korte intervallen.

- Latentie- en snelheidslimieten: Mini levert doorgaans een lagere latentie en staat hogere snelheidslimieten per plan toe, waardoor het geschikt is voor drukke, interactieve workflows.

- Standaardoppervlakken: Mini is beschikbaar als selecteerbaar model in Codex CLI en de IDE Extension; GPT-5-Codex is de standaard voor cloudtaken en deep code review flows in Codex.

Wanneer Mini vs. Full Codex gebruiken

- Gebruik Mini voor: steigerwerk, repetitieve codegeneratie, kleine refactoringen, interactieve aanvullingen tijdens het bewerken en bij het werken met een quotum- of kostenbeperking.

- Gebruik GPT-5-Codex voor: uitgebreide codebeoordelingen, autonome taken van meerdere uren, complexe refactoringen en taken die de sterkste redenering van het model en testgestuurde uitvoering vereisen.

Hoe krijg ik toegang tot GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (terminal-eerst)

OpenAI geïntroduceerd gpt-5-codex-mini als modeloptie in de Codex CLI. Typische gebruikspatronen volgen de workflow van de Codex CLI: start een interactieve sessie, specificeer het model, voeg bestanden of screenshots toe, voer 'Codex Cloud-taken' uit, en meer. De CLI ondersteunt ook snelle /model schakelen tussen volledige gpt-5-codex en gpt-5-codex-miniBij de eerste uitvoering moet u zich authenticeren met uw ChatGPT/Pro/Enterprise-account (of een API-sleutel opgeven). De CLI biedt verschillende opdrachten waarmee Codex codebases kan scannen, tests kan uitvoeren, REPL's kan openen of patchaanbevelingen kan toepassen.

Voorbeeld (interactieve Codex CLI-sessie):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Die stroom weerspiegelt de nieuwe Codex CLI-standaardinstellingen, waarbij de tool Mini-gebruikslimieten voorstelt die dicht bij de norm liggen.

VS Code / IDE-extensie

Ja - de Codex IDE-extensie (VS Code) bevat al gpt-5-codex-mini Optioneel. Installeer de Codex-extensie in Visual Studio Code voor inline codeaanvulling, refactoringsuggesties en AI-gestuurde snelle oplossingen. De extensie biedt ook snelle acties (code genereren, geselecteerde code uitleggen, refactoren) en kan Codex Cloud-taken uitvoeren vanuit de editor, VS Code-stappen:

- Installeer de OpenAI Codex/ChatGPT-extensie voor VS Code.

- Meld u aan met uw ChatGPT-account (Plus/Pro/Business).

- Open het opdrachtenpalet:

Cmd/Ctrl+Shift+P → Codex: Set Model→ kiezengpt-5-codex-mini. - Gebruik inline-opdrachten (code selecteren → rechtsklikken → “Uitleggen met Codex” of op de geconfigureerde sneltoets drukken).

Voorbeeld: VS Code inline-opdracht (pseudo-stappen)

- Selecteer een functie in

user_service.py. - Media

Cmd/Ctrl+Shift+P → Codex: Explain Selectionof gebruik de rechtermuisknop → “Uitleggen met Codex.” - De extensie opent een zijpaneel met Mini's uitleg, voorgestelde tests en een knop 'PR maken' met één klik waarmee Codex Cloud-taken kunnen worden gebruikt om een branch te pushen voor beoordeling.

Hoe zit het met de API? Kan ik die vanuit mijn app aanroepen?

De aankondigingen van OpenAI geven aan API-ondersteuning komt binnenkort voor GPT-5-Codex-Mini; op het moment van schrijven is het model eerst beschikbaar in de Codex-toolchain (CLI/IDE). Dit betekent dat productie-API-clients zich moeten voorbereiden op de modelnaam. gpt-5-codex-mini in de Requests/Responses API zodra deze is gepubliceerd. In de tussentijd kunt u prototypen maken met de Codex CLI en IDE-flows.

Wanneer API-toegang is ingeschakeld, kan een typische aanroep (in responsstijl) er als volgt uitzien:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Wat zijn de beste werkwijzen voor rapid engineering met Codex Mini?

Hieronder vindt u concrete, in de praktijk geteste best practices en patronen om maximale waarde uit Codex Mini te halen in productietechnische workflows.

1) Modelselectiestrategie – mixen en matchen

Gebruik Mini voor taken met een hoge frequentie en een lagere complexiteit (opmaak, kleine refactorings, automatische tests) en schakel terug naar de volledige Codex voor complex ontwerp, diepgaande debugging of grote repo-brede transformaties. Automatiseer de overstap: de Codex CLI suggereert Mini al bij 90% gebruik, en je kunt scripts gebruiken. /model Schakelen in uw tooling om een model te kiezen op basis van de complexiteit van de taak.

2) Snelle technische sjablonen

Maak kleine, deterministische promptsjablonen voor herhaalbare taken: testgeneratie, changelog-concepten, het genereren van commitberichten en PR-beschrijvingen. Sla deze op als herbruikbare fragmenten in je repository of als Codex-promptpresets.

Voorbeeld van een promptsjabloon voor unittests:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Automatiseer veiligheidsnetten - goedkeuringen en CI-poorten

Sta nooit toe dat een model rechtstreeks code pusht zonder menselijke goedkeuring. Gebruik de goedkeuringsmodi van Codex en Codex Cloud-taken om diffs te maken en menselijke goedkeuring in CI te vereisen. De Codex CLI ondersteunt "goedkeuringsmodi", waardoor bewerkingen moeten worden goedgekeurd voordat ze worden toegepast.

4) Modeloproepen cachen en dedupliceren

Voor repetitieve prompts (bijvoorbeeld het uitleggen van een functie) cachet u het antwoord met de sleutel prompt + bestandshash. Dit vermindert redundante aanroepen en houdt het kostenprofiel voorspelbaar.

5) Gebruik streaming + incrementele verschillen

Vraag indien mogelijk streaming outputs en incrementele diffs aan in plaats van volledige bestandsherschrijvingen. Dit vermindert het tokengebruik en helpt reviewers om gerichte wijzigingen te zien.

6) Eenheidstest - eerste generatorstroom

Genereer tests en voer ze lokaal uit in een tijdelijke omgeving. Als tests mislukken, herhaal dan de iteratie met het model dat oplossingen voor de falende test levert. Formuleer elke iteratie als een afzonderlijke prompt met de testresultaten inbegrepen.

Voorbeeld Codex CLI-automatiseringsfragment (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Conclusie

GPT-5-Codex-Mini is een pragmatische productstap: het erkent dat de workflows van ontwikkelaars vaak worden gedomineerd door veel korte interacties waarbij latentie, kosten en een ononderbroken doorstroming van belang zijn. Door een mini-laag te bieden die gericht is op IDE- en CLI-gebruik, geeft OpenAI teams de mogelijkheid om de dagelijkse codeerondersteuning op te schalen zonder direct het model met de hoogste kosten voor elke interactie in te schakelen.

Ontwikkelaars hebben toegang tot GPT-5-Codex API ,GPT-5 Pro API Via CometAPI zijn de nieuwste modellen van CometAPI vermeld vanaf de publicatiedatum van het artikel. Voordat u toegang krijgt, dient u ervoor te zorgen dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen.KomeetAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren.

Klaar om te gaan?→ Meld u vandaag nog aan voor CometAPI !

Als u meer tips, handleidingen en nieuws over AI wilt weten, volg ons dan op VK, X en Discord!