In 2025-2026 consolideerde het AI-toollandschap zich verder: gateway-API's (zoals CometAPI) breidden zich uit om OpenAI-achtige toegang tot honderden modellen te bieden, terwijl LLM-apps voor eindgebruikers (zoals AnythingLLM) hun "Generic OpenAI"-provider verder verbeterden, zodat desktop- en local-first apps elk OpenAI-compatibel eindpunt konden aanroepen. Dit maakt het vandaag de dag eenvoudig om AnythingLLM-verkeer via CometAPI te routeren en te profiteren van de voordelen van modelkeuze, kostenroutering en uniforme facturering – terwijl de lokale gebruikersinterface en RAG/agent-functies van AnythingLLM behouden blijven.

Wat is AnythingLLM en waarom zou je het willen verbinden met CometAPI?

Wat is AnythingLLM?

AnythingLLM is een open-source, alles-in-één AI-applicatie en lokale/cloudclient voor het bouwen van chatassistenten, retrieval-augmented generation (RAG) workflows en LLM-gestuurde agents. Het biedt een gestroomlijnde gebruikersinterface, een API voor ontwikkelaars, werkruimte-/agentfuncties en ondersteuning voor lokale en cloud-LLM's – standaard ontworpen om privé te zijn en uitbreidbaar via plug-ins. AnythingLLM biedt een Generieke OpenAI provider die het mogelijk maakt om te communiceren met OpenAI-compatibele LLM API's.

Wat is CometAPI?

CometAPI is een commercieel API-aggregatieplatform dat 500+ AI-modellen via één REST-interface in OpenAI-stijl en uniforme facturering. In de praktijk kunt u hiermee modellen van meerdere leveranciers (OpenAI, Anthropic, Google/Gemini-varianten, afbeeldings-/audiomodellen, enz.) via dezelfde interface aanroepen. https://api.cometapi.com/v1 eindpunten en een enkele API-sleutel (formaat sk-xxxxx). CometAPI ondersteunt standaard eindpunten in OpenAI-stijl, zoals /v1/chat/completions, /v1/embeddings, enz., waardoor het eenvoudig is om tools aan te passen die al OpenAI-compatibele API's ondersteunen.

Waarom AnythingLLM integreren met CometAPI?

Drie praktische redenen:

- Modelkeuze en leveranciersflexibiliteit: AnythingLLM kan "elke OpenAI-compatibele" LLM gebruiken via zijn generieke OpenAI-wrapper. Door die wrapper naar CometAPI te verwijzen, krijg je direct toegang tot honderden modellen zonder de gebruikersinterface of flows van AnythingLLM te wijzigen.

- Kosten-/operatieoptimalisatie: Met CometAPI kunt u centraal van model wisselen (of terugschakelen naar goedkopere modellen) om zo de kosten te beheersen. Bovendien behoudt u de uniforme facturering in plaats van te jongleren met meerdere providercodes.

- Sneller experimenteren: U kunt A/B-modellen gebruiken voor verschillende modellen (bijv.

gpt-4o,gpt-4.5, Claude-varianten of open-source multimodale modellen) via dezelfde AnythingLLM-gebruikersinterface — handig voor agenten, RAG-reacties, samenvattingen en multimodale taken.

De omgeving en de omstandigheden die u moet voorbereiden voordat u integreert

Systeem- en softwarevereisten (hoog niveau)

- Desktop of server met AnythingLLM (Windows, macOS, Linux) — desktopinstallatie of zelfgehoste instance. Controleer of u een recente build gebruikt die de LLM-voorkeuren / AI-leveranciers instellingen.

- CometAPI-account en een API-sleutel (de

sk-xxxxxstijlgeheim). U gebruikt dit geheim in de generieke OpenAI-provider van AnythingLLM. - Netwerkconnectiviteit van uw machine naar

https://api.cometapi.com(geen firewall die uitgaande HTTPS blokkeert). - Optioneel maar aanbevolen: een moderne Python- of Node-omgeving voor het testen (Python 3.10+ of Node 18+), curl en een HTTP-client (Postman / HTTPie) om CometAPI te controleren voordat u deze aan AnythingLLM koppelt.

AnythingLLM-specifieke voorwaarden

Het Generieke OpenAI Een LLM-provider is de aanbevolen route voor eindpunten die het API-oppervlak van OpenAI nabootsen. De documentatie van AnythingLLM waarschuwt dat deze provider gericht is op ontwikkelaars en dat u de invoer die u verstrekt, moet begrijpen. Als u streaming gebruikt of uw eindpunt streaming niet ondersteunt, bevat AnythingLLM een instelling om streaming voor Generic OpenAI uit te schakelen.

Veiligheids- en operationele checklist

- Behandel de CometAPI-sleutel als elk ander geheim: sla hem niet op in repositories, maar bewaar hem waar mogelijk in OS-sleutelhangers of omgevingsvariabelen.

- Als u van plan bent om gevoelige documenten in RAG te gebruiken, zorg er dan voor dat de endpoint-privacygaranties voldoen aan uw nalevingsbehoeften (raadpleeg de documentatie/voorwaarden van CometAPI).

- Stel maximale tokens en limieten voor het contextvenster in om te voorkomen dat rekeningen uit de hand lopen.

Hoe configureer je AnythingLLM voor gebruik van CometAPI (stap voor stap)?

Hieronder vindt u een concrete stappenreeks, gevolgd door voorbeeldomgevingsvariabelen en codefragmenten voor het testen van de verbinding voordat u de instellingen opslaat in de AnythingLLM-gebruikersinterface.

Stap 1: Haal uw CometAPI-sleutel op

- Registreer u of meld u aan bij CometAPI.

- Navigeer naar 'API-sleutels' en genereer een sleutel. Je krijgt dan een string die eruitziet als

sk-xxxxxHoud het geheim.

Stap 2 — Controleer of CometAPI werkt met een snelle aanvraag

Gebruik curl of Python om een eenvoudig chatvoltooiingseindpunt aan te roepen om de connectiviteit te bevestigen.

Krulvoorbeeld

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Als dit een 200 en een JSON-respons met een retourneert choices array, uw sleutel en netwerk werken. (De documentatie van CometAPI toont het OpenAI-stijl oppervlak en eindpunten).

Python-voorbeeld (verzoeken)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

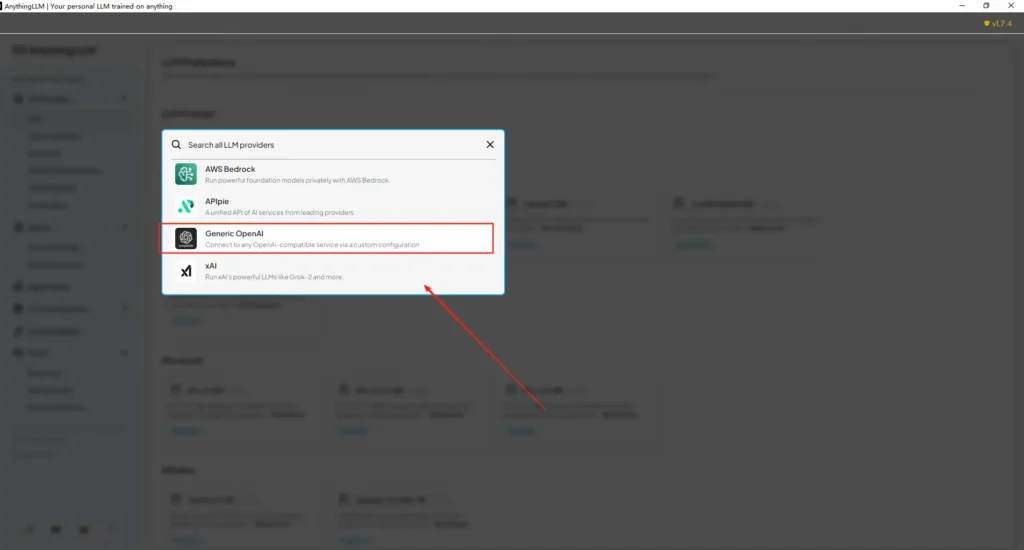

Stap 3 — AnythingLLM configureren (UI)

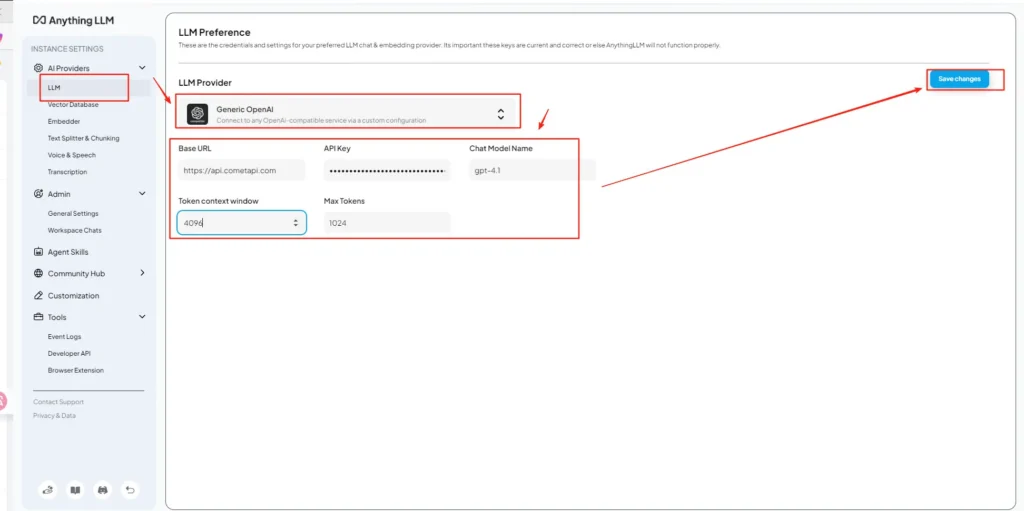

Open AnythingLLM → Instellingen → AI-leveranciers → LLM-voorkeuren (of een vergelijkbaar pad in uw versie). Gebruik de Generieke OpenAI provider en vul de velden als volgt in:

API-configuratie (voorbeeld)

• Ga naar het instellingenmenu van AnythingLLM en zoek LLM-voorkeuren onder AI-providers.

• Selecteer Generic OpenAI als modelprovider, voer inhttps://api.cometapi.com/v1in het URL-veld.

• Plak desk-xxxxxvan CometAPI in het invoerveld voor de API-sleutel. Vul het contextvenster Token en het maximum aantal tokens in op basis van het daadwerkelijke model. U kunt op deze pagina ook modelnamen aanpassen, zoals het toevoegen vangpt-4omodel.

Dit is in lijn met de richtlijnen van AnythingLLM voor 'Generic OpenAI' (ontwikkelaarswrapper) en de OpenAI-compatibele basis-URL-benadering van CometAPI.

Stap 4 — Modelnamen en tokenlimieten instellen

Op hetzelfde instellingenscherm kunt u modelnamen toevoegen of aanpassen precies zoals CometAPI ze publiceert (bijv. gpt-4o, minimax-m2, kimi-k2-thinking) zodat de AnythingLLM-gebruikersinterface deze modellen aan gebruikers kan presenteren. CometAPI publiceert modelstrings voor elke leverancier.

Stap 5 - Test in AnythingLLM

Start een nieuwe chat of gebruik een bestaande werkruimte, selecteer de generieke OpenAI-provider (als je meerdere providers hebt), kies een van de CometAPI-modelnamen die je hebt toegevoegd en voer een eenvoudige prompt uit. Als je coherente aanvullingen krijgt, ben je geïntegreerd.

Hoe AnythingLLM deze instellingen intern gebruikt

De generieke OpenAI-wrapper van AnythingLLM construeert OpenAI-stijl verzoeken (/v1/chat/completions, /v1/embeddings), dus zodra u de basis-URL aanwijst en de CometAPI-sleutel opgeeft, zal AnythingLLM chats, agentgesprekken en embeddingsverzoeken transparant via CometAPI routeren. Als u AnythingLLM-agenten gebruikt (de @agent stromen), erven ze dezelfde provider.

Wat zijn de beste werkwijzen en mogelijke valkuilen?

Beste praktijken

- Gebruik modelgeschikte contextinstellingen: Koppel het Token Context Window en Max Tokens van AnythingLLM aan het model dat u op CometAPI kiest. Mismatch leidt tot onverwachte afkapping of mislukte aanroepen.

- Beveilig uw API-sleutels: Sla CometAPI-sleutels op in omgevingsvariabelen en/of Kubernetes/secret manager; check ze nooit in in Git. AnythingLLM slaat sleutels op in de lokale instellingen als je ze in de gebruikersinterface invoert. Behandel de hostopslag als gevoelig.

- Begin met goedkopere/kleinere modellen voor experimentele stromen: Gebruik CometAPI om goedkopere modellen te testen voor ontwikkeling en reserveer premiummodellen voor productie. CometAPI promoot expliciet kostenomschakeling en uniforme facturering.

- Gebruik bewaken en waarschuwingen instellen: CometAPI biedt gebruiksdashboards: stel budgetten/waarschuwingen in om onverwachte rekeningen te voorkomen.

- Testagenten en hulpmiddelen geïsoleerd: AnythingLLM-agenten kunnen acties activeren; test ze eerst met veilige prompts en op staging-instanties.

Veel voorkomende valkuilen

- UI versus

.envconflicten: Bij zelfhosting kunnen UI-instellingen overschreven worden.envveranderingen (en vice versa). Controleer de gegenereerde/app/server/.envals de zaken na een herstart weer terugkeren. Rapport van communityproblemenLLM_PROVIDERwordt gereset. - Modelnaam komt niet overeen: Het gebruik van een modelnaam die niet beschikbaar is op CometAPI, veroorzaakt een 400/404-foutmelding van de gateway. Controleer altijd de beschikbare modellen in de CometAPI-modellijst.

- Tokenlimieten en streaming: Als u streamingreacties nodig hebt, controleer dan of het CometAPI-model streaming ondersteunt (en de UI-versie van AnythingLLM dit ondersteunt). Sommige providers verschillen in de semantiek van streaming.

Welke praktische use cases worden door deze integratie mogelijk?

Retrieval-augmented generatie (RAG)

Gebruik de documentloaders en vectordatabases van AnythingLLM met CometAPI LLM's om contextbewuste antwoorden te genereren. Je kunt experimenteren met goedkope embedding en dure chatmodellen, of alles op CometAPI houden voor uniforme facturering. De RAG-stromen van AnythingLLM zijn een belangrijke ingebouwde functie.

Agentautomatisering

AnythingLLM ondersteunt @agent workflows (pagina's doorbladeren, tools aanroepen, automatiseringen uitvoeren). Door de LLM-aanroepen van agenten via CometAPI te routeren, kunt u kiezen uit modellen voor controle-/interpretatiestappen zonder de agentcode te hoeven wijzigen.

Multi-model A/B-testen en kostenoptimalisatie

Wissel van model per werkruimte of functie (bijv. gpt-4o voor productie antwoorden, gpt-4o-mini voor dev). CometAPI maakt modelswaps triviaal en centraliseert kosten.

Multimodale pijpleidingen

CometAPI biedt beeld-, audio- en gespecialiseerde modellen. De multimodale ondersteuning van AnythingLLM (via providers) en de modellen van CometAPI maken ondertiteling van afbeeldingen, multimodale samenvattingen of audiotranscriptiestromen mogelijk via dezelfde interface.

Conclusie

CometAPI blijft zich positioneren als een multi-model gateway (meer dan 500 modellen, OpenAI-achtige API) – wat het een natuurlijke partner maakt voor apps zoals AnythingLLM die al een generieke OpenAI-provider ondersteunen. Bovendien maken de generieke provider en recente configuratieopties van AnythingLLM het eenvoudig om verbinding te maken met dergelijke gateways. Deze convergentie vereenvoudigt experimenten en productiemigratie eind 2025.

Aan de slag met Comet API

CometAPI is een uniform API-platform dat meer dan 500 AI-modellen van toonaangevende aanbieders – zoals de GPT-serie van OpenAI, Gemini van Google, Claude, Midjourney en Suno van Anthropic – samenvoegt in één, gebruiksvriendelijke interface voor ontwikkelaars. Door consistente authenticatie, aanvraagopmaak en responsverwerking te bieden, vereenvoudigt CometAPI de integratie van AI-mogelijkheden in uw applicaties aanzienlijk. Of u nu chatbots, beeldgenerators, muziekcomponisten of datagestuurde analysepipelines bouwt, met CometAPI kunt u sneller itereren, kosten beheersen en leveranciersonafhankelijk blijven – en tegelijkertijd profiteren van de nieuwste doorbraken in het AI-ecosysteem.

Om te beginnen, verken de modelmogelijkheden vanKomeetAPI in de Speeltuin en raadpleeg de API-handleiding voor gedetailleerde instructies. Voordat u toegang krijgt, moet u ervoor zorgen dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen. cometAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren.

Klaar om te gaan?→ Meld u vandaag nog aan voor CometAPI !

Als u meer tips, handleidingen en nieuws over AI wilt weten, volg ons dan op VK, X en Discord!