De low-code visuele AI-toolingmarkt ontwikkelt zich snel. Flowise – een open-source visuele builder voor LLM-workflows – blijft community-integraties toevoegen en brengt regelmatig updates uit; CometAPI is een van de vele uniforme AI API Platforms die nu honderden modellen via één eindpunt beschikbaar stellen; en no-code backend builders zoals BuildShip bieden eveneens nodes om CometAPI aan te roepen, zodat je dezelfde modellen in serverworkflows kunt integreren. Deze handleiding laat zien waarom en wanneer je deze onderdelen moet combineren en begeleidt je vervolgens door een concrete Flowise → CometAPI-integratie, hoe je Prompt → LLM Chain → CometAPI kunt integreren, aanbevolen best practices en voorbeelden van use cases.

Wat is FlowiseAI en waarom is het belangrijk?

FlowiseAI is een open-source visueel platform voor het bouwen van LLM-workflows, chatassistenten en agentische pipelines. Het biedt een drag-and-drop canvas met nodes (integraties) die prompts, ketens, LLM-connectoren, retrievers, geheugen, tools en outputs vertegenwoordigen. Zo kunnen teams prototypes maken van LLM-gestuurde systemen en deze verzenden zonder alles handmatig te hoeven bedraden. Flowise stelt ook API's, tracering, evaluatietools en door de community beheerde nodes beschikbaar, waardoor het zowel geschikt is voor rapid prototyping als voor productie-experimenten.

Waarom dat belangrijk is: Met Flowise krijgt u visuele observatie en snelle iteratie op promptketens en modelkeuzes. Door connectoren van derden (zoals CometAPI) toe te voegen, kunt u met minimale wijzigingen schakelen tussen of experimenteren met veel onderliggende modellen.

Wat is CometAPI en wat biedt het?

CometAPI is een uniforme API-laag die toegang tot honderden AI-modellen (OpenAI, Anthropic/Claude, Google/Gemini, Replicate-modellen, beeld- en audioproviders, enz.) achter één consistent aanvraagformaat en authenticatieschema. Dit betekent dat u modellen kunt kiezen of verwisselen, kosten/latentie kunt vergelijken of programmatisch kunt terugvallen op providers zonder uw applicatiecode te herschrijven. Het platform is gepositioneerd als een kostenbeheer- en leveranciersonafhankelijke toegangslaag voor LLM's en multimodale modellen.

Wat levert dit u in de praktijk op: eenvoudiger beheer van referenties voor de evaluatie van meerdere modellen, de mogelijkheid om snel A/B-tests uit te voeren met verschillende modellen en (vaak) kostenoptimalisatie door indien mogelijk goedkopere modelvarianten te selecteren.

Waarom zou je FlowiseAI integreren met CometAPI?

Door Flowise te integreren met CometAPI profiteert u van het gemak van Flowise's visuele builder, gecombineerd met gecentraliseerde toegang tot vele modelbackends via CometAPI. Voordelen zijn onder andere:

- Beheer van één referentie voor meerdere model-eindpunten (via CometAPI).

- Eenvoudig model A/Bing en routering op providerniveau binnen een visuele keten (model wisselen zonder de bedrading van knooppunten te wijzigen).

- Sneller experimenteren: verwissel modellen, pas prompts aan en vergelijk de uitvoer binnen Flowise-stromen.

- Minder technische problemen voor teams die een visuele orkestratielaag willen, maar achter de schermen meerdere modelleveranciers nodig hebben.

- Waarom zou je FlowiseAI integreren met CometAPI?

- Door Flowise te integreren met CometAPI profiteert u van het gemak van Flowise's visuele builder, gecombineerd met gecentraliseerde toegang tot vele modelbackends via CometAPI. Voordelen zijn onder andere:

- Beheer van één referentie voor meerdere model-eindpunten (via CometAPI).

- Eenvoudig model A/Bing en routering op providerniveau binnen een visuele keten (model wisselen zonder de bedrading van knooppunten te wijzigen).

- Sneller experimenteren: verwissel modellen, pas prompts aan en vergelijk de uitvoer binnen Flowise-stromen.

- Minder technische problemen voor teams die een visuele orkestratielaag willen, maar achter de schermen meerdere modelleveranciers nodig hebben.

- Deze mogelijkheden versnellen RAG-installaties, agentorkestratie en modelcompositieworkflows, terwijl de visuele herkomst en traceerbaarheid die Flowise biedt, behouden blijven.

Deze mogelijkheden versnellen RAG-instellingen, agent-orkestratie en modelcompositie-workflows, terwijl de visuele herkomst behouden blijft en traceerbaarheid Flowise biedt.

Welke omgeving en voorwaarden zijn er nodig voordat integratie kan plaatsvinden?

Controlelijst (minimaal):

- Inloggen FlowiseAI

- A KomeetAPI account + API-sleutel (u haalt deze op via de CometAPI Console). Let op: CometAPI gebruikt een basispad (bijv.

https://api.cometapi.com/v1/) voor verzoeken — u geeft dit op in de Flowise-knooppuntinstellingen.

Beveiliging en operationele voorbereidingen:

- Sla API-sleutels op in Flowise-referenties. Plaats sleutels niet in promptsjablonen of knooppuntcode.

- Quota- en tarieflimieten voor plannen: zowel CometAPI als de leveranciers van het onderliggende model kunnen limieten opleggen. Controleer uw plan en pas indien nodig client-side throttling of nieuwe pogingen toe.

- Let op de kosten: wanneer u van model wisselt, kunt u het tokengebruik en de kosten aanzienlijk wijzigen — instrumenteer statistieken en stel randvoorwaarden in.

Hoe integreer ik CometAPI met FlowiseAI? (Zoek en voeg het CometAPI-knooppunt toe — wat zijn de stappen?)

Volg deze praktische stappen om de ChatCometAPI knooppunt en configureer referenties.

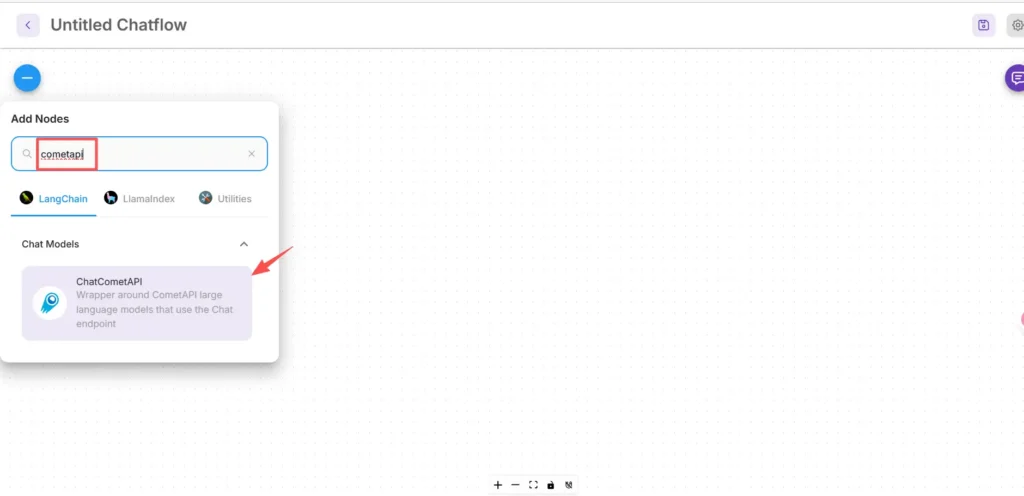

Stap 1 — Bevestig dat u het knooppunt beschikbaar hebt

- Klik in het FlowiseAI-canvas op Nieuw toevoegen.

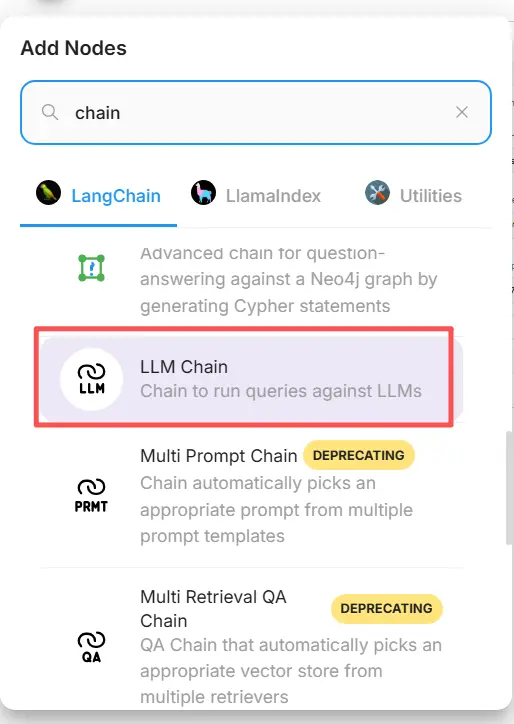

- Typ en zoek in het zoekvak naar "cometapi" om het CometAPI-veld te vinden. Sommige community-nodes verschijnen onder LangChain → Chatmodellen.

Stap 2: Voeg het CometAPI-knooppunt toe aan uw flow

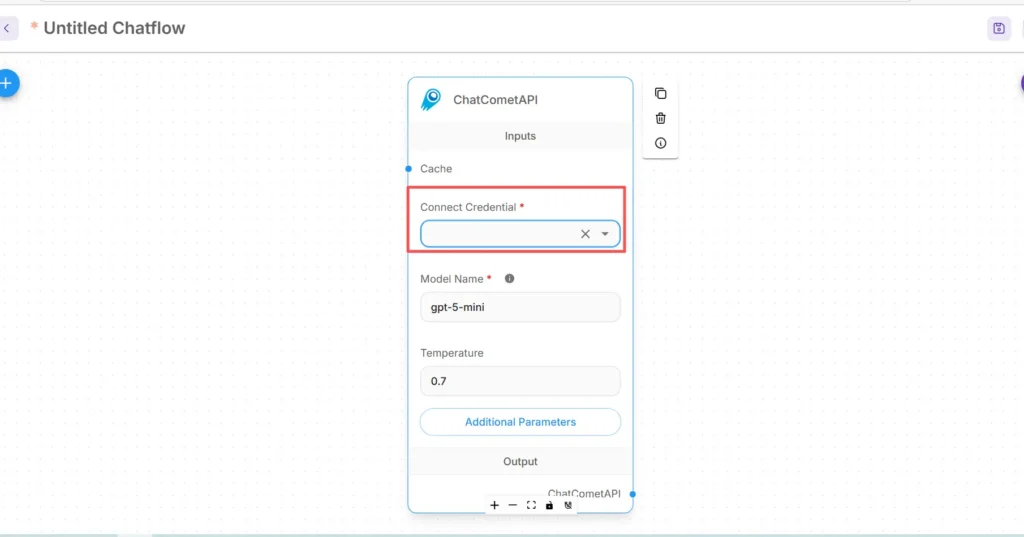

- Sleep de ChatCometAPI Node in uw werkruimte. De node geeft modelselectie, temperatuur, maximale tokens en andere inferentieparameters weer.

- Plaats Start/Invoer node (of de node die uw chatbot aanstuurt) stroomopwaarts van de CometAPI node.

Stap 3 — Configureer de inloggegevens voor CometAPI

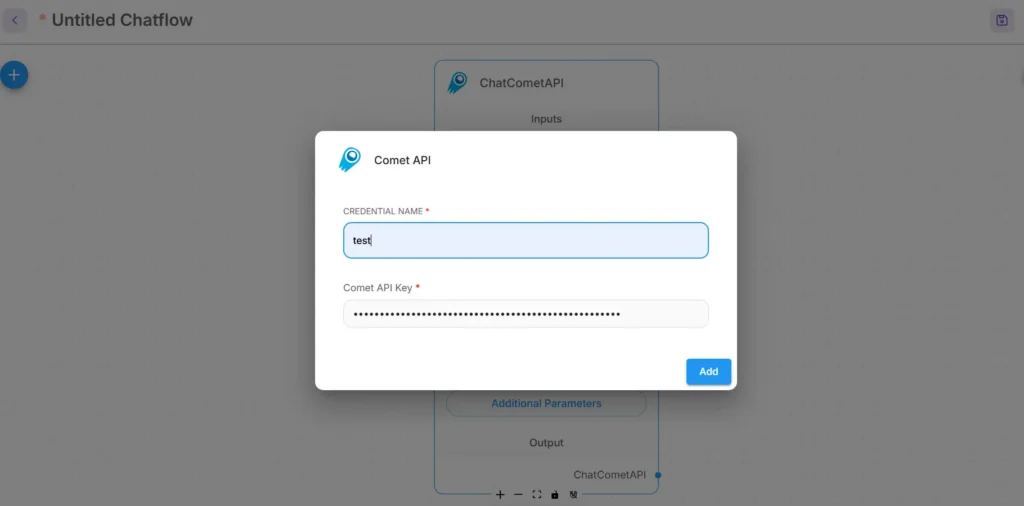

- Selecteer in het vervolgkeuzemenu Connect Credential van het CometAPI-knooppunt de optie Create New en zoek de API Key / Geloofsbrieven veld. (In Flowise, of open Geloofsbrieven)

- Vul uw CometAPI API-sleutel (bij voorkeur via de credential manager van Flowise of als omgevingsvariabele). Gebruik in productie geheimenbeheer

- Kies het standaard onderliggende model (of laat het aanpasbaar via de knooppuntinvoer als u wilt wisselen tussen runtime-modellen). CometAPI accepteert doorgaans een

modelparameter die aangeeft welke leverancier/model gebruikt moet worden.

Stap 4 — Stel het basispad en aanvullende parameters in.

Vouw in de ChatCometAPI-knooppuntinstellingen het volgende uit: Aanvullende parameters en stel de Basispad naar https://api.cometapi.com/v1/ (Dit is vereist zodat het knooppunt naar de v1-gateway van CometAPI verwijst.) Pas optioneel de standaardmodelnaam of providerparameters aan die door CometAPI worden ondersteund.

Tips voor probleemoplossing:

- Als aanroepen mislukken, controleer dan de netwerkuitgang en eventuele firewall-/NAT-regels tussen Flowise en CometAPI-eindpunten.

- Controleer de snelheidslimieten en foutreacties die door CometAPI worden geretourneerd; implementeer exponentiële backoff op 429/5xx.

Hoe voeg ik een Prompt-knooppunt toe en stel ik de LLM-keten in Flowise in?

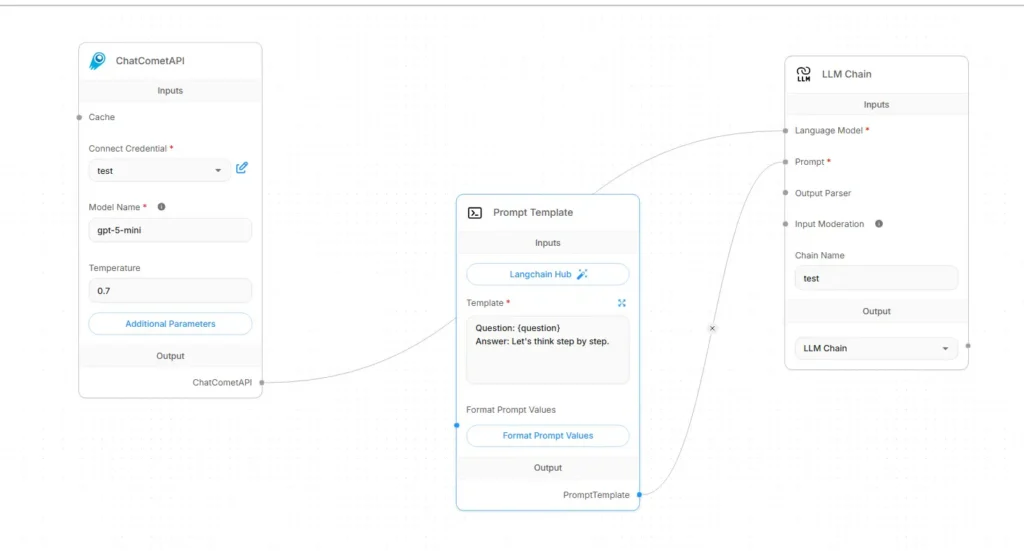

Flowise LLM-stromen worden doorgaans samengesteld als Invoer → Promptsjabloon → LLM-keten → UitvoerHier is een concreet bedradingsrecept met CometAPI als taalmodel:

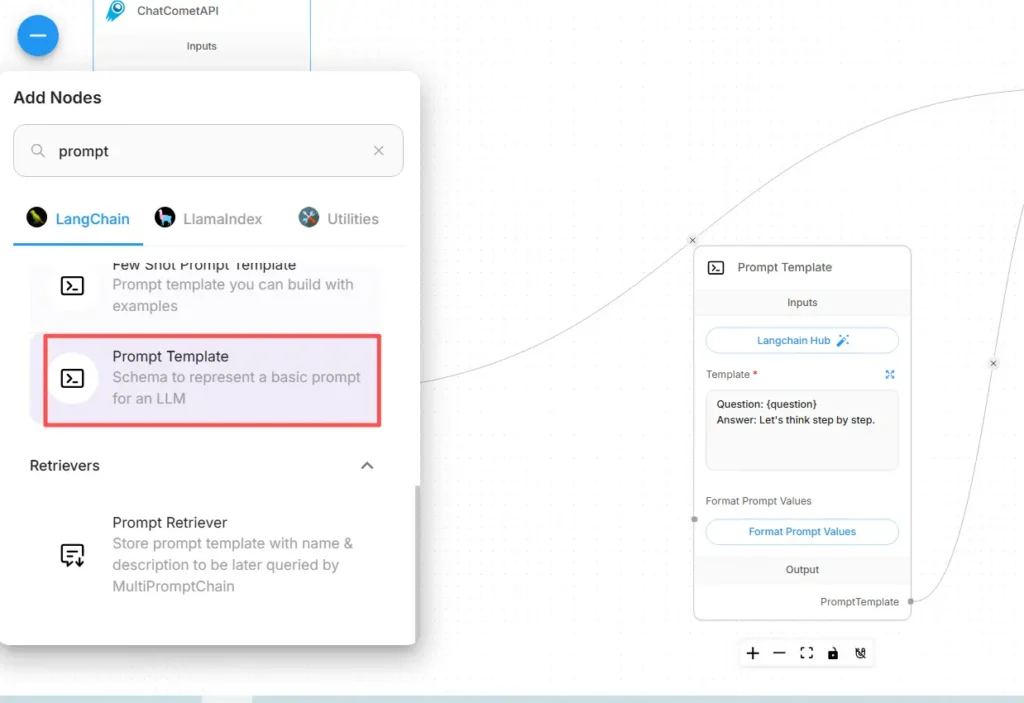

Stap A — Een Prompt Template-knooppunt maken

- Voeg een Prompt-sjabloon knooppunt (of "Prompt"-knooppunt) aan het canvas.

- In het Prompt-knooppunt kunt u uw sjabloon samenstellen met behulp van variabelen voor dynamische inhoud, bijvoorbeeld:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- blootstellen

user_inputals de variabele die moet worden ingevuld vanuit het Start/Input-knooppunt.

Stap B — Voeg een LLM-ketenknooppunt toe (LLM-wrapper)

Voeg een toe LLM-keten or LLM knooppunt dat een prompt → modelaanroep vertegenwoordigt. In Flowise heeft het LLM Chain-knooppunt gewoonlijk twee hoofdingangen: Taalmodel (het model/inferentieknooppunt) en prompt (het promptsjabloon).

Stap C — Sluit de knooppunten aan (expliciete bedrading)

- Verbind het CometAPI-knooppunt met de LLM-keten Taalmodel invoer.

Hiermee wordt aan de keten doorgegeven welk model moet worden aangeroepen voor generatie. (CometAPI wordt dan de modelleverancier.) - Verbind het Prompt Template-knooppunt met de LLM-keten prompt invoer.

De keten combineert de promptsjabloon met de variabelewaarden en stuurt de resulterende prompt naar CometAPI. - Verbind het Start/Input-knooppunt met de Prompt Template

user_inputvariabel. - Verbind de LLM Chain-uitvoer met het Uitvoerknooppunt (UI-respons of downstream-tool).

Visueel gezien zou de stroom er als volgt uit moeten zien:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

Stap D — Test met een proefrun

- Voer de flow uit in de testconsole van Flowise. Inspecteer de prompt die naar CometAPI is verzonden, de responstokens en de latentie. Pas de temperatuur, het maximum aantal tokens of de top-p aan in de CometAPI-node-instellingen om creativiteit versus determinisme te bepalen.

Welke praktische toepassingen biedt deze integratie?

Hieronder staan sterke use cases waarbij Flowise + CometAPI tastbare voordelen oplevert:

1) Multi-model routing / beste toolselectie

Bouw stromen die modellen per subtaak kiezen: snelle samenvatting met een goedkoop model, feitelijke basis met een model met hoge nauwkeurigheid en generatie van afbeeldingen via een afbeeldingsmodel - alles via CometAPI-parameters zonder de Flowise-bedrading te wijzigen.

2) Model A/B-testen en -evaluatie

Start twee parallelle LLM-ketens in Flowise (A versus B), routeer dezelfde prompt naar verschillende CometAPI-modelkeuzes en stuur de resultaten naar een kleine comparatornode die de outputs scoort. Gebruik metrics om te bepalen welk model je wilt gebruiken.

3) Hybride RAG (Retriever + LLM)

Gebruik Flowise's documentopslag en vectorretriever om context te verzamelen en stuur vervolgens een gecombineerde promptsjabloon naar het model van CometAPI. De uniforme API vereenvoudigt het verwisselen van de LLM die voor de uiteindelijke synthese wordt gebruikt.

4) Agentische tooling (API's, databases, code)

Compose tools (HTTP GET/POST, DB-aanroepen) binnen Flowise-agenten, gebruiken CometAPI voor taalredenering en actieselectie, en routeren uitvoer naar connectoren/tools. Flowise ondersteunt hiervoor request tools en agentpatronen.

Beginnen

CometAPI is een uniform API-platform dat meer dan 500 AI-modellen van toonaangevende aanbieders – zoals de GPT-serie van OpenAI, Gemini van Google, Claude, Midjourney en Suno van Anthropic – samenvoegt in één, gebruiksvriendelijke interface voor ontwikkelaars. Door consistente authenticatie, aanvraagopmaak en responsverwerking te bieden, vereenvoudigt CometAPI de integratie van AI-mogelijkheden in uw applicaties aanzienlijk. Of u nu chatbots, beeldgenerators, muziekcomponisten of datagestuurde analysepipelines bouwt, met CometAPI kunt u sneller itereren, kosten beheersen en leveranciersonafhankelijk blijven – en tegelijkertijd profiteren van de nieuwste doorbraken in het AI-ecosysteem.

Om te beginnen, verken de mogelijkheden van het model in de Speeltuin en raadpleeg de Flowise API-gids voor gedetailleerde instructies. Zorg ervoor dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen voordat u toegang krijgt. KomeetAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren.

Klaar om te gaan?→ Meld u vandaag nog aan voor CometAPI !

Eindaanbevelingen en afronding

Flowise integreren met CometAPI is een pragmatische manier om snelle visuele orkestratie (Flowise) te combineren met flexibele toegang tot meerdere modelproviders (CometAPI). Het patroon – sla prompts op als sjablonen, houd modelknooppunten ontkoppeld en instrumenteer runs zorgvuldig – stelt teams in staat snel te itereren en van provider te wisselen zonder flows te herschrijven. Vergeet niet om inloggegevens veilig te beheren, rekening te houden met latentie en kosten, en uw flows te instrumenteren voor observeerbaarheid en governance.