Wat is de GPT-5.2 API

GPT-5.2 API is hetzelfde als GPT-5.2 Thinking in ChatGPT. GPT-5.2 Thinking is de middensegmentvariant binnen OpenAI’s GPT-5.2-familie, ontworpen voor dieper werk: meerstapsredeneren, samenvattingen van lange documenten, kwalitatieve codegeneratie en professioneel kenniswerk waar nauwkeurigheid en bruikbare structuur zwaarder wegen dan pure doorvoer. In de API is deze beschikbaar als het model gpt-5.2 (Responses API / Chat Completions), en het zit tussen de laag-latentie Instant-variant en de hogere kwaliteit maar duurdere Pro-variant.

Belangrijkste functies

- Zeer lange context & compactie: 400K effectief contextvenster en compactietools om relevantie te beheren over lange gesprekken en documenten.

- Configureerbare redeneerinspanning:

none | medium | high | xhigh(xhigh schakelt maximale interne compute in voor moeilijke redenering).xhighis beschikbaar voor Thinking/Pro-varianten. - Sterkere ondersteuning voor tools en functies: eersteklas tool-calling, grammars (CFG/Lark) om gestructureerde output te beperken, en verbeterde agent-capaciteiten die complexe meerstapsautomatisering vereenvoudigen.

- Multimodale begrip: rijker begrip van afbeeldingen + tekst en integratie in meerstapstaken.

- Verbeterde veiligheid / omgang met gevoelige inhoud: gerichte interventies om ongewenste reacties te verminderen in gebieden zoals zelfbeschadiging en andere gevoelige contexten.

Technische mogelijkheden & specificaties (weergave voor ontwikkelaars)

- API-endpoints & model-ID’s:

gpt-5.2voor Thinking (Responses API),gpt-5.2-chat-latestvoor chat/instant-workflows, engpt-5.2-provoor de Pro-laag; beschikbaar via Responses API en Chat Completions waar aangegeven. - Reasoning-tokens & inspanningsbeheer: de API ondersteunt expliciete parameters om rekenwerk (reasoning effort) per verzoek toe te wijzen; hogere inspanning verhoogt latentie en kosten maar verbetert de outputkwaliteit voor complexe taken.

- Gestructureerde outputtools: ondersteuning voor grammars (Lark / CFG) om de modeloutput te beperken tot een DSL of exacte syntaxis (nuttig voor SQL, JSON, DSL-generatie).

- Parallelle tool-calling & agentcoördinatie: verbeterde paralleliteit en nettere tool-orkestratie verminderen de noodzaak voor uitgebreide system prompts en multi-agent scaffolding.

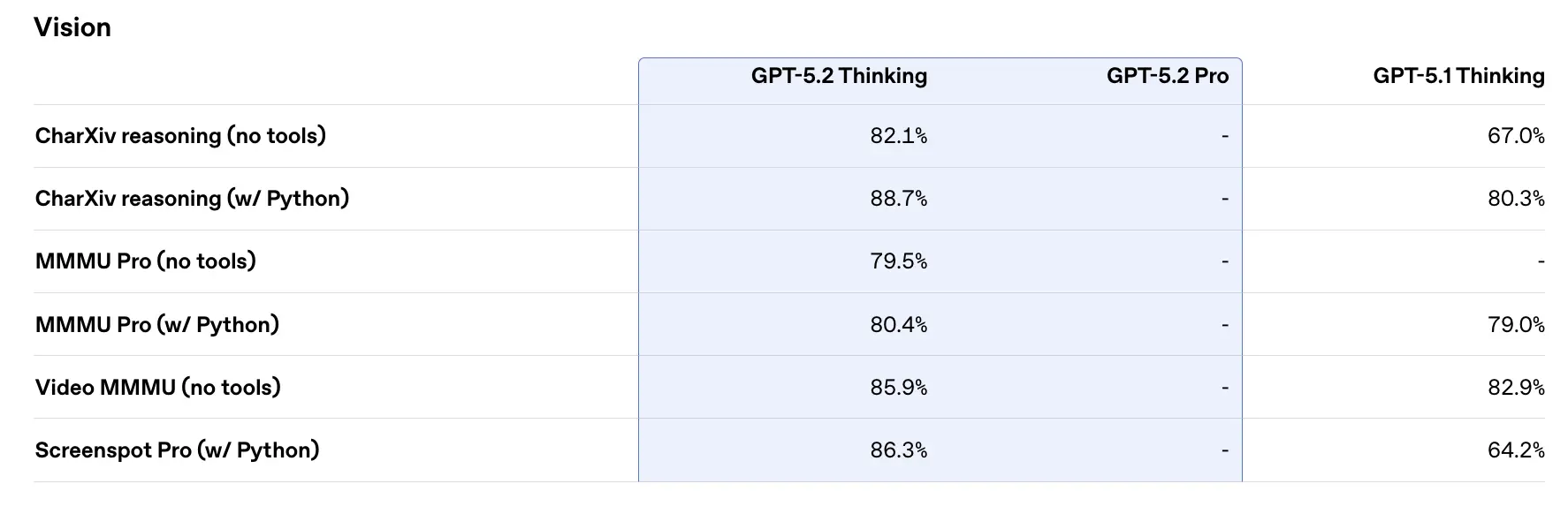

Benchmarkprestaties & ondersteunende data

OpenAI publiceerde een reeks interne en externe benchmarkresultaten voor GPT-5.2. Geselecteerde highlights (door OpenAI gerapporteerde cijfers):

- GDPval (44 beroepen, kenniswerk) — GPT-5.2 Thinking “overtreft of evenaart topprofessionals uit de industrie in 70,9% van de vergelijkingen”; OpenAI meldt dat outputs werden geproduceerd met >11× de snelheid en <1% de kosten van expertprofessionals op hun GDPval-taken (snelheids- en kostenramingen zijn historisch gebaseerd). Deze taken omvatten spreadsheetmodellen, presentaties en korte video’s.

- SWE-Bench Pro (coding) — GPT-5.2 Thinking behaalt ≈55,6% op SWE-Bench Pro en ~80% op SWE-Bench Verified (alleen Python) volgens OpenAI, en zet daarmee een nieuwe state of the art voor codegeneratie / engineeringevaluaties in hun tests. Dit vertaalt zich in de praktijk in betrouwbaardere debugging en end-to-end fixes, volgens OpenAI’s voorbeelden.

- GPQA Diamond (wetenschappelijke vraag-en-antwoord op graduate-niveau) — GPT-5.2 Pro: 93,2%, GPT-5.2 Thinking: 92,4% op GPQA Diamond (geen tools, maximale redenering).

- ARC-AGI-serie — Op ARC-AGI-2 (een moeilijkere benchmark voor flexibel redeneren) scoorde GPT-5.2 Thinking 52,9% en GPT-5.2 Pro 54,2% (OpenAI zegt dat dit nieuwe state-of-the-art marks zijn voor chain-of-thought-modellen).

- Long-context (OpenAI MRCRv2) — GPT-5.2 Thinking toont bijna 100% nauwkeurigheid op de 4-needle MRCR-variant tot 256k tokens en aanzienlijk verbeterde scores t.o.v. GPT-5.1 in long-context-instellingen. (OpenAI publiceerde MRCRv2-grafieken en -tabellen.)

Vergelijking met tijdgenoten

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro is gepromoot met een ~1.048.576 (≈1M) tokens contextvenster en brede multimodale input (tekst, beeld, audio, video, PDF’s) en sterke agent-integraties via Vertex AI / AI Studio. Op papier is Gemini 3’s grotere contextvenster een onderscheidende factor voor extreem grote single-session workloads; afwegingen omvatten de omvang van de tooling en de aansluiting op het ecosysteem.

- vs Anthropic Claude Opus 4.5: Anthropic’s Opus 4.5 legt de nadruk op enterprise coding/agent-workflows en rapporteert sterke SWE-bench-resultaten en robuustheid voor lange agent-sessies; Anthropic positioneert Opus voor automatisering en codegeneratie met een 200k contextvenster en gespecialiseerde agent-/Excel-integraties. Opus 4.5 is een sterke concurrent in enterprise-automatisering en codetaken.

Praktische conclusie: GPT-5.2 richt zich op een gebalanceerde set verbeteringen (context 400k, hoge tokenoutputs, verbeterd redeneren/coderen). Gemini 3 richt zich op de absoluut grootste single-session contexten (≈1M), terwijl Claude Opus focust op enterprise-engineering en agentische robuustheid. Kies door de contextgrootte, modaliteitsbehoeften, feature/tooling-fit en kosten-/latentieafwegingen te matchen.

Toegang krijgen tot en gebruiken van de GPT-5.2 API

Stap 1: Aanmelden voor API-sleutel

Log in op cometapi.com. Als u nog geen gebruiker van ons bent, registreer dan eerst. Meld u aan bij uw CometAPI-console. Verkrijg de toegangssleutel (API key) van de interface. Klik bij “Add Token” bij de API-token in het persoonlijke centrum, verkrijg de tokensleutel: sk-xxxxx en dien in.

Stap 2: Verzoeken verzenden naar de GPT-5.2 API

Selecteer het “gpt-5.2”-endpoint om het API-verzoek te verzenden en stel de request body in. De requestmethode en request body worden verkregen uit onze website-API-documentatie. Onze website biedt ook Apifox-test voor uw gemak. Vervang <YOUR_API_KEY> door uw daadwerkelijke CometAPI-sleutel uit uw account. Developers roepen deze aan via de Responses API / Chat endpoints.

Voeg uw vraag of verzoek in het content-veld in—dit is waar het model op zal reageren. Verwerk de API-respons om het gegenereerde antwoord te verkrijgen.

Stap 3: Resultaten ophalen en verifiëren

Verwerk de API-respons om het gegenereerde antwoord te verkrijgen. Na verwerking reageert de API met de taakstatus en uitvoerdata.

Zie ook Gemini 3 Pro Preview API