In de snel evoluerende wereld van kunstmatige intelligentie vertegenwoordigt de release van elk nieuw groot taalmodel (LLM) meer dan een numerieke versieverhoging – het signaleert vooruitgang in redeneervermogen, programmeervaardigheden en de samenwerking tussen mens en machine. Eind september 2025, Zhipu AI (Z.ai) onthuld GLM-4.6, het nieuwste lid van de General Language Model-familie. Voortbouwend op de robuuste architectuur en het sterke redeneringsfundament van GLM-4.5, verfijnt deze update de mogelijkheden van het model in agentisch redeneren, codeerintelligentie en begrip van lange contexten, terwijl het open en toegankelijk blijft voor zowel ontwikkelaars als ondernemingen.

Wat is GLM-4.6?

GLM-4.6 is een belangrijke release in de GLM-serie (General Language Model) die is ontworpen om redeneren met hoge capaciteit in balans te brengen met praktische workflows voor ontwikkelaars. Op hoofdlijnen richt de release zich op drie nauw verwante use cases: (1) geavanceerde codegeneratie en redeneren over code, (2) taken met uitgebreide context die modelbegrip vereisen voor zeer lange invoer, en (3) agentische workflows waarbij het model moet plannen, tools moet aanroepen en processen met meerdere stappen moet orkestreren. Het model wordt geleverd in varianten die bedoeld zijn voor cloud-API's en community-modelhubs, waardoor zowel gehoste als zelfgehoste implementatiepatronen mogelijk zijn.

In de praktijk wordt GLM-4.6 gepositioneerd als een "ontwikkelaar-eerst" vlaggenschip: de verbeteringen betreffen niet alleen de ruwe benchmarkcijfers, maar ook mogelijkheden die de manier waarop ontwikkelaars assistenten, codecopiloten en document- of kennisgestuurde agents bouwen, wezenlijk veranderen. Verwacht een release die de nadruk legt op het afstemmen van instructies voor toolgebruik, gedetailleerde verbeteringen voor codekwaliteit en debugging, en infrastructuurkeuzes die zeer lange contexten mogelijk maken zonder lineaire prestatievermindering.

Wat wil GLM-4.6 oplossen?

- Verminder de rompslomp bij het werken met lange codebases en grote documenten door langere, effectieve contextvensters te ondersteunen.

- Verbeter de betrouwbaarheid van codegeneratie en foutopsporing, zodat u meer idiomatische, testbare uitvoer krijgt.

- Vergroot de robuustheid van agentgedrag – planning, gebruik van hulpmiddelen en uitvoering van taken in meerdere stappen – door middel van gerichte instructie en afstemming op versterkingsstijl.

Van GLM-4.5 naar GLM-4.6, wat is er in de praktijk veranderd?

- Contextschaal: 128K spring naar 200 penningen is de grootste UX/architectuurverandering voor gebruikers: lange documenten, complete codebases of uitgebreide agenttranscripties kunnen nu worden verwerkt als één contextvenster. Dit vermindert de noodzaak voor ad-hoc chunking of dure retrieval loops voor veel workflows.

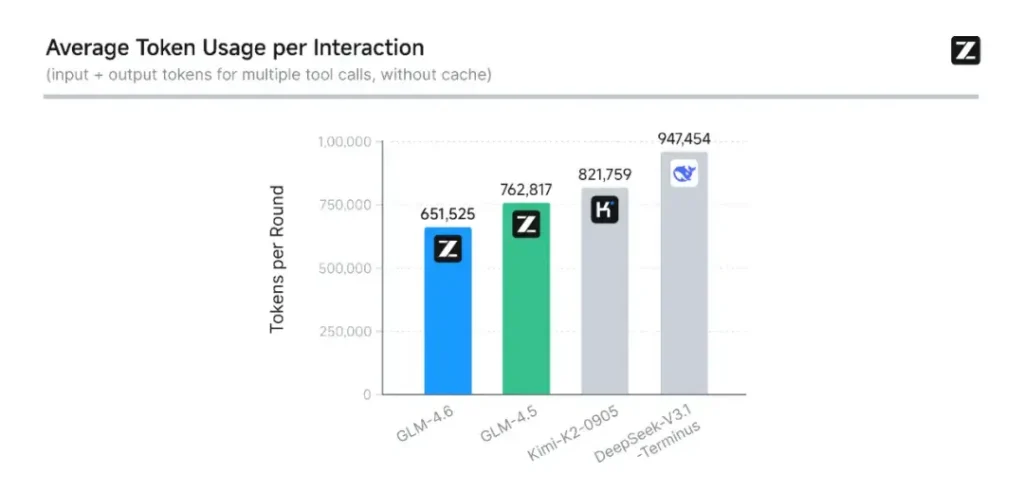

- Codering en evaluatie in de praktijk: Z.ai heeft CC-Bench (hun coderings- en voltooiingsbenchmark) uitgebreid met moeilijkere, realistische taaktrajecten en meldt dat GLM-4.6 taken voltooit met ~15% minder tokens dan GLM-4.5, terwijl de slagingspercentages bij complexe multi-turn engineering taken worden verbeterd. Dit duidt op een betere tokenefficiëntie en verbeteringen in de ruwe capaciteiten in toegepaste coderingsscenario's. Z.ai

- Integratie van agenten en tools: GLM-4.6 bevat betere ondersteuningspatronen voor toolaanroepen en zoekagenten. Dit is belangrijk voor producten die afhankelijk zijn van het model om webzoekopdrachten, code-uitvoering of andere microservices te orkestreren.

Wat zijn de belangrijkste kenmerken van GLM-4.6?

1. Contextvenster uitgebreid tot 200K tokens

Een van de meest opvallende kenmerken van GLM-4.6 is de enorm uitgebreid contextvensterUitbreiding van 128K in de vorige generatie naar 200 penningenGLM-4.6 kan hele boeken, complexe datasets met meerdere documenten of uren aan dialogen in één sessie verwerken. Deze uitbreiding verbetert niet alleen het begrip, maar maakt het ook mogelijk consistente redenering over lange inputs — een grote stap voor het samenvatten van documenten, juridische analyses en workflows voor softwareontwikkeling.

2. Verbeterde coderingsintelligentie

Zhipu AI is intern CC-Bench benchmark, een reeks real-world programmeertaken, laat zien dat GLM-4.6 opmerkelijke verbeteringen in de nauwkeurigheid en efficiëntie van de coderingHet model kan syntactisch correcte, logisch gezonde code produceren tijdens het gebruik ongeveer 15% minder tokens dan GLM-4.5 voor vergelijkbare taken. Deze token-efficiëntie betekent snellere en goedkopere voltooiingen zonder in te leveren op kwaliteit — een essentiële factor voor implementatie in ondernemingen.

3. Geavanceerd redeneren en toolintegratie

Naast het genereren van ruwe tekst blinkt GLM-4.6 uit in gereedschapsversterkende redeneringHet is getraind en afgestemd op meerstapsplanning en het orkestreren van externe systemen – van databases tot zoektools en uitvoeringsomgevingen. In de praktijk betekent dit dat GLM-4.6 kan fungeren als het 'brein' van een autonome AI-agent, bepalen wanneer externe API's moeten worden aangeroepen, hoe resultaten moeten worden geïnterpreteerd en hoe taakcontinuïteit tussen sessies moet worden gehandhaafd.

4. Verbeterde uitlijning van natuurlijke taal

Door voortdurend versterkend leren en voorkeursoptimalisatie levert GLM-4.6 soepelere conversatiestroom, betere stijlmatching en sterkere veiligheidsafstemmingHet model past zijn toon en structuur aan de context aan, of het nu gaat om formele documentatie, educatieve begeleiding of creatief schrijven. Dit verbetert het vertrouwen en de leesbaarheid van de gebruiker.

Welke architectuur ondersteunt GLM-4.6?

Is GLM-4.6 een 'mix van experts'-model?

Continuïteit van de inferentiemethode: Het GLM-team geeft aan dat GLM-4.5 en GLM-4.6 dezelfde fundamentele inferentiepijplijn delen, waardoor bestaande implementatieconfiguraties met minimale problemen kunnen worden geüpgraded. Dit vermindert het operationele risico voor teams die al GLM-4.x gebruiken – schaalparameters en modelontwerpkeuzes die de nadruk leggen op specialisatie voor agentisch redeneren, coderen en efficiënte inferentie. Het GLM-4.5-rapport geeft de duidelijkste openbare beschrijving van de MoE-strategie en het trainingsprogramma van de familie (multi-stage pretraining, expert model iteratie, reinforcement learning voor afstemming); GLM-4.6 past deze lessen toe en stemt tegelijkertijd de contextlengte en taakspecifieke mogelijkheden af.

Praktische architectuurnotities voor ingenieurs

- Parametervoetafdruk versus geactiveerde berekening: Grote parametertotalen (honderden miljarden) vertalen zich niet direct naar equivalente activeringskosten voor elk verzoek. MoE betekent dat slechts een subset van experts per tokenreeks activeert, wat voor veel workloads een gunstiger afweging tussen kosten en doorvoer oplevert.

- Tokenprecisie en formaten: De openbare gewichten worden verdeeld in de formaten BF16 en F32 en community-kwantificeringen (GGUF, 4-/8-/bits) verschijnen snel. Hiermee kunnen teams GLM-4.6 op verschillende hardwareprofielen uitvoeren.

- Compatibiliteit van inferentiestapel: Z.ai documenteert vLLM en andere moderne LLM-runtimes als compatibele inferentie-backends, waardoor GLM-4.6 geschikt is voor zowel cloud- als on-prem-implementaties.

Benchmarkprestaties: hoe presteert GLM-4.6?

Welke benchmarks werden gerapporteerd?

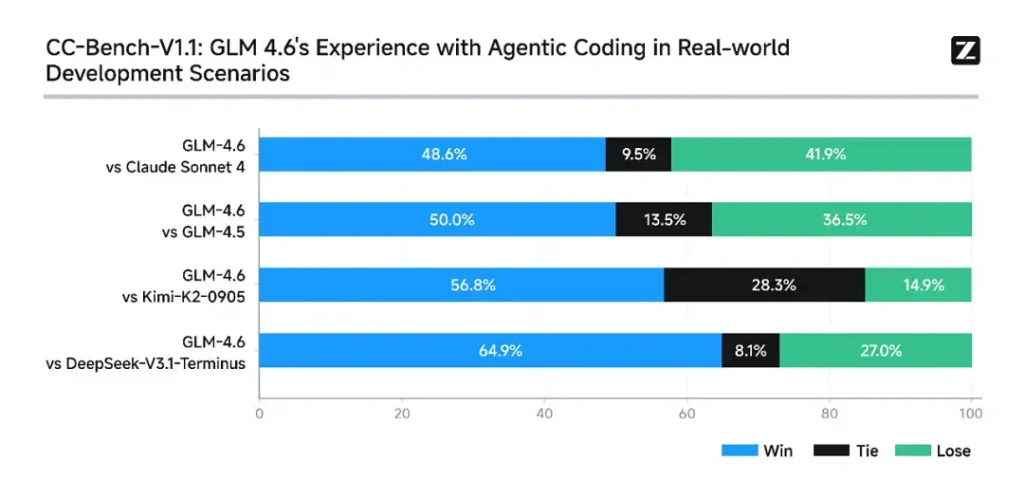

Z.ai heeft GLM-4.6 geëvalueerd in een reeks acht openbare benchmarks Ze omvatten agentische taken, redeneren en coderen. Ze breidden ook CC-Bench uit (een door mensen geëvalueerde benchmark voor real-task codering in Docker-geïsoleerde omgevingen) om productietechnische taken (front-end ontwikkeling, testen, algoritmische probleemoplossing) beter te simuleren. Voor deze taken liet GLM-4.6 consistente verbeteringen zien ten opzichte van GLM-4.5.

Coderingsprestaties

- Echte taken winnen: In de menselijke CC-Bench-evaluaties bereikte GLM-4.6 bijna pariteit met Anthropic's Claude Sonnet 4 in head-to-head, multi-turn taken - Z.ai meldt een 48.6% winstpercentage in hun Docker-geïsoleerde, door mensen beoordeelde evaluaties (interpretatie: bijna 50/50 met Claude Sonnet 4 in hun samengestelde set). Tegelijkertijd presteerde GLM-4.6 beter dan een aantal binnenlandse open modellen (bijv. DeepSeek-varianten) op hun taken.

- Token efficiëntie: Z.ai rapporteert ~15% minder tokens wordt gebruikt om taken af te ronden in vergelijking met GLM-4.5 in CC-Bench-trajecten. Dit is van belang voor zowel de latentie als de kosten.

Redeneren en wiskunde

GLM-4.6 claimt een verbeterd redeneervermogen en betere prestaties in het gebruik van tools ten opzichte van GLM-4.5. Waar GLM-4.5 de nadruk legde op hybride 'denk'- en direct-reply-modi, verhoogt GLM-4.6 de robuustheid voor meerstaps redeneren, vooral wanneer geïntegreerd met zoek- of uitvoeringstools.

De openbare berichtgeving van Z.ai positioneert GLM-4.6 als concurrerend met toonaangevende internationale en binnenlandse modellen op hun gekozen benchmarks – met name concurrerend met Claude Sonnet 4 en beter presterend dan bepaalde binnenlandse alternatieven zoals DeepSeek-varianten in code-/agenttaken. Maar in sommige coderingsspecifieke subbenchmarks** loopt GLM-4.6 nog steeds achter op Claude Sonnet 4.5 (een recentere Anthropic-release), waardoor het landschap er eerder een is van hevige concurrentie dan van regelrechte dominantie.

Hoe toegang te krijgen tot GLM-4.6

- 1. Via het Z.ai-platform: Ontwikkelaars hebben rechtstreeks toegang tot GLM-4.6 via API van Z.ai or **chatinterface (chat.z.ai)**Deze gehoste services maken snelle experimenten en integratie mogelijk zonder lokale implementatie. De API ondersteunt zowel standaard tekstaanvulling als gestructureerde toolaanroepmodi – essentieel voor agentworkflows.

- 2. Open gewichten op het omsluitende vlak en de modelscoop: Voor degenen die de voorkeur geven aan lokale controle, heeft Zhipu AI GLM-4.6-modelbestanden uitgebracht op Gezicht knuffelen en Modelbereik, inclusief safetensorversies in BF16 en F32 Precisie. Community-ontwikkelaars hebben al gekwantiseerde GGUF-versies geproduceerd, waardoor inferentie op consumenten-GPU's mogelijk is.

- 3. Integratieframeworks: GLM-4.6 integreert probleemloos met belangrijke inferentie-engines zoals vLLM, SGLangen LMDeploy, waardoor het geschikt is voor moderne serveerstapels. Deze veelzijdigheid laat bedrijven kiezen tussen cloud, randen on-prem implementatie afhankelijk van de nalevings- of latentievereisten.

CometAPI is een uniform API-platform dat meer dan 500 AI-modellen van toonaangevende aanbieders – zoals de GPT-serie van OpenAI, Gemini van Google, Claude, Midjourney en Suno van Anthropic – samenvoegt in één, gebruiksvriendelijke interface voor ontwikkelaars. Door consistente authenticatie, aanvraagopmaak en responsverwerking te bieden, vereenvoudigt CometAPI de integratie van AI-mogelijkheden in uw applicaties aanzienlijk. Of u nu chatbots, beeldgenerators, muziekcomponisten of datagestuurde analysepipelines bouwt, met CometAPI kunt u sneller itereren, kosten beheersen en leveranciersonafhankelijk blijven – en tegelijkertijd profiteren van de nieuwste doorbraken in het AI-ecosysteem.

De nieuwste integratie GLM-4.6 zal binnenkort op CometAPI verschijnen, dus blijf op de hoogte! Terwijl we de upload van het GLM 4.6-model afronden, kunt u onze andere modellen bekijken op de modellenpagina of ze uitproberen in de AI Playground.

Ontwikkelaars hebben toegang tot GLM‑4.5 API via CometAPI, de nieuwste modelversie wordt altijd bijgewerkt met de officiële website. Om te beginnen, verken de mogelijkheden van het model in de Speeltuin en raadpleeg de API-gids voor gedetailleerde instructies. Zorg ervoor dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen voordat u toegang krijgt. KomeetAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren.

Klaar om te gaan?→ Meld u vandaag nog aan voor CometAPI !

Conclusie — Waarom GLM-4.6 nu belangrijk is

GLM-4.6 is een belangrijke mijlpaal in de GLM-lijn omdat het praktische verbeteringen voor ontwikkelaars – langere contextvensters, gerichte codering en agentoptimalisaties, en tastbare benchmarkresultaten – combineert met de openheid en flexibiliteit van het ecosysteem die veel organisaties wensen. Voor teams die code-assistenten, agents voor lange documenten of toolgestuurde automatiseringen bouwen, is GLM-4.6 het overwegen waard als topkandidaat.