GPT-5-Codex is OpenAI's nieuwe, op engineering gerichte variant van GPT-5, specifiek afgestemd op agentische software engineering binnen de Codex-productfamilie. Het is ontworpen om grote, praktische engineeringworkflows aan te kunnen: volledige projecten vanaf nul creëren, functies en tests toevoegen, debuggen, refactoren en codereviews uitvoeren, terwijl er wordt gecommuniceerd met externe tools en testsuites. Deze release vertegenwoordigt een gerichte productverbetering in plaats van een gloednieuw fundamenteel model: OpenAI heeft GPT-5-Codex geïntegreerd in Codex CLI, de Codex IDE-extensie, Codex Cloud, GitHub-workflows en ChatGPT mobiele ervaringen; de API-beschikbaarheid is gepland, maar niet direct.

Wat is GPT-5-Codex en waarom bestaat het?

GPT-5-Codex is GPT-5 "gespecialiseerd in coderen". In plaats van een algemene conversatie-assistent te zijn, is het afgestemd en getraind met reinforcement learning en engineering-specifieke datasets om iteratieve, tool-ondersteunde codeertaken beter te ondersteunen (denk aan: tests uitvoeren, itereren bij fouten, modules refactoren en PR-conventies volgen). OpenAI beschouwt het als de opvolger van eerdere Codex-initiatieven, maar bouwt voort op de GPT-5-backbone om de redeneerdiepte over grote codebases te verbeteren en meerstaps engineeringtaken betrouwbaarder uit te voeren.

De motivatie is praktisch: workflows voor ontwikkelaars zijn steeds meer afhankelijk van agents die meer kunnen dan suggesties in fragmenten. Door een model specifiek af te stemmen op de lus van "genereren → tests uitvoeren → repareren → herhalen" en op de PR-normen van de organisatie, streeft OpenAI ernaar een AI te creëren die aanvoelt als een teamgenoot in plaats van een bron van eenmalige voltooiingen. Die verschuiving van "een functie genereren" naar "een feature leveren" is de unieke waarde van het model.

Hoe wordt GPT-5-Codex ontworpen en getraind?

Hoogwaardige architectuur

GPT-5-Codex is een variant van de GPT-5-architectuur (de bredere GPT-5-lijn) in plaats van een volledig nieuwe architectuur. Dat betekent dat het het kernontwerp, de schaalbaarheid en de redeneringsverbeteringen van GPT-5 overneemt, maar ook Codex-specifieke training en RL-gebaseerde finetuning toevoegt, gericht op software engineering-taken. Het addendum van OpenAI beschrijft GPT-5-Codex als getraind voor complexe, realistische engineering-taken en benadrukt reinforcement learning in omgevingen waar code wordt uitgevoerd en gevalideerd.

Hoe werd het getraind en geoptimaliseerd voor code?

Het trainingsprogramma van GPT-5-Codex benadrukt echte technische takenHet maakt gebruik van reinforcement-learning-achtige finetuning op datasets en omgevingen die zijn opgebouwd uit tastbare softwareontwikkelingsworkflows: multi-file refactoring, PR-diffs, het uitvoeren van testsuites, debugsessies en menselijke beoordelingssignalen. Het trainingsdoel is om de correctheid van codebewerkingen te maximaliseren, tests te laten slagen en reviewcommentaren te produceren die een hoge precisie en relevantie hebben. Deze focus onderscheidt Codex van algemene chat-gerichte finetuning: de verliesfuncties, evaluatie-harnassen en beloningssignalen zijn afgestemd op de technische resultaten (geslaagde tests, correcte diffs, minder valse opmerkingen).

Hoe ‘agentische’ training eruitziet

- Uitvoeringsgedreven fine-tuning:Het model wordt getraind in contexten waarin gegenereerde code wordt uitgevoerd, getest en geëvalueerd. Feedbackloops komen voort uit testresultaten en menselijke voorkeurssignalen, waardoor het model wordt aangemoedigd om te itereren totdat een testsuite slaagt.

- Versterkend leren van menselijke feedback (RLHF):In de geest vergelijkbaar met eerder RLHF-werk, maar toegepast op taken met codering in meerdere stappen (PR maken, testen uitvoeren, fouten verhelpen). Op deze manier leert het model de tijdelijke toekenning van studiepunten aan de hand van een reeks acties.

- Context op repository-schaal:Training en evaluatie omvatten grote repositories en refactoringen, die het model helpen bij het leren van cross-file redeneringen, naamgevingsconventies en impact op codebase-niveau. ()

Hoe gaat GPT-5-Codex om met gereedschapsgebruik en omgevingsinteracties?

Een belangrijk architectonisch kenmerk is de verbeterde mogelijkheid van het model om tools aan te roepen en te coördineren. Codex combineerde modeluitvoer van oudsher met een klein runtime-/agentsysteem dat tests kon uitvoeren, bestanden kon openen of zoekopdrachten kon aanroepen. GPT-5-Codex breidt dit uit door te leren wanneer tools moeten worden aangeroepen en door testfeedback beter te integreren in de daaropvolgende codegeneratie, waardoor de cirkel tussen synthese en verificatie effectief wordt gesloten. Dit wordt bereikt door te trainen op trajecten waarbij het model zowel acties uitvoert (zoals "test X uitvoeren") als latere generaties conditioneert op testuitvoer en diffs.

Wat kan GPT-5-Codex eigenlijk doen? Wat zijn de kenmerken ervan?

Een van de bepalende productinnovaties is adaptieve denkduurGPT-5-Codex past de hoeveelheid verborgen redenering aan: triviale verzoeken worden snel en goedkoop verwerkt, terwijl complexe refactoringen of langlopende taken het model veel langer laten "denken". Tegelijkertijd verbruikt het model voor kleine, interactieve taken veel minder tokens dan een algemene GPT-5-instantie. Het bespaart 93.7% van de tokens (inclusief inferentie en output) in vergelijking met GPT-5. Deze strategie van variabel redeneren is bedoeld om snelle reacties te produceren wanneer nodig en een diepgaande, grondige uitvoering wanneer dat gerechtvaardigd is.

Kerncapaciteiten

- Projectgeneratie en bootstrapping: Maak volledige projectskeletten met CI, tests en basisdocumentatie vanuit algemene prompts.

- Agenttesten en iteratie: Genereer code, voer tests uit, analyseer fouten, patch code en voer deze opnieuw uit totdat de tests slagen. Zo automatiseer je op effectieve wijze delen van de bewerking → test → herstel-lus van een ontwikkelaar.

- Grootschalige refactoring: Voer systematische refactorings uit over meerdere bestanden met behoud van gedrag en tests. Dit is een belangrijk optimalisatiegebied voor GPT-5-Codex ten opzichte van generieke GPT-5.

- Codebeoordeling en PR-generatie: Maak PR-beschrijvingen, stel wijzigingen voor met verschillen en bekijk opmerkingen die aansluiten bij de projectconventies en de verwachtingen van menselijke beoordeling.

- Redeneren met code in grote contexten: Beter in het navigeren en redeneren over codebases met meerdere bestanden, afhankelijkheidsgrafieken en API-grenzen vergeleken met generieke chatmodellen.

- Visuele invoer en uitvoer: Bij het werken in de cloud kan GPT-5-Codex afbeeldingen/screenshots accepteren, de voortgang visueel inspecteren en visuele artefacten (screenshots van de gebouwde gebruikersinterface) aan taken koppelen. Dit is een praktische tool voor front-end debugging en visuele QA-workflows.

Editor- en workflow-integraties

Codex is nauw geïntegreerd in de workflows van ontwikkelaars:

- Codex CLI — terminal-first interactie, ondersteunt screenshots, takenlijst en agentgoedkeuringen. De CLI is open-source en geoptimaliseerd voor agent-codeerworkflows.

- Codex IDE-extensie — integreert de agent in VS Code (en forks), zodat u lokale diffs kunt bekijken, cloudtaken kunt maken en werk kunt verplaatsen tussen cloud- en lokale contexten met behoud van de status.

- Codex Cloud / GitHub — Cloudtaken kunnen worden geconfigureerd om PR's automatisch te beoordelen, tijdelijke containers voor tests te spawnen en taaklogboeken en schermafbeeldingen aan PR-threads te koppelen.

Opvallende beperkingen en afwegingen

- Smalle optimalisatie:Sommige niet-coderende productie-evaluaties zijn iets lager voor GPT-5-Codex dan voor de algemene GPT-5-variant — een herinnering dat specialisatie ten koste kan gaan van algemeenheid.

- Test afhankelijkheid: Agentisch gedrag is afhankelijk van beschikbare geautomatiseerde tests. Codebases met een slechte testdekking leggen beperkingen op bij automatische verificatie en vereisen mogelijk menselijk toezicht.

Voor welke taken is GPT-5-Codex vooral goed of slecht?

Goed in: complexe refactoringen, het creëren van scaffolds voor grote projecten, het schrijven en oplossen van tests, het voldoen aan PR-verwachtingen en het diagnosticeren van runtime-problemen met meerdere bestanden.

Minder goed in: Taken die actuele of bedrijfseigen interne kennis vereisen die niet in de werkruimte aanwezig is, of taken die een hoge mate van correctheid vereisen zonder menselijke controle (veiligheidskritische systemen hebben nog steeds experts nodig). Onafhankelijke reviews laten ook een gemengd beeld zien van de kwaliteit van de ruwe code in vergelijking met andere gespecialiseerde coderingsmodellen: sterke punten in agentische workflows vertalen zich niet uniform in de beste correctheid in elke benchmark.

Wat laten benchmarks zien over de prestaties van GPT-5-Codex?

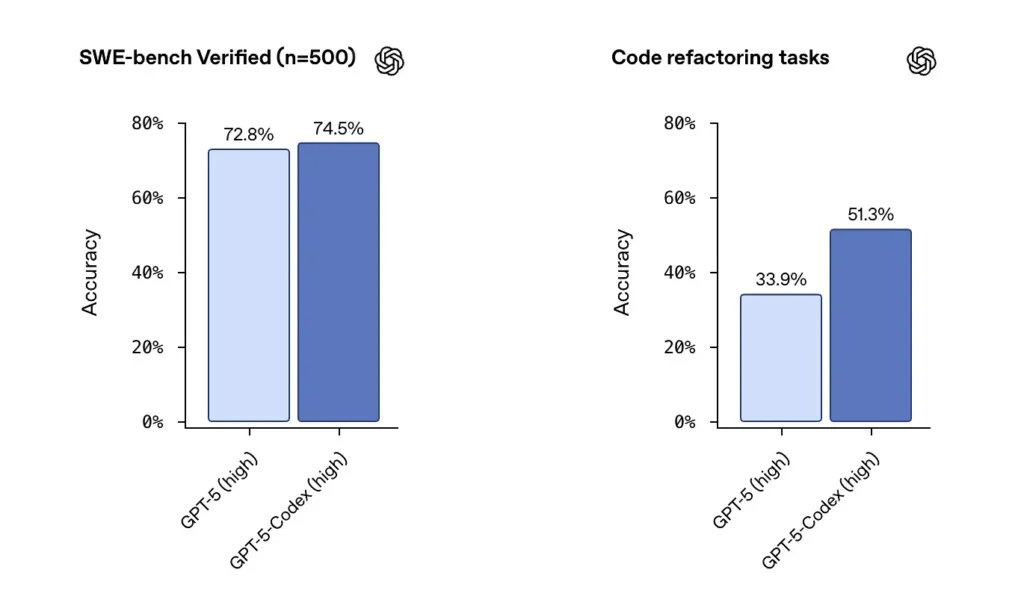

SWE-bench / SWE-bench Geverifieerd: OpenAI stelt dat GPT-5-Codex beter presteert dan GPT-5 in agentische coderingsbenchmarks zoals SWE-bench Verified, en winst laat zien bij coderefactoringtaken uit grote repositories. In de SWE-bench Verified-dataset, die 500 real-world software engineering-taken bevat, behaalde GPT-5-Codex een slagingspercentage van 74.5%. Dit overtreft de 5% van GPT-72.8 op dezelfde benchmark, wat de verbeterde mogelijkheden van de agent benadrukt. 500 programmeertaken van echte open-sourceprojecten. Voorheen konden slechts 477 taken worden getest, maar nu kunnen alle 500 taken worden getest → completere resultaten.

Van eerdere GPT-5-instellingen naar GPT-5-Codex zijn de evaluatiescores voor code-refactoring aanzienlijk gestegen - cijfers zoals de verschuiving van ~34% naar ~51% op een specifieke refactoring-metriek met hoge verbosity werden benadrukt in vroege analyses). Deze winsten zijn betekenisvol omdat ze een verbetering weerspiegelen op grote, realistische refactoringen in plaats van speelgoedvoorbeelden — maar er blijven kanttekeningen bij de reproduceerbaarheid en de exacte testopstelling.

Hoe krijgen ontwikkelaars en teams toegang tot GPT-5-Codex?

OpenAI heeft GPT-5-Codex geïntegreerd in de Codex-productomgevingen: het is live overal waar Codex vandaag draait (bijvoorbeeld de Codex CLI en geïntegreerde Codex-ervaringen). Voor ontwikkelaars die Codex gebruiken via CLI en ChatGPT-aanmelding, zal de bijgewerkte Codex-ervaring het GPT-5-Codex-model zichtbaar maken. OpenAI heeft aangegeven dat het model "binnenkort" beschikbaar zal zijn in de bredere API voor gebruikers van API-sleutels, maar bij de eerste uitrol verloopt de primaire toegang via Codex-tools in plaats van een openbaar API-eindpunt.

Codex CLI

Schakel Codex in om concept-PR's in een sandbox-repository te beoordelen, zodat u de kwaliteit van reacties zonder risico kunt beoordelen. Gebruik de goedkeuringsmodi met mate.

- Opnieuw ontworpen rondom een agentische coderingsworkflow.

- Ondersteuning voor het toevoegen van afbeeldingen (zoals wireframes, ontwerpen en screenshots van UI-bugs) biedt context voor modellen.

- Er is een takenlijstfunctie toegevoegd om de voortgang van complexe taken bij te houden.

- Ondersteuning voor externe tools (web zoeken, MCP-verbinding).

- De nieuwe terminalinterface verbetert het aanroepen van tools en de opmaak van verschillen. Bovendien is de toestemmingsmodus vereenvoudigd tot drie niveaus (alleen-lezen, automatisch en volledige toegang).

IDE-extensie

Integreren in IDE-workflows: Voeg de Codex IDE-extensie toe voor ontwikkelaars die inline previews en snellere iteratie willen. Het verplaatsen van taken tussen de cloud en lokaal met behoud van context kan de frictie bij complexe functies verminderen.

- Ondersteunt VS Code, Cursor en meer.

- Roep Codex rechtstreeks aan vanuit de editor om de context van het momenteel geopende bestand en de code te benutten voor nauwkeurigere resultaten.

- Schakel naadloos tussen taken tussen lokale en cloudomgevingen en behoud daarbij de contextuele continuïteit.

- Bekijk en werk met cloudtaakresultaten rechtstreeks in de editor, zonder dat u van platform hoeft te wisselen.

GitHub-integratie en cloudfuncties

- Geautomatiseerde PR-beoordeling: activeert automatisch de voortgang van concept naar gereed.

- Ondersteunt ontwikkelaars bij het aanvragen van gerichte beoordelingen, rechtstreeks in het @codex-gedeelte van een PR.

- Aanzienlijk snellere cloudinfrastructuur: verlaag de taakresponstijden met 90% dankzij containercaching.

- Geautomatiseerde configuratie van de omgeving: voert installatiescripts uit en installeert afhankelijkheden (bijv. pip install).

- Start automatisch een browser, controleert front-end-implementaties en voegt schermafbeeldingen toe aan taken of PR's.

Wat zijn de veiligheids-, beveiligings- en beperkingsoverwegingen?

OpenAI legt de nadruk op meerdere mitigatielagen voor Codex-agenten:

- Training op modelniveau: Gerichte veiligheidstrainingen om snelle injecties te voorkomen en schadelijk of risicovol gedrag te beperken.

- Controles op productniveau: sandbox-standaardgedrag, configureerbare netwerktoegang, goedkeuringsmodi voor het uitvoeren van opdrachten, terminallogs en citaten voor traceerbaarheid, en de mogelijkheid om menselijke goedkeuring te vereisen voor gevoelige acties. OpenAI heeft ook een "systeemkaartaddendum" gepubliceerd waarin deze mitigerende maatregelen en hun risicobeoordelingen worden beschreven, met name voor de mogelijkheden in het biologische en chemische domein.

Deze controles weerspiegelen het feit dat een agent die opdrachten kan uitvoeren en afhankelijkheden kan installeren, een reëel aanvalsoppervlak en risico's met zich meebrengt. OpenAI combineert modeltraining met productbeperkingen om misbruik te beperken.

Wat zijn bekende beperkingen?

- Geen vervanging voor menselijke reviewers: OpenAI beveelt Codex expliciet aan als een extra reviewer, geen vervanger. Menselijk toezicht blijft cruciaal, vooral bij beslissingen over beveiliging, licenties en architectuur.

- Benchmarks en claims moeten zorgvuldig worden gelezen: Reviewers hebben gewezen op verschillen in evaluatiesubsets, verbosity-instellingen en kostenafwegingen bij het vergelijken van modellen. Vroege onafhankelijke tests laten gemengde resultaten zien: Codex vertoont sterk agentisch gedrag en refactoringverbeteringen, maar de relatieve nauwkeurigheid ten opzichte van andere leveranciers varieert per benchmark en configuratie.

- Hallucinaties en onregelmatig gedrag: Net als alle LLM's kan Codex hallucineren (URL's verzinnen, afhankelijkheidsgrafieken verkeerd weergeven), en de agentruns van meerdere uren kunnen in grensgevallen nog steeds te maken krijgen met kwetsbaarheid. Verwacht dat de output gevalideerd zal worden met tests en menselijke beoordeling.

Wat zijn de bredere implicaties voor software engineering?

GPT-5-Codex laat een volwassenwordende verschuiving in LLM-ontwerp zien: in plaats van alleen de mogelijkheden van de naakte taal te verbeteren, optimaliseren leveranciers gedrag voor lange, agentische taken (uitvoering van meerdere uren, testgestuurde ontwikkeling, geïntegreerde reviewpijplijnen). Dit verandert de productiviteitseenheid van een enkel gegenereerd fragment naar taak volbrengen — het vermogen van het model om een ticket te accepteren, een reeks tests uit te voeren en iteratief een gevalideerde implementatie te produceren. Als deze agents robuust en goed beheerd worden, zullen ze workflows hervormen (minder handmatige refactors, snellere PR-cycli, ontwikkelaarstijd gericht op ontwerp en strategie). Maar de transitie vereist zorgvuldig procesontwerp, menselijk toezicht en veiligheidsbeheer.

Conclusie — Wat moet je onthouden?

GPT-5-Codex is een gerichte stap in de richting van ingenieurskwaliteit LLM's: een GPT-5-variant die getraind, afgestemd en geproduceerd is om te fungeren als een capabele codeeragent binnen het Codex-ecosysteem. Het brengt tastbare nieuwe gedragingen met zich mee – adaptieve redeneertijd, lange autonome runs, geïntegreerde sandbox-uitvoering en gerichte verbeteringen in codereview – terwijl de bekende kanttekeningen van taalmodellen (de noodzaak van menselijk toezicht, evaluatienuances en incidentele hallucinaties) behouden blijven. Voor teams is de verstandige weg gemeten experimenten: piloteer op veilige opslagplaatsen, monitor uitkomstmetingen en integreer de agent stapsgewijs in de workflows van reviewers. Naarmate OpenAI de API-toegang uitbreidt en benchmarks van derden toenemen, mogen we duidelijkere vergelijkingen en concretere richtlijnen verwachten over kosten, nauwkeurigheid en best practices.

Beginnen

CometAPI is een uniform API-platform dat meer dan 500 AI-modellen van toonaangevende aanbieders – zoals de GPT-serie van OpenAI, Google Gemini, Anthropic's Claude, Midjourney, Suno en meer – samenvoegt in één, ontwikkelaarsvriendelijke interface. Door consistente authenticatie, aanvraagopmaak en responsverwerking te bieden, vereenvoudigt CometAPI de integratie van AI-mogelijkheden in uw applicaties aanzienlijk. Of u nu chatbots, beeldgenerators, muziekcomponisten of datagestuurde analysepipelines bouwt, met CometAPI kunt u sneller itereren, kosten beheersen en leveranciersonafhankelijk blijven – en tegelijkertijd profiteren van de nieuwste doorbraken in het AI-ecosysteem.

Ontwikkelaars hebben toegang tot GPT-5-Codex API Via CometAPI zijn de nieuwste modellen van CometAPI vermeld vanaf de publicatiedatum van het artikel. Voordat u toegang krijgt, dient u ervoor te zorgen dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen.