Kimi K2 vertegenwoordigt een significante sprong voorwaarts in open-source grote taalmodellen en combineert state-of-the-art mixed-of-expert-architectuur met gespecialiseerde training voor agentische taken. Hieronder bespreken we de oorsprong, het ontwerp, de prestaties en praktische overwegingen voor toegang en gebruik.

Wat is Kimi K2?

Kimi K2 is een taalmodel met een mix van biljoen parameters (MoE) ontwikkeld door Moonshot AI. Het beschikt over 32 miljard "geactiveerde" parameters – de parameters die per token worden gebruikt – en een totaal aantal expertparameters van 1 biljoen, wat een enorme capaciteit mogelijk maakt zonder lineaire inferentiekosten. Kimi K2 is gebaseerd op de Muon-optimizer en is getraind op meer dan 15.5 biljoen tokens, waardoor stabiliteit is bereikt op schaalgroottes die voorheen als onpraktisch werden beschouwd. Het model wordt aangeboden in twee hoofdvarianten:

Kimi‑K2‑Instructie: Vooraf afgestemd op conversatie- en agenttoepassingen, klaar voor onmiddellijke implementatie in dialoogsystemen en toolgestuurde workflows.

Kimi‑K2‑Basis: Een fundamenteel model dat geschikt is voor onderzoek, specifieke aanpassingen en experimenten op laag niveau.

Hoe werkt de architectuur ervan?

- Mix van deskundigen (MoE): Op elke laag selecteert een poortmechanisme een kleine subgroep experts (8 van de 384) om elk token te verwerken. Hierdoor wordt de rekenkracht voor de inferentie aanzienlijk verminderd, terwijl er toch een enorme kennisbasis behouden blijft.

- Gespecialiseerde lagen: Omvat een enkele dichte laag naast 61 lagen in totaal, met 64 aandachtskoppen en verborgen afmetingen op maat voor MoE-efficiëntie.

- Context en woordenschat: Ondersteunt maximaal 128 K tokens in contextlengte en een vocabulaire van 160 K-tokens, waardoor langdurig begrip en generatie mogelijk is.

Waarom is Kimi K2 belangrijk?

Kimi K2 verlegt de grenzen van open-source AI door prestaties te leveren die vergelijkbaar zijn met die van toonaangevende, gepatenteerde modellen, met name op het gebied van benchmarks voor coderen en redeneren.

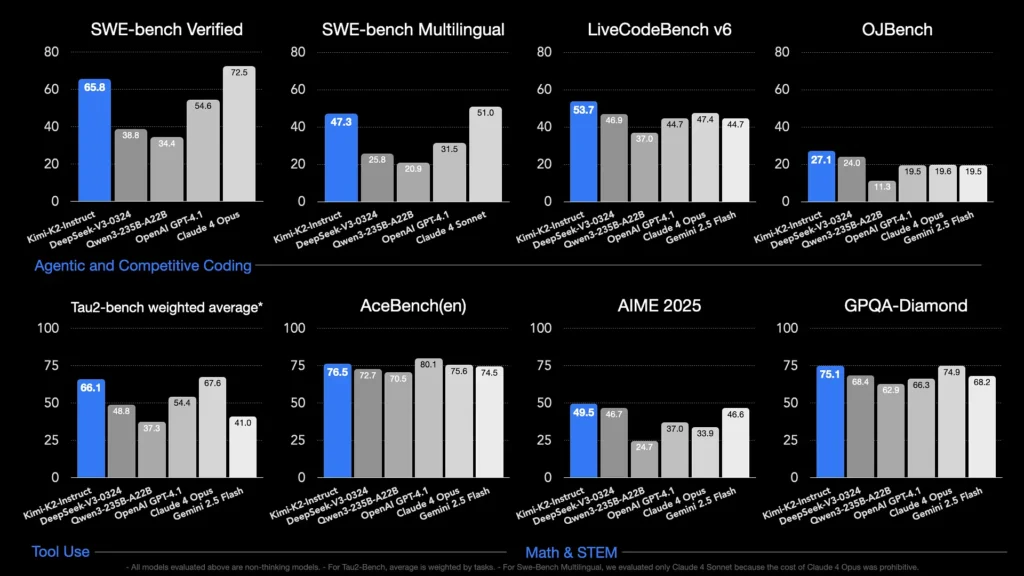

Welke benchmarks tonen de mogelijkheden ervan aan?

- LiveCodeBench v6: Behaalt een slagingspercentage van 1% bij het behalen van het eerste examen, wat leidt tot toonaangevende open-sourcemodellen en concurreert met gesloten systemen zoals GPT-53.7 (4.1%).

- SWE‑bench geverifieerd: Scores van 65.8%, beter dan de 4.1% van GPT‑54.6 en alleen lager dan Claude Sonnet 4 in openbaar beschikbare vergelijkingstests.

- MultiPL‑E en OJBench: Toont robuuste vaardigheden in meertalige codering (85.7% op MultiPL‑E) en betrouwbare prestaties bij echte programmeeruitdagingen.

- Wiskunde-500: Behaalt 97.4%, meer dan de 4.1% van GPT-92.4, wat getuigt van de bekwaamheid in formeel wiskundig redeneren.

Hoe is het geoptimaliseerd voor agenttaken?

Naast het genereren van ruwe data is Kimi K2 getraind met synthetische toolgebruikscenario's – Model Context Protocol (MCP)-data – om externe tools aan te roepen, processen met meerdere stappen te doorgronden en autonoom problemen op te lossen. Dit maakt het bijzonder geschikt voor omgevingen zoals Cline, waar het code-uitvoering, API-interactie en workflowautomatisering naadloos kan orkestreren.

Hoe krijg ik toegang tot Kimi K2?

De toegangsopties omvatten officiële platformen, opensourcedistributies en integraties van derden, en voldoen zo aan de behoeften van onderzoek, ontwikkeling en ondernemingen.

Officieel Moonshot AI-platform

Moonshot AI biedt gehoste inferentie via zijn platform en biedt API-toegang met lage latentie tot zowel Kimi-K2-Base als Kimi-K2-Instruct. De prijzen zijn gebaseerd op rekenkracht, met enterprise-abonnementen inclusief prioriteitssupport en on-premises implementaties. Gebruikers kunnen zich aanmelden op de website van Moonshot AI en API-sleutels ophalen voor directe integratie.

KomeetAPI

CometAPI heeft K2 al geïntegreerd in zijn aanbod. Het bundelt K2-inferentie met beheerde GPU-infrastructuur, SLA-garanties en schaalbare prijsniveaus, waardoor organisaties kunnen kiezen tussen pay-as-you-go API-gebruik of gereserveerde capaciteit met volumekortingen.

CometAPI is een uniform API-platform dat meer dan 500 AI-modellen van toonaangevende aanbieders – zoals de GPT-serie van OpenAI, Gemini van Google, Claude, Midjourney en Suno van Anthropic – samenvoegt in één gebruiksvriendelijke interface voor ontwikkelaars. Door consistente authenticatie, aanvraagopmaak en responsverwerking te bieden, vereenvoudigt CometAPI de integratie van AI-mogelijkheden in uw applicaties aanzienlijk.

Ontwikkelaars hebben toegang tot Kimi K2 API(kimi-k2-0711-preview)door KomeetAPIOm te beginnen, verken de mogelijkheden van het model in de Speeltuin en raadpleeg de API-gidsvoor gedetailleerde instructies. Zorg ervoor dat u bent ingelogd op CometAPI en de API-sleutel hebt verkregen voordat u toegang krijgt.

Integraties van tools van derden

- Cline: Een populaire codegerichte IDE die Kimi K2 native ondersteunt via de

cline:moonshotai/kimi-k2provider, waarmee ontwikkelaars met één klik toegang hebben tot chat, codegeneratie en agentworkflows binnen hun editor. - Knuffelende gezichtsruimtes: Door de community gehoste demo's en minimale gebruikersinterfaces laten gebruikers rechtstreeks in de browser met K2-Instruct-modellen werken. Een Hugging Face-account is vereist en de prestaties kunnen variëren afhankelijk van gedeelde backend-resources.

Hoe gebruik ik Kimi K2?

Nadat u een toegangsmethode hebt gekozen, kunt u K2 voor uiteenlopende taken gebruiken: van chatten tot code-uitvoering tot autonome agents.

Via API of platform SDK

- Authenticate: Haal uw API-sleutel op bij Moonshot AI of CometAPI.

- Client initialiseren: Gebruik de officiële SDK (Python/JavaScript) of standaard HTTP-verzoeken.

- Kies modelvariant:

- Kimi-K2-basis voor verfijning en onderzoek.

- Kimi‑K2‑Instruct voor plug-and-play chat en agenten.

- Het model van CometAPI:

kimi-k2-0711-preview

- Verzendprompts: Formatteer invoer volgens de chatsjabloon (systeem-, gebruiker-, assistentrollen) om optimaal instructievolggedrag te benutten.

Lokaal draaien met llama.cpp

Gebruik voor offline of zelf-gehoste installaties de door Unsloth gekwantiseerde GGUF-gewichten (245 GB voor dynamische quant van 1.8 bits).

- Downloadgewichten: Van de Moonshot AI GitHub of Hugging Face repository.

- Installeer llama.cpp: Zorg ervoor dat u voldoende schijfruimte (≥ 250 GB) en gecombineerd RAM+VRAM (≥ 250 GB) hebt voor een doorvoer van ~5 tokens/s.

- Lanceermodel:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Instellingen aanpassen: Gebruik aanbevolen parameters (

rope_freq_base,context_len) gedocumenteerd in de Unsloth-gids voor stabiele prestaties.

Integraties met ontwikkeltools

- IDE-plug-ins: Verschillende community-plugins maken K2 mogelijk in VS Code, Neovim en JetBrains IDE's. Configuratie omvat doorgaans het specificeren van het API-eindpunt en de model-ID in de instellingen.

- Automatiseringsframeworks: Benut de agentische kern van K2 met frameworks als LangChain of Haystack om prompts, API-aanroepen en code-uitvoeringsstappen aan elkaar te koppelen tot complexe automatiseringen.

Wat zijn de typische use cases voor Kimi K2?

De combinatie van schaal, training van agenten en open toegang maakt K2 veelzijdig in verschillende domeinen.

Hulp bij het coderen

Van boilerplate-generatie en refactoring tot het oplossen van bugs en prestatieprofilering: de SOTA-coderingsbenchmarks van K2 leveren echte productiviteitswinst op. Vaak overtreffen ze alternatieven op het gebied van leesbaarheid en eenvoud.

Kennis en redenering

Met een contextlengte van 128 K verwerkt K2 lange documenten, vragen en antwoorden over meerdere documenten en redeneringen gebaseerd op een keten van gedachten. De MoE-architectuur zorgt ervoor dat diverse kennis behouden blijft zonder catastrofale vergetelheid.

Agentische workflows

K2 blinkt uit in het orkestreren van taken met meerdere stappen, zoals het ophalen van gegevens, het aanroepen van API's, het bijwerken van codebases en het samenvatten van resultaten. Hierdoor is het ideaal voor autonome assistenten bij klantondersteuning, gegevensanalyse en DevOps.

Hoe verhoudt Kimi K2 zich tot andere open-sourcemodellen?

Terwijl DeepSeek's V3 en Meta's recente openbare releases eerder in 2025 het nieuws domineerden, onderscheidt Kimi K2 zich door:

Agentische intelligentie

Kimi K2 is expliciet ontworpen voor 'agentische' workflows: het automatiseren van taken via tool calls, shell-opdrachten, webautomatisering en API-integraties. De self-play-augmented trainingsdataset bevat diverse voorbeelden van tool calls, wat naadloze integratie met systemen uit de praktijk mogelijk maakt.

Kostenefficiënt toezicht

Met ongeveer 80-90% lagere inferentiekosten per token vergeleken met modellen als Claude Sonnet 4 biedt Kimi K2 prestaties op ondernemingsniveau zonder torenhoge prijzen, wat zorgt voor een snelle acceptatie door prijsbewuste ontwikkelaars.

Licenties en toegankelijkheid

In tegenstelling tot bepaalde open source-versies die gebonden zijn aan beperkende licenties, is Kimi K2 beschikbaar onder een permissieve licentie die commercieel gebruik, afgeleide werken en lokale implementaties toestaat. Dit is geheel in lijn met de open source-filosofie van Moonshot AI.

- Door geavanceerd MoE-ontwerp, strenge agenttraining en open-sourcebeschikbaarheid te combineren, stelt Kimi K2 ontwikkelaars en onderzoekers in staat om intelligente, autonome applicaties te bouwen zonder onbetaalbare kosten of gesloten ecosystemen. Of u nu code schrijft, complexe workflows met meerdere stappen ontwikkelt of experimenteert met grootschalige redeneringen, K2 biedt een veelzijdige, krachtige basis.