Wat is Llama 4?

meta Platforms heeft zijn nieuwste reeks grote taalmodellen (LLM's) onthuld onder de Llama 4-serie, wat een aanzienlijke vooruitgang in kunstmatige intelligentietechnologie markeert. De Llama 4-collectie introduceert in april 2025 twee primaire modellen: Llama 4 Scout en Llama 4 Maverick. Deze modellen zijn ontworpen om verschillende gegevensformaten te verwerken en vertalen, waaronder tekst, video, afbeeldingen en audio, en tonen hun multimodale mogelijkheden. Daarnaast heeft Meta een preview gegeven van Llama 4 Behemoth, een aankomend model dat wordt aangeprezen als een van de krachtigste LLM's tot nu toe, bedoeld om te helpen bij het trainen van toekomstige modellen.

Waarin verschilt Llama 4 van eerdere modellen?

Verbeterde multimodale mogelijkheden

In tegenstelling tot zijn voorgangers is Llama 4 ontworpen om naadloos met meerdere datamodaliteiten om te gaan. Dit betekent dat het reacties kan analyseren en genereren op basis van tekst, afbeeldingen, video's en audio-inputs, waardoor het zeer aanpasbaar is voor diverse toepassingen.

Introductie van gespecialiseerde modellen

Meta heeft twee gespecialiseerde versies binnen de Llama 4-serie geïntroduceerd:

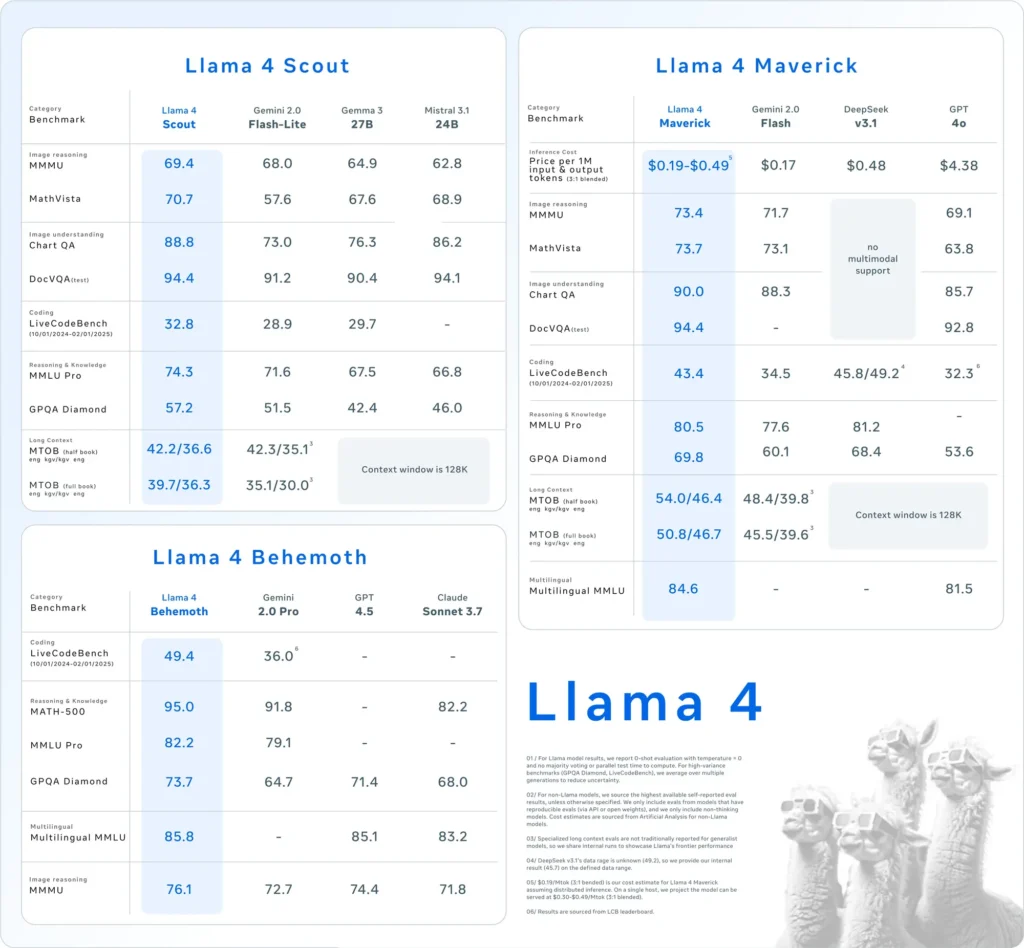

- Lama 4 Scout: Een compact model dat is geoptimaliseerd om efficiënt te draaien op een enkele Nvidia H100 GPU. Het beschikt over een contextvenster van 10 miljoen tokens en heeft superieure prestaties laten zien ten opzichte van concurrenten zoals Google's Gemma 3 en Mistral 3.1 in verschillende benchmarks.

- Lama 4 Maverick: Een groter model dat qua prestaties vergelijkbaar is met OpenAI's GPT-4o en DeepSeek-V3, en dat vooral uitblinkt in coderings- en redeneertaken, terwijl er minder actieve parameters worden gebruikt.

Bovendien ontwikkelt Meta Lama 4 Behemoth, een model met 288 miljard actieve parameters en een totaal van 2 biljoen, met als doel modellen als GPT-4.5 en Claude Sonnet 3.7 te overtreffen op STEM-benchmarks.

Aanname van de Mixture of Experts (MoE)-architectuur

Llama 4 gebruikt een "mixture of experts" (MoE) architectuur, waarbij het model wordt verdeeld in gespecialiseerde eenheden om het gebruik van bronnen te optimaliseren en de prestaties te verbeteren. Deze aanpak zorgt voor efficiëntere verwerking door alleen relevante subsets van het model te activeren voor specifieke taken.

Hoe verhoudt Llama 4 zich tot andere AI-modellen?

Llama 4 positioneert zich concurrerend onder toonaangevende AI-modellen:

- Prestatiebenchmarks: De prestaties van Llama 4 Maverick zijn vergelijkbaar met die van OpenAI's GPT-4o en DeepSeek-V3 bij codeer- en redeneertaken, terwijl Llama 4 Scout in verschillende benchmarks beter presteert dan modellen als Google's Gemma 3 en Mistral 3.1.

- Open source-aanpak: Meta blijft Llama-modellen aanbieden als open-source, wat bredere samenwerking en integratie op verschillende platforms promoot. De Llama 4-licentie legt echter beperkingen op aan commerciële entiteiten met meer dan 700 miljoen gebruikers, wat discussies oproept over de echte openheid van het model.

| Categorie | criterium | Lama 4 Maverick | GPT-4o | Gemini 2.0 Flitser | DeepSeek v3.1 |

|---|---|---|---|---|---|

| Beeldredenering | MMMU | 73.4 | 69.1 | 71.7 | Geen multimodale ondersteuning |

| MathVista | 73.7 | 63.8 | 73.1 | Geen multimodale ondersteuning | |

| Beeldbegrip | GrafiekQA | 90.0 | 85.7 | 88.3 | Geen multimodale ondersteuning |

| DocVQA (test) | 94.4 | 92.8 | - | Geen multimodale ondersteuning | |

| codering | LiveCodeBench | 43.4 | 32.3 | 34.5 | 45.8/49.2 |

| Redeneren en kennis | MMLU-Pro | 80.5 | - | 77.6 | 81.2 |

| GPQA-diamant | 69.8 | 53.6 | 60.1 | 68.4 | |

| Meertalig | Meertalige MMLU | 84.6 | 81.5 | - | - |

| Lange context | MTOB (half boek) eng→kgv/kgv→eng | 54.0/46.4 | Context beperkt tot 128K | 48.4/39.8 | Context beperkt tot 128K |

| MTOB (volledig boek) eng→kgv/kgv→eng | 50.8/46.7 | Context beperkt tot 128K | 45.5/39.6 | Context beperkt tot 128K |

Hoe presteert Llama 4 in benchmarktests?

Benchmarkevaluaties bieden inzicht in de prestaties van de Llama 4-modellen:

- Lama 4 Scout: Dit model overtreft verschillende concurrenten, waaronder Google's Gemma 3 en Mistral 3.1, in verschillende benchmarks. Het vermogen om te werken met een contextvenster van 10 miljoen tokens op één GPU benadrukt de efficiëntie en effectiviteit bij het verwerken van complexe taken.

- Lama 4 Maverick: Vergelijkbaar in prestaties met OpenAI's GPT-4o en DeepSeek-V3, blinkt Llama 4 Maverick uit in coderings- en redeneertaken terwijl er minder actieve parameters worden gebruikt. Deze efficiëntie gaat niet ten koste van de capaciteit, waardoor het een sterke kanshebber is in het LLM-landschap.

- Lama 4 Behemoth: Met 288 miljard actieve parameters en een totaal van 2 biljoen overtreft Llama 4 Behemoth modellen als GPT-4.5 en Claude Sonnet 3.7 op STEM-benchmarks. Het uitgebreide aantal parameters en de prestaties geven aan dat het een potentieel heeft als fundamenteel model voor toekomstige AI-ontwikkelingen.

Deze benchmarkresultaten onderstrepen Meta's toewijding aan het verbeteren van AI-mogelijkheden en het positioneren van de Llama 4-serie als een geduchte speler in het veld.

Hoe krijgen gebruikers toegang tot Llama 4?

Meta heeft de Llama 4-modellen geïntegreerd in zijn AI-assistent, waardoor ze toegankelijk zijn op platforms zoals WhatsApp, Messenger, Instagram en het web. Deze integratie stelt gebruikers in staat om de verbeterde mogelijkheden van Llama 4 te ervaren binnen bekende applicaties.

Voor ontwikkelaars en onderzoekers die geïnteresseerd zijn in het benutten van Llama 4 voor aangepaste applicaties, biedt Meta toegang tot de modelgewichten via platforms zoals Hugging Face en zijn eigen distributiekanalen. Deze open-sourcebenadering stelt de AI-community in staat om te innoveren en voort te bouwen op de mogelijkheden van Llama 4.

Het is belangrijk om op te merken dat hoewel Llama 4 op de markt wordt gebracht als open-source, de licentie beperkingen oplegt aan commerciële entiteiten met meer dan 700 miljoen gebruikers. Organisaties moeten de licentievoorwaarden controleren om naleving van de richtlijnen van Meta te garanderen.

Bouw snel met Llama 4 op CometAPI

CometAPI biedt toegang tot meer dan 500 AI-modellen, waaronder open-source en gespecialiseerde multimodale modellen voor chat, afbeeldingen, code en meer. De belangrijkste kracht ligt in het vereenvoudigen van het traditioneel complexe proces van AI-integratie. Door API-aggregatie te centraliseren in één platform, bespaart het gebruikers waardevolle tijd en middelen die anders zouden worden besteed aan het beheren van afzonderlijke platforms en providers. Hiermee is toegang tot toonaangevende AI-tools zoals Claude, OpenAI, Deepseek en Gemini beschikbaar via één uniform abonnement. U kunt de API in CometAPI gebruiken om muziek en artwork te maken, video's te genereren en uw eigen workflows te bouwen

KomeetAPI bieden een prijs die veel lager is dan de officiële prijs om u te helpen integreren Lama 4 API, en u ontvangt $1 op uw account na registratie en inloggen! Welkom bij registratie en ervaar CometAPI.CometAPI betaalt terwijl u gaat,Lama 4 API in CometAPI is de prijs als volgt gestructureerd:

| Categorie | lama-4-maverick | lama-4-scout |

| API-prijzen | Invoertokens: $0.48 / M tokens | Invoertokens: $0.216 / M tokens |

| Uitvoertokens: $1.44/ M tokens | Uitvoertokens: $1.152/ M tokens |

- Raadpleeg Lama 4 API voor integratiedetails.

- Voor informatie over het model dat in Comet API is opgenomen, zie https://api.cometapi.com/new-model.

- Voor informatie over de modelprijs in Comet API, zie https://api.cometapi.com/pricing

Begin met bouwen op CometAPI vandaag – meld je aan hier voor gratis toegang of schaal zonder tarieflimieten door te upgraden naar een CometAPI betaald abonnement.

Wat zijn de gevolgen van de release van Llama 4?

Integratie over Meta-platforms heen

Llama 4 is geïntegreerd in de AI-assistent van Meta op platforms zoals WhatsApp, Messenger, Instagram en het web, waardoor de gebruikerservaring wordt verbeterd met geavanceerde AI-mogelijkheden.

Impact op de AI-industrie

De release van Llama 4 onderstreept Meta's agressieve push in AI, met plannen om tot $ 65 miljard te investeren in de uitbreiding van zijn AI-infrastructuur. Deze stap weerspiegelt de groeiende concurrentie tussen techgiganten om het voortouw te nemen in AI-innovatie.

Overwegingen bij energieverbruik

De substantiële rekenkracht die nodig is voor Llama 4 roept zorgen op over energieverbruik en duurzaamheid. Het bedienen van een cluster van meer dan 100,000 GPU's vereist aanzienlijke energie, wat leidt tot discussies over de impact van grootschalige AI-modellen op het milieu.

Wat brengt de toekomst voor Llama 4?

Meta is van plan om verdere ontwikkelingen en toepassingen van Llama 4 te bespreken tijdens de komende LlamaCon-conferentie op 29 april 2025. De AI-community verwacht inzichten in Meta's strategieën om huidige uitdagingen aan te pakken en de mogelijkheden van Llama 4 in verschillende sectoren te benutten.

Samenvattend vertegenwoordigt Llama 4 een significante vooruitgang in AI-taalmodellen, met verbeterde multimodale mogelijkheden en gespecialiseerde architecturen. Ondanks de uitdagingen op het gebied van ontwikkeling, positioneren de substantiële investeringen en strategische initiatieven van Meta Llama 4 als een geduchte concurrent in het evoluerende AI-landschap.