In een landschap dat wordt gedomineerd door de “scale-at-all-costs”-filosofie—waar modellen zoals Flux.2 en Hunyuan-Image-3.0 het aantal parameters naar de enorme 30B tot 80B stuwen—is een nieuwe uitdager opgestaan om de status quo te doorbreken. Z-Image, ontwikkeld door Alibaba’s Tongyi Lab, is officieel gelanceerd en doorbreekt de verwachtingen met een slanke architectuur van 6 miljard parameters die de outputkwaliteit van industriereuzen evenaart, terwijl hij draait op consumentenhardware.

Uitgebracht eind 2025, heeft Z-Image (en de razendsnelle variant Z-Image-Turbo) de AI-community direct geboeid, met meer dan 500.000 downloads binnen 24 uur na de introductie. Door fotorealistische beelden te leveren in slechts 8 inferentiestappen, is Z-Image niet zomaar een model; het is een democratiserende kracht in generatieve AI, die hoogwaardige creatie mogelijk maakt op laptops die zouden bezwijken onder zijn concurrenten.

Wat is Z-Image?

Z-Image is een nieuw, open-source fundamentmodel voor beeldgeneratie, ontwikkeld door het Tongyi-MAI / Alibaba Tongyi Lab onderzoeksteam. Het is een generatief model met 6 miljard parameters, gebouwd op een nieuwe Scalable Single-Stream Diffusion Transformer (S3-DiT)-architectuur die teksttokens, visuele semantische tokens en VAE-tokens samenvoegt tot één verwerkingsstroom. Het ontwerpdoel is expliciet: topniveau-fotorealisme en naleving van instructies leveren, terwijl de inferentiekosten drastisch worden verlaagd en praktische inzet op consumentenhardware mogelijk wordt. Het Z-Image-project publiceert code, modelgewichten en een online demo onder een Apache-2.0-licentie.

Z-Image wordt geleverd in meerdere varianten. De meest besproken release is Z-Image-Turbo — een gedestilleerde, versie met weinig stappen geoptimaliseerd voor productie — plus de niet-gedestilleerde Z-Image-Base (foundation-checkpoint, beter geschikt voor fine-tuning) en Z-Image-Edit (instructie-getuned voor beeldbewerking).

Het “Turbo”-voordeel: inferentie in 8 stappen

De vlaggenschipvariant, Z-Image-Turbo, gebruikt een progressieve distillatietechniek genaamd Decoupled-DMD (Distribution Matching Distillation). Dit maakt compressie van het generatieproces van de standaard 30-50 stappen naar slechts 8 stappen mogelijk.

Resultaat: Generatietijden onder de seconde op enterprise-GPU’s (H800) en praktisch realtime prestaties op consumentenkaarten (RTX 4090), zonder de “plastic” of “uitgewassen” look die typisch is voor andere turbo/lightning-modellen.

4 kernfuncties van Z-Image

Z-Image zit boordevol functies die zowel technische ontwikkelaars als creatieve professionals aanspreken.

1. Onovertroffen fotorealisme & esthetiek

Ondanks slechts 6 miljard parameters produceert Z-Image beelden met verbluffende scherpte. Het blinkt uit in:

- Huidtextuur: Het repliceren van poriën, imperfecties en natuurlijke belichting bij menselijke onderwerpen.

- Materiaalfysica: Glas-, metaal- en stoftexturen nauwkeurig weergeven.

- Belichting: Superieure behandeling van cinematografische en volumetrische belichting vergeleken met SDXL.

2. Native tweetalige tekstrendering

Een van de grootste pijnpunten in AI-beeldgeneratie is tekstrendering. Z-Image lost dit op met native ondersteuning voor zowel Engels als Chinees.

- Het kan complexe posters, logo’s en signages genereren met correcte spelling en kalligrafie in beide talen, een functie die vaak ontbreekt in westers-georiënteerde modellen.

3. Z-Image-Edit: instructiegebaseerde bewerking

Naast het basismodel bracht het team Z-Image-Edit uit. Deze variant is fijn-afgesteld voor image-to-image-taken, waardoor gebruikers bestaande beelden kunnen wijzigen met natuurlijke taal-instructies (bijv. “Laat de persoon glimlachen,” “Verander de achtergrond in een besneeuwde berg”). Het behoudt hoge consistentie in identiteit en belichting tijdens deze transformaties.

4. Toegankelijkheid op consumentenhardware

- VRAM-efficiëntie: Draait comfortabel op 6GB VRAM (met kwantisering) tot 16GB VRAM (volledige precisie).

- Lokale uitvoering: Ondersteunt volledig lokale deployment via ComfyUI en

diffusers, waardoor gebruikers niet afhankelijk zijn van de cloud.

Hoe werkt Z-Image?

Single-stream diffusion transformer (S3-DiT)

Z-Image wijkt af van klassieke dual-stream ontwerpen (aparte tekst- en afbeeldingsencoders/streams) en voegt in plaats daarvan teksttokens, VAE-afbeeldingstokens en visuele semantische tokens samen tot één transformer-invoer. Deze single-stream benadering verbetert de parameterbenutting en vereenvoudigt de cross-modale afstemming in de transformer-backbone, wat volgens de auteurs een gunstige afweging tussen efficiëntie en kwaliteit oplevert voor een 6B-model.

Decoupled-DMD en DMDR (distillatie + RL)

Om generatie met weinig stappen (8 stappen) mogelijk te maken zonder de gebruikelijke kwaliteitsstraf, ontwikkelde het team een Decoupled-DMD-distillatiebenadering. De techniek scheidt CFG (classifier-free guidance)-augmentatie van distributiematching, zodat elk onafhankelijk kan worden geoptimaliseerd. Vervolgens passen ze een post-trainingsstap met reinforcement learning (DMDR) toe om semantische afstemming en esthetiek te verfijnen. Samen produceren deze Z-Image-Turbo met aanzienlijk minder NFEs dan typische diffusiemodellen, terwijl hoge realiteit behouden blijft.

Trainingsdoorvoer en kostenoptimalisatie

Z-Image werd getraind met een levenscyclusgerichte optimalisatieaanpak: samengestelde datapijplijnen, een gestroomlijnde leercurve en efficiëntiebewuste implementiekeuzes. De auteurs melden dat de volledige trainingsworkflow is voltooid in ongeveer 314K H800 GPU-uren (≈ USD $630K) — een expliciete, reproduceerbare engineeringmaatstaf die het model positioneert als kostenefficiënt ten opzichte van zeer grote alternatieven (>20B).

Benchmarkresultaten van het Z-Image-model

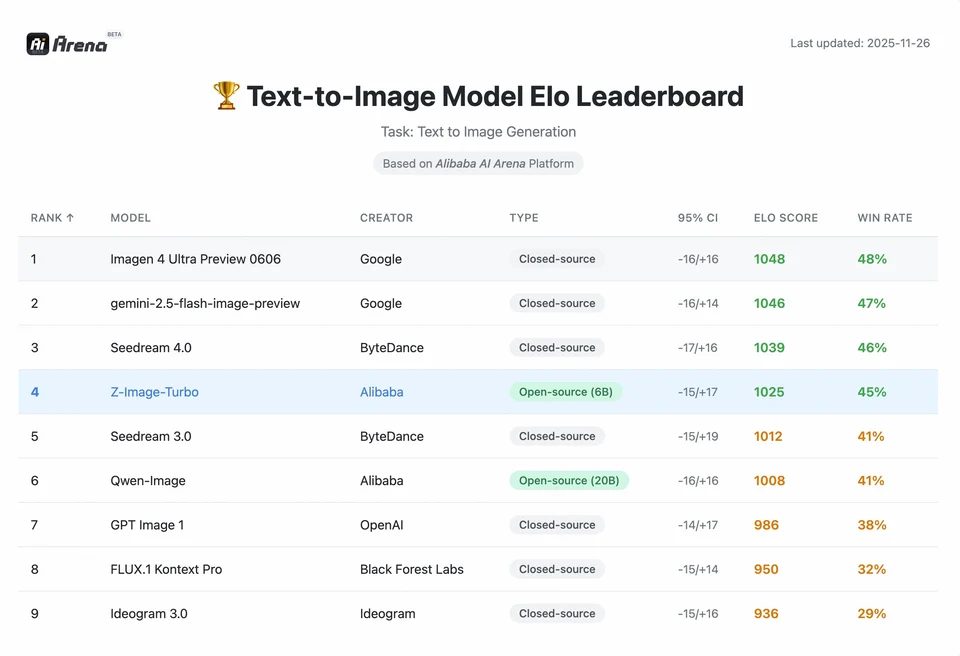

Z-Image-Turbo scoorde hoog op verschillende eigentijdse ranglijsten, waaronder een toppositie voor open-source op de Artificial Analysis Text-to-Image-ranglijst en sterke prestaties op Alibaba AI Arena voorkeursevaluaties door mensen.

Maar de kwaliteit in de praktijk hangt ook af van promptformulering, resolutie, upscaling-pipeline en aanvullende nabewerking.

Om de omvang van Z-Image’s prestatie te begrijpen, moeten we naar de gegevens kijken. Hieronder staat een vergelijkende analyse van Z-Image tegenover toonaangevende open-source en propriëtaire modellen.

Samenvatting van de vergelijkende benchmark

| Functie / Metriek | Z-Image-Turbo | Flux.2 (Dev/Pro) | SDXL Turbo | Hunyuan-Image |

|---|---|---|---|---|

| Architectuur | S3-DiT (enkelvoudige stream) | MM-DiT (dubbele stream) | U-Net | Diffusietransformer |

| Parameters | 6 miljard | 12B / 32B | 2.6B / 6.6B | ~30B+ |

| Inferentiestappen | 8 stappen | 25 - 50 stappen | 1 - 4 stappen | 30 - 50 stappen |

| Vereiste VRAM | ~6GB - 12GB | 24GB+ | ~8GB | 24GB+ |

| Tekstrendering | Hoog (EN + CN) | Hoog (EN) | Gemiddeld (EN) | Hoog (CN + EN) |

| Generatiesnelheid (4090) | ~1,5 - 3,0 seconden | ~15 - 30 seconden | ~0,5 seconden | ~20 seconden |

| Fotorealisme-score | 9,2/10 | 9,5/10 | 7,5/10 | 9,0/10 |

| Licentie | Apache 2.0 | Niet-commercieel (Dev) | OpenRAIL | Aangepast |

Data-analyse & prestatie-inzichten

- Snelheid vs. kwaliteit: Hoewel SDXL Turbo sneller is (1 stap), gaat de kwaliteit sterk achteruit bij complexe prompts. Z-Image-Turbo treft de “sweet spot” bij 8 stappen, evenaart de kwaliteit van Flux.2 en is 5x tot 10x sneller.

- Democratisering van hardware: Flux.2 is krachtig, maar effectief afgeschermd achter 24GB VRAM-kaarten (RTX 3090/4090) voor redelijke prestaties. Z-Image stelt gebruikers met midrange kaarten (RTX 3060/4060) in staat lokaal professionele 1024x1024-afbeeldingen te genereren.

Hoe kunnen ontwikkelaars Z-Image benaderen en gebruiken?

Er zijn drie typische benaderingen:

- Hosted / SaaS (web UI of API): Gebruik diensten zoals z-image.ai of andere aanbieders die het model deployen en een webinterface of betaalde API voor beeldgeneratie aanbieden. Dit is de snelste route voor experimenten zonder lokale setup.

- Hugging Face + diffusers pipelines: De Hugging Face-

diffusers-bibliotheek bevatZImagePipelineenZImageImg2ImgPipelineen biedt typischefrom_pretrained(...).to("cuda")-workflows. Dit is het aanbevolen pad voor Python-ontwikkelaars die een eenvoudige integratie en reproduceerbare voorbeelden willen. - Lokale native inferentie vanuit de GitHub-repo: De Tongyi-MAI-repo bevat native inferentiescripts, optimalisatie-opties (FlashAttention, compilatie, CPU offload) en instructies om

diffusersvanaf de bron te installeren voor de nieuwste integratie. Deze route is nuttig voor onderzoekers en teams die volledige controle willen of aangepaste training/fine-tuning willen uitvoeren.

Hoe ziet een minimaal Python-voorbeeld eruit?

Hieronder staat een beknipt Python-fragment met Hugging Face diffusers dat tekst-naar-beeldgeneratie met Z-Image-Turbo demonstreert.

# minimal_zimage_turbo.pyimport torchfrom diffusers import ZImagePipelinedef generate(prompt, output_path="zimage_output.png", height=1024, width=1024, steps=9, guidance_scale=0.0, seed=42): # Use bfloat16 where supported for efficiency on modern GPUs pipe = ZImagePipeline.from_pretrained("Tongyi-MAI/Z-Image-Turbo", torch_dtype=torch.bfloat16) pipe.to("cuda") generator = torch.Generator("cuda").manual_seed(seed) image = pipe( prompt=prompt, height=height, width=width, num_inference_steps=steps, guidance_scale=guidance_scale, generator=generator, ).images[0] image.save(output_path) print(f"Saved: {output_path}")if __name__ == "__main__": generate("A cinematic portrait of a robot painter, studio lighting, ultra detailed")

Opmerkingen:guidance_scale standaardwaarden en aanbevolen instellingen verschillen voor Turbo-modellen; documentatie suggereert dat guidance laag of nul kan worden gezet voor Turbo, afhankelijk van het beoogde gedrag.

Hoe voer je image-to-image (edit) uit met Z-Image?

De ZImageImg2ImgPipeline ondersteunt beeldbewerking. Voorbeeld:

from diffusers import ZImageImg2ImgPipelinefrom diffusers.utils import load_imageimport torchpipe = ZImageImg2ImgPipeline.from_pretrained("Tongyi-MAI/Z-Image-Turbo", torch_dtype=torch.bfloat16)pipe.to("cuda")init_image = load_image("sketch.jpg").resize((1024, 1024))prompt = "Turn this sketch into a fantasy river valley with vibrant colors"result = pipe(prompt, image=init_image, strength=0.6, num_inference_steps=9, guidance_scale=0.0, generator=torch.Generator("cuda").manual_seed(123))result.images[0].save("zimage_img2img.png")

Dit weerspiegelt de officiële gebruikspatronen en is geschikt voor creatieve bewerking en inpainting-taken.

Hoe kun je prompts en guidance benaderen?

- Wees expliciet met structuur: Voor complexe scènes, structureer prompts om scènecompositie, hoofdobject, camera/lens, belichting, sfeer en eventuele tekstuele elementen op te nemen. Z-Image profiteert van gedetailleerde prompts en kan positionele/vertellende aanwijzingen goed aan.

- Stel

guidance_scalezorgvuldig af: Turbo-modellen kunnen lagere guidance-waarden aanbevelen; experimenteren is noodzakelijk. Voor veel Turbo-workflows levertguidance_scale=0.0–1.0met een seed en vaste stappen consistente resultaten op. - Gebruik image-to-image voor gecontroleerde bewerkingen: Wanneer je de compositie wilt behouden maar stijl/kleuring/objecten wilt wijzigen, begin dan met een init-afbeelding en gebruik

strengthom de mate van verandering te bepalen.

Gebruiksscenario’s en best practices

1. Snelle prototyping & storyboarding

Gebruiksscenario: Filmregisseurs en gamedesigners moeten scènes direct visualiseren.

Waarom Z-Image? Met generaties onder 3 seconden kunnen makers door honderden concepten itereren in één sessie, waarbij ze belichting en compositie in realtime verfijnen zonder minuten op een render te hoeven wachten.

2. E-commerce & reclame

Gebruiksscenario: Achtergronden of lifestyle-foto’s genereren voor merchandise.

Best practice: Gebruik Z-Image-Edit.

Upload een ruwe productfoto en gebruik een instructieprompt zoals “Plaats deze parfumfles op een houten tafel in een zonovergoten tuin.” Het model behoudt de integriteit van het product terwijl het een fotorealistische achtergrond hallucineert.

3. Tweetalige contentcreatie

Gebruiksscenario: Wereldwijde marketingcampagnes die assets voor zowel westerse als Aziatische markten vereisen.

Best practice: Maak gebruik van de tekstrendering.

- Prompt: “Een neonbord met de tekst ‘OPEN’ en ‘营业中’ dat gloeit in een donkere steeg.”

- Z-Image rendert correct zowel de Engelse als Chinese tekens, een prestatie die de meeste andere modellen niet halen.

4. Hulpbronnenarme omgevingen

Gebruiksscenario: AI-generatie uitvoeren op edge-devices of standaard kantoorlaptops.

Optimalisatietip: Gebruik de INT8-gekwantiseerde versie van Z-Image. Dit vermindert het VRAM-gebruik tot onder 6GB met verwaarloosbaar kwaliteitsverlies, waardoor het haalbaar wordt voor lokale apps op niet-gaminglaptops.

Conclusie: wie zou Z-Image moeten gebruiken?

Z-Image is ontworpen voor organisaties en ontwikkelaars die hoogwaardig fotorealisme willen met praktische latentie en kosten, en die de voorkeur geven aan open licenties en on-premises of aangepaste hosting. Het is bijzonder aantrekkelijk voor teams die snelle iteratie nodig hebben (creatieve tooling, productmockups, realtime services) en voor onderzoekers/communityleden die geïnteresseerd zijn in het fine-tunen van een compact maar krachtig beeldmodel.

CometAPI biedt vergelijkbaar minder beperkte Grok Image-modellen, evenals modellen zoals Nano Banana Pro, GPT- image 1.5, Sora 2(Kan Sora 2 NSFW-inhoud genereren? Hoe kunnen we het uitproberen?) enz.—mits je de juiste NSFW-tips en -trucs hebt om de beperkingen te omzeilen en vrij te beginnen met creëren. Zorg ervoor dat je bent ingelogd bij CometAPI en de API-sleutel hebt verkregen voordat je toegang krijgt. CometAPI biedt een prijs die veel lager ligt dan de officiële prijs om je te helpen integreren.

Klaar om te starten?→ Gratis proef voor creëren !