Kunstig intelligens (AI) har revolusjonert en rekke bransjer, og en av de mest fengslende applikasjonene er bildegenerering. Fra å skape realistiske menneskeansikter til å produsere surrealistiske kunstverk, har evnen til AI Image Generation åpnet nye veier innen kunst, design og teknologi. Denne artikkelen går nærmere inn på mekanismene bak AI-genererte bilder, modellene som driver dem, og de bredere implikasjonene av denne teknologien.

Forstå det grunnleggende: Hvordan fungerer AI-bildegenerering?

Hva er generative modeller?

Generative modeller er en klasse av AI-algoritmer som kan lage nye dataforekomster som ligner treningsdataene. I sammenheng med bildegenerering lærer disse modellene mønstre fra eksisterende bilder og bruker denne kunnskapen til å produsere nye, lignende bilder.

Nevrale nettverks rolle

I hjertet av AI-bildegenerering er nevrale nettverk, spesielt dyplæringsmodeller som Convolutional Neural Networks (CNN). CNN-er er designet for å behandle data med en rutenettlignende topologi, noe som gjør dem ideelle for bildeanalyse og generering. De fungerer ved å oppdage mønstre som kanter, teksturer og former, som er avgjørende for å forstå og gjenskape bilder.

Viktige AI-modeller i AI-bildegenerering

Generative Adversarial Networks (GAN)

GAN-er ble introdusert av Ian Goodfellow i 2014 og består av to nevrale nettverk: en generator og en diskriminator. Generatoren lager bilder, mens diskriminatoren vurderer dem opp mot ekte bilder. Gjennom denne motstandsprosessen forbedrer generatoren produksjonen for å produsere stadig mer realistiske bilder.

StyleGAN

StyleGAN er utviklet av NVIDIA, og er en GAN-variant kjent for å generere menneskeansikter av høy kvalitet. Den introduserer en stilbasert generatorarkitektur, som gir kontroll over ulike detaljnivåer i bildet. StyleGAN2 og StyleGAN3 forbedret bildekvaliteten ytterligere og løste problemer som teksturfeste.

Diffusjonsmodeller

Diffusjonsmodeller genererer bilder ved å starte med tilfeldig støy og gradvis avgrense den for å matche ønsket utgang. De har vunnet popularitet på grunn av deres evne til å produsere bilder av høy kvalitet og deres fleksibilitet i ulike applikasjoner.

Stabil diffusjon

Stable Diffusion er en åpen kildekode-diffusjonsmodell som muliggjør tekst-til-bilde generering. Den kan også utføre inpainting og outpainting, noe som gir mulighet for bilderedigering og utvidelse. Dens åpen kildekode har gjort den allment tilgjengelig for utviklere og artister.

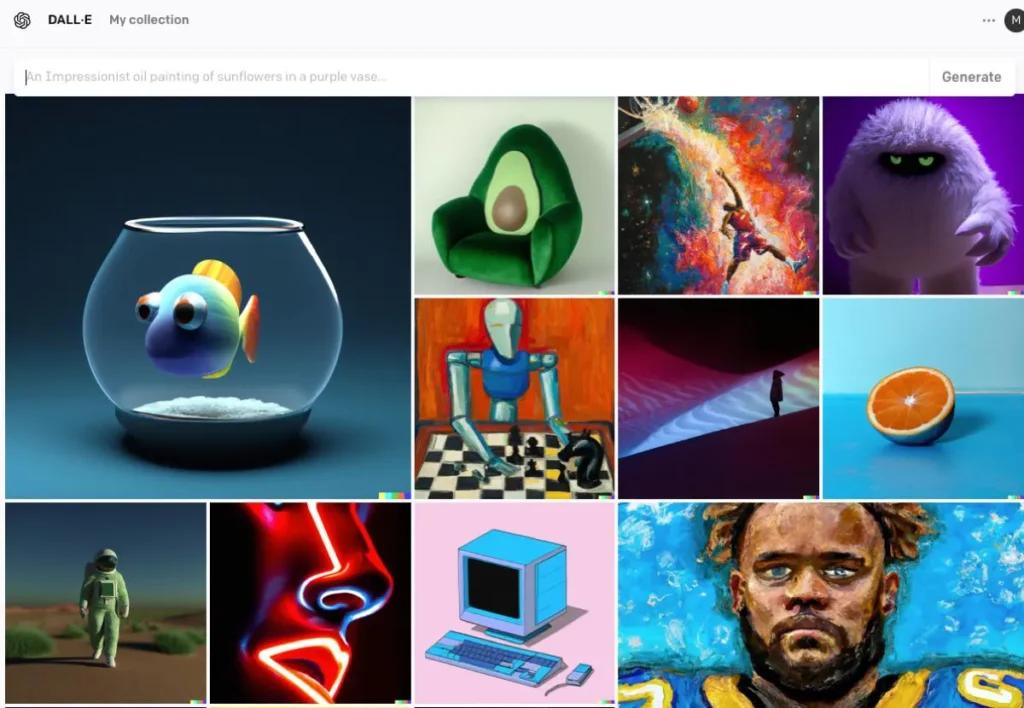

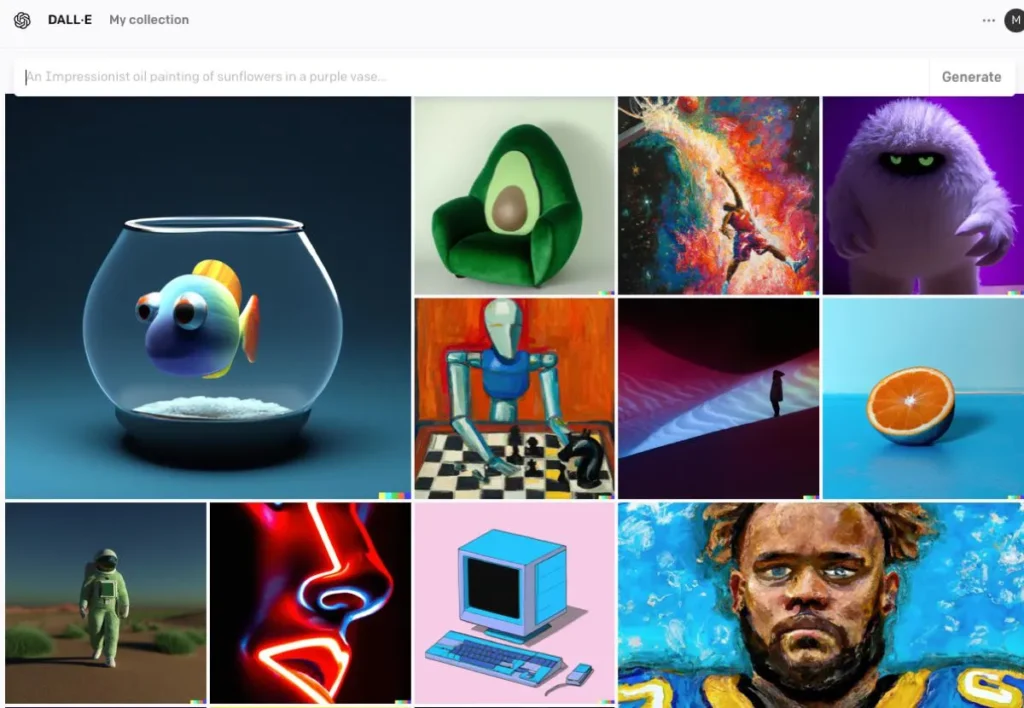

DALL · E

Utviklet av OpenAI, DALL·E er en transformatorbasert modell som er i stand til å generere bilder fra tekstbeskrivelser. DALL·E 2 og DALL·E 3 har forbedret originalen, og tilbyr høyere oppløsning og mer nøyaktig bilde-tekstjustering. DALL·E 3 er integrert i ChatGPT for forbedret brukerinteraksjon.

Prosessen med AI-bildegenerering

Trening av modellen

AI-modeller krever omfattende opplæring på store datasett med bilder. Under trening lærer modellen å gjenkjenne mønstre og funksjoner i bildene, slik at den kan generere nye bilder som etterligner treningsdataene.

Generering av nye bilder

Når modellen er trent, kan den generere nye bilder ved å:

- Motta inngang: Dette kan være tilfeldig støy (i GAN-er), en tekstmelding (i DALL·E) eller et eksisterende bilde (for redigering). Dette trinnet fanger opp den semantiske betydningen av teksten, slik at AI kan forstå innholdet og konteksten.

- Behandler input: Modellen behandler input gjennom sine nevrale nettverkslag, og bruker lærte mønstre og funksjoner. Ved å bruke den kodede teksten bruker AI modeller som Generative Adversarial Networks (GAN) eller diffusjonsmodeller for å lage bilder. Disse modellene genererer bilder ved å starte med tilfeldig støy og avgrense den for å matche tekstbeskrivelsen.

- Foredling og evaluering: Det genererte bildet foredles deretter ved hjelp av oppmerksomhetsmekanismer for å sikre sammenheng med teksten. En diskriminatormodell evaluerer bildets realisme og konsistens med input, og gir tilbakemelding for ytterligere foredling.

- Sender ut bilde: Den endelige utgangen er et nytt bilde som gjenspeiler egenskapene til treningsdataene og de spesifikke inndataene som er gitt.

Kodeeksempel på AI-bildegenerering

her er praktiske Python-kodeeksempler som viser hvordan du genererer bilder ved hjelp av tre fremtredende AI-modeller: Generative Adversarial Networks (GANs), Stable Diffusion og DALL·E.

Generative Adversarial Networks (GANs) med PyTorch

Generative Adversarial Networks (GAN) består av to nevrale nettverk – Generatoren og Diskriminatoren – som konkurrerer med hverandre om å generere nye, realistiske dataforekomster. Her er et forenklet eksempel ved å bruke PyTorch til å generere bilder:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Denne koden definerer et enkelt generatornettverk som tar en 100-dimensjonal støyvektor som input og produserer en 784-dimensjonal utgang, som kan omformes til et 28×28 bilde. De tanh aktiveringsfunksjonen sikrer at utgangsverdiene er i området , som er vanlig for bildedata.

Stabil diffusjon med klemende ansiktsspredere

Stable Diffusion er en kraftig tekst-til-bilde-modell som genererer bilder basert på tekstbeskrivelser. Det klemme ansiktet diffusers biblioteket gir et enkelt grensesnitt for å bruke denne modellen:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Dette skriptet laster den stabile diffusjonsmodellen og genererer et bilde basert på den oppgitte ledeteksten. Sørg for at du har de nødvendige avhengighetene installert og en kompatibel GPU for optimal ytelse

DALL·E med OpenAI API

DALL·E er en annen tekst-til-bilde-modell utviklet av OpenAI. Du kan samhandle med den ved å bruke OpenAIs API:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

Erstatt "your-api-key" med din faktiske OpenAI API-nøkkel. Dette skriptet sender en melding til DALL·E-modellen og henter det genererte bildet. Bildet lagres deretter lokalt

CometAPI integreres også DALL-E 3 API, kan du også bruke CometAPIs nøkkel for å få tilgang DALL-E 3 API, som er mer praktisk og raskere enn OpenAI.

For mer modellinformasjon i Comet API, se API-dok.

Disse eksemplene gir et utgangspunkt for å generere bilder ved hjelp av forskjellige AI-modeller. Hver modell har sine unike egenskaper og krav, så velg den som passer best til prosjektets behov.

Konklusjon

AI-bildegenerering står i skjæringspunktet mellom teknologi og kreativitet, og tilbyr enestående muligheter for å skape visuelt innhold. Å forstå hvordan AI genererer bilder, modellene som er involvert, og implikasjonene av denne teknologien er avgjørende når vi navigerer dens integrering i ulike aspekter av samfunnet.

Få tilgang til AI Image API i CometAPI

CometAPI gir tilgang til over 500 AI-modeller, inkludert åpen kildekode og spesialiserte multimodale modeller for chat, bilder, kode og mer. Dens primære styrke ligger i å forenkle den tradisjonelt komplekse prosessen med AI-integrasjon. Med den er tilgang til ledende AI-verktøy som Claude, OpenAI, Deepseek og Gemini tilgjengelig gjennom ett enkelt, enhetlig abonnement. Du kan bruke API i CometAPI til å lage musikk og kunstverk, generere videoer og bygge dine egne arbeidsflyter

CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere GPT-4o API ,Midjourney API Stable Diffusion API (Stabil Diffusion XL 1.0 API) og Flux API(FLUX.1 API etc) , og du vil få $1 på kontoen din etter registrering og innlogging!

CometAPI integrerer det siste GPT-4o-image API .