Lanseringen av GLM-5, avduket denne uken av Kinas Zhipu AI (markedsført offentlig som Z.AI / zai-org i mange utviklerkanaler), markerer nok et steg i den stadig raskere takten av lanseringer av store modeller. Den nye modellen posisjoneres som Zhipus flaggskip: større i skala, finjustert for agentiske oppgaver med langt tidsperspektiv, og bygget med ingeniørvalg som skal redusere inferenskostnad samtidig som lang kontekst bevares. Tidlige bransjerapporter og praktiske utviklernotater antyder merkbare gevinster i koding, flertrinns resonnement og agent-orkestrering sammenlignet med tidligere GLM-iterasjoner — og i noen tester utfordrer den til og med Claude 4.5.

Hva er GLM-5 og hvem har bygget den?

GLM-5 er den siste hovedutgivelsen i GLM-familien: en stor, åpen kildekode-basemodell utviklet og publisert av Z.ai (teamet bak GLM-serien). Lansert tidlig i februar 2026, presenteres GLM-5 som en neste-generasjons modell spesifikt finjustert for «agentiske» oppgaver — dvs. flertrinns arbeidsflyter med langt tidsperspektiv der en modell må planlegge, kalle verktøy, utføre og opprettholde kontekst for utvidede samtaler eller automatiserte agenter. Lanseringen er bemerkelsesverdig ikke bare for modellutformingen, men også for hvordan og hvor den ble trent: Z.ai brukte en miks av innenlandsk kinesisk maskinvare og verktøykjeder som del av en satsing på selvforsyning.

Rapporterte arkitektur- og treningsdata inkluderer:

- Parameter skalering: GLM-5 skalerer opp til omtrent 744B parametre (med et lavere «aktivt» ekspertantall nevnt i noen tekniske notater, f.eks. 40B aktive), sammenlignet med tidligere GLM-4-familie størrelser rundt 355B/32B aktive.

- Fortreningsdata: Treningskorpusstørrelsen skal ha økt fra ~23 trillion tokens (GLM-4-generasjonen) til ~28.5 trillion tokens for GLM-5.

- Sparsom oppmerksomhet / DeepSeek Sparse Attention (DSA): En sparsom oppmerksomhetsordning for å bevare lang kontekst samtidig som beregningskostnad under inferens reduseres.

- Designfokus: ingeniørvalg med vekt på agent-orkestrering, langkontekst-resonnering og kostnadseffektiv inferens.

Opprinnelse og posisjonering

GLM-5 bygger på en linje som inkluderte GLM-4.5 (lansert midt i 2025) og noen iterative oppdateringer som 4.7. Z.ai posisjonerer GLM-5 som et hopp fra «vibe coding» (raske enkeltstegs kodeutganger) mot «agentisk ingeniørkunst»: varig resonnement, orkestrering av flere verktøy og systemsyntese over lange kontekstvinduer. Offentlige materialer understreker at GLM-5 er designet for å håndtere komplekse systemingeniøroppgaver — å bygge, koordinere og opprettholde flertrinns agentatferd fremfor kun å svare på isolerte forespørsler.

Hva er de nye funksjonene i GLM-5?

Større arkitektoniske endringer

- Massiv sparsom skalering (MoE): GLM-5 går over til en mye større sparsom Mixture-of-Experts-arkitektur. Offentlige tall fra utviklersider og uavhengige omtaler oppgir modellen til omtrent 744B totale parametre med ~40B aktive per token — et betydelig steg opp fra GLM-4.5s ~355B / 32B aktiv per token-konfigurasjon. Denne sparsomme skaleringen lar modellen tilby svært stor total kapasitet samtidig som beregning per token holdes håndterbar.

- DeepSeek Sparse Attention (DSA): For å bevare langkontekst-evne uten lineær skalering av inferenskostnad integrerer GLM-5 en sparsom oppmerksomhetsmekanisme (merket som DeepSeek) som beholder viktige langtrekkende avhengigheter i skala samtidig som kostnaden ved oppmerksomhet over mega-lange kontekster trimmedes.

Agentisk ingeniørkunst som et grunnleggende designmål

En av GLM-5s overskriftsfunksjoner er at den eksplisitt er designet for agentisk ingeniørkunst — dvs. modellen er ment å brukes ikke bare til enkeltrunds chat eller oppsummering, men som «hjernen» i flertrinns agenter som kan planlegge, utstede verktøykall, håndtere tilstand og resonnere på tvers av lange kontekster. Z.ai posisjonerer GLM-5 til å fungere i orkestreringssløyfer: bryte ned komplekse problemer, kalle eksterne verktøy/API-er og spore lange oppgaver over mange omganger.

Hvorfor agentisk design er viktig

Agentiske arbeidsflyter er sentrale i reell automatisering: automatiserte forskningsassistenter, autonome programvareingeniører, driftsorkestrering og simuleringskontroll. En modell bygget for denne verden trenger sterk planlegging, stabil verktøykalling og robusthet over tusenvis av tokens med kontekst.

Forbedret koding, resonnement og «langtids»-atferd

GLM-5 vektlegger forbedret kodegenerering og resonnement. Z.ai hevder målrettede forbedringer i modellens evne til å skrive, refaktorere og feilsøke kode, samt mer konsistent flertrinns resonnement over lange interaksjoner. Uavhengige tidlig-tilgangsrapporter og partner-evalueringer fant modellen merkbart sterkere i utviklerorienterte oppgaver enn tidligere GLM-generasjoner.

Praktiske utviklerfunksjoner

- Større kontekstvinduer for å holde dokumentasjon, kodebaser og samtaletilstand.

- Verktøyprimitiver for sikker verktøykalling og håndtering av resultater.

- Bedre few-shot og chain-of-thought-ytelse for å dekomponere og utføre komplekse oppgaver.

- Agentiske funksjoner og verktøykalling: GLM-5 vektlegger innebytt støtte for agenter: funksjons-/verktøykall, tilstandsfulle sesjoner og bedre håndtering av lange dialoger og sekvenser av verktøybruk. Dette gjør det enklere å bygge agenter som integrerer nettsøk, databaser eller oppgaveautomatisering.

Hvordan presterer GLM-5 på benchmarks?

Konkrete høydepunkter fra benchmarks

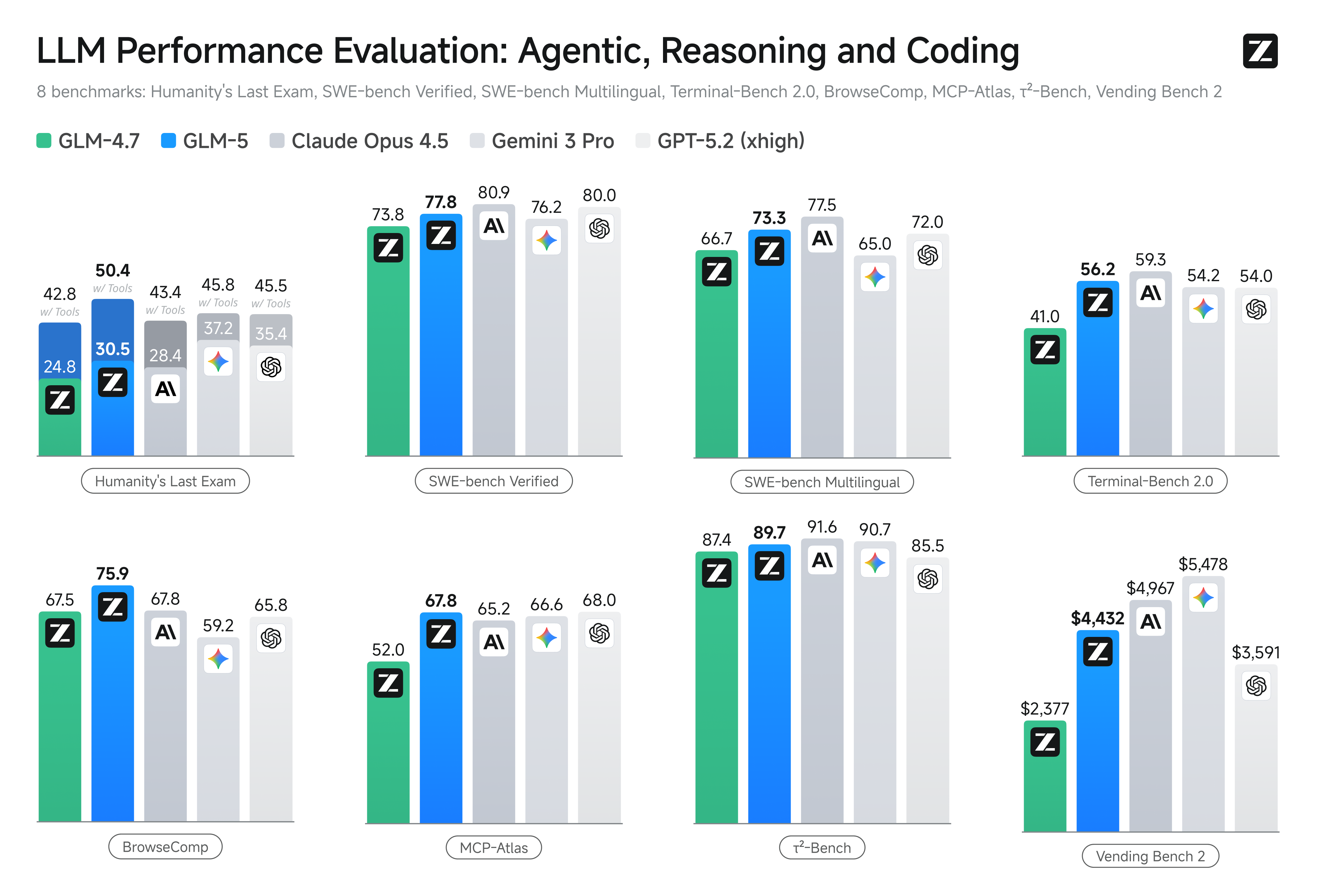

- Kodingsbenchmarks: GLM-5 nærmer seg (og i noen tilfeller matcher) kodeytelsen til høyt optimaliserte proprietære modeller som Claude Opus 4.5 fra Anthropic på spesifikke kodeoppgaver. Resultatene er oppgaveavhengige (enhetstester, algoritmisk koding, API-bruk), men markerer en tydelig forbedring over GLM-4.5.

- Resonnering og agentiske tester: På flertrinns resonnement og agentiske evalueringspakker (f.eks. fleromgangs planlegging, oppgavedekomponering) oppnådde GLM-5 best-i-klassen-resultater for åpne modeller og i noen metrikker overgikk den konkurrerende lukkede modeller på målrettede oppgaver.

Hvordan få tilgang til og prøve GLM-5?

GLM-5 er femte generasjons stor språkmodell fra Zhipu AI (Z.ai), bygget med en Mixture-of-Experts-arkitektur (~745 B total, ~44 B aktive) og rettet mot sterkt resonnement, koding og agentiske arbeidsflyter. Den ble offisielt lansert rundt 12. feb. 2026.

Per nå finnes det to hovedmåter å få tilgang:

A) Offisiell API-tilgang (Z.ai eller aggregatorer)

Zhipu AI tilbyr selv API-er for sine modeller, og du kan kalle GLM-5 gjennom disse API-ene.

Typiske steg:

- Registrer deg for en Z.ai/Open BigModel API-konto.

- Hent en API-nøkkel fra dashbordet.

- Bruk et OpenAPI-stil eller REST API-endepunkt med modellnavnet (f.eks.

glm-5).

(På samme måte som du ville kalle GPT-modeller fra OpenAI). - Sett opp prompts og send HTTP-forespørsler.

👉 Z.ais prisside viser offisielle GLM-5 token-priser som:

- ~$1.0 per million inngående tokens

- ~$3.2 per million utgående tokens

B) Tredjeparts API-wrappere ——CometAPI

API-er som CometAPI eller WaveSpeed pakker inn flere AI-modeller (OpenAI, Claude, Z.ai osv.) bak et enhetlig grensesnitt.

- Med tjenester som CometAPI kan du kalle GLM-modeller ved å bytte modell-ID.

(CometAPI støtter for øyeblikket GLM-5/GLM-4.7.) - CometAPIs glm-5 er priset til 20% av den offisielle prisen.

| Brukstype | Pris |

|---|---|

| Inngående tokens | ~$0.8 per 1M tokens |

| Utgående tokens | ~$2.56 per 1M tokens |

Hvorfor dette er viktig: Du beholder eksisterende OpenAI-kompatibel klientkode og endrer bare base-URL/modell-ID.

C) Selvhosting via Hugging Face / vekter

Det finnes uoffisielle GLM-5-vektsrepositorier (f.eks. versjoner kalt glm-5/glm-5-fp8) synlige i Hugging Face-modelloppføringer.

Med disse kan du:

- Laste ned modellvektene.

- Bruke verktøy som vLLM, SGLang, xLLM eller Transformers for å serve lokalt eller på din sky-GPU-flåte.

Fordeler: maksimal kontroll, ingen løpende API-kostnad.

Ulemper: enorm beregningskrav — sannsynligvis flere high-end GPU-er og minne (flere hundre GB), noe som gjør det upraktisk på små systemer.

Så — er GLM-5 verdt det, og bør du beholde GLM-4.7?

Kort svar (lederoppsummering)

- Hvis arbeidet ditt trenger robust, flertrinns agentisk atferd, produksjonsgrad kodegenerering eller systemnivå-automatisering: GLM-5 er verdt å evaluere umiddelbart. Arkitekturen, skalaen og finjusteringen prioriterer nettopp disse resultatene.

- Hvis du trenger kostnadseffektive, høy-gjennomstrømmingstjenester (kort chat, klassifisering, lette prompts): GLM-4.7 er trolig det mest økonomiske valget. GLM-4.7 bevarer et sterkt evnesett til betydelig lavere kostnad per token i mange leverandørlister og er allerede godt utprøvd.

Lengre svar (praktisk anbefaling)

Ta i bruk en nivådelt modellstrategi: bruk GLM-4.7 til daglige, høyt volum interaksjoner og reserver GLM-5 for høyt verdsatte ingeniørproblemer og agentisk orkestrering. Pilotér GLM-5 på en liten produktdel som øver lang kontekst, verktøyintegrasjon og kodekorrekthet; mål både spart ingeniørtid og inkrementell modellkostnad. Over tid vil du vite om GLM-5s kapasitetsløft rettferdiggjør bredere migrering.

Med CometAPI kan du bytte mellom GLM-4.7 og GLM-5 når som helst.

Virkelige brukstilfeller der GLM-5 utmerker seg

1. Kompleks agent-orkestrering

GLM-5s designfokus på flertrinns planlegging og verktøykalling gjør den godt egnet til systemer som må koordinere søk, API-kall og programutførelse (for eksempel: automatiserte forskningsassistenter, iterative kodegeneratorer eller flertrinns kundeserviceagenter som må konsultere databaser og eksterne API-er).

2. Langvarig ingeniørarbeid og resonnement over kodebaser

Når du trenger at modellen analyserer, refaktorerer eller syntetiserer på tvers av mange filer eller en stor kodebase, er GLM-5s utvidede kontekst og sparsomme oppmerksomhet direkte fordeler — færre feilmodi forårsaket av trunkert kontekst og bedre konsistens over lange spenn.

3. Kunnskapsintensiv syntese

Analytikere og produktteam som genererer komplekse rapporter — flerseksjons forskningsnotater, juridiske oppsummeringer eller regulatoriske innleveringer — kan dra nytte av modellens forbedringer i stabilt flertrinns resonnement og reduserte hallusinasjoner i leverandørrapporterte tester.

4. Agentisk automatisering for arbeidsflyter

Team som bygger automatisering som må orkestrere flere systemer (f.eks. planlegging + ticketing + utrullingspipeliner) kan bruke GLM-5 som sentral planlegger og eksekutør, støttet av verktøykall-rammeverk og sikkerhetsinnpakninger.

Konklusjon

GLM-5 er en viktig lansering i det raskt utviklende frontmodells-landskapet. Vekten på agentisk ingeniørkunst, forbedret koding og resonnement, og åpne vekter gjør den attraktiv for team som bygger verktøy-aktiverte AI-systemer med langt tidsperspektiv. Reelle gevinster i utvalgte oppgaver og oppmuntrende kostnad/ytelses-avveininger — men kjøpere bør evaluere GLM-5 mot sine spesifikke oppgaver og kjøre kontrollerte benchmarks før produksjonsinnføring.

Utviklere kan få tilgang til GLM-5 via CometAPI nå.For å begynne, utforsk modellens kapabiliteter i Playground og se API guide for detaljerte instruksjoner. Før du får tilgang, sørg for at du er logget inn på CometAPI og har hentet API-nøkkelen. CometAPI tilbyr en pris langt lavere enn den offisielle for å hjelpe deg å integrere.

Ready to Go?→ Registrer deg for glm-5 i dag !

Hvis du vil ha flere tips, guider og nyheter om AI, følg oss på VK, X og Discord!