DeepSeek har gitt ut en eksperimentell modell kalt DeepSeek-V3.2-Exp on September 29, 2025, og introduserer en ny sparse-attention-mekanisme (DeepSeek Sparse Attention, eller DSA) som sikter mot mye lavere slutningskostnader for arbeidsbelastninger med lang kontekst – og selskapet kuttet samtidig API-prisene med omtrent halvparten. Denne veiledningen forklarer hva modellen er, arkitektur-/funksjonshøydepunktene, hvordan du får tilgang til og bruker API-et (med kodeeksempler), hvordan det sammenlignes med tidligere DeepSeek-modeller, og hvordan du analyserer og håndterer svarene i produksjon.

Hva er DeepSeek-V3.2-Exp?

DeepSeek-V3.2-Exp er en eksperimentell iterasjon i DeepSeeks V3-spor. Utgivelsen – annonsert sent i september 2025 – er posisjonert som et «mellomtrinn» som validerer arkitektoniske optimaliseringer for utvidede kontekstlengder, snarere enn som et stort sprang i rå nøyaktighet. Hovedinnovasjonen er DeepSeek Sparse Attention (DSA), et oppmerksomhetsmønster som selektivt fokuserer på deler av en lang input for å redusere beregnings- og minnekostnader, samtidig som det tar sikte på å holde utdatakvaliteten sammenlignbar med V3.1-Terminus.

Hvorfor det er viktig i praksis:

- Kostnad for oppgaver med lang kontekst: DSA retter seg mot den kvadratiske oppmerksomhetskostnaden, og reduserer beregningsbehovet for svært lange inndata (tenk på henting av flere dokumenter, lange transkripsjoner, store spillverdener). API-brukskostnadene er vesentlig lavere for typiske brukstilfeller med lang kontekst.

- Kompatibilitet og tilgjengelighet: DeepSeek API bruker et OpenAI-kompatibelt forespørselsformat, slik at mange eksisterende OpenAI SDK-arbeidsflyter kan tilpasses raskt.

Hva er hovedfunksjonene og arkitekturen til DeepSeek V3.2-Exp?

Hva er DeepSeek Sparse Attention (DSA), og hvordan fungerer det?

DSA er en finkornet sparsom oppmerksomhet et opplegg designet for å delta selektivt over tokens i stedet for å beregne tett oppmerksomhet på tvers av hele konteksten. Kort sagt:

- Modellen velger dynamisk delsett av tokens som skal ivaretas på hvert lag eller blokk, noe som reduserer FLOP-er for lange inngangslengder.

- Utvalget er utformet for å bevare den «viktige» konteksten for resonneringsoppgaver, ved å utnytte en kombinasjon av lærte utvalgspolicyer og rutingsheuristikker.

DSA som kjerneinnovasjonen i V3.2-Exp, ment å holde utdatakvaliteten nær tette oppmerksomhetsmodeller samtidig som inferenskostnader reduseres, spesielt når kontekstlengdene øker. Utgivelsesnotatene og modellsiden understreker at treningskonfigurasjonene ble justert med V3.1-Terminus, slik at forskjeller i referansemålinger gjenspeiler den sparsomme oppmerksomhetsmekanismen snarere enn en fullstendig endring i trening.

Hvilke andre arkitekturer/funksjoner følger med V3.2-Exp?

- Hybridmoduser (tenkning vs. ikke-tenkning): DeepSeek eksponerer to modell-ID-er:

deepseek-chat(ikke-tenkende / raskere svar) ogdeepseek-reasoner(tenkemodus som kan eksponere innhold fra tankekjeden eller mellomliggende resonnement). Disse modusene lar utviklere velge hastighet kontra eksplisitt resonnementtransparens. - Svært store kontekstvinduer: V3.x-familien støtter svært store kontekster (V3-linjen gir DeepSeek 128K kontekstalternativer i nåværende oppdateringer), noe som gjør den egnet for arbeidsflyter med flere dokumenter, lange logger og kunnskapstunge agenter.

- JSON-utdata og kall av strenge funksjoner (Beta): API-et støtter en

response_formatobjekt som kan tvinge frem JSON-utdata (og en streng betaversjon for funksjonskall). Dette hjelper når du trenger forutsigbare maskinparsbare utdata for verktøyintegrasjon. - Strømming og resonnementstokener: API-et støtter strømmeresponser og – for resonneringsmodeller – distinkte tokener for resonneringsinnhold (ofte eksponert under

reasoning_content), som lar deg vise eller revidere modellens mellomtrinn.

Hvordan får jeg tilgang til og bruker DeepSeek-V3.2-Exp API via CometAPI?

DeepSeek beholder bevisst et OpenAI-lignende API-format – slik at eksisterende OpenAI SDK-er eller kompatible verktøy kan målrettes på nytt med en annen basis-URL. Jeg anbefaler å bruke CometAPI for å få tilgang til DeepSeek-V3.2-Exp fordi det er rimelig og en multimodal aggregeringsgateway. DeepSeek eksponerer modellnavn som er kartlagt til V3.2-Exp-oppførselen. Eksempler:

DeepSeek-V3.2-Exp-thinking — resonnerings-/tenkemodus tilordnet V3.2-Exp.

DeepSeek-V3.2-Exp-thinking — ikke-resonnerings-/chattemodus tilordnet V3.2-Exp.

Hvordan autentiserer jeg, og hva er basis-URL-en?

- Få en API-nøkkel fra CometAPI-utviklerkonsollen (søk på nettstedet deres).

- Grunnadresse: (

https://api.cometapi.comorhttps://api.cometapi.com/v1for OpenAI-kompatible stier). OpenAI-kompatibiliteten betyr at mange OpenAI SDK-er kan pekes på nytt til DeepSeek med små endringer.

Hvilke modell-ID-er bør jeg bruke?

DeepSeek-V3.2-Exp-thinking— tenkemodus, eksponerer innhold i tankekjeden/resonnementet. Begge ble oppgradert til V3.2-Exp i de siste utgivelsesnotatene.DeepSeek-V3.2-Exp-nothinking— ikke-tenking, raskere svar, typisk bruk av chat/fullføring.

Eksempel: enkel curl-forespørsel (chat-fullføring)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Eksempel: Python (OpenAI-kompatibelt klientmønster)

Dette mønsteret fungerer etter å ha pekt en OpenAI-klient til CometAPI-basis-URL-en (eller ved bruk av CometAPIs SDK). Eksemplet nedenfor følger DeepSeeks dokumentasjonsstil:

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Ingen spesiell SDK er nødvendig – men hvis du allerede bruker OpenAIs SDK, kan du ofte konfigurere den på nytt. base_url og api_key og behold de samme samtalemønstrene.

Avansert bruk: muliggjør resonnering eller reasoning_content

Hvis du trenger modellens interne tankekjede (for revisjon, destillasjon eller uttrekking av mellomtrinn), bytt til DeepSeek-V3.2-Exp-thinking. De reasoning_content feltet (og relatert strøm eller tokener) er tilgjengelig i svaret for resonneringsmodus; API-dokumentasjonen gir reasoning_content som et svarfelt for å inspisere CoT-en som genereres før det endelige svaret. Merk: eksponering av disse tokenene kan påvirke faktureringen, ettersom de er en del av modellutdataene.

Strømming og delvise oppdateringer

- Bruk

"stream": truei forespørsler om å motta token-deltaer via SSE (server-sendte hendelser). stream_optionsoginclude_usagelar deg justere hvordan og når bruksmetadata vises under en strømming (nyttig for trinnvise brukergrensesnitt).

Hvordan er DeepSeek-V3.2-Exp sammenlignet med tidligere DeepSeek-modeller?

V3.2-Exp vs. V3.1-Terminus

- Primær forskjell: V3.2-Exp introduserer sparse attention-mekanismen for å redusere beregningsbehovet for lange kontekster, samtidig som resten av treningsoppskriften holdes på linje med V3.1. Dette tillot DeepSeek å gjøre en renere sammenligning av effektivitetsgevinster. ()

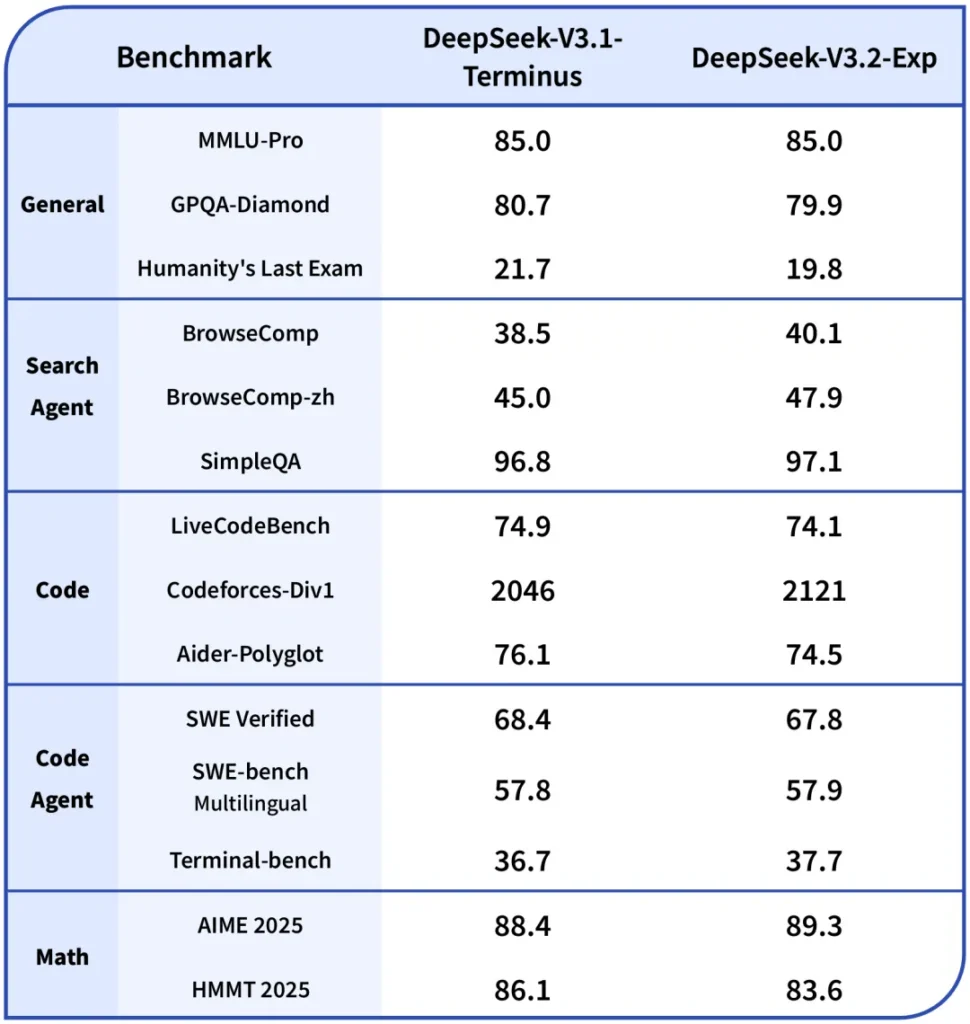

- benchmarks: Offentlige notater indikerer at V3.2-Exp yter omtrent på nivå med V3.1 på mange resonnerings-/kodingsoppgaver, samtidig som den er betydelig billigere på lange kontekster. Merk at spesifikke oppgaver fortsatt kan ha mindre regresjoner avhengig av hvordan oppmerksomhetssparsitet samhandler med de nødvendige token-interaksjonene.

V3.2-Exp vs R1 / Eldre utgivelser

- R1- og V3-linjene følger forskjellige designmål (R1 fokuserte historisk sett på forskjellige arkitektoniske avveininger og multimodale kapasiteter i noen grener). V3.2-Exp er en forbedring i V3-familien med fokus på lange kontekster og gjennomstrømning. Hvis arbeidsmengden din er tung på rå nøyaktighetsbenchmarks for én tur, kan forskjellene være beskjedne. Hvis du opererer på pipelines med flere dokumenter, er kostnadsprofilen til V3.2-Exp sannsynligvis mer attraktiv.

Hvor får man tilgang til Claude Sonnet 4.5

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering, forenkler CometAPI dramatisk integreringen av AI-funksjoner i applikasjonene dine. Enten du bygger chatboter, bildegeneratorer, musikkomponister eller datadrevne analysepipeliner, lar CometAPI deg iterere raskere, kontrollere kostnader og forbli leverandøruavhengig – alt samtidig som du utnytter de nyeste gjennombruddene på tvers av AI-økosystemet.

Utviklere har tilgang DeepSeek V3.2 Exp gjennom Comet API, den nyeste modellversjonen er alltid oppdatert med den offisielle nettsiden. For å begynne, utforsk modellens muligheter i lekeplass og konsulter API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Klar til å dra? → Registrer deg for CometAPI i dag !

Konklusjon

DeepSeek-V3.2-Exp er en pragmatisk eksperimentell utgivelse som har som mål å gjøre arbeid i lang kontekst billigere og mer gjennomførbart, samtidig som den bevarer utdatakvaliteten i V3-klassen. For team som jobber med lange dokumenter, transkripsjoner eller resonnement på flere dokumenter, er det verdt å teste det ut: API-et følger et OpenAI-lignende grensesnitt som gjør integreringen enkel, og det fremhever både DSA-mekanismen og meningsfulle prisreduksjoner som endrer den økonomiske kalkulusen ved bygging i stor skala. Som med enhver eksperimentell modell er omfattende evaluering, instrumentering og trinnvis utrulling avgjørende.