GLM-4.5-serien, utviklet av Zhipu AI (Z.ai), representerer et betydelig fremskritt innen åpen kildekode for store språkmodeller (LLM-er). GLM-4.5 er designet for å forene resonnement, koding og agentiske funksjoner, og tilbyr robust ytelse på tvers av ulike applikasjoner. Enten du er en utvikler, forsker eller entusiast, gir denne veiledningen detaljert informasjon om hvordan du får tilgang til og bruker GLM-4.5-serien effektivt.

Hva er GLM-4.5-serien, og hvorfor er den viktig?

GLM-4.5 er en hybrid resonneringsmodell som kombinerer to distinkte moduser: en «tenkemodus» for kompleks resonnering og verktøybruk, og en «ikke-tenkemodus» for umiddelbare responser. Denne tomodustilnærmingen lar modellen håndtere et bredt spekter av oppgaver effektivt. Serien inkluderer to hovedvarianter:

- GLM-4.5Med totalt 355 milliarder parametere med 32 milliarder aktive parametere er denne modellen designet for storskala distribusjon på tvers av resonnement, generering og oppgaver med flere agenter.

- GLM-4.5-AirEn lettvektsversjon med 106 milliarder parametere totalt og 12 milliarder aktive parametere, optimalisert for inferens på enheten og i mindre skala i skyen uten å ofre kjernefunksjoner.

Begge modellene støtter hybride resonneringsmoduser, og tilbyr «tenknings»- og «ikke-tenknings»-moduser for å balansere komplekse resonneringsoppgaver og raske responser. De er åpen kildekode og utgitt under MIT-lisensen, noe som gjør dem tilgjengelige for kommersiell bruk og sekundærutvikling.

Arkitektur og designprinsipper

I kjernen utnytter GLM-4.5 MoE til å dynamisk rute tokens gjennom spesialiserte ekspert-undernettverk, noe som muliggjør overlegen parametereffektivitet og skaleringsatferd (). Denne tilnærmingen betyr at færre parametere må aktiveres per videresending, noe som reduserer driftskostnadene samtidig som man opprettholder toppmoderne ytelse på resonnement- og kodeoppgaver ().

Nøkkelegenskaper

- Hybrid resonnering og kodingGLM-4.5 demonstrerer SOTA-ytelse på både benchmarks for forståelse av naturlig språk og kodegenereringstester, og konkurrerer ofte med proprietære modeller i nøyaktighet og flyt.

- AgentintegrasjonInnebygde verktøykallgrensesnitt lar GLM-4.5 orkestrere flertrinns arbeidsflyter – som databasespørringer, API-orkestrering og interaktiv frontend-generering – i én enkelt økt.

- Multimodale artefakterFra HTML/CSS-miniapper til Python-baserte simuleringer og interaktive SVG-er, kan GLM-4.5 produsere fullt funksjonelle artefakter, noe som forbedrer brukerengasjement og utviklerproduktivitet.

Hvorfor er GLM-4.5 banebrytende?

GLM-4.5 har blitt hyllet ikke bare for sin rå ytelse, men også for å omdefinere verdien av åpen kildekode-LLM-er i bedrifts- og forskningsmiljøer.

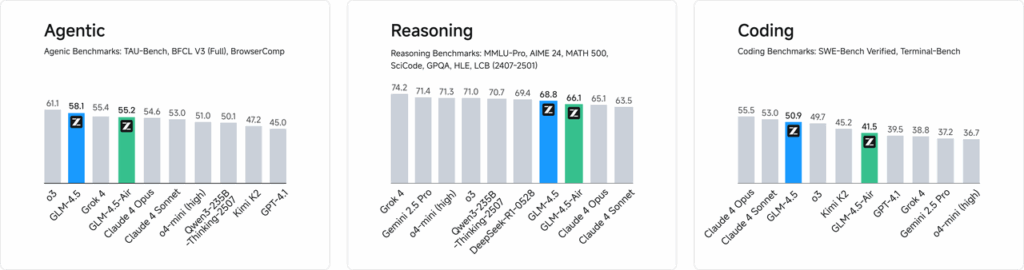

Performance Benchmarks

I uavhengige evalueringer på tvers av 52 programmeringsoppgaver – som spenner over webutvikling, dataanalyse og automatisering – overgikk GLM-4.5 konsekvent andre ledende modeller med åpen kildekode når det gjelder pålitelighet av verktøykalling og generell oppgavefullføring. I sammenlignende tester mot Claude Code, Kimi-K2 og Qwen3-Coder oppnådde GLM-4.5 de beste poengsummene i klassen på benchmarks som «SWE-bench Verified»-ledertavlen.

Kostnadseffektivitet

Utover nøyaktighet, reduserer GLM-4.5s MoE-design inferenskostnadene dramatisk. Offentlig prising for API-kall starter så lavt som RMB 0.8 per million input-tokener og RMB 2 per million output-tokener – omtrent en tredjedel av kostnaden for sammenlignbare proprietære tilbud. Kombinert med toppgenereringshastigheter på 100 tokener/sek, støtter modellen distribusjoner med høy gjennomstrømning og lav latens uten uoverkommelige kostnader.

Hvordan får du tilgang til GLM-4.5?

1. Direkte tilgang via Z.ai-plattformen

Den enkleste måten å samhandle med GLM-4.5 på er gjennom Z.ai-plattformen. Ved å besøke chat.z.ai, kan brukere velge GLM-4.5-modellen og begynne å samhandle via et brukervennlig grensesnitt. Denne plattformen muliggjør umiddelbar testing og prototyping uten behov for komplekse integrasjoner. Brukere kan velge enten GLM-4.5- eller GLM-4.5-Air-modellen fra øverste venstre hjørne og begynne å chatte umiddelbart. Dette grensesnittet er brukervennlig og krever ingen oppsett, noe som gjør det ideelt for raske samhandlinger og demonstrasjoner.

2. API-tilgang for utviklere

For utviklere som ønsker å integrere GLM-4.5 i applikasjoner, tilbyr Z.ai API-plattformen omfattende støtte. API-et tilbyr OpenAI-kompatible grensesnitt for både GLM-4.5- og GLM-4.5-Air-modeller, noe som muliggjør sømløs integrering i eksisterende arbeidsflyter. Detaljert dokumentasjon og integrasjonsretningslinjer er tilgjengelig på Z.ai API-dokumentasjon .

3. Implementering med åpen kildekode

For de som er interessert i lokal distribusjon, er GLM-4.5-modeller tilgjengelige på plattformer som Hugging Face og ModelScope. Disse modellene er utgitt under MITs åpen kildekode-lisens, noe som tillater kommersiell bruk og sekundærutvikling. De kan integreres med vanlige inferensrammeverk som vLLM og SGLang.

4. Integrasjon med CometAPI

CometAPI tilbyr strømlinjeformet tilgang til GLM-4.5-modeller gjennom deres enhetlige API-plattform på DasboradDenne integrasjonen forenkler autentisering, hastighetsbegrensning og feilhåndtering, noe som gjør den til et utmerket valg for utviklere som ønsker et problemfritt oppsett. I tillegg muliggjør CometAPIs standardiserte API-format enkel modellbytte og A/B-testing mellom GLM-4.5 og andre tilgjengelige modeller.

Hvordan kan utviklere få tilgang til GLM-4.5-serien?

Det finnes flere kanaler for å skaffe og distribuere GLM-4.5, fra direkte modellnedlastinger til administrerte API-er.

Via Hugging Face og ModelScope

Både Hugging Face og ModelScope er vert for hele GLM-4.5-serien under navneområdet zai-org. Etter å ha godta MIT-lisensen, kan utviklere:

- Klon depotet:

git clone https://huggingface.co/zai-org/GLM-4.5

- Installer avhengigheter:

pip install transformers accelerate

- Last inn modellen:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Gjennom Comet API

CometAPI tilbyr et serverløst API for GLM‑4.5 og GLM-4.5 Air API Med betaling per token-priser, tilgjengelig via, ved å konfigurere OpenAI-kompatible endepunkter, kan du kalle GLM-4.5 gjennom OpenAIs Python-klient med minimale justeringer av eksisterende kodebaser. CometAPI tilbyr ikke bare GLM4.5 og GLM-4.5-air, men også alle offisielle modeller:

| Modellnavn | introdusere | Pris |

glm-4.5 | Vår kraftigste resonneringsmodell, med 355 milliarder parametere | Inndatatokener $0.48 Utdatatokens $1.92 |

glm-4.5-air | Kostnadseffektiv Lettvekt Sterk Ytelse | Inndatatokener $0.16 Utdatatokens $1.07 |

glm-4.5-x | Høy ytelse, sterk resonnering, ultrarask respons | Inndatatokener $1.60 Utdatatokens $6.40 |

glm-4.5-airx | Lettvekt Sterk ytelse Ultrarask respons | Inndatatokener $0.02 Utdatatokens $0.06 |

glm-4.5-flash | Sterk ytelse Utmerket for resonnering, koding og agenter | Inndatatokener $3.20 Utdatatokens $12.80 |

Python og REST API-integrasjon

For skreddersydde implementeringer kan organisasjoner være vert for GLM-4.5 på dedikerte GPU-klynger ved hjelp av Docker eller Kubernetes. Et typisk RESTful-oppsett involverer:

Starter inferensserver:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Sender forespørsler:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Hva er beste praksis for å integrere GLM-4.5 i applikasjoner?

For å maksimere avkastningen og sikre robust ytelse, bør team vurdere følgende:

API-optimalisering og hastighetsgrenser

- GruppeforespørslerGrupper lignende ledetekster for å redusere overhead og utnytte GPU-gjennomstrømning.

- Bufring av vanlige spørringerLagre hyppige fullføringer lokalt for å unngå overflødige slutningskall.

- Adaptiv prøvetakingDynamisk justering

temperatureogtop_pbasert på spørringskompleksitet for å balansere kreativitet og determinisme.

Sikkerhet og samsvar

- DatarensingForhåndsbehandle inndata for å fjerne sensitiv informasjon før sending til modellen.

- Access ControlImplementer API-nøkler, IP-tillatelseslister og hastighetsbegrensning for å forhindre misbruk og urettferdig bruk.

- RevisjonsloggingRegistrer forespørsler, fullføringer og metadata for samsvar med bedrifts- og regulatoriske krav, spesielt i finans- eller helsesammenhenger.

Komme i gang

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering, forenkler CometAPI dramatisk integreringen av AI-funksjoner i applikasjonene dine. Enten du bygger chatboter, bildegeneratorer, musikkomponister eller datadrevne analysepipeliner, lar CometAPI deg iterere raskere, kontrollere kostnader og forbli leverandøruavhengig – alt samtidig som du utnytter de nyeste gjennombruddene på tvers av AI-økosystemet.

For utviklere som ønsker å integrere GLM-4.5 i applikasjonene sine, tilbyr CometAPI-plattformen en robust løsning. API-et tilbyr OpenAI-kompatible grensesnitt, noe som muliggjør sømløs integrering i eksisterende arbeidsflyter. Detaljert dokumentasjon og bruksretningslinjer er tilgjengelig på Comet API-side.

Utviklere har tilgang GLM‑4.5 og GLM-4.5 Air API gjennom CometAPI, de nyeste modellversjonene som er oppført er per artikkelens publiseringsdato. For å begynne, utforsk modellens muligheter i lekeplass og konsulter API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Konklusjon

GLM-4.5 representerer et betydelig fremskritt innen store språkmodeller, og tilbyr en allsidig løsning for et bredt spekter av applikasjoner. Den hybride resonneringsarkitekturen, agentfunksjonene og åpen kildekode-naturen gjør det til et attraktivt alternativ for utviklere og organisasjoner som ønsker å utnytte avanserte AI-teknologier. Ved å utforske de ulike tilgangsmetodene som er skissert i denne veiledningen, kan brukere effektivt integrere GLM-4.5 i prosjektene sine og bidra til den kontinuerlige utviklingen.