OpenAI annonserte nylig flere oppdateringer, inkludert utgivelsen av GPT-5-Codex-Mini-modellen, forbedringer av hastighetsgrensen for flerbrukerhierarkier og optimaliseringer for effektiv modellbehandling.

OpenAI GPT-5-Codex-Mini er en nylig annonsert, utviklerfokusert variant av GPT-5-Codex: en mindre, kostnads- og gjennomstrømningsoptimalisert modell som er ment å levere mesteparten av kodehjelpen til GPT-5-Codex, men til mye lavere kostnad og høyere brukbart volum. «Mini»-varianten er posisjonert som et pragmatisk valg for lange kodeøkter, bakgrunnsautomatisering og høyfrekvente utviklerarbeidsflyter der rå toppkapasitet er mindre viktig enn å få flere tokens/forespørsler for samme plan.

Hva er GPT-5-Codex-Mini og hva er dens funksjoner?

GPT-5-Codex-Mini er en kompakt og kostnadseffektiv variant av OpenAIs GPT-5-Codex-familie, spesielt pakket for Codex-produktflater (CLI- og IDE-integrasjon). Den er posisjonert som en «mindre og mer kostnadseffektiv» modell som bytter en liten mengde toppkapasitet mot vesentlig lavere ressursforbruk og en høyere brukbar kvote for interaktive utviklerarbeidsflyter. Minimodellen er ment å la utviklere kjøre mange flere kodeomganger (OpenAI beskriver omtrent ... 4 ganger mer bruk for samme ChatGPT-abonnementsnivå) samtidig som ventetid og kostnader holdes nede for vanlige, veldefinerte ingeniøroppgaver.

Når det gjelder funksjoner, arver GPT-5-Codex-Mini kjernefunksjonene i Codex-produktlinjen: en dyp forståelse av kodebasen og utførelse av flertrinnsoppgaver på en "agent"-måte. Basert på Codex CLI-funksjonene kan utviklere sende inn kommandoer i naturlig språk, kodestykker, skjermbilder eller grensesnittdesigndiagrammer til Codex i en interaktiv terminal. Modellen vil først gi en plan, og deretter automatisk bla gjennom filer, redigere kode, kjøre kommandoer og teste etter å ha fått brukergodkjenning.

Fra et modalt perspektiv tillater Codex-produkter å legge ved bilder (som UI-skjermbilder, designutkast eller skjermbilder av feilmeldinger) til økten i terminalen eller IDE-en. Modellen kan forstå både tekst- og bildeinnhold, men utdataene er fortsatt hovedsakelig tekstkode og forklaringer. Derfor kan GPT-5-Codex-Mini betraktes som en kodeproxymodell som hovedsakelig er "tekst + bildeinndata, tekstutdata", og som ikke utfører oppgaver som bildegenerering, lydgenerering eller videogenerering.

Hvordan er GPT-5-Codex-Mini sammenlignet med GPT-5-Codex?

Hva er nytt i Codex?

I tillegg til GPT-5-Codex-Mini som er realisert, har OpenAI økt Codex-hastighetsgrensen med 50 % for ChatGPT Plus-, Business- og Edu-brukernivåer, noe som øker grensen for tilgjengelige forespørsler betydelig. I mellomtiden vil ChatGPT Pro-brukere få prioriterte behandlingstillatelser for å forbedre responshastigheten og oppgaveutførelsesopplevelsen.

Videre har OpenAI gjort en mindre oppgradering av GPT-5-Codex-modellen, som optimaliserer ytelsen i samarbeidsscenarier. Den oppdaterte modellen viser forbedringer på flere prosentpoeng på viktige evalueringsmålinger, en økning på omtrent 3 % i effektiviteten av tokenbruk og større robusthet i håndtering av kanttilfeller, og reduserer dermed behovet for brukerveiledning.

| brukernivå | GPT-5-kodeks | GPT-5-Codex-Mini |

|---|---|---|

| Pluss/Biz/Edu | øker meldingsvolumet med henholdsvis 1.5 ganger. | øker meldingsvolumet med henholdsvis 6 ganger. |

GPT-5-Codex-Mini vs. GPT-5-Codex: Forskjeller i referansepunkter

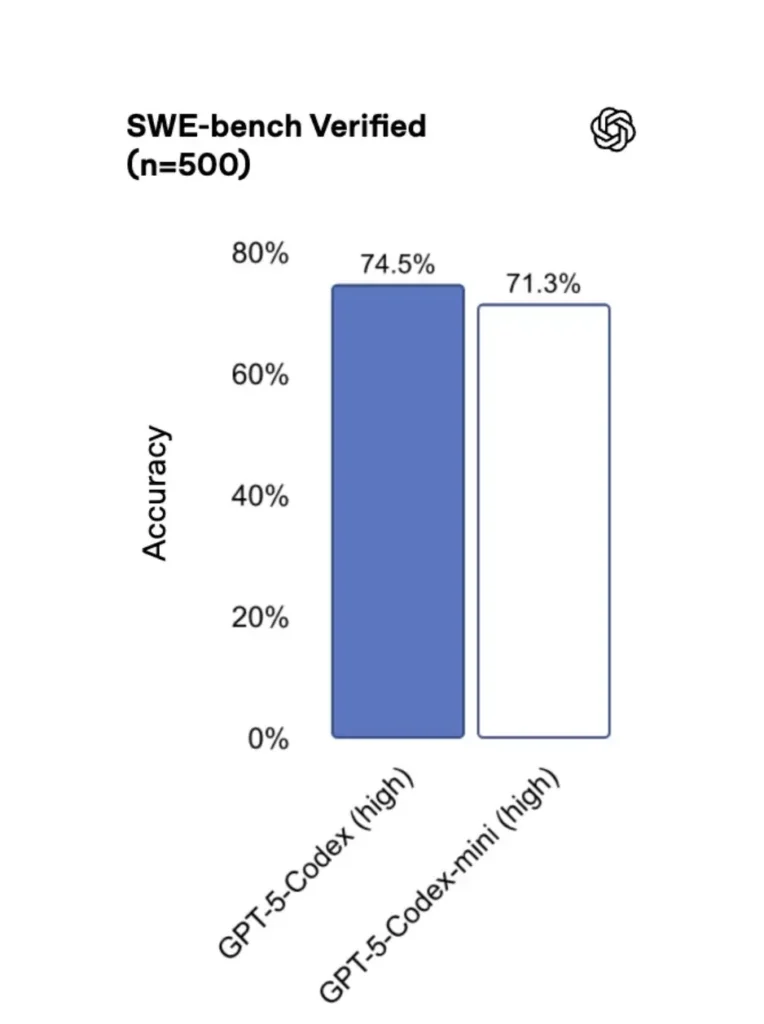

GPT-5-Codex-Mini er noe redusert sammenlignet med originalversjonen, men utviklere får omtrent fire ganger mer brukspoeng. I SWE-bench Verified-testen fikk GPT-5 High en score på 72.8 %, GPT-5-Codex 74.5 % og GPT-5-Codex-Mini 71.3 %.

Codex (og minivarianten) bruker dramatisk færre tokens for lette interaksjoner – OpenAIs materialer hevder reduksjoner i størrelsesorden titalls prosentpoeng for enkle ledetekster (f.eks. et sitert tall på ≈93.7 % færre tokens på lette interaksjoner for Codex-familien vs. GPT-5 i noen scenarier).

GPT-5-Codex-Mini vs. GPT-5-Codex: funksjonsforskjeller

- Størrelse og kostnad: Mini er eksplisitt mindre og mer kostnadseffektivt; OpenAI anslår at det muliggjør omtrent 4 ganger mer bruk under de samme abonnementsbegrensningene. Dette er en kvote-/effektivitetsoptimalisering for rutinemessige utvikleroppgaver.

- Kapasitetsramme: GPT-5-Codex er fortsatt det mest funksjonelle alternativet for lange, komplekse agentoppgaver (store refaktoreringer, dype kodegjennomganger, utvidede testsykluser). Mini er innstilt for å være raskere og mindre ressurskrevende for hyppige korte interaksjoner.

- Latens- og hastighetsgrenser: Mini leverer vanligvis lavere latens og tillater høyere hastighetsgrenser per plan – noe som gjør den egnet for tette, interaktive arbeidsflyter.

- Standardoverflater: Mini er tilgjengelig som en valgbar modell i Codex CLI og IDE-utvidelsen; GPT-5-Codex er standard for skyoppgaver og dype kodegjennomgangsflyter i Codex.

Når skal man bruke Mini vs. Full Codex

- Bruk Mini for: stillasarbeid, repeterende kodegenerering, små refaktoreringer, interaktive fullføringer under redigering og når man arbeider under en kvote eller kostnadsbegrensning.

- Bruk GPT-5-kodeks for: omfattende kodegjennomganger, autonome oppgaver over flere timer, komplekse refaktoreringer og oppgaver som krever modellens sterkeste resonnement og testdrevne utførelse.

Hvordan får jeg tilgang til GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (terminal først)

OpenAI introdusert gpt-5-codex-mini som et modellalternativ i Codex CLI. Typiske bruksmønstre følger Codex CLI-arbeidsflyten: start en interaktiv økt, spesifiser modellen, legg ved filer eller skjermbilder, kjør «Codex Cloud-oppgaver» og mer. CLI støtter også rask /model bytte mellom full gpt-5-codex og gpt-5-codex-miniVed første kjøring må du autentisere deg med ChatGPT/Pro/Enterprise-kontoen din (eller oppgi en API-nøkkel). CLI-en tilbyr diverse kommandoer som lar Codex skanne kodebaser, kjøre tester, åpne REPL-er eller bruke patch-anbefalinger.

Eksempel (interaktiv Codex CLI-økt):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Den flyten gjenspeiler de nye Codex CLI-standardene der verktøyet vil foreslå Mini som nærmer seg bruksgrensene.

VS-kode / IDE-utvidelse

Ja – Codex IDE-utvidelsen (VS Code) inkluderer allerede gpt-5-codex-mini som et alternativ. Installer Codex-utvidelsen i Visual Studio Code for å få innebygd kodefullføring, forslag til refaktorering og AI-drevne hurtigreparasjoner. Utvidelsen eksponerer også hurtighandlinger (generer kode, forklar valgt kode, refaktorer) og kan kjøre Codex Cloud-oppgaver fra redigeringsprogrammet, VS Code-trinn:

- Installer OpenAI Codex / ChatGPT-utvidelsen for VS Code.

- Logg inn med ChatGPT-kontoen din (Plus/Pro/Business).

- Åpne kommandopaletten:

Cmd/Ctrl+Shift+P → Codex: Set Model→ velggpt-5-codex-mini. - Bruk innebygde kommandoer (velg kode → høyreklikk → «Forklar med Codex» eller trykk på den konfigurerte hurtigtasten).

Eksempel: VS Code innebygd kommando (pseudo-trinn)

- Velg en funksjon i

user_service.py. - Press

Cmd/Ctrl+Shift+P → Codex: Explain Selectioneller bruk høyreklikk → «Forklar med Codex». - Utvidelsen åpner et sidepanel med Minis forklaring, foreslåtte tester og en ettklikks «Opprett PR»-knapp som bruker Codex Cloud-oppgaver til å sende en gren til gjennomgang.

Hva med API-et – kan jeg kalle det fra appen min?

OpenAIs kunngjøringer indikerer API-støtte kommer snart for GPT-5-Codex-Mini; i skrivende stund er modellen først tilgjengelig i Codex-verktøykjeden (CLI/IDE). Dette betyr at produksjons-API-klienter bør forberede seg på modellnavnet gpt-5-codex-mini i Requests/Responses API-et når det er publisert. I mellomtiden kan du lage prototyper med Codex CLI og IDE-flyter.

Når API-tilgang er aktivert, kan et typisk kall (i responsstil) se slik ut:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Hva er beste praksis for rask utvikling med Codex Mini?

Nedenfor finner du konkrete, feltutprøvde beste praksiser og mønstre for å få maksimal verdi ut av Codex Mini i produksjonsteknikkarbeidsflyter.

1) Strategi for modellvalg – miks og match

Bruk Mini for oppgaver med høy frekvens og lavere kompleksitet (formatering, små refaktoreringer, automatiske tester), og bruk full Codex for kompleks design, dyp feilsøking eller store repository-omfattende transformasjoner. Automatiser byttet: Codex CLI foreslår allerede Mini ved 90 % bruk, og du kan lage skript. /model bytt verktøy for å velge en modell basert på oppgavens kompleksitet.

2) Fremgangsmåte for tekniske maler

Lag små, deterministiske promptmaler for repeterbare oppgaver: testgenerering, utkast til endringslogger, generering av commit-meldinger og PR-beskrivelser. Lagre disse som gjenbrukbare kodebiter i repoet ditt eller som forhåndsinnstillinger for Codex-prompter.

Eksempel på ledetekstmal for enhetstester:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Automatiser sikkerhetsnett – godkjenninger og CI-gating

Aldri tillat en modell å pushe kode direkte uten menneskelig godkjenning. Bruk Codex sine godkjenningsmoduser og Codex Cloud-oppgaver for å opprette differanser og kreve menneskelig signering i CI. Codex CLI støtter «godkjenningsmoduser», så redigeringer må godkjennes før de brukes.

4) Bufre og deduplisere modellkall

For gjentatte spørsmål (f.eks. forklaring av en funksjon), mellomlagr svaret som er tastet inn av spørsmål + fil-hash. Dette reduserer overflødige kall og holder kostnadsprofilen forutsigbar.

5) Bruk strømming + inkrementelle differanser

Når det er mulig, be om strømmingsutganger og inkrementelle differanser i stedet for omskriving av hele filer. Dette reduserer tokenbruk og hjelper anmeldere med å se målrettede endringer.

6) Enhetstest - først generatorstrøm

Generer tester og kjør dem lokalt i et kortvarig miljø. Hvis testene mislykkes, iterer med modellen som leverer feilrettinger for testene. Ram hver iterasjon inn som en separat ledetekst med testutgangene inkludert.

Eksempel på automatiseringskodebit for Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Konklusjon

GPT-5-Codex-Mini er et pragmatisk produkttrekk: det erkjenner at utviklernes arbeidsflyter ofte domineres av mange korte interaksjoner der latens, kostnader og uavbrutt flyt er viktig. Ved å tilby et mini-nivå rettet mot IDE- og CLI-bruk, gir OpenAI team muligheten til å skalere daglig kodingshjelp uten å umiddelbart aktivere den høyest kostbare modellen for hver interaksjon.

Utviklere har tilgang GPT-5-Codex API ,GPT-5 Pro API Gjennom CometAPI er cometAPIs nyeste modeller oppført per artikkelens publiseringsdato. Før du åpner, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen.CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Klar til å dra? → Registrer deg for CometAPI i dag !

Hvis du vil vite flere tips, guider og nyheter om AI, følg oss på VK, X og Discord!