I 2025–2026 fortsatte AI-verktøylandskapet å konsolideres: Gateway-API-er (som CometAPI) ble utvidet for å gi OpenAI-tilgang til hundrevis av modeller, mens sluttbruker-LLM-apper (som AnythingLLM) fortsatte å forbedre sin «Generic OpenAI»-leverandør for å la skrivebords- og lokalt orienterte apper kalle ethvert OpenAI-kompatible endepunkt. Det gjør det enkelt i dag å rute AnythingLLM-trafikk gjennom CometAPI og få fordelene med modellvalg, kostnadsruting og enhetlig fakturering – samtidig som man fortsatt bruker AnythingLLMs lokale brukergrensesnitt og RAG/agent-funksjoner.

Hva er AnythingLLM, og hvorfor vil du koble det til CometAPI?

Hva er AnythingLLM?

AnythingLLM er en åpen kildekode, alt-i-ett AI-applikasjon og lokal/sky-klient for å bygge chatassistenter, arbeidsflyter for hentingsforsterket generering (RAG) og LLM-drevne agenter. Den tilbyr et elegant brukergrensesnitt, et utvikler-API, arbeidsområde-/agentfunksjoner og støtte for lokale og skybaserte LLM-er – designet for å være private som standard og utvidbare via plugins. AnythingLLM eksponerer en Generisk OpenAI leverandør som lar den kommunisere med OpenAI-kompatible LLM API-er.

Hva er CometAPI?

CometAPI er en kommersiell API-aggregeringsplattform som eksponerer 500+ AI-modeller gjennom ett OpenAI-lignende REST-grensesnitt og enhetlig fakturering. I praksis lar det deg kalle modeller fra flere leverandører (OpenAI, Anthropic, Google/Gemini-varianter, bilde-/lydmodeller osv.) via samme https://api.cometapi.com/v1 endepunkter og en enkelt API-nøkkel (format sk-xxxxx). CometAPI støtter standard OpenAI-stil endepunkter som /v1/chat/completions, /v1/embeddingsosv., noe som gjør det enkelt å tilpasse verktøy som allerede støtter OpenAI-kompatible API-er.

Hvorfor integrere AnythingLLM med CometAPI?

Tre praktiske grunner:

- Modellvalg og leverandørfleksibilitet: AnythingLLM kan bruke «hvilken som helst OpenAI-kompatibel» LLM via sin generiske OpenAI-wrapper. Å peke den wrapperen mot CometAPI gir umiddelbar tilgang til hundrevis av modeller uten å endre AnythingLLMs brukergrensesnitt eller flyter.

- Kostnads-/driftsoptimalisering: Ved å bruke CometAPI kan du bytte modell (eller nedgire til billigere) sentralt for kostnadskontroll, og beholde enhetlig fakturering i stedet for å sjonglere flere leverandørnøkler.

- Raskere eksperimentering: Du kan bruke A/B til forskjellige modeller (f.eks.

gpt-4o,gpt-4.5, Claude-varianter eller multimodale modeller med åpen kildekode) via det samme AnythingLLM-grensesnittet – nyttig for agenter, RAG-svar, oppsummering og multimodale oppgaver.

Miljø og forhold må du forberede før integrering

System- og programvarekrav (overordnet nivå)

- Skrivebord eller server som kjører AnythingLLM (Windows, macOS, Linux) – skrivebordsinstallasjon eller selvhostet instans. Bekreft at du bruker en nylig versjon som eksponerer LLM-preferanser / AI-leverandører innstillinger.

- CometAPI-konto og en API-nøkkel (den

sk-xxxxxstilhemmelighet). Du bruker denne hemmeligheten i AnythingLLMs generiske OpenAI-leverandør. - Nettverkstilkobling fra maskinen din til

https://api.cometapi.com(ingen brannmur som blokkerer utgående HTTPS). - Valgfritt, men anbefalt: et moderne Python- eller Node-miljø for testing (Python 3.10+ eller Node 18+), curl og en HTTP-klient (Postman / HTTPie) for å sjekke CometAPI før den kobles til AnythingLLM.

AnythingLLM-spesifikke betingelser

Ocuco Generisk OpenAI LLM-leverandøren er den anbefalte ruten for endepunkter som etterligner OpenAIs API-overflate. AnythingLLMs dokumentasjon advarer om at denne leverandøren er utviklerfokusert, og at du bør forstå inndataene du oppgir. Hvis du bruker strømming eller endepunktet ditt ikke støtter strømming, inkluderer AnythingLLM en innstilling for å deaktivere strømming for generisk OpenAI.

Sjekkliste for sikkerhet og drift

- Behandle CometAPI-nøkkelen som enhver annen hemmelighet – ikke lagre den i repositorier; lagre den i OS-nøkkelringer eller miljøvariabler der det er mulig.

- Hvis du planlegger å bruke sensitive dokumenter i RAG, må du sørge for at personverngarantiene for endepunktene oppfyller dine samsvarsbehov (sjekk CometAPIs dokumenter/vilkår).

- Bestem deg for maksimalt antall tokener og grenser for kontekstvinduer for å forhindre løpske regninger.

Hvordan konfigurerer du AnythingLLM til å bruke CometAPI (trinn for trinn)?

Nedenfor er en konkret trinnsekvens – etterfulgt av eksempler på miljøvariabler og kodestykker for testing av tilkoblingen før du lagrer innstillingene i AnythingLLM-grensesnittet.

Trinn 1 – Skaff deg CometAPI-nøkkelen din

- Registrer deg eller logg inn på CometAPI.

- Naviger til «API-nøkler» og generer en nøkkel – du får en streng som ser slik ut

sk-xxxxxHold det hemmelig.

Trinn 2 – Bekreft at CometAPI fungerer med en hurtigforespørsel

Bruk curl eller Python til å kalle et enkelt sluttpunkt for chatfullføring for å bekrefte tilkoblingen.

Eksempel på krøll

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Hvis dette returnerer en 200 og et JSON-svar med en choices array, nøkkelen og nettverket ditt fungerer. (CometAPIs dokumentasjon viser OpenAI-lignende overflate og endepunkter).

Python-eksempel (forespørsler)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

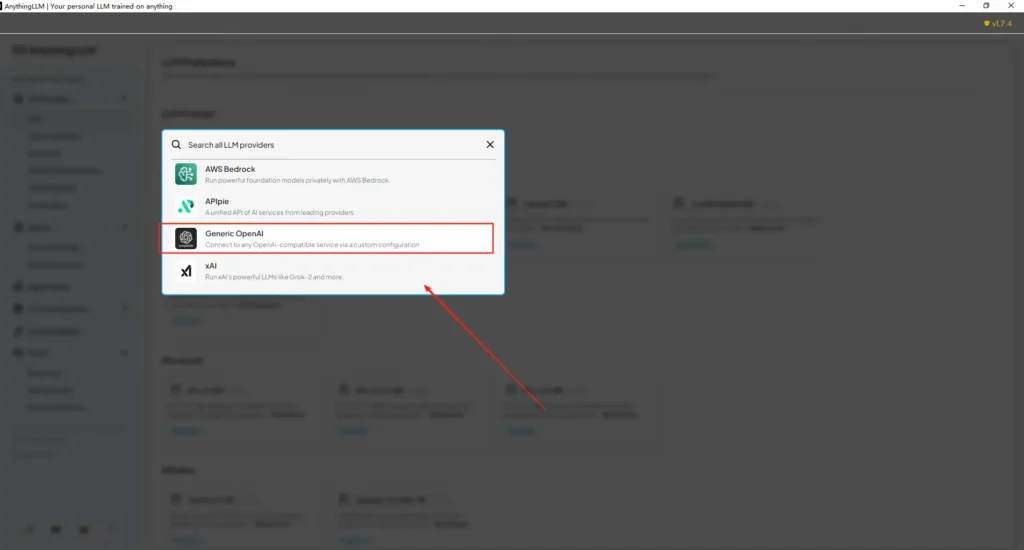

Trinn 3 – Konfigurer AnythingLLM (brukergrensesnitt)

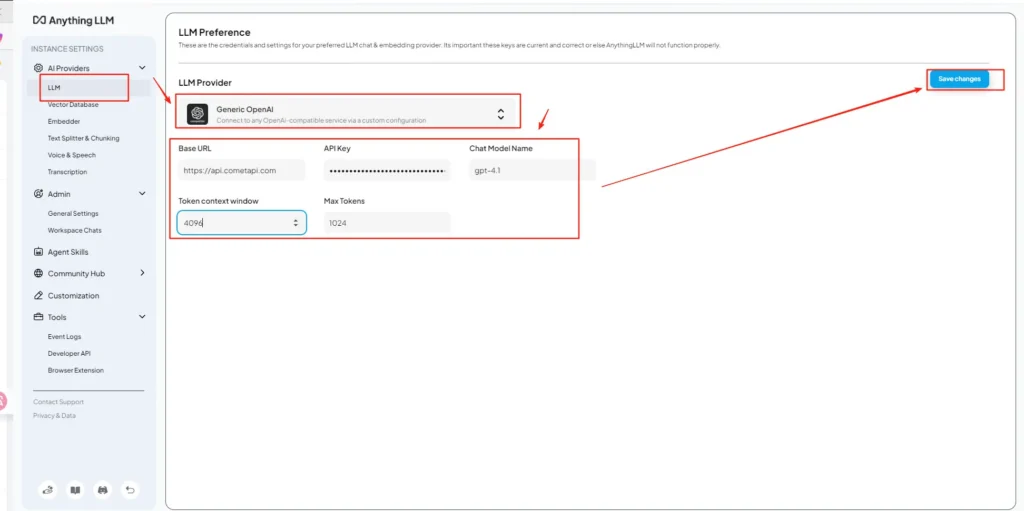

Åpne AnythingLLM → Innstillinger → AI-leverandører → LLM-preferanser (eller lignende sti i din versjon). Bruk Generisk OpenAI leverandør og fyll ut feltene som følger:

API-konfigurasjon (eksempel)

• Gå inn på innstillingsmenyen for AnythingLLM, og finn LLM-innstillinger under AI-leverandører.

• Velg Generic OpenAI som modellleverandør, skriv innhttps://api.cometapi.com/v1i URL-feltet.

• Lim innsk-xxxxxfra CometAPI i API-nøkkelinndataboksen. Fyll ut Token-kontekstvinduet og Maks. tokens i henhold til den faktiske modellen. Du kan også tilpasse modellnavn på denne siden, for eksempel legge tilgpt-4omodell.

Dette er i samsvar med AnythingLLMs veiledning for «Generisk OpenAI» (utvikleromslag) og CometAPIs OpenAI-kompatible basis-URL-tilnærming.

Trinn 4 – Angi modellnavn og tokengrenser

På samme innstillingsskjerm kan du legge til eller tilpasse modellnavn nøyaktig slik CometAPI publiserer dem (f.eks. gpt-4o, minimax-m2, kimi-k2-thinking) slik at AnythingLLM-grensesnittet kan presentere disse modellene for brukere. CometAPI publiserer modellstrenger for hver leverandør.

Trinn 5 – Test i AnythingLLM

Start en ny chat eller bruk et eksisterende arbeidsområde, velg den generiske OpenAI-leverandøren (hvis du har flere leverandører), velg et av CometAPI-modellnavnene du la til, og kjør en enkel ledetekst. Hvis du får sammenhengende fullføringer, er du integrert.

Hvordan AnythingLLM bruker disse innstillingene internt

AnythingLLMs generiske OpenAI-innpakning konstruerer forespørsler i OpenAI-stil (/v1/chat/completions, /v1/embeddings), så når du peker på basis-URL-en og oppgir CometAPI-nøkkelen, vil AnythingLLM rute chatter, agentanrop og innebyggingsforespørsler gjennom CometAPI på en transparent måte. Hvis du bruker AnythingLLM-agenter (den @agent flyter), vil de arve den samme leverandøren.

Hva er beste praksis og mulige fallgruver?

Beste praksis

- Bruk modelltilpassede kontekstinnstillinger: Match AnythingLLMs Token Context Window og Max Tokens med modellen du velger på CometAPI. Feil samsvar fører til uventet avkorting eller mislykkede kall.

- Sikre API-nøklene dine: Lagre CometAPI-nøkler i miljøvariabler og/eller Kubernetes/secret manager; sjekk dem aldri inn i git. AnythingLLM vil lagre nøkler i sine lokale innstillinger hvis du skriver dem inn i brukergrensesnittet – behandle vertslageret som sensitivt.

- Start med billigere/mindre modeller for eksperimentflyter: Bruk CometAPI til å prøve rimeligere modeller for utvikling, og reserver premiummodeller for produksjon. CometAPI annonserer eksplisitt kostnadsbytte og enhetlig fakturering.

- Overvåk bruk og angi varsler: CometAPI tilbyr bruksdashboards – angi budsjetter/varsler for å unngå uventede regninger.

- Testmidler og verktøy isolert: AnythingLLM-agenter kan utløse handlinger; test dem først med sikre ledetekster og på staging-instanser.

Vanlige fallgruver

- Brukergrensesnitt vs.

.envkonflikter: Ved egenhosting kan brukergrensesnittinnstillinger overskrives.envendringer (og omvendt). Sjekk de genererte/app/server/.envhvis ting går tilbake til normalen etter omstart. Rapport om fellesskapsproblemerLLM_PROVIDERtilbakestilles. - Avvik i modellnavn: Bruk av et modellnavn som ikke er tilgjengelig på CometAPI vil føre til en 400/404 fra gatewayen. Bekreft alltid tilgjengelige modeller på CometAPI-modelllisten.

- Tokengrenser og strømming: Hvis du trenger strømmesvar, må du bekrefte at CometAPI-modellen støtter strømme (og at AnythingLLMs brukergrensesnittversjon støtter det). Noen leverandører har ulik semantikk for strømmebruk.

Hvilke brukstilfeller i den virkelige verden åpner denne integrasjonen opp for?

Retrieval-Augmented Generation (RAG)

Bruk AnythingLLMs dokumentlastere + vektordatabase med CometAPI LLM-er for å generere kontekstbevisste svar. Du kan eksperimentere med billig innebygging + dyre chatmodeller, eller beholde alt på CometAPI for enhetlig fakturering. AnythingLLMs RAG-flyter er en primær innebygd funksjon.

Agentautomatisering

AnythingLLM støtter @agent arbeidsflyter (bla gjennom sider, kall verktøy, kjør automatiseringer). Ruting av agenters LLM-kall gjennom CometAPI gir deg valg av modeller for kontroll-/tolkningstrinn uten å endre agentkode.

Multimodell A/B-testing og kostnadsoptimalisering

Bytt modell per arbeidsområde eller funksjon (f.eks. gpt-4o for produksjonssvar, gpt-4o-mini for utviklere). CometAPI gjør modellbytter trivielle og sentraliserer kostnader.

Multimodale rørledninger

CometAPI tilbyr bilde-, lyd- og spesialiserte modeller. AnythingLLMs multimodale støtte (via leverandører) pluss CometAPIs modeller muliggjør bildeteksting, multimodal oppsummering eller lydtranskripsjon flyter gjennom samme grensesnitt.

Konklusjon

CometAPI fortsetter å posisjonere seg som en multimodell-gateway (500+ modeller, OpenAI-stil API) – noe som gjør den til en naturlig partner for apper som AnythingLLM som allerede støtter en generisk OpenAI-leverandør. På samme måte gjør AnythingLLMs generiske leverandør og nyere konfigurasjonsalternativer det enkelt å koble til slike gatewayer. Denne konvergensen forenkler eksperimentering og produksjonsmigrering sent i 2025.

Slik kommer du i gang med Comet API

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering, forenkler CometAPI dramatisk integreringen av AI-funksjoner i applikasjonene dine. Enten du bygger chatboter, bildegeneratorer, musikkomponister eller datadrevne analysepipeliner, lar CometAPI deg iterere raskere, kontrollere kostnader og forbli leverandøruavhengig – alt samtidig som du utnytter de nyeste gjennombruddene på tvers av AI-økosystemet.

For å begynne, utforsk modellens egenskaperCometAPI i lekeplass og se API-veiledningen for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. cometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Klar til å dra? → Registrer deg for CometAPI i dag !

Hvis du vil vite flere tips, guider og nyheter om AI, følg oss på VK, X og Discord!