DeepSeek utgitt DeepSeek V3.2 og en variant med høy databehandling DeepSeek-V3.2-Spesial, med en ny sparse-attention engine (DSA), forbedret agent/verktøy-atferd og en «tenkemodus» (tankekjede) som avdekker intern resonnement. Begge modellene er tilgjengelige via DeepSeeks API (OpenAI-kompatible endepunkter), og modellartefakter/tekniske rapporter publiseres offentlig.

Hva er DeepSeek V3.2?

DeepSeek V3.2 er produksjonsfølgeren i DeepSeek V3-familien – en stor, generativ modellfamilie med lang kontekst som er eksplisitt konstruert for resonnement først arbeidsflyter og agentbruk. V3.2 konsoliderer tidligere eksperimentelle forbedringer (V3.2-Exp) til en vanlig modelllinje eksponert via DeepSeeks app, webgrensesnitt og API. Den støtter både raske, konversasjonsbaserte utdata og en dedikert tenker (tankekjede)-modus egnet for flertrinns resonneringsoppgaver som matematikk, feilsøking og planlegging.

Hvorfor V3.2 er viktig (rask kontekst)

DeepSeek V3.2 er bemerkelsesverdig av tre praktiske grunner:

- Lang kontekst: Opptil 128 000 token-kontekstvinduer, noe som gjør den egnet for lange dokumenter, juridiske kontrakter eller forskning på flere dokumenter.

- Resonering først-design: Modellen integrerer tankekjede («tenkning») i arbeidsflyter og i verktøybruk – et skifte mot agentiske apper som trenger mellomliggende resonneringstrinn.

- Kostnad og effektivitet: Innføringen av DSA (sparse attention) reduserer beregningsbehovet for lange sekvenser, noe som muliggjør mye billigere inferens for store kontekster.

Hva er DeepSeek-V3.2-Speciale, og hvordan skiller den seg fra basisversjonen v3.2?

Hva gjør «Speciale»-varianten spesiell?

DeepSeek V3.2-Speciale er en høy databehandling, høy resonnement variant av v3.2-familien. Sammenlignet med den balanserte v3.2-varianten er Speciale finjustert (og ettertrent) spesielt for flertrinnsresonnement, matematikk og agentiske oppgaver; den bruker ekstra forsterkningslæring fra menneskelig tilbakemelding (RLHF) og utvidet intern tankekjede under trening. Det midlertidige endepunktet og Speciale API-tilgangen ble annonsert som tidsbegrenset (referer til et endepunktutløp 15. desember 2025 for Speciale-banen).

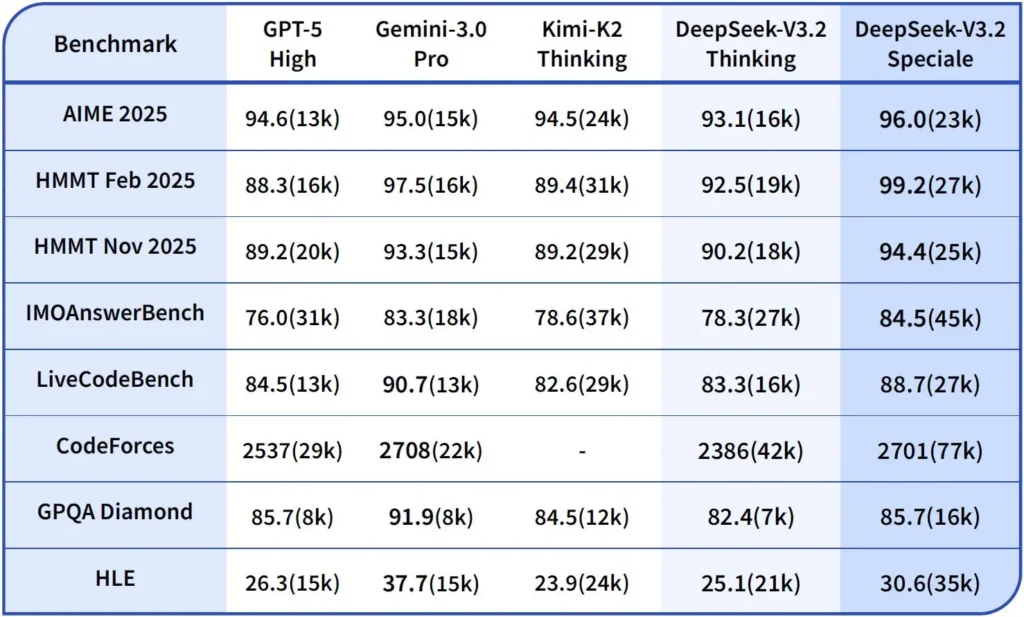

Ytelse og referansetester

DeepSeek-V3.2-Speciale er den høyberegnings- og resonneringsoptimaliserte varianten av V3.2. Speciale-versjonen integrerer den tidligere matematiske modellen DeepSeek-Math-V2. Den er posisjonert som modellen som skal brukes når arbeidsmengden krever det. dypeste mulige tankekjede, problemløsning i flere trinn, konkurransepreget resonnement (f.eks. matematisk olympiadstil) og kompleks agentisk orkestrering.

Den kan bevise matematiske teoremer og verifisere logisk resonnement på egenhånd; Den har oppnådd bemerkelsesverdige resultater i flere konkurranser i verdensklasse:

- IMO (Internasjonal matematisk olympiad) gullmedalje

- CMO (kinesisk matematikkolympiade) gullmedalje

- ICPC (Internasjonal dataprogrammeringskonkurranse) 2. plass (Menneskekonkurranse)

- IOI (Internasjonal olympiad i informatikk) 10. plass (menneskelig konkurranse)

Hva er resonneringsmodus i DeepSeek v3.2?

DeepSeek avslører en eksplisitt tenke-/resonneringsmodus som får modellen til å produsere en Chain-of-Thought (CoT) som en diskret del av utgangen før du det endelige svaret. API-et viser frem denne CoT-en slik at klientapplikasjoner kan inspisere, vise eller destillere den.

Mekanikk – hva API-et tilbyr

reasoning_contentfelt: når tenkemodus er aktivert, inkluderer responsstrukturen enreasoning_contentfeltet (CoT) på samme nivå som den endeligecontentDette lar klienter programmatisk få tilgang til de interne trinnene.- Verktøyanrop under tenkningV3.2 hevder å støtte verktøykall innenfor Tenkningsbanen: modellen kan flette sammen resonneringstrinn og verktøyaktiveringer, noe som forbedrer ytelsen til komplekse oppgaver.

Hvordan DeepSeek v3.2 API implementerer resonnement

Versjon 3.2 introduserer en standardisert API-mekanisme for resonneringskjeder for å opprettholde konsistent resonneringslogikk på tvers av samtaler med flere runder:

- Hver begrunnelsesforespørsel inneholder en

reasoning_contentfeltet i modellen; - Hvis brukeren ønsker at modellen skal fortsette resonnementet, må dette feltet sendes tilbake til neste runde;

- Når et nytt spørsmål begynner, det gamle

reasoning_contentmå ryddes for å forhindre logisk forurensning; - Modellen kan utføre løkken «resonnering → verktøykall → ny resonnering» flere ganger i resonneringsmodus.

Hvordan får jeg tilgang til og bruker DeepSeek v3.2 API

Kort sagt: CometAPI er en OpenAI-lignende gateway som eksponerer mange modeller (inkludert DeepSeek-familier) via https://api.cometapi.com/v1 slik at du kan bytte modeller ved å endre model streng i forespørsler. Registrer deg på CometAPI og få API-nøkkelen din først.

Hvorfor bruke CometAPI kontra direkte DeepSeek?

- CometAPI sentraliserer fakturering, prisgrenser og modellvalg (nyttig hvis du planlegger å bytte leverandør uten å endre kode).

- Direkte DeepSeek-endepunkter (f.eks.

https://api.deepseek.com/v1) finnes fortsatt og eksponerer noen ganger leverandørspesifikke funksjoner; velg CometAPI for enkelhets skyld eller det direkte leverandørendepunktet for leverandørnative kontroller. Bekreft hvilke funksjoner (f.eks. Speciale, eksperimentelle endepunkter) som er tilgjengelige gjennom CometAPI før du stoler på dem.

Trinn A – Opprett en CometAPI-konto og få en API-nøkkel

- Gå til CometAPI (registrering / konsoll) og generer en API-nøkkel (dashbordet viser vanligvis

sk-...). Hold det hemmelig. CometAPI

Trinn B – Bekreft det nøyaktige modellnavnet som er tilgjengelig

- Spør modelllisten for å bekrefte den nøyaktige modellstrengen CometAPI eksponerer (modellnavn kan inneholde variantsuffikser). Bruk modellens endepunkt før du hardkoder navn:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Se etter DeepSeek-oppføringen (f.eks. deepseek-v3.2 or deepseek-v3.2-exp) og noter den nøyaktige ID-en. CometAPI eksponerer en /v1/models oppføring.

Trinn C – Foreta en enkel chat-samtale (krøll)

Erstatt <COMET_KEY> og deepseek-v3.2 med modell-ID-en du bekreftet:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Dette er det samme OpenAI-lignende kallemønsteret – CometAPI videresender til den valgte leverandøren.

Kompatibilitet og forholdsregler

- Støtter aktivering av Think Mode i Claude Code-miljøet;

- I kommandolinjen (CLI) skriver du ganske enkelt inn modellnavnet deepseek-reasoner;

- Det kan imidlertid hende at den ikke er kompatibel med ikke-standardiserte verktøy som Cline og RooCode foreløpig;

- Det anbefales å bruke ikke-tenkemodus for vanlige oppgaver og tenkemodus for kompleks logisk resonnering.

Praktiske adopsjonsmønstre: noen få eksempelarkitekturer

1 — Assistent for utviklerarbeidsflyter

- Mode: Speciale (tenkemodus) aktiveres for kompleks kodegenerering og testoppretting; rask chat-modus for innebygd assistent.

- Sikkerhet: Bruk CI-pipelinekontroller og sandkassetestkjøring for generert kode.

- hosting: API eller selvhostet på vLLM + multi-GPU-klynge for stor kontekst.

2 — Dokumentanalyse for juridiske/finansielle team

- Mode: V3.2 med DSA-optimaliseringer for lang kontekst for å behandle lange kontrakter og produsere strukturerte sammendrag og handlingslister.

- Sikkerhet: Godkjenning av menneskelig advokat for nedstrøms avgjørelser; redigering av personlig identifiserbar informasjon før sending til vertsbaserte endepunkter.

3 — Autonom orkestrator for datapipeline

- Mode: Tenkemodus for å planlegge ETL-oppgaver i flere trinn, kalle verktøy for å spørre databaser og kalle valideringstester.

- Sikkerhet: Implementer handlingsbekreftelse og verifiserbare kontroller før enhver irreversibel operasjon (f.eks. destruktiv DB-skriving).

Hvert av mønstrene ovenfor er gjennomførbart med V3.2-familiemodeller i dag, men du må koble modellen med verifiseringsverktøy og konservativ styring.

Hvordan optimaliserer jeg kostnader og ytelse med v3.2?

Bruk de doble modusene bevisst

- Hurtigmodus for mikrointeraksjoner: Bruk ikke-tenkende verktøymodus for korte hentinger, formatkonverteringer eller direkte API-kall der latens er viktig.

- Tenkemodus for planlegging og verifisering: Send komplekse oppgaver, agenter med flere handlinger eller sikkerhetssensitive beslutninger til tenkemodus. Registrer mellomtrinnene og kjør en verifiseringsprosess (automatisert eller menneskelig) før kritiske handlinger utføres.

Hvilken modellvariant bør jeg velge?

- deepseek-v3.2 — balansert produksjonsmodell for generelle agentoppgaver.

- deepseek-v3.2-Speciale — spesialisert variant for tung resonnering; kan i utgangspunktet kun være API-basert og brukes når du trenger best mulig resonnerings-/benchmark-ytelse (og aksepterer potensielt høyere kostnader).

Praktiske kostnadskontroller og tips

- Promptutvikling: Hold systeminstruksjonene konsise, unngå å sende overflødig kontekst. Eksplisitte systeminstruksjoner: Bruk systemprompter som erklærer modusintensjon: f.eks. «Du er i THINKING-modus – oppgi planen din før du kaller verktøy.» For verktøymodus, legg til begrensninger som «Når du samhandler med kalkulator-API-et, må du bare sende ut JSON med følgende felt.»

- Chunking + hentingsøkning: bruk en ekstern henter for å bare sende de mest relevante segmentene for hvert brukerspørsmål.

- Temperatur og prøvetaking: Senk temperaturen for verktøyinteraksjoner for å øke determinismen; øk den i utforskende eller idégenererende oppgaver.

Referansepunkt og mål

- Behandle utdata som upålitelige inntil de er bekreftet: Selv resonnerende utdata kan være feil. Legg til deterministiske kontroller (enhetstester, typekontroller) før du iverksetter irreversible handlinger.

- Kjør A/B-tester på en prøvearbeidsmengde (forsinkelse, tokenbruk, korrekthet) før du forplikter deg til en variant. V3.2 rapporterte store gevinster på resonnement-benchmarks, men reell app-oppførsel avhenger av rask design og input-distribusjon.

Spørsmål og svar

Spørsmål: Hva er den anbefalte måten å hente CoT fra modellen?

A: Bruke deepseek-reasoner modell eller sett thinking/thinking.type = enabled i forespørselen din. Svaret inkluderer reasoning_content (CoT) og den endelige content.

Spørsmål: Kan modellen kalle på eksterne verktøy mens den er i tenkemodus?

A: Ja – V3.2 introduserte muligheten for å bruke verktøy i både tenkende og ikke-tenkende moduser; modellen kan sende ut strukturerte verktøykall under intern resonnering. strict modus og tøm JSON-skjemaer for å unngå feilformede kall.

Spørsmål: Øker bruk av tenkemodus kostnadene?

A: Ja – tenkemodus sender ut mellomliggende CoT-tokener, noe som øker tokenbruken og dermed kostnadene. Design systemet ditt slik at det bare muliggjør tenkning når det er nødvendig.

Q: Hvilket endepunkt og hvilken basis-URL bør jeg bruke?

A: CometAPI tilbyr OpenAI-kompatible endepunkter. Standard basis-URL er https://api.cometapi.com og det primære chat-endepunktet er /v1/chat/completions (eller /chat/completions avhengig av basis-URL-en du velger).

Spørsmål: Kreves det spesialverktøy for å bruke verktøykalling?

A: Nei – API-et støtter strukturerte funksjonsdeklarasjoner i JSON. Du må oppgi tools parameteren, verktøyskjemaene og håndter JSON-funksjonens livssyklus i applikasjonen din: motta funksjonskall-JSON, utfør funksjonen, og returner deretter resultatene til modellen for fortsettelse eller lukking. Tenkemodus legger til et krav om å sende tilbake reasoning_content sammen med verktøyresultater.

Konklusjon

DeepSeek V3.2 og DeepSeek-V3.2-Speciale representerer et klart løft mot åpen, resonnementssentrisk LLM-er som gjør tankekjeden eksplisitt og støtter arbeidsflyter for agentverktøy. De tilbyr kraftige nye primitiver (DSA, tenkemodus, opplæring i verktøybruk) som kan forenkle byggingen av pålitelige agenter – forutsatt at du tar hensyn til tokenkostnader, nøye tilstandsstyring og driftskontroller.

Utviklere har tilgang Deepseek v3.2 API osv. gjennom CometAPI, den nyeste modellversjonen er alltid oppdatert med den offisielle nettsiden. For å begynne, utforsk modellens muligheter i lekeplass og konsulter API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Klar til å dra? → Gratis prøveversjon av deepseek v3.2 !

Hvis du vil vite flere tips, guider og nyheter om AI, følg oss på VK, X og Discord!