Google kunngjorde Gemini 3 Flash 17.–18. desember 2025 som et lav-latens, kostnadseffektivt medlem av Gemini 3-familien. Den bringer resonnering på Pro-nivå inn i et Flash-format, støtter omfattende multimodale inndata (tekst, bilde, lyd, video), introduserer kontroller for thinking_level og medieresolusjon, og er tilgjengelig via Google AI Studio, Gemini API (REST / SDK-er), Vertex AI, Gemini CLI, og som standardmodell i Google Søk / Gemini-appen.

Hva er Gemini 3 Flash, og hvorfor er det viktig

Gemini 3 Flash er en del av Googles modeller i 3-serien. Den er utformet for å flytte Paretofronten for kvalitet vs. kostnad vs. latenstid: den leverer mye av resonneringskapasiteten til Gemini 3 Pro samtidig som den er betydelig raskere og billigere å kjøre. Denne kombinasjonen gjør den godt egnet for høyfrekvente interaktive scenarier (chatboter, IDE-assistenter, sanntids agentiske flyter), masseinnholdsgenerering der latenstid betyr noe, og applikasjoner som trenger multimodal resonnering (bilder + tekst + lyd) med lav overhead.

Viktige hovedpunkter:

- Den er eksplisitt optimalisert for hastighet + lav kostnad samtidig som den beholder sterk resonnering og multimodal troverdighet (Tre ganger raskere enn gamle Gemini 2.5 Pro; Bevarer toppsjiktets inferensevner i Gemini 3.).

- Den er posisjonert som «sweet spot» for agentiske løkker og iterative utviklerarbeidsflyter (f.eks. kodeassistanse, multi-turn agenter).

- Fleksibel: Den kan «justere tenketiden» etter problemets kompleksitet—svare umiddelbart på enkle spørsmål og ta flere trinn for komplekse oppgaver.

Teknisk ytelse og benchmarkresultater

Gemini 3 Flash oppnår et trippelt gjennombrudd i hastighet, intelligens og kostnad:

1) Agentiske løkker og multimodal forståelse

Gemini 3 Flash arver arkitektur- og treningsforbedringer fra den bredere Gemini 3-familien, noe som gir sterk multimodal kompetanse (tekst-, bilde-, video-, lydinndata) og forbedret resonnering sammenlignet med tidligere Flash-modeller. Google posisjonerer Flash som i stand til å håndtere oppgaver som dokumentanalyse (OCR + resonnering), videosammendrag, spørsmål og svar basert på bilde og tekst, og multimodale kodeoppgaver. Denne multimodale evnen, kombinert med lav latenstid, er et av modellens definerende tekniske salgsargumenter.

Google publiserte interne benchmark-påstander som fremhever sterk agentisk kodeytelse (SWE-bench Verified ~78 % for agentiske kodearbeidsflyter), og Flash nærmer seg Pro-nivå resonnering på mange oppgaver samtidig som den forblir rask nok for agentiske løkker og nesten sanntids arbeidsflyter.

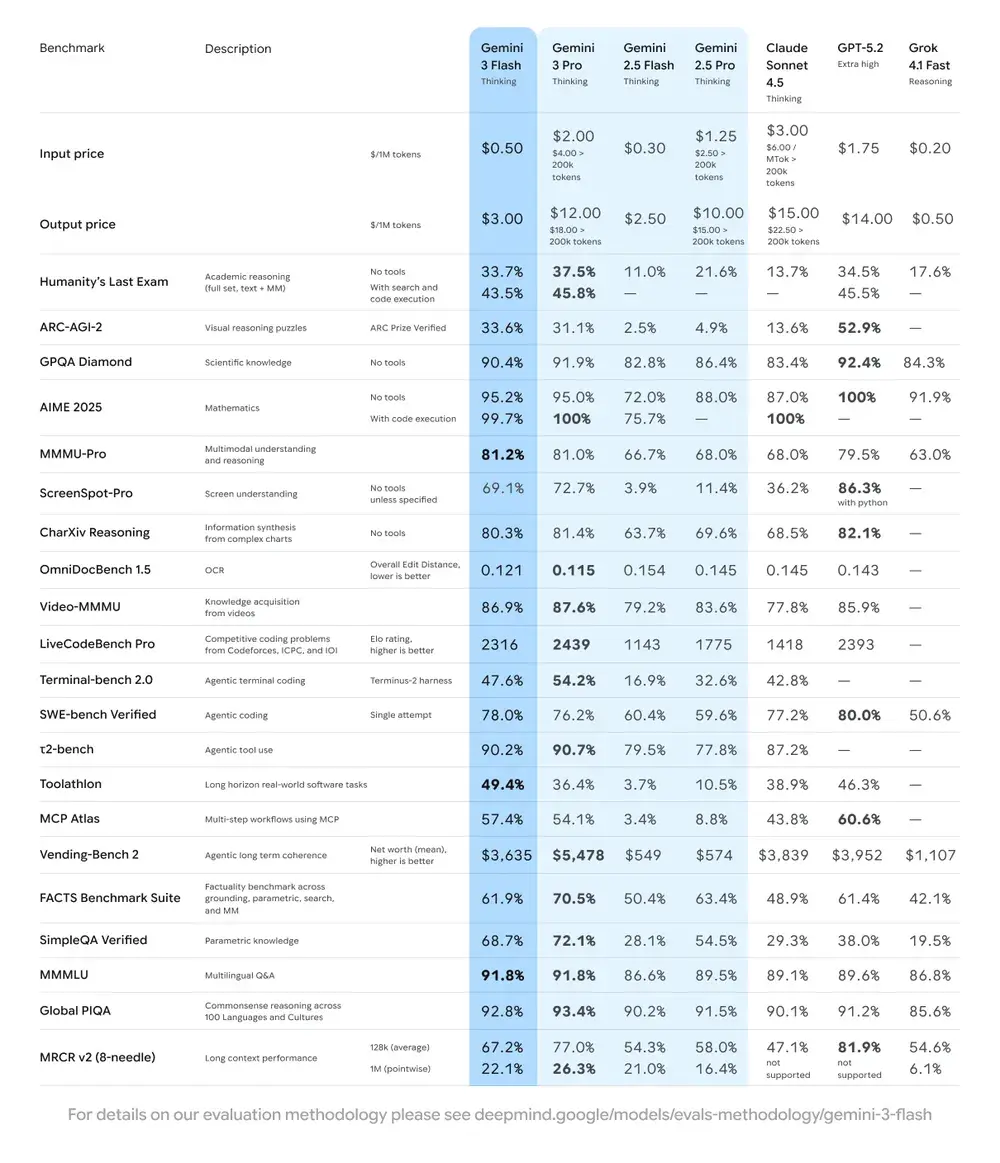

| Benchmark | Gemini 3 Flash-score | Sammenligningsmodell | Forbedring |

|---|---|---|---|

| GPQA Diamond (resonnement på PhD-nivå) | 90,4 % | Overgår Gemini 2.5 Pro | Betydelig |

| Humanity’s Last Exam (generell kunnskapstest) | 33,7 % (uten verktøy) | Nær Gemini 3 Pro | Avansert resonnering |

| MMMU Pro (multimodal forståelse) | 81,2 % | På nivå med Gemini 3 Pro | — |

| SWE-bench Verified (benchmark for kodeevner) | 78 % | Høyere enn Gemini 3 Pro og 2.5-serien | Utmerket |

2) Kostnad og effektivitet

Utviklingsfilosofien til Gemini 3 Flash er «Paretofrontier»: å finne den optimale balansen mellom hastighet, kvalitet og kostnad. Gemini 3 Flash er eksplisitt optimalisert for pris–ytelse. Google oppgir at Flash-prisingen er betydelig lavere enn Pro for sammenlignbare oppgaver, og posisjonerer den til å behandle store volum forespørsler med lavere driftskostnad. For mange arbeidslaster er Flash-varianten ment å være det kostnadseffektive standardvalget—for eksempel forhåndsvisningsprising rundt $0.50 per 1M input-tokens og $3.00 per 1M output-tokens for Flash-forhåndsvisning. I praksis gjør det den levedyktig for høyfrekvente oppgaver der Pros høyere per-token-kostnad ville være forhindrende.

Effektivitetsindikatorer

- Hastighet: 3x raskere enn Gemini 2.5 Pro (basert på Artificial Analysis-testing).

- Token-effektivitet: Bruker i gjennomsnitt 30 % færre tokens for å fullføre samme oppgave. Med andre ord får du raskere, bedre resultater for samme sum.

- Gemini 3 Flash har en «Dynamic Thinking Mode»—tilpasser resonneringsdybden til oppgavens kompleksitet, «tenker litt mer» når nødvendig, og svarer raskt på enkle oppgaver.

Praktiske implikasjoner: Lavere per-token- eller per-kall-kostnad betyr at du kan kjøre flere spørringer, lengre kontekster eller høyere samplingsrater for samme budsjett. Effektivitetsgevinster kan også redusere infrastrukturkompleksitet (færre hot-instanser nødvendig) og forbedre svartidsgarantier.

3) Ytelsesbenchmark

Gemini 3 Flash oppnår «frontier»-klasse ytelse på flere akademiske og anvendte benchmarks samtidig som den gir bedre latenstid og kostnad enn tidligere Pro-modeller. Google presenterer tall som høye poengsummer på komplekse resonnement- og kunnskapsbenchmarks (f.eks. GPQA-varianter) for å illustrere kompetansen.

Hvordan bruker jeg Gemini 3 Flash-API-et?

Hvilken tilgangsmetode bør jeg bruke?

- Anbefalt (enkelt + robust): Bruk SDK-integrasjonsmønsteret Comet viser—det peker ganske enkelt et eksisterende GenAI-SDK mot Comets base-URL og oppgir din Comet API-nøkkel. Dette gjør at du slipper å reimplementere håndtering av forespørsel/strømming selv.

- Alternativ (rå HTTP / curl / egendefinerte stacker): Du kan POST-e direkte til CometAPI-endepunkter (Comet aksepterer OpenAI-stil eller leverandørspesifikke formater). Bruk

Authorization: Bearer <sk-...>(Comet-eksemplene bruker en Bearer-header) og modellstrengengemini-3-flashi kroppen. Bekreft nøyaktig sti og spørringsparametre i Comets API-dokumentasjon for modellen du ønsker.

Rask Laur oppsummering — dette gjør du

- Registrer deg på CometAPI og opprett et API-token.

- Velg en tilgangsmetode (anbefalt: SDK-wrapper-mønsteret vist nedenfor; reserve: rå HTTP/cURL).

- Kall modellen

gemini-3-flashvia CometAPIs base-URL (Comet ruter forespørselen din til Googles Gemini-backend). - Håndter strømming / funksjonskall / multimodale inndata i henhold til modellens krav (detaljer nedenfor).

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Explain how AI works in a few words",)print(response.text)

Viktige forespørselsparametere å vurdere

thinking_level— styrer intern resonneringsdybde:MINIMAL,LOW,MEDIUM,HIGH. BrukMINIMALfor lavest latenstid og kostnad når du ikke trenger dyp flerstegsresonnering.media_resolution— for bilde-/videoinndata:low,medium,high,ultra_high. Lavere oppløsning reduserer token-ekvivalenter og latenstid.streamGenerateContentvsgenerateContent— bruk strømming for bedre opplevd latenstid når du vil ha delvise svar etter hvert som de kommer.- Funksjonskall / JSON-modus — bruk strukturerte svar når du trenger maskinparsbare utdata.

Sende multimodale inndata (praktiske tips)

- Bilder/PDF-er: foretrekk Cloud Storage-URI-er (gs://) for store medier; mange API-er aksepterer base64 for små bilder. Følg med på token-regnskap per modalitet—PDF-er kan telles under bilde-/dokumentkvoter avhengig av endepunktet.

- Video/lyd: for korte klipp kan du sende URI-er; for langt media bruk batchprosesseringsarbeidsflyter eller strøm i biter. Sjekk maksimale inndata-størrelser og kodingsbegrensninger i API-dokumentasjonen.

- Funksjonskall / verktøy: bruk strukturerte funksjonsskjemaer for å få JSON-utdata og muliggjøre sikre verktøykall. Gemini 3 Flash støtter strømmet funksjonskall for forbedret brukeropplevelse.

Hvor kan jeg få tilgang til Gemini 3 Flash?

Gemini 3 Flash er tilgjengelig på tvers av Googles forbruker- og utviklerflater:

- Google Søk og Gemini-appen — Flash er rullet ut som standardmodell for AI-modus i Søk og er integrert i Gemini-appopplevelsen for sluttbrukere.

- Google AI Studio — det umiddelbare stedet for utviklere til å eksperimentere og generere API-nøkler for testing.

- Gemini API (Generative Language / AI Developer API) — tilgjengelig som

gemini-3-flash-preview(modell-ID brukt i dokumentasjon/lanseringsnotater) og via de standardgenerateContent/streamGenerateContent-endepunktene. - Vertex AI (Google Cloud) — produksjonsklar tilgang gjennom Vertex AIs Generative AI-modell-API-er og priser/kvoter som passer for bedriftsarbeidslaster.

- Gemini CLI — for terminalbasert utvikling og skript-arbeidsflyter.

Tredjeparts-gateway CometAPI

CometAPI har allerede lagt til gemini-3-flash i katalogen sin, og modellsiden forklarer hvordan du kaller den via CometAPIs forente endepunkt. Den oppgitte modell-API-en er priset til 20 % av offisiell pris.

Hva er beste praksis når du bruker Gemini 3 Flash?

1) Velg thinking_level per oppgave og finjuster

- Sett

MINIMAL/LOWfor enkel Q&A og høyfrekvente interaktive oppgaver. - Bruk

MEDIUM/HIGHselektivt for oppgaver som krever dypere tankerekker eller flerstegs planlegging. - Benchmarket kostnad vs kvalitet når du endrer

thinking_level. Googles dokumentasjon advarer om atthinking_levelendrer interne tankesignaturer og latenstid.

2) Bruk media_resolution for å styre visuell beregning

Hvis du sender bilder eller video, velg lavest akseptable media_resolution for oppgaven; for eksempel, bruk low for miniatyrbilder og masseekstraksjon, high for visuell designkritikk. Dette reduserer token-ekvivalenter for bilder og senker latenstid.

3) Foretrekk strukturerte utdata for automatisering

Bruk JSON-modus / funksjonskall når applikasjonen din trenger maskinparsbare utdata (f.eks. enhetsekstraksjon, verktøykall). Dette forenkler nedstrøms prosessering dramatisk. Håndhev strenge JSON-skjemaer der det er mulig og valider på klienten.

4) Bruk strømming liberalt for lange svar

streamGenerateContent reduserer opplevd latenstid og tillater progressiv rendering i UI. For lange multimodale oppgaver, strøm delvise utdata slik at brukerne ser umiddelbar fremdrift.

5) Kontroller kostnader med hurtigbufring og konteksthåndtering

- Bruk kontekstbufring for gjentatte referanser (priser og tokens varierer mellom modeller).

- Unngå å sende unødvendig lange kontekster hvis det ikke er nødvendig—foretrekk konsise prompt og bruk gjenfinning + forankring for store kunnskapsbaser.

Typiske bruksscenarier for Gemini 3 Flash

Høyt volum konversasjonsagenter

Flash er et naturlig valg for chatboter og kundestøtteassistenter som trenger lav latenstid og lav kostnad per inferens. Med støtte for strømming og høy tokens/sekund reduserer Flash opplevd ventetid og driftskostnader.

Multimodale assistenter og dokumentrørledninger

Fordi Flash håndterer bilder, PDF-er og korte videoer godt, er vanlige bruksområder fakturauttrekk, multimodal Q&A over manualer, kundestøtte med bilder og PDF-inntak for kunnskapsbaser.

Sanntids videoanalyse og moderering

Rapportert høy utdatahastighet (≈218 t/s i før-lanseringstester) muliggjør nær sanntids analyse og oppsummering av korte videoer, høydepunktdeteksjon, og live-innholdsmoderering når det er riktig arkitektert.

Agentiske utviklerverktøy og kodeassistanse

SWE-bench-poeng og rapportert kodeytelse gjør Flash til et godt alternativ for raske kodeassistenter, CLI-hjelpere og andre utviklerarbeidsflyter som prioriterer lav latenstid.

Konklusjon — bør du ta i bruk Gemini 3 Flash nå?

Gemini 3 Flash er et strategisk tilbud for team som trenger sterk resonnering og multimodal intelligens uten latenstid og kostnadene til de mest avanserte Pro-modellene. Modellen er spesielt godt egnet for agentiske kodeassistenter, interaktive multimodale agenter, dokumentbehandlingsrørledninger og ethvert system der lav latenstid og skala er primære hensyn. Tidlige benchmarks (både Googles og uavhengige analyser) indikerer at Flash er konkurransedyktig på kvalitet samtidig som den tilbyr betydelige gjennomstrømmings- og kostnadsfordeler

For å komme i gang, utforsk Gemini 3 Flash sine kapabiliteter i Playground og se API-veiledningen for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du er logget inn på CometAPI og har skaffet API-nøkkelen. CometAPI tilbyr en pris langt lavere enn den offisielle for å hjelpe deg å integrere.

Klar til å starte?→ Gratis prøve av Gemini 3 Flash !