Markedet for lavkodebasert visuell AI-verktøy er i rask utvikling. Flowise – en visuell bygger med åpen kildekode for LLM-arbeidsflyter – fortsetter å legge til fellesskapsintegrasjoner og gi ut hyppige oppdateringer; CometAPI er en av flere enhetlig AI API plattformer som nå eksponerer hundrevis av modeller via et enkelt endepunkt; og backend-byggere uten kode som BuildShip tilbyr også noder for å kalle CometAPI, slik at du kan koble de samme modellene til serverarbeidsflyter. Denne veiledningen viser hvorfor og når du skal kombinere disse delene, og leder deg deretter gjennom en konkret Flowise → CometAPI-integrasjon, hvordan du kobler Prompt → LLM Chain → CometAPI, anbefalte beste praksiser og eksempler på brukstilfeller.

Hva er FlowiseAI, og hvorfor er det viktig?

FlowiseAI er en visuell plattform med åpen kildekode for å bygge LLM-arbeidsflyter, chatassistenter og agentpipelines. Den tilbyr et dra-og-slipp-lerret laget av noder (integrasjoner) som representerer ledetekster, kjeder, LLM-koblinger, hentere, minne, verktøy og utganger – slik at team kan prototype og sende LLM-drevne systemer uten å koble alt manuelt. Flowise eksponerer også API-er, sporing, evalueringsverktøy og fellesskapsvedlikeholdte noder, slik at den er nyttig både for rask prototyping og produksjonseksperimentering.

Hvorfor det er viktig: Ved å bruke Flowise får du visuell observerbarhet og rask iterasjon på promptkjeder og modellvalg – og ved å legge til tredjepartskoblinger (som CometAPI) kan du bytte eller eksperimentere med mange underliggende modeller med minimale endringer.

Hva er CometAPI, og hva tilbyr det?

CometAPI er et enhetlig API-lag som samler tilgang til hundrevis av AI-modeller (OpenAI, Anthropic/Claude, Google/Gemini, Replicate-modeller, bilde- og lydleverandører, osv.) bak et enkelt, konsistent forespørselsformat og autentiseringsskjema. Det betyr at du kan velge eller bytte modeller, sammenligne kostnader/forsinkelser eller falle tilbake på tvers av leverandører programmatisk uten å skrive om applikasjonskoden din. Plattformen er posisjonert som et kostnadsstyrings- og leverandøruavhengig tilgangslag for LLM-er og multimodale modeller.

Hva dette gir deg i praksis: enklere legitimasjonshåndtering for evaluering av flere modeller, muligheten til å A/B-e forskjellige modeller raskt, og (ofte) kostnadsoptimalisering ved å velge billigere modellvarianter når det er passende.

Hvorfor ville du integrere FlowiseAI med CometAPI?

Integrering av Flowise med CometAPI gir deg bekvemmeligheten av Flowises visuelle verktøy sammen med sentralisert tilgang til mange modellbackends via CometAPI. Fordelene inkluderer:

- Administrasjon av enkeltstående legitimasjonsopplysninger for flere modellendepunkter (gjennom CometAPI).

- Enkel modell A/Bing og ruting på leverandørnivå i en visuell kjede (bytt modell uten å endre nodekablingen).

- Raskere eksperimentering: bytt modeller, juster ledetekster og sammenlign resultater i Flowise-flyter.

- Redusert ingeniørfriksjon for team som ønsker et visuelt orkestreringslag, men trenger flere modellleverandører i kulissene.

- Hvorfor ville du integrere FlowiseAI med CometAPI?

- Integrering av Flowise med CometAPI gir deg bekvemmeligheten av Flowises visuelle verktøy sammen med sentralisert tilgang til mange modellbackends via CometAPI. Fordelene inkluderer:

- Administrasjon av enkeltstående legitimasjonsopplysninger for flere modellendepunkter (gjennom CometAPI).

- Enkel modell A/Bing og ruting på leverandørnivå i en visuell kjede (bytt modell uten å endre nodekablingen).

- Raskere eksperimentering: bytt modeller, juster ledetekster og sammenlign resultater i Flowise-flyter.

- Redusert ingeniørfriksjon for team som ønsker et visuelt orkestreringslag, men trenger flere modellleverandører i kulissene.

- Disse funksjonene akselererer RAG-oppsett, agentorkestrering og arbeidsflyter for modellkomposisjon, samtidig som de beholder den visuelle proveniensen og sporbarheten Flowise tilbyr.

Disse funksjonene akselererer RAG-oppsett, agentorkestrering og arbeidsflyter for modellkomposisjon, samtidig som de beholder den visuelle opprinnelsen og sporbarhet Flowise tilbyr.

Hvilke miljø og forutsetninger trenger du før integrering?

Sjekkliste (minimum):

- Logg på FlowiseAI

- A CometAPI konto + API-nøkkel (du henter dette fra CometAPI-konsollen). Merk: CometAPI bruker en basissti (f.eks.

https://api.cometapi.com/v1/) for forespørsler – du oppgir det i Flowise-nodeinnstillingene.

Sikkerhets- og driftsforberedelser:

- Lagre API-nøkler i Flowise Credentials – ikke legg nøkler i ledetekstmaler eller nodekode.

- Planens kvote- og hastighetsgrenser: både CometAPI og leverandørene av underliggende modeller kan pålegge grenser – sjekk planen din og bruk klientsidebegrensning eller nye forsøk om nødvendig.

- Observer kostnader: Når du bytter modell, kan du endre tokenbruk og kostnader vesentlig – instrumentmålinger og angi rekkverk.

Hvordan integrerer jeg CometAPI med FlowiseAI? (Finn og legg til CometAPI-noden – hva er trinnene?)

Følg disse praktiske trinnene for å legge til ChatCometAPI node og konfigurere påloggingsinformasjon.

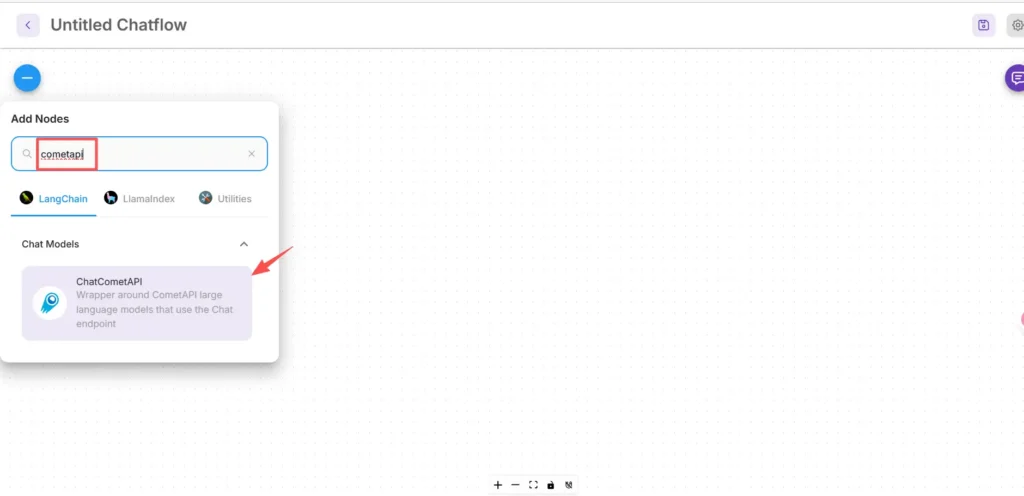

Trinn 1 – Bekreft at du har noden tilgjengelig

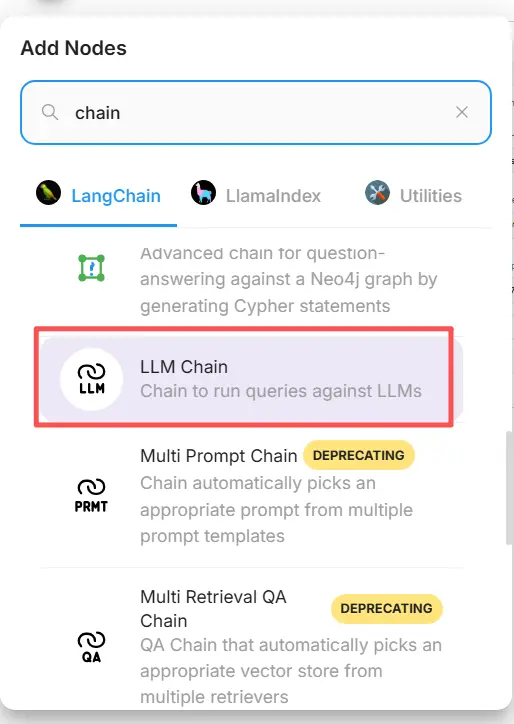

- Klikk på Legg til ny i FlowiseAI-lerretet.

- I søkefeltet skriver du inn og søker etter «cometapi» for å finne CometAPI-feltet. Noen fellesskapsnoder vises under LangChain → Chatmodeller.

Trinn 2 – Legg til CometAPI-noden i flyten din

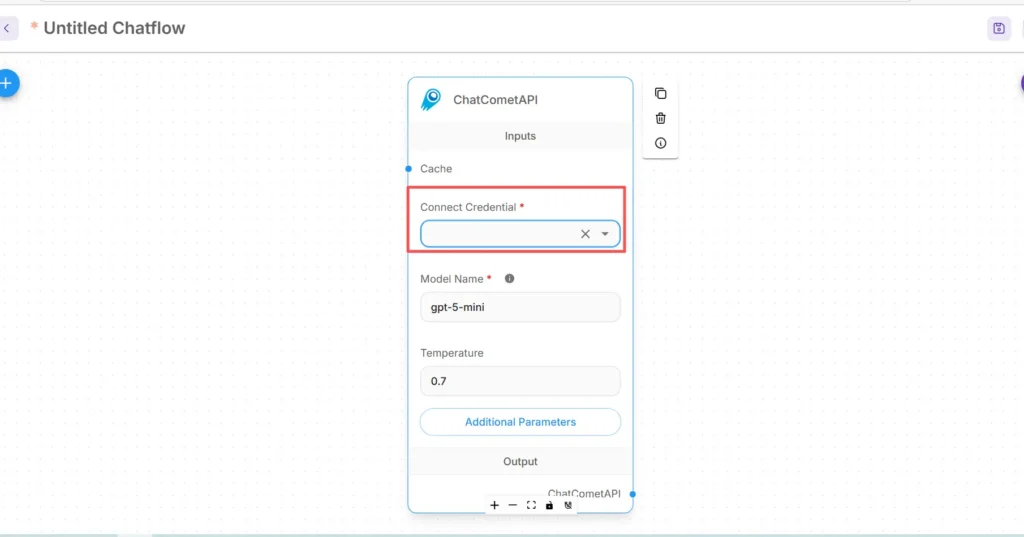

- Dra ChatCometAPI noden inn i arbeidsområdet ditt. Noden eksponerer modellvalg, temperatur, maks. tokener og andre inferensparametere.

- Plasser en Start/Inndata node (eller din chatbot-frontnode) oppstrøms for CometAPI-noden.

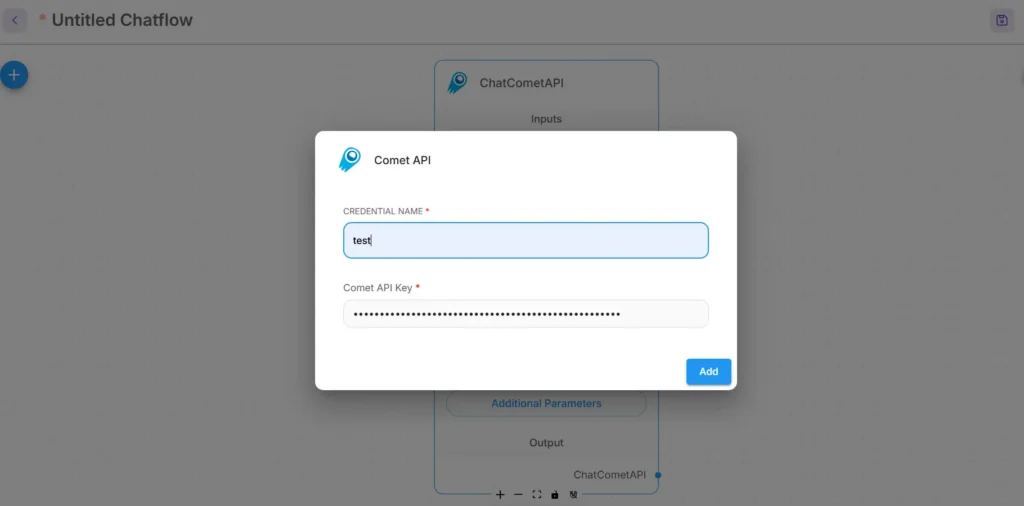

Trinn 3 – Konfigurer påloggingsinformasjon for CometAPI

- I rullegardinmenyen Koble til legitimasjon i CometAPI-noden velger du Opprett ny og finner API-nøkkel / Credentials felt. (I Flowise, eller åpen Credentials)

- Angi CometAPI API-nøkkel (helst via Flowises legitimasjonsbehandling eller som en miljøvariabel). Bruk hemmelighetsbehandling i produksjon

- Velg standard underliggende modell (eller la den være justerbar fra nodeinngangene hvis du vil bytte mellom kjøretidsmodeller). CometAPI godtar vanligvis en

modelparameter som angir hvilken leverandør/modell som skal brukes.

Trinn 4 – Angi basisbanen og tilleggsparametere.

I ChatCometAPI-nodeinnstillingene utvides Ytterligere parametere og sett Basissti til https://api.cometapi.com/v1/ (dette er nødvendig slik at noden peker til CometAPIs v1-gateway). Juster eventuelt standard modellnavn eller leverandørparametere som støttes av CometAPI.

Feilsøkingstips:

- Hvis anrop mislykkes, sjekk nettverksutgang og eventuelle brannmur-/NAT-regler mellom Flowise og CometAPI-endepunkter.

- Sjekk hastighetsgrenser og feilresponser returnert av CometAPI; implementer eksponentiell backoff på 429/5xx.

Hvordan legger jeg til en Prompt-node og setter opp LLM-kjeden i Flowise?

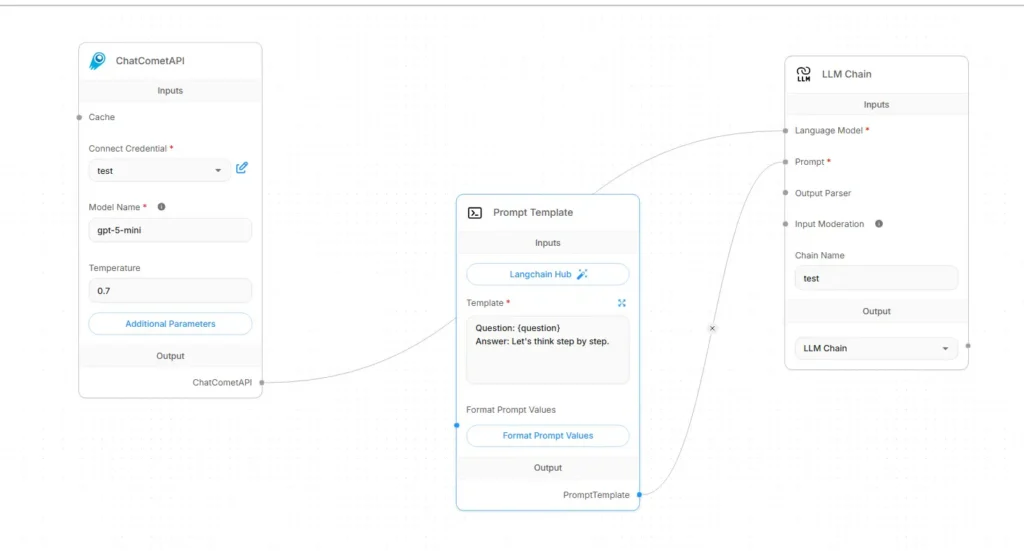

Flowise LLM-strømmer settes vanligvis sammen som Inndata → Promptmal → LLM-kjede → UtdataHer er en konkret oppskrift på ledningsnett som bruker CometAPI som språkmodell:

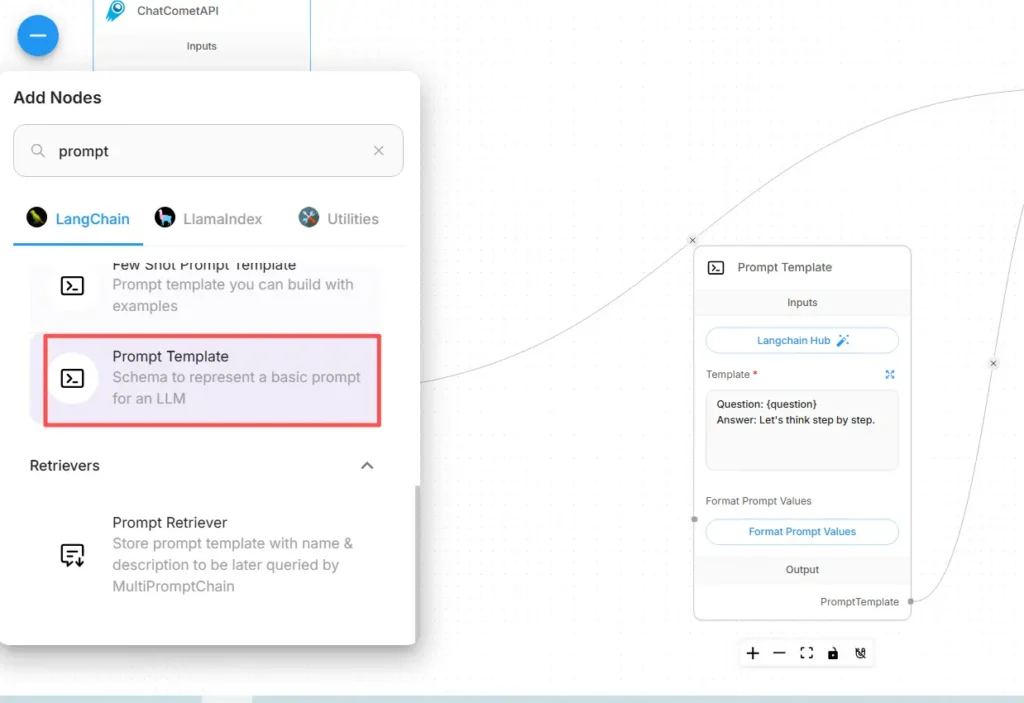

Trinn A – Opprett en node for ledetekstmal

- legge en Spørmal node (eller «Prompt»-node) til lerretet.

- I Prompt-noden redigerer du malen din ved hjelp av variabler for dynamisk innhold, f.eks.:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- Avdekke

user_inputsom variabelen som skal fylles ut fra Start/Input-noden.

Trinn B – Legg til en LLM-kjedenode (LLM-wrapper)

Legg til en LLM-kjede or LLM node som representerer en prompt → modellpåkallelse. I Flowise har LLM Chain-noden vanligvis to hovedinnganger: Språkmodell (modell-/inferensnoden) og prompt (malen for ledeteksten).

Trinn C – Koble til nodene (eksplisitt kabling)

- Koble CometAPI-noden til LLM-kjeden Språkmodell input.

Dette forteller kjeden hvilken modell den skal kalle for generering. (CometAPI blir modellleverandøren.) - Koble Prompt Template-noden til LLM-kjeden prompt input.

Kjeden vil kombinere promptmalen med variabelverdiene og sende den resulterende prompten til CometAPI. - Koble Start/Input-noden til ledetekstmalens

user_inputvariabel. - Koble LLM-kjedeutgangen til utgangsnoden (UI-respons eller nedstrømsverktøy).

Visuelt skal flyten se slik ut:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

Trinn D – Test med en tørrkjøring

- Kjør flyten i Flowises testkonsoll. Inspiser ledeteksten som sendes til CometAPI, responstokener og latens. Juster temperatur, maks. tokener eller topp-p i CometAPI-nodeinnstillingene for å finjustere kreativitet kontra determinisme.

Hvilke praktiske bruksområder muliggjør denne integrasjonen?

Nedenfor er sterke brukseksempler der Flowise + CometAPI gir konkrete fordeler:

1) Flermodellruting / valg av beste verktøy

Bygg flyter som velger modeller per deloppgave: rask oppsummering med en lavkostmodell, faktabasert forankring med en modell med høy nøyaktighet og bildegenerering via en bildemodell – alt via CometAPI-parametere uten å endre Flowise-kablingen.

2) Modell A/B-testing og evaluering

Spinn opp to parallelle LLM-kjeder i Flowise (A vs. B), rute den samme prompten til forskjellige CometAPI-modellvalg, og mat resultatene til en liten komparatornode som scorer utdata. Bruk beregninger for å bestemme hvilken modell som skal tas i bruk.

3) Hybrid RAG (Retriever + LLM)

Bruk Flowises dokumentlager og vektorhenter til å samle kontekst, og send deretter en kombinert promptmal til CometAPIs modell. Det enhetlige API-et forenkler bytte av LLM som brukes til endelig syntese.

4) Agentverktøy (API-er, databaser, kode)

Skriv verktøy (HTTP GET/POST, DB-kall) i Flowise-agenter, bruk CometAPI for språklig resonnement og handlingsvalg, og rute utdata til koblinger/verktøy. Flowise støtter forespørselsverktøy og agentmønstre for dette.

Komme i gang

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering, forenkler CometAPI dramatisk integreringen av AI-funksjoner i applikasjonene dine. Enten du bygger chatboter, bildegeneratorer, musikkomponister eller datadrevne analysepipeliner, lar CometAPI deg iterere raskere, kontrollere kostnader og forbli leverandøruavhengig – alt samtidig som du utnytter de nyeste gjennombruddene på tvers av AI-økosystemet.

For å begynne, utforsk modellens muligheter i lekeplass og konsulter Flowise API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Klar til å dra? → Registrer deg for CometAPI i dag !

Endelige anbefalinger og oppsummering

Å integrere Flowise med CometAPI er en pragmatisk måte å kombinere rask visuell orkestrering (Flowise) med fleksibel tilgang til mange modellleverandører (CometAPI). Mønsteret – lagre ledetekster som maler, hold modellnoder frakoblet og instrumentkjøring nøye – lar team iterere raskt og bytte leverandører uten å skrive om flyter. Husk å administrere legitimasjon sikkert, ta hensyn til latens og kostnader, og instrumenter flytene dine for observerbarhet og styring.