Llama 4 API er et kraftig grensesnitt som lar utviklere integrere Metasine nyeste multimodale store språkmodeller, som muliggjør avanserte tekst-, bilde- og videobehandlingsmuligheter på tvers av ulike applikasjoner.

Oversikt over Llama 4-serien

Metas Llama 4-serie introduserer banebrytende AI-modeller designet for å behandle og oversette ulike dataformater, inkludert tekst, video, bilder og lyd, og dermed forbedre allsidigheten på tvers av applikasjoner. Serien inkluderer:

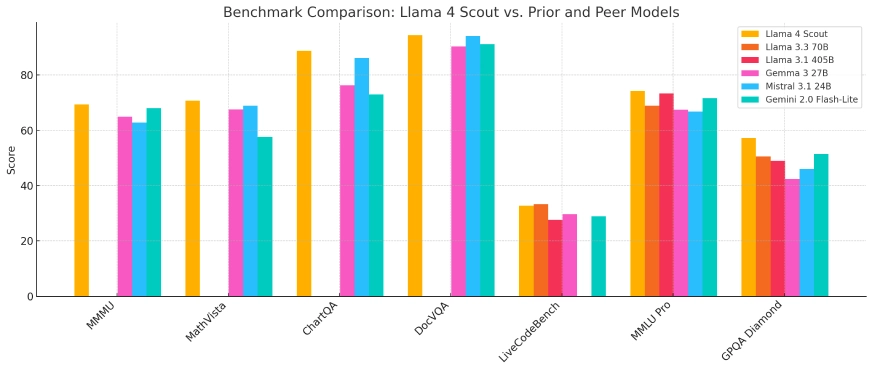

- Flamme 4 speider: En kompakt modell optimalisert for distribusjon på en enkelt Nvidia H100 GPU, med et kontekstvindu på 10 millioner tokener. Den utkonkurrerer konkurrenter som Googles Gemma 3 og Mistral 3.1 på tvers av ulike benchmarks.

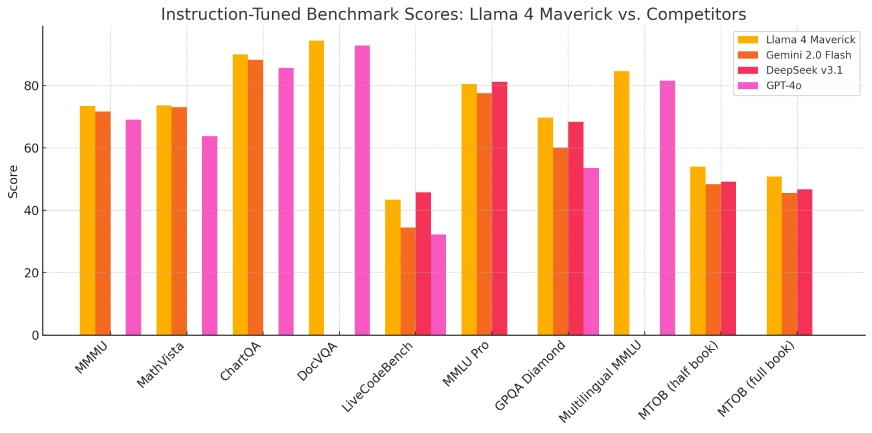

- Flame 4 Maverick: En større modell som kan sammenlignes i ytelse med OpenAIs GPT-4o og DeepSeek-V3 i kodings- og resonneringsoppgaver, samtidig som den bruker færre aktive parametere.

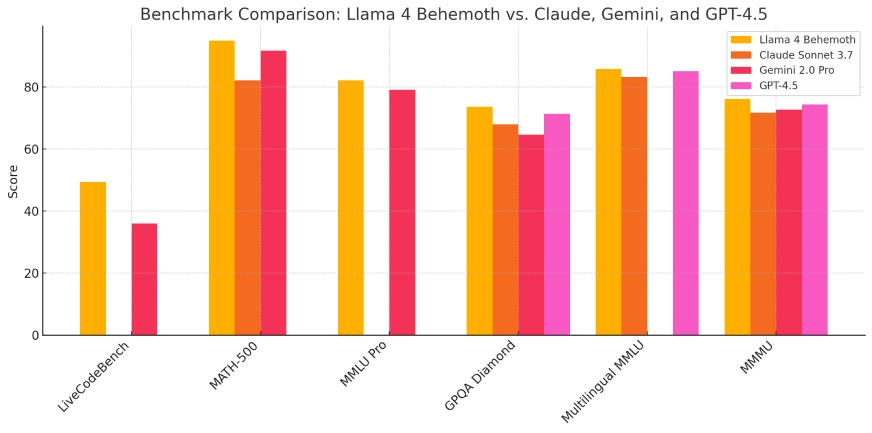

- Flame 4 Behemoth: Denne modellen er under utvikling, og har 288 milliarder aktive parametere og totalt 2 billioner, med mål om å overgå modeller som GPT-4.5 og Claude Sonnet 3.7 på STEM-benchmarks.

Disse modellene er integrert i Metas AI-assistent på tvers av plattformer som WhatsApp, Messenger, Instagram og nettet, og forbedrer brukerinteraksjoner med avanserte AI-funksjoner.

| Modell | Totale parametere | Aktive parametere | Eksperter | Kontekstlengde | Kjører på | Offentlig tilgang | Ideell for |

|---|---|---|---|---|---|---|---|

| Scout | 109B | 17B | 16 | 10 millioner tokens | Enkel Nvidia H100 | ✅ Ja | Lette AI-oppgaver, apper med lang kontekst |

| Maverick | 400B | 17B | 128 | Ikke spesifisert | Enkel eller multi-GPU | ✅ Ja | Forskning, bedriftsapplikasjoner, koding |

| Behemoth | ~2T | 288B | 16 | Ikke spesifisert | Meta intern infra | ❌ Nei | Intern modellopplæring og benchmarking |

Teknisk arkitektur og innovasjoner

Llama 4-serien bruker en "blanding av eksperter" (MoE)-arkitektur, en innovativ tilnærming som optimaliserer ressursutnyttelsen ved å aktivere bare relevante delsett av modellens parametere under spesifikke oppgaver. Denne designen forbedrer beregningseffektiviteten og ytelsen, slik at modellene kan håndtere komplekse oppgaver mer effektivt.

Opplæring av disse modellene krevde betydelige beregningsressurser. Meta brukte en GPU-klynge bestående av over 100,000 100 Nvidia HXNUMX-brikker, som representerer en av de største AI-treningsinfrastrukturene til dags dato. Denne omfattende beregningskraften gjorde det lettere å utvikle modeller med forbedrede muligheter og ytelsesmålinger.

Evolusjon fra tidligere modeller

Llama 4-serien bygger på grunnlaget lagt av tidligere iterasjoner, og representerer en betydelig utvikling i Metas AI-modellutvikling. Integreringen av multimodale prosesseringsevner og innføringen av MoE-arkitekturen adresserer begrensninger observert i tidligere modeller, for eksempel utfordringer i resonnement og matematiske oppgaver. Disse fremskrittene posisjonerer Llama 4 som en formidabel konkurrent i AI-landskapet.

Benchmark ytelse og tekniske indikatorer

I benchmark-evalueringer viste Llama 4 Scout overlegen ytelse i forhold til modeller som Googles Gemma 3 og Mistral 3.1, spesielt i oppgaver som krever omfattende kontekstbehandling. Llama 4 Maverick viste egenskaper på nivå med ledende modeller som OpenAIs GPT-4o, spesielt i kodings- og resonneringsoppgaver, samtidig som de opprettholdt en mer effektiv parameterutnyttelse. Disse resultatene understreker effektiviteten til MoE-arkitekturen og det omfattende treningsregimet som brukes.

Flamme 4 speider

Flame 4 Maverick

Llama 4 Behemoth:

Applikasjonsscenarier

Allsidigheten til Llama 4-serien gjør det mulig å bruke den på tvers av forskjellige domener:

- Social Media Integration: Forbedre brukerinteraksjoner på plattformer som WhatsApp, Messenger og Instagram gjennom avanserte AI-drevne funksjoner, inkludert forbedrede innholdsanbefalinger og samtaleagenter.

- Content Creation: Hjelper skapere med å generere multimodalt innhold av høy kvalitet ved å behandle og syntetisere tekst, bilder og videoer, og dermed strømlinjeforme den kreative prosessen.

- Pedagogiske verktøy: Tilrettelegging for utvikling av intelligente veiledningssystemer som kan tolke og svare på ulike dataformater, og gi en mer oppslukende læringsopplevelse.

- Business Analytics: Gjør det mulig for bedrifter å analysere og tolke komplekse datasett, inkludert tekstlig og visuell informasjon, for å utlede handlingskraftig innsikt og informere beslutningsprosesser.

Integreringen av Llama 4-modellene i Metas plattformer eksemplifiserer deres praktiske nytte og potensial for å forbedre brukeropplevelser på tvers av ulike applikasjoner.

Etiske vurderinger og åpen kildekode-strategi

Mens Meta markedsfører Llama 4-serien som åpen kildekode, inkluderer lisensvilkårene restriksjoner for kommersielle enheter med over 700 millioner brukere. Denne tilnærmingen har fremkalt kritikk fra Open Source Initiative, og fremhever den pågående debatten om balansen mellom åpen tilgang og kommersielle interesser i AI-utvikling.

Metas betydelige investering, angivelig opp til 65 milliarder dollar i AI-infrastruktur, understreker selskapets forpliktelse til å fremme AI-evner og opprettholde et konkurransefortrinn i det raskt utviklende AI-landskapet.

Konklusjon

Introduksjonen av Metas Llama 4-serie markerer et sentralt fremskritt innen kunstig intelligens, og viser betydelige forbedringer i multimodal prosessering, effektivitet og ytelse. Gjennom innovative arkitektoniske design og betydelige beregningsinvesteringer setter disse modellene nye standarder for AI-evner. Ettersom Meta fortsetter å integrere disse modellene på tvers av sine plattformer og utforske videre utvikling, er Llama 4-serien klar til å spille en avgjørende rolle i å forme den fremtidige banen til AI-applikasjoner og -tjenester.

Hvordan ringe Llama 4 API fra CometAPI

1.Logg inn til cometapi.com. Hvis du ikke er vår bruker ennå, vennligst registrer deg først

2.Få tilgangslegitimasjons-API-nøkkelen av grensesnittet. Klikk "Legg til token" ved API-tokenet i det personlige senteret, hent tokennøkkelen: sk-xxxxx og send inn.

-

Få nettadressen til dette nettstedet: https://api.cometapi.com/

-

Velg Llama 4 (modellnavn: lama-4-maverick; lama-4-speider) endepunkt for å sende API-forespørselen og angi forespørselsteksten. Forespørselsmetoden og forespørselsinstansen hentes fra vår nettside API-dok. Vår nettside tilbyr også Apifox-test for enkelhets skyld.

- For modelllunsjinformasjon i Comet API, se https://api.cometapi.com/new-model.

- For modellprisinformasjon i Comet API, se https://api.cometapi.com/pricing

| Kategori | lama-4-maverick | lama-4-speider |

| API-priser | Input tokens: $0.48 / M tokens | Input tokens: $0.216 / M tokens |

| Output tokens: $1.44/M tokens | Output tokens: $1.152/M tokens |

- Behandle API-svaret for å få det genererte svaret. Etter å ha sendt API-forespørselen, vil du motta et JSON-objekt som inneholder den genererte fullføringen.