I et spennende livestream-arrangement torsdag 27. OpenAI avslørte en forskningsforhåndsvisning av GPT-4.5, den siste iterasjonen av flaggskipets store språkmodell. Selskapets representanter hyllet denne nye versjonen som deres mest dyktige og allsidige chat-modell til dags dato. Det vil i utgangspunktet være åpent for programvareutviklere og personer med ChatGPT Pro-abonnementer.

Utgivelsen av GPT-4.5 vil markere slutten på en slags æra for OpenAI. I et innlegg på X tidligere denne måneden sa OpenAI-sjef Sam Altman at modellen ville være den siste som selskapet introduserer som ikke bruker ekstra datakraft til å tenke over spørsmål før de svarer.

Hva er GPT 4.5?

GPT 4.5 er OpenAIs største modell til nå – Eksperter har estimert at GPT-4 kan ha så mange som 1.8 billioner parametere, verdiene som blir justert når en modell trenes. Ved å skalere uovervåket læring forbedrer GPT 4.5 sin evne til å gjenkjenne mønstre, tegne sammenhenger og generere koblinger uten kreative motiver.

GPT 4.5 er et eksempel på skalering av uovervåket læring ved å skalere opp databehandling og data, sammen med arkitektur- og optimaliseringsinnovasjoner. Og GPT-4.5 er mer naturlig i brukerinteraksjon, dekker et bredere spekter av kunnskap, og kan bedre forstå og svare på brukerens hensikter, noe som fører til reduserte hallusinasjoner og mer pålitelighet på tvers av et bredt spekter av emner.

Hva er oppgraderingene til GPT 4.5 og dens funksjoner

EQ oppgradering:

Den største egenskapen til GPT-4.5 er dens forbedrede "emosjonelle intelligens" (EQ), som kan gi en mer naturlig, varm og jevn samtaleopplevelse. OpenAI-sjef Sam Altman delte på sosiale medier: "Dette er første gang jeg føler at AI snakker med en gjennomtenkt person. Det gir virkelig verdifulle råd, og fikk meg til og med til å lene meg tilbake i stolen noen ganger, overrasket over at AI kan gi så gode svar."

I testen for menneskelige preferanser tror brukere generelt at GPT 4.5s svar er mer i tråd med menneskelige kommunikasjonsvaner enn GPT-4o. Nærmere bestemt fikk den nye modellen høyere rangeringer innen kreativ intelligens (56.8 %), profesjonelle problemer (63.2 %) og daglige problemer (57.0 %).

Reduserte hallusinasjoner:

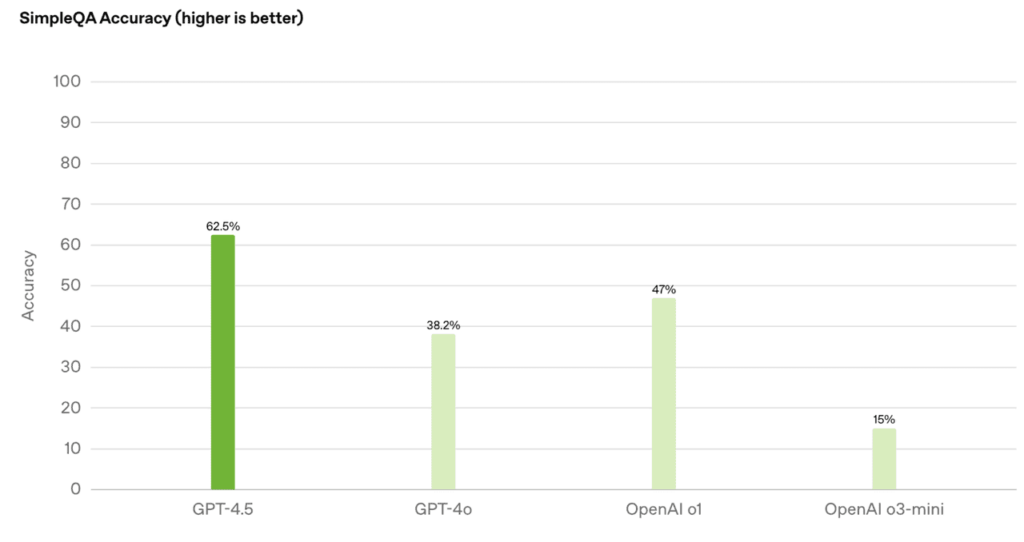

Gjennom storskala "uovervåket læring" har GPT 4.5 gjort betydelige fremskritt i kunnskapsnøyaktighet og redusert "hallusinasjoner" (falsk informasjon):

- Ved å oppnå 62.5 % nøyaktighet i SimpleQA-evaluering, falt hallusinasjonsfrekvensen til 37.1 %

- Oppnå en nøyaktighet på 0.78 på PersonQA-datasettet, langt bedre enn GPT-4o (0.28) og o1 (0.55)

Kunnskapsbaseutvidelse og Expression Upgrade

Effektiviteten økte dramatisk: datakraftforbruket ble redusert med 10 ganger, kunnskapsbasen doblet, men kostnadene var høyere (Pro-brukere har prioritert erfaring på $200/måned). I tillegg har GPT 4.5 blitt optimert innen arkitektur og innovasjon, forbedret kontrollerbarhet, forståelse av nyanser og naturlige samtaleevner, og er spesielt egnet for skriving, programmering, løsning av praktiske problemer og interaktive scenarier som krever høy grad av empati.

Høydepunkter i teknisk arkitektur

Oppgradering av datakraft: Basert på Microsoft Azure supercomputing-opplæring, er datakraften 10 ganger større enn GPT-40, dataeffektiviteten er forbedret med mer enn 10 ganger, og distribuert opplæring på tvers av datasentre støttes.

Sikkerhetsoptimalisering: Integrer tradisjonell overvåket finjustering (SFT) og RLHF, introduser ny tilsynsteknologi og reduser risikoen for skadelig produksjon.

Multimodale begrensninger: Stemme/video støttes ikke ennå, men bildeforståelse er lagt til for å hjelpe SVG-animasjonsdesign og opphavsrettsfri musikkgenerering.

Beslektede emner:Den beste 8 mest populære AI-modellsammenlikningen fra 2025

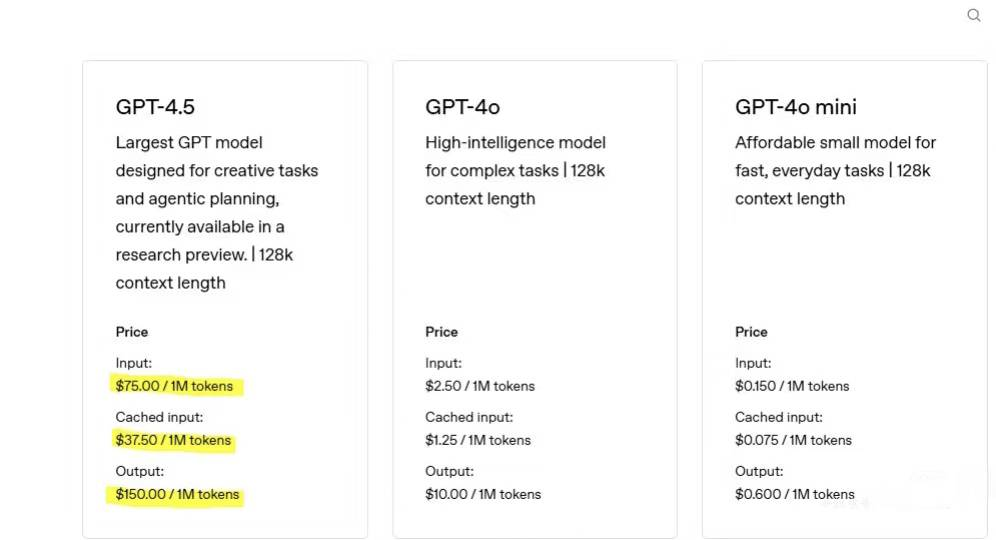

GPT 4.5 API-priser forklart: Er det virkelig verdt det?

GPT-4.5 er bygget på en kolossal arkitektur med 12.8 billioner parametere og et 128k token kontekstvindu. Denne enorme skalaen og dataintensive designen kommer med premiumpriser. For eksempel kan en arbeidsmengde med 750 250 input-tokens og 147 30 output-tokens koste rundt $34 – omtrent 4–XNUMX× dyrere enn tidligere modeller som GPT-XNUMXo.

Prissammenligning av GPT-serien

Den nye modellen er nå tilgjengelig for forskningsforhåndsvisning for ChatGPT Pro-brukere og vil bli rullet ut til Plus-, Team-, Enterprise- og Education-brukere i løpet av de neste to ukene.

GPT 4.5 vs andre språkmodeller

Den estetiske intuisjonen til designskriving har blitt oppgradert, noe som gjør den mer egnet for kreativt arbeid og emosjonell interaksjon enn andre modeller. Resonnementet har blitt nedprioritert, og det har helt klart forlatt posisjoneringen av «den sterkeste modellen». Dens resonnementevne henger etter konkurrentene. GPT-4.5 har hevet standarden for konversasjons-AI, men den høye prisen gjør det til et profesjonelt verktøy i stedet for en massemarkedsløsning.

Omfattende API-prissammenligning på tvers av ledende AI-modeller

| Modell | Inndatakostnad (per 1 million tokens) | Utdatakostnad (per 1 million tokens) | Kontekstvindu | Kommentar |

| GPT-4.5 | 75 | 150 | 128k tokens | Premium-priser for avanserte emosjonelle og samtaleevner |

| GPT-4o | 2.5 | 10 | 128k tokens | Kostnadseffektiv baseline med rask, multimodal støtte |

| Claude 3.7 sonett | 3 | 15 | 200k tokens | Eksepsjonelt økonomisk; støtter både tekst og bilder |

| DeepSeek R1 | ~ $ 0.55 | ~ $ 2.19 | 64k tokens | Aggressiv prissetting; caching kan ytterligere redusere kostnadene for brukstilfeller med høyt volum |

| Google Gemini 2.0 Flash | ~ $ 0.15 | ~ $ 0.60 | Opptil 1 million tokens | Ultralav kostnad med enorm kontekstkapasitet; ideell for store oppgaver |

Tekniske evner og kostnadsavveininger

Kontekst og multimodalitet:

**GPT-4.5:**Støtter en 128k token-kontekst, men er kun for tekst.

Claude 3.7 sonett: Tilbyr et større 200k token-vindu og bildebehandling for forbedret ytelse i lang kontekst.

**Google Gemini 2.0 Flash:**Har et imponerende 1M token-vindu, ideelt for omfattende innholdsbehandling (selv om tekstkvaliteten kan variere).

Spesialiserte oppgaver:

**Kodingsreferanser:**GPT-4.5 oppnår rundt 38 % nøyaktighet på kodeoppgaver (f.eks. SWE-Bench), mens Claude 3.7 Sonnet gir betydelig bedre kostnadseffektivitet og ytelse i tekniske oppgaver.

**Emosjonell intelligens:**GPT-4.5 utmerker seg ved å levere nyansert, følelsesmessig rik dialog, noe som gjør den ideell for kundestøtte- og coachingapplikasjoner.

Konklusjon

GPT-4.5 er den "siste ikke-inferensmodellen". Dens uovervåkede læringsevne vil bli integrert med resonneringsteknologien i o-serien, og baner vei for GPT-5 utgitt i slutten av mai. Utgivelsen av GPT-4.5 er ikke bare en teknologisk oppgradering, men også en rekonstruksjon av menneske-maskin-samarbeidsmodellen. Selv om flaskehalsen for høy pris og datakraft er kontroversiell, gir dens gjennombrudd innen emosjonell resonans og praktisk funksjon et nytt paradigme for integrering av AI i utdanning, medisinsk behandling og andre felt. AI har ubegrenset utviklingspotensial!

Vanlige vanlige spørsmål om GPT 4.5

Hva er dens begrensninger?

Den mangler tankekjede-resonnement, og kan være tregere på grunn av størrelsen. Den produserer heller ikke multimodal utgang som lyd eller video.

Kan den gi fullstendig nøyaktige svar 100 % av tiden?

Nei. Mens GPT-4.5 generelt hallusinerer mindre enn tidligere modeller, bør brukere fortsatt verifisere viktige eller sensitive utdata.

Støtter GPT-4.5 bilder?

Ja, GPT-4.5 aksepterer bildeinndata, kan generere SVG-bilder in-line og generere bilder via DALL·E.

Støtter GPT-4.5 søk på nettet?

Ja, GPT-4.5 har tilgang til den siste oppdaterte informasjonen med søk.

Hvilke filer og filtyper fungerer det med?

GPT-4.5 støtter alle filer og filtyper.