Qwen2.5-Omni-7B API gir utviklere OpenAI-kompatible metoder for å samhandle med modellen, som muliggjør behandling av tekst, bilde, lyd og videoinnganger, og genererer både tekst og naturlig talerespons i sanntid.

Hva er Qwen2.5-Omni-7B?

Qwen2.5-Omni-7B er Alibabas flaggskip multimodale AI-modell, med 7 milliarder parametere. Designet for å behandle og forstå flere datamodaliteter, støtter den tekst-, bilde-, lyd- og videoinnganger. Modellen forenkler tale- og videointeraksjoner i sanntid, noe som gjør den til et allsidig verktøy for ulike applikasjoner.

Nøkkelfunksjoner til Qwen2.5-Omni-7B

- Multimodal behandling: Kan håndtere ulike input, inkludert tekst, bilder, lyd og video, noe som muliggjør omfattende dataforståelse.

- Samhandling i sanntid: Støtter prosessering med lav latens, noe som gir mulighet for tale- og videosamtaler i sanntid.

- Thinker-Talker-arkitektur: Bruker et system med dobbel arkitektur der 'Tenkeren' styrer databehandling og forståelse, mens 'Talker' genererer flytende tale.

- Tidsjustert multimodalt tau (TMRoPE): Bruker TMRoPE for presis synkronisering av tidsdata på tvers av ulike modaliteter, og sikrer sammenhengende forståelse og responsgenerering.

Ytelsesmålinger

Benchmark-prestasjoner

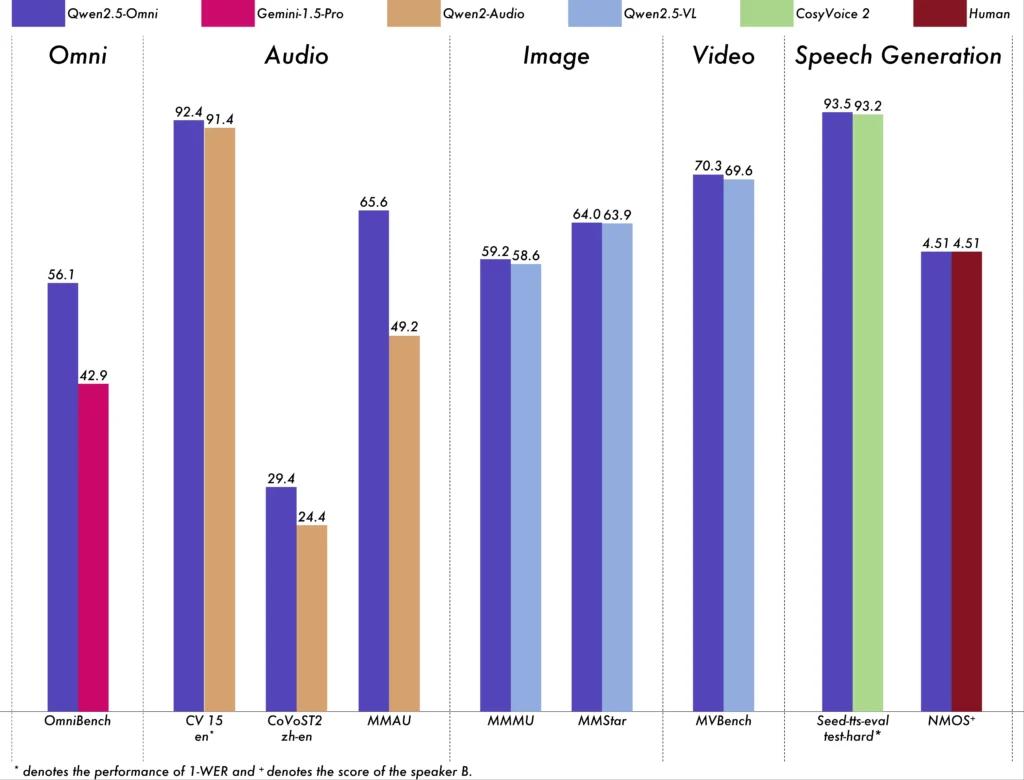

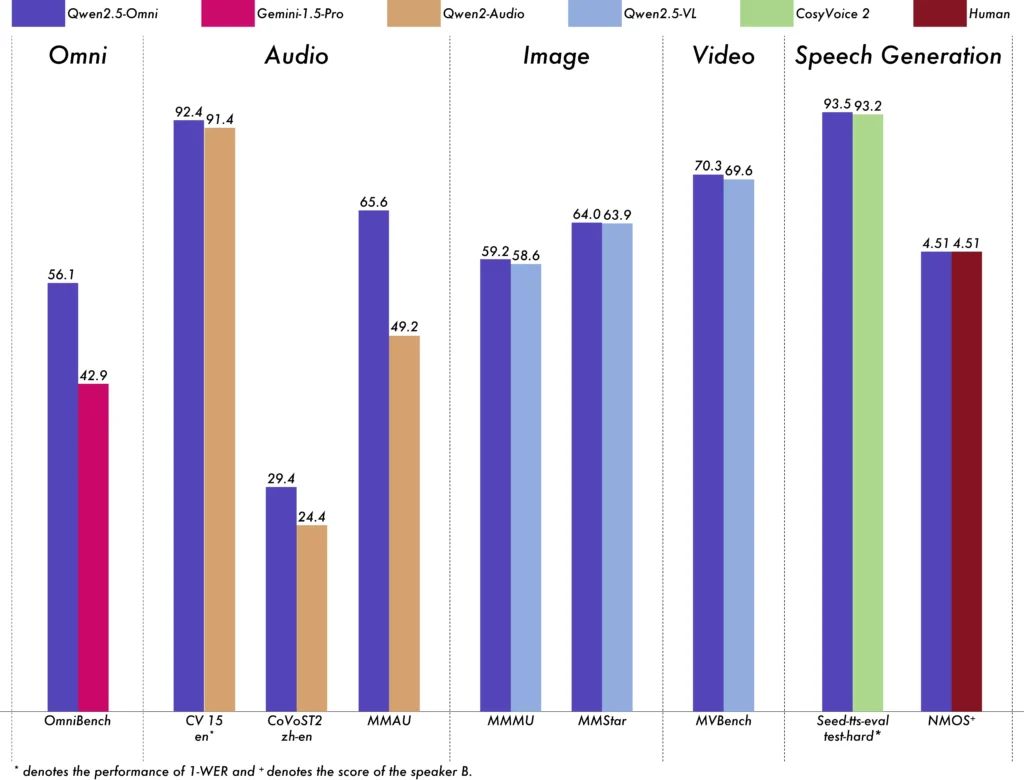

Qwen2.5-Omni-7B har vist eksepsjonell ytelse på tvers av ulike standarder:

- OmniBench: Oppnådde en gjennomsnittlig poengsum på 56.13 %, og overgikk modeller som Gemini-1.5-Pro (42.91 %) og MIO-Instruct (33.80 %).

- Talegjenkjenning: På Librispeech-datasettet oppnådde det Word-feilrater fra 1.6 % til 3.5 %, sammenlignet med spesialiserte modeller som Whisper-large-v3.

- Lydhendelsesgjenkjenning: Sikret en poengsum på 0.570 på Meld-datasettet, og satte en ny benchmark i feltet.

- Musikkforståelse: Oppnådde en poengsum på 0.88 på GiantSteps Tempo-benchmark, noe som fremhever dens ferdigheter i musikkforståelse.

Sanntidsbehandlingsevner

Qwen2.5-Omni-7B er designet for sanntidsapplikasjoner og støtter blokk-for-blokk-streaming, noe som muliggjør umiddelbar lydgenerering med minimal latenstid. Denne funksjonen er spesielt gunstig for applikasjoner som krever raske svar, for eksempel virtuelle assistenter og interaktive AI-systemer.

Tekniske spesifikasjoner

Arkitektonisk design

- Thinker-Talker Framework: 'Tenker'-komponenten behandler og forstår multimodale input, og genererer semantiske representasjoner på høyt nivå og tekstutdata. 'Talker' konverterer disse representasjonene til naturlig, flytende tale, og sikrer sømløs kommunikasjon mellom AI-systemet og brukerne.

- TMRoPE-mekanisme: Løser utfordringen med å synkronisere tidsdata fra ulike kilder ved å samkjøre tidsstempler for video- og lydinnganger, og tilrettelegge for sammenhengende multimodal forståelse.

Opplæringsmetodikk

Modellen gjennomgikk en trefaset opplæringsprosess:

- Fase ett: Faste språkmodellparametere mens du trener visuelle og lydkodere ved å bruke omfattende lyd-tekst- og bilde-tekst-par for å forbedre multimodal forståelse.

- Fase to: Frigjør alle parametere og trent på et mangfoldig datasett som består av bilde, video, lyd og tekst, og forbedrer den omfattende multimodale forståelsen ytterligere.

- Fase tre: Fokusert på datatrening i lang sekvens for å styrke modellens kapasitet til å håndtere komplekse, utvidede input.

Utviklingen av Qwen-modeller

Progresjon fra Qwen til Qwen2.5

Utviklingen fra Qwen til Qwen2.5 betyr et betydelig sprang i utviklingen av AI-modeller:

- Forbedrede parametere: Qwen2.5 utvidet til modeller med opptil 72 milliarder parametere, og tilbyr skalerbare løsninger for ulike applikasjoner.

- Utvidet kontekstbehandling: Introduserte muligheten til å behandle opptil 128,000 XNUMX tokens, noe som letter håndteringen av omfattende dokumenter og komplekse samtaler.

- Kodefunksjoner: Qwen2.5-Coder-varianten støtter over 92 programmeringsspråk, og hjelper til med kodegenerering, feilsøking og optimaliseringsoppgaver.

Fordeler med Qwen2.5-Omni-7B

Omfattende multimodal integrasjon

Ved å effektivt behandle tekst, bilder, lyd og video, gir Qwen2.5-Omni-7B en helhetlig AI-løsning som passer for et bredt spekter av bruksområder.

Samhandling i sanntid

Behandlingen med lav ventetid sikrer umiddelbare svar, og forbedrer brukeropplevelsen i interaktive applikasjoner.

Tilgjengelighet med åpen kildekode

Som en åpen kildekode-modell fremmer Qwen2.5-Omni-7B åpenhet og lar utviklere tilpasse og integrere modellen i ulike plattformer uten proprietære begrensninger.

tekniske indikatorer

- Modellparametere: 7 milliarder

- Inndatamodaliteter: Tekst, bilde, lyd, video

- Utdatamodaliteter: Tekst, tale

- Behandlingsevne: Samhandling med tale og video i sanntid

- Ytelsesreferanser:

- OmniBench: 56.13 % gjennomsnittlig poengsum

- Librispeech (ordfeilfrekvens): Test-ren: 1.8 %, Test-annet: 3.4 %

Applikasjonsscenarier

Interaktive virtuelle assistenter

Qwen2.5-Omni-7Bs sanntidsbehandling og multimodale forståelse gjør den ideell for virtuelle assistenter som kan se, høre og svare naturlig.

Oppretting av multimediainnhold

Innholdsskapere kan utnytte modellen til å generere engasjerende multimedieinnhold, og kombinere tekst, bilder og lyd sømløst.

Hjelpemidler

Modellens muligheter kan hjelpe personer med funksjonshemminger, for eksempel å tilby beskrivende lyd for visuelt innhold.

Brukstips

Optimalisering av ytelse

For å oppnå optimal ytelse, spesielt i sanntidsapplikasjoner, anbefales det å bruke maskinvareakseleratorer og sikre tilstrekkelig GPU-minne.

Integrasjon med eksisterende systemer

Utviklere bør vurdere modellens input- og utdataformater når de integreres med eksisterende applikasjoner for å sikre kompatibilitet og maksimere effektiviteten.

Holder seg oppdatert

Sjekk de offisielle depotene og dokumentasjonen regelmessig for oppdateringer og beste praksis for å utnytte funksjonene til Qwen2.5-Omni-7B fullt ut.

Beslektede emner Hvordan kjøre Qwen2.5-Omni-7B-modellen

Konklusjon

Qwen2.5-Omni-7B eksemplifiserer konvergensen av avansert AI-forskning og praktisk anvendelse, og tilbyr en allsidig og effektiv løsning for en rekke oppgaver på tvers av ulike bransjer. Dens åpen kildekode sikrer at den forblir tilgjengelig og tilpasningsdyktig, og baner vei for fremtidige innovasjoner innen multimodal AI.

Hvordan ringe Qwen2.5-Omni-7B API fra CometAPI

1.Logg inn til cometapi.com. Hvis du ikke er vår bruker ennå, vennligst registrer deg først

2.Få tilgangslegitimasjons-API-nøkkelen av grensesnittet. Klikk "Legg til token" ved API-tokenet i det personlige senteret, hent tokennøkkelen: sk-xxxxx og send inn.

-

Få nettadressen til dette nettstedet: https://api.cometapi.com/

-

Velg Qwen2.5-Omni-7B-endepunktet for å sende API-forespørselen og angi forespørselsteksten. Forespørselsmetoden og forespørselsinstansen hentes fra vår nettside API-dok. Vår nettside tilbyr også Apifox-test for enkelhets skyld.

-

Behandle API-svaret for å få det genererte svaret. Etter å ha sendt API-forespørselen, vil du motta et JSON-objekt som inneholder den genererte fullføringen.