DeepSeek har gitt ut DeepSeek V3.2 som etterfølgeren til V3.x-linjen og en tilhørende DeepSeek-V3.2-Spesial variant som selskapet posisjonerer som en høytytende, resonneringsførsteutgave for agent-/verktøybruk. V3.2 bygger på eksperimentelt arbeid (V3.2-Exp) og introduserer høyere resonneringskapasitet, en Speciale-utgave optimalisert for "gullnivå" matematikk/konkurransedyktig programmeringsytelse, og det DeepSeek beskriver som et førsteklasses "tenkning + verktøy"-system med to moduser som tett integrerer intern trinnvis resonnering med ekstern verktøypåkalling og agentarbeidsflyter.

Hva er DeepSeek V3.2 – og hvordan er V3.2-Speciale forskjellig?

DeepSeek-V3.2 er den offisielle etterfølgeren til DeepSeeks eksperimentelle V3.2-Exp-gren. Den beskrives av DeepSeek som en «Resonering først»-modellfamilie bygget for agenter, dvs. modeller som ikke bare er innstilt for naturlig samtalekvalitet, men spesifikt for flertrinnsslutning, verktøypåkalling og pålitelig tankekjede-resonnement når de opererer i miljøer som inkluderer eksterne verktøy (API-er, kodekjøring, datakoblinger).

Hva er DeepSeek-V3.2 (basis)

- Posisjonert som den vanlige produksjonsfølgeren til den eksperimentelle V3.2-Exp-linjen; beregnet for bred tilgjengelighet via DeepSeeks app/web/API.

- Opprettholder en balanse mellom beregningseffektivitet og robust resonnement for agentoppgaver.

Hva er DeepSeek-V3.2-Speciale

DeepSeek-V3.2-Spesial er en variant som DeepSeek markedsfører som en «spesialutgave» med høyere kapasitet, finjustert for resonnement på konkurransenivå, avansert matematikk og agentytelse. Markedsføres som en variant med høyere kapasitet som «flytter grensene for resonnementsmuligheter». DeepSeek eksponerer for tiden Speciale som en API-kun-modell med midlertidig tilgangsruting; tidlige benchmarks antyder at den er posisjonert til å konkurrere med avanserte lukkede modeller innen resonnement- og kodebenchmarks.

Hvilke avstamnings- og ingeniørvalg førte til V3.2?

V3.2 arver en rekke iterative ingeniører som DeepSeek publiserte i 2025: V3 → V3.1 (Terminus) → V3.2-Exp (et eksperimentelt trinn) → V3.2 → V3.2-Speciale. Den eksperimentelle V3.2-Exp ble introdusert. DeepSeek Sparse Attention (DSA) — en finmasket mekanisme for sparsom oppmerksomhet som har som mål å senke minne- og beregningskostnader for svært lange kontekstlengder, samtidig som utskriftskvaliteten bevares. Denne DSA-forskningen og arbeidet med kostnadsreduksjoner fungerte som et teknisk springbrett for den offisielle V3.2-familien.

Hva er nytt i offisiell DeepSeek 3.2?

1) Forbedret resonneringsevne – hvordan forbedres resonnement?

DeepSeek markedsfører V3.2 som «Resonering først». Det betyr at arkitekturen og finjusteringen fokuserer på å utføre flertrinnsslutninger på en pålitelig måte, opprettholde interne tankekjeder og støtte den typen strukturerte overveielser agenter trenger for å bruke eksterne verktøy riktig.

Konkret inkluderer forbedringene:

- Trening og RLHF (eller lignende justeringsprosedyrer) justert for å oppmuntre til eksplisitt trinnvis problemløsning og stabile mellomtilstander (nyttig for matematisk resonnement, flertrinns kodegenerering og logiske oppgaver).

- Arkitektoniske og tapsfunksjonsvalg som bevarer lengre kontekstvinduer og lar modellen referere til tidligere resonneringstrinn med troskap.

- Praktiske moduser (se «dobbeltmodus» nedenfor) som lar den samme modellen operere enten i en raskere «chattemodus» eller i en deliberativ «tenkemodus» der den bevisst jobber seg gjennom mellomtrinn før den handler.

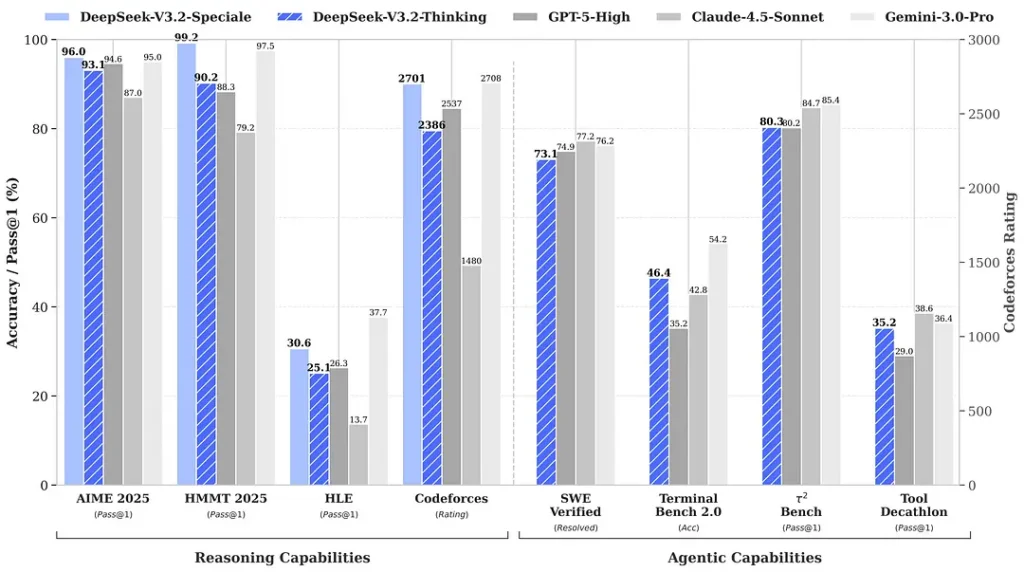

Referansetester som er sitert rundt utgivelsen hevder bemerkelsesverdige forbedringer i matematikk- og resonneringssett; uavhengige tidlige fellesskapsreferansetester rapporterer også imponerende poengsummer på konkurrerende evalueringssett:

2) Gjennombruddsytelse i spesialutgaven – hvor mye bedre?

DeepSeek-V3.2-Spesial hevdes å gi et steg opp i resonneringsnøyaktighet og agentorkestrering sammenlignet med standard V3.2. Leverandøren rammer inn Speciale som et ytelsesnivå rettet mot tunge resonneringsbelastninger og utfordrende agentoppgaver; det er for øyeblikket kun API-basert og tilbys som et midlertidig endepunkt med høyere kapasitet (DeepSeek indikerte at Speciale-tilgjengeligheten vil være begrenset i starten). Speciale-versjonen integrerer den tidligere matematiske modellen DeepSeek-Math-V2; Den kan bevise matematiske teoremer og verifisere logisk resonnement på egenhånd; Den har oppnådd bemerkelsesverdige resultater i flere konkurranser i verdensklasse:

- 🥇 IMO (Internasjonal matematikkolympiad) gullmedalje

- 🥇 CMO (kinesisk matematikkolympiade) gullmedalje

- 🥈 ICPC (Internasjonal dataprogrammeringskonkurranse) Andreplass (Menneskekonkurranse)

- 🥉 IOI (Internasjonal olympiade i informatikk) Tiendeplass (Menneskelig konkurranse)

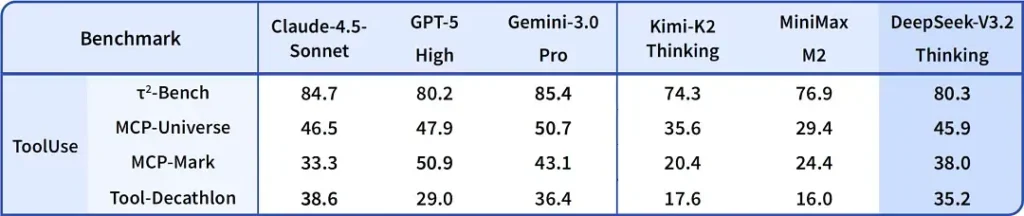

| benchmark | GPT-5 Høy | Gemini-3.0 Pro | Kimi-K2 Tenkning | DeepSeek-V3.2 Tenkning | DeepSeek-V3.2 Spesial |

|---|---|---|---|---|---|

| TID 2025 | 94.6 (13 000) | 95.0 (15 000) | 94.5 (24 000) | 93.1 (16 000) | 96.0 (23 000) |

| HMMT februar 2025 | 88.3 (16 000) | 97.5 (16 000) | 89.4 (31 000) | 92.5 (19 000) | 99.2 (27 000) |

| HMMT november 2025 | 89.2 (20 000) | 93.3 (15 000) | 89.2 (29 000) | 90.2 (18 000) | 94.4 (25 000) |

| IMOAnswerBench | 76.0 (31 000) | 83.3 (18 000) | 78.6 (37 000) | 78.3 (27 000) | 84.5 (45 000) |

| LiveCodeBench | 84.5 (13 000) | 90.7 (13 000) | 82.6 (29 000) | 83.3 (16 000) | 88.7 (27 000) |

| CodeForces | 2537 (29 000) | 2708 (22 000) | - | 2386 (42 000) | 2701 (77 000) |

| GPQA diamant | 85.7 (8 000) | 91.9 (8 000) | 84.5 (12 000) | 82.4 (7 000) | 85.7 (16 000) |

| HLE | 26.3 (15 000) | 37.7 (15 000) | 23.9 (24 000) | 25.1 (21 000) | 30.6 (35 000) |

3) Første implementering noensinne av et tomodussystem med «tenkning + verktøy»

En av de mest praktisk interessante påstandene i V3.2 er en arbeidsflyt med to moduser som skiller (og lar deg velge mellom) rask samtaleoperasjon og en langsommere, deliberativ «tenkemodus» som integreres tett med verktøybruk.

- «Chat / rask»-modus: Utviklet for brukerrettet chat med lav latens, konsise svar og færre interne resonnementsspor – bra for uformell hjelp, korte spørsmål og svar og hastighetssensitive applikasjoner.

- «Tenke-/resonneringsmodus»: Optimalisert for grundig tankekjede, trinnvis planlegging og orkestrering av eksterne verktøy (API-er, databasespørringer, kodekjøring). Når modellen opererer i tenkemodus, produserer den mer eksplisitte mellomtrinn, som kan inspiseres eller brukes til å kjøre sikre, korrekte verktøykall i agentsystemer.

Dette mønsteret (en tomodusdesign) var tilstede i tidligere eksperimentelle grener, og DeepSeek har integrert det dypere i V3.2 og Speciale – Speciale støtter for tiden utelukkende tenkemodusen (derav API-gating). Muligheten til å veksle mellom hastighet og overveielse er verdifull for ingeniørfag fordi den lar utviklere velge riktig avveining for latens kontra pålitelighet når de bygger agenter som må samhandle med virkelige systemer.

Hvorfor det er bemerkelsesverdig: Mange moderne systemer tilbyr enten en sterk tankekjedemodell (for å forklare resonnement) eller et separat agent/verktøy-orkestreringslag. DeepSeeks innramming antyder en tettere kobling – modellen kan «tenke» og deretter deterministisk kalle verktøy, ved å bruke verktøyresponser for å informere påfølgende tenkning – noe som er mer sømløst for utviklere som bygger autonome agenter.

Hvor å komme seg DeepSeek v3.2

Kort svar – du kan få DeepSeek v3.2 på flere måter, avhengig av hva du trenger:

- Offisiell nett/app (bruk på nett) – prøv DeepSeek-nettgrensesnittet eller mobilappen for å bruke V3.2 interaktivt.

- API-tilgang — DeepSeek eksponerer V3.2 gjennom API-et sitt (dokumentasjonen inkluderer modellnavn / base_url og priser). Registrer deg for en API-nøkkel og kall opp v3.2-endepunktet.

- Nedlastbare/åpne vekter (Klemfjes) — modellen (V3.2 / V3.2-Exp-varianter) er publisert på Hugging Face og kan lastes ned (åpen vekt). Bruk

huggingface-hubortransformerså hente filene. - CometAPI — En AI API-aggregeringsplattform tilbyr vertsbaserte endepunkter V3.2-Exp. Prisen er billigere enn den offisielle prisen.

Et par praktiske merknader:

- Hvis du ønsker vekter som skal kjøres lokalt, gå til siden for klemmende ansikt-modell (godta eventuelle lisens-/tilgangsvilkår der) og bruk

huggingface-cliortransformerså laste ned; GitHub-repoet viser vanligvis de nøyaktige kommandoene. - Hvis du ønsker produksjonsbruk via API, følg den ønskede plattformen, for eksempel cometapi API-dokumentasjon for endepunktnavn og riktig

base_urlfor V3.2-varianten.

DeepSeek-V3.2-Spesialer:

- Kun åpen for forskningsbruk, støtter dialogen «Tenkemodus», men støtter ikke verktøykall.

- Maksimal utgang kan nå 128 000 tokens (ultralang tenkekjede).

- For øyeblikket gratis å teste frem til 15. desember 2025.

Avsluttende tanker

DeepSeek-V3.2 representerer et meningsfullt skritt i modningen av resonnementssentriske modeller. Kombinasjonen av forbedret flertrinnsresonnement, spesialiserte høyytelsesutgaver (Speciale) og en produksjonsbasert «tenkning + verktøy»-integrasjon er verdt å merke seg for alle som bygger avanserte agenter, kodeassistenter eller forskningsarbeidsflyter som må flette overveielse sammen med eksterne handlinger.

Utviklere kan få tilgang til DeepSeek V3.2 gjennom CometAPI. For å begynne, utforsk modellmulighetene til CometAPI i lekeplass og konsulter API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. cometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Klar til å dra? → Registrer deg for CometAPI i dag !

Hvis du vil vite flere tips, guider og nyheter om AI, følg oss på VK, X og Discord!