Gemini 3 Dyp Tenk er en ny, spesialisert resonneringsmodus i Google / DeepMinds nyeste grunnleggende modellfamilie – Gemini 3 – designet for å ta mer tid og intern «overveielse» av vanskelige, flertrinns, multimodale problemer. Den markedsføres som versjonen av Gemini som driver toppmoderne resonnering og agentisk problemløsning lenger enn tidligere utgivelser.

Hva er egentlig Gemini 3 Deep Think?

Definisjon og posisjonering

Gemini 3 Deep Think er ikke en separat modellfamilie i den forstand at det er en helt annen nevral nettverksarkitektur utgitt uavhengig – det er en forbedret resonneringsmodus innenfor Gemini 3-serien som Google beskriver som «å flytte grensene for intelligens enda lenger». Deep Think presenteres eksplisitt som modusen du velger når du trenger modellen til å forfølge dypere tankekjeder, vurdere flere hypoteser og evaluere alternativer før du svarer – slik at systemet effektivt kan bytte latens mot høyere kvalitet og mer deliberative resultater. Google posisjonerer Deep Think som utgaven som er innstilt for de mest komplekse, nye og flertrinns resonneringsoppgavene (og er i utgangspunktet begrenset til sikkerhetstesting og Google AI Ultra-abonnenter).

Hvor Deep Think skiller seg fra standard Gemini 3 Pro

Konseptuelt sett sikter Gemini 3 Pro mot en balansert opplevelse med lav latens, egnet for generell agentbruk og integrering med utviklere (f.eks. de nye integrasjonene Antigravity IDE og Vertex AI). Deep Think er den samme familien, men konfigurert til å:

- Resonnering - først avkoding og internalisering av tankekjeden. Google beskriver Gemini 3 som en modell som bruker en forbedret intern «tenkningsprosess» som lar modellen utføre flertrinnsplanlegging og intern overveielse mer pålitelig. Deep Think ser ut til å intensivere denne prosessen – ved å allokere mer intern beregning, lengre interne overveielseskjeder og strengere verifiseringsheuristikker under generering. Disse endringene tar sikte på å redusere sprø enkelttrinnsresponser og forbedre problemløsningen for nye oppgaver.

- Større inferenskonvolutt (verktøy + simulering). Deep Think er optimalisert for å bruke verktøysimuleringer (simulerte nettlesere, kalkulatorer, kodekjørere eller eksterne API-er) på en måte som behandler den agentiske arbeidsflyten som en del av modellens resonneringsløkke. Det betyr at modellen kan planlegge, formulere hypoteser, teste (via simulerte verktøy) og revidere – en form for intern eksperimentering som er til fordel for komplekse koding-, matematikk- eller forskningsspørsmål.

- Avveining mellom høyere beregnings-/forsinkelseshastighet. For å få denne dypere begrunnelsen, opererer Deep Think i et inferensregime med høyere kostnader og høyere latens enn Pro. Google har historisk sett tilbudt slike avveininger med premium «ekspert»-moduser i modellene sine; Deep Think følger dette mønsteret ved å prioritere kvalitet og pålitelighet.

Hvordan fungerer Gemini 3 Deep Think?

Å forstå «hvordan» krever at man skiller produktmodus (Deep Think) fra den underliggende modellfamilien (Gemini 3). Deep Think er ikke en separat, frittstående modellfil du laster ned; snarere er det en konfigurasjon – et trent kapasitetslag og en inferensstabel – som låser opp mer beregning, interne resonneringsrutiner og spesialiserte dekodingsatferder for å prioritere dybde og korrekthet fremfor latens eller kostnad.

Tettere verktøyintegrasjon

Deep Think bruker de samme agentiske verktøykall- og sandboksprimitivene som Gemini 3 Pro, men med mer konservative retningslinjer og ekstra verifiseringstrinn for hvert verktøykall (viktig for sikkerheten i forskningsarbeidsflyter).

Avveininger i dyp tenkning og inferensstrategi

Deep Think beskrives eksplisitt som handel ventetid forum dybdeDen kjører mer beregning per spørring (lengre intern overveielse eller mer grundig søk i kandidatens resonnementsveier) og benytter seg av hjelpemekanismer som selektiv kodekjøring eller flertrinnsverifisering for å løse nye problemer. Det gjør den sterkere på "grense"-benchmarks (nye, kreative eller flertrinnsproblemer), men potensielt tregere og dyrere i produksjon.

Tankekjede, kladdeblokker og iterativ forbedring

Deep Think-tilnærmingen er avhengig av mekanismer som forskningsmiljøet og bedrifter har brukt med hell: tankekjede-resonnement, interne notater og trinnvis resonnement der delproblemer løses og valideres før integrering. Modellen bruker metoder for å dekomponere problemer, sjekke mellomtrinn og sette sammen løsninger til robuste endelige resultater.

Hvilke ytelsesstandarder oppnår Gemini 3 Deep Think?

Google har publisert en rekke referansetall som illustrerer omfanget av gevinstene som hevdes for Gemini 3 – og spesielt Deep Think-konfigurasjonen. De sterkeste offentlige påstandene om Gemini 3 Deep Think er:

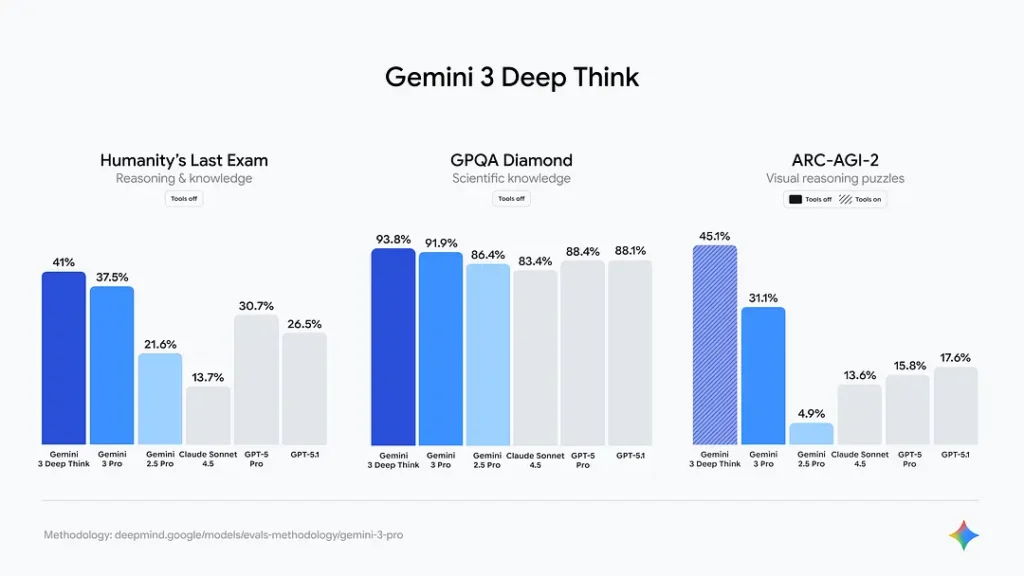

- ARC-AGI (abstrakt visuell resonnement, kodeutførelsesvarianter): Gemini 3 Pro oppnår angivelig ~31.1 % mens Gemini 3 Deep Think når ~45.1% på ARC-AGI-2 – et dramatisk sprang på en referanseindeks som tidligere unngikk høy ytelse.

- GPQA Diamond (avansert spørsmålsbesvarelse): Gemini 3 Pro ble rapportert til rundt ~91.9 %, mens Deep Think scoret ~93.8 % i publiserte omganger. Dette er høye ytelsesnivåer som plasserer Gemini 3 på eller nær toppen av flere resultatlister ved lansering.

- Menneskehetens siste eksamen (verktøyfri utfordring): Googles materialrapport viser at Gemini 3 Deep Think oppnådde betydelig høyere verktøyfri ytelse (Google oppga et tall på ~41.0 %) og overgikk Gemini 3 Pro på de mest krevende eksamenslignende oppgavene.

Hvorfor disse tallene er viktige. Disse gevinstene ved referansepunktene er ikke ensartede på tvers av alle oppgaver: de er mest uttalte på problemer som krever flertrinnsresonnement, abstrakt visuell problemløsning og situasjoner der modellen må holde og manipulere store mengder kontekst. Dette samsvarer med den funksjonelle intensjonen bak Deep Think: å demonstrere robust resonnement av høyere orden i stedet for bare bedre overflatetekstprediksjon.

Gemini 3 Deep Think vs. Gemini 2.5 pro

Der Deep Think forbedrer seg på Gemini 2.x

Resonering og problemløsning: Den tydeligste forbedringen er i resonneringsbenchmarks og oppgaver som krever utvidede interne logikkkjeder. Vesentlig høyere poengsummer på ARC-AGI, Humanity's Last Exam og andre resonneringspakker for Gemini 3 Deep Think sammenlignet med Gemini 2.5 Pro. Dette hoppet ser ut til å være både algoritmisk (annen trening/finjustering) og operasjonelt (Deep Thinks inferens-tids-deliberasjon).

Multimodal forståelse: Gemini 3 utvider støtten for rikere multimodale inndata – videoanalyse, håndskrift + stemmefusjon og mer nyansert bilde-og-tekst-resonnement – og Deep Think forsterker denne muligheten for oppgaver som blander medietyper. Der Gemini 2.x håndterte multimodale oppgaver bra, presenteres Gemini 3 Deep Think som både mer nøyaktig og mer kontekstsensitiv.

Bruk av agenter og verktøy: Gemini 3s vekt på agentiske arbeidsflyter (å lage agenter som opererer på tvers av editorer, terminaler, nettlesere og API-kall) markerer en kvalitativ endring. Deep Think, ved å forbedre intern simulering og verktøyorkestrering, gir bedre planlegging og verifisering når man samhandler med eksterne verktøy – en funksjon som var i sin vorden i tidligere Gemini-generasjoner. Googles Antigravity IDE er en konkret tidlig integrasjon som demonstrerer dette.

Koding og utviklerergonomi: Gemini 3 Pro har allerede forbedret enkeltkoding og «vibe-koding» (spesifikasjon på høyt nivå → generering av stillasbaserte apper). Deep Think forbedrer modellens evne til å planlegge større prosjekter, generere mer sammenhengende flerfilskode og feilsøke på tvers av kontekster. Tidlig tilbakemelding fra benchmarks og partnere rapporterer klare produktivitetsøkninger for utviklere sammenlignet med 2.x.

Arkitektoniske og atferdsmessige forskjeller (H3)

De praktiske årsakene til gevinstene i forhold til Gemini 2.x er flere og gjensidig forsterkende:

- Forbedringer av MoE-ryggraden og ekspertrutingjustering, noe som muliggjør mer effektiv spesialisering og skalering.

- Enhetlig multimodal stabel som bedre smelter sammen kryssmodal resonnement (viktig for ARC-AGIs visuelle delproblemer).

- Driftsmoduser som Deep Think som bevisst utvider intern overveielse og hypotesetesting, og bytter ut beregning/latens for nøyaktighet.

Praktiske resultater for brukerne

For utviklere og forskere betyr det:

- Forbedret kapasitet til å automatisere arbeidsflyter med høyere verdi (f.eks. syntese av vitenskapelig litteratur, arkitekturdesign, avansert feilsøking) som tidligere Gemini-generasjoner hadde begrenset suksess med.

- Færre hallusinasjoner og mer forsvarlige trinnvise resonnementskjeder basert på komplekse spørsmål.

- Bedre ytelse når oppgaver krever resonnement på tvers av lange dokumenter, kodebaser eller blandede medier.

Slik får du tilgang til Gemini 3 Deep Think

Alternativ A – Forbruker-/avanserte brukerruter: Gemini-appen + Google AI

Ifølge den offisielle kunngjøringen fra Google er Gemini 3 Deep Think ikke bredt tilgjengelig ennå i den generelle utgivelsesnivået. Den rulles først ut til sikkerhetstestere, deretter til abonnementsnivået «Ultra».

Google AI Ultra: US $ 249.99/måned (i USA) for Ultra-nivået, som inkluderer «Deep Think, Gemini Agent (kun USA, kun engelsk) og høyeste grenser».

Hvor du kan abonnere: Abonner via Gemini-appen / Google One / Google AI-abonnementssiden for din region. Abonnementskonsollen viser om Deep Think allerede er aktivert for kontoen din.

Alternativ B – Utvikler-/bedriftsrute: API

For utviklere som ønsker API-tilgang: Gemini 3 API er allerede tilgjengelig for «Pro» i forhåndsvisning. Hvis du trenger å bruke «Deep think»-versjonen, bruk API-varianten. API-tilgang betales per bruk og faktureres per million input-/output-tokens.

Gode nyheter — CometAPI har nå integrert Gemini 3 Pro forhåndsvisnings-API, og du kan også få tilgang til den nyeste ChatGPT 5.1. API-prisen er billigere enn den offisielle prisen:

| Modell | gemini-3-pro-preview | gemini-3-pro-preview-thinking |

| Skriv inn tokens | $1.60 | $1.60 |

| Output tokens | $9.60 | $9.60 |

Klar til å dra? → Registrer deg for CometAPI i dag !

Hvis du vil vite flere tips, guider og nyheter om AI, følg oss på VK, X og Discord!

Konklusjon

Gemini 3 Deep Think representerer et bevisst og pragmatisk forsøk på å produktifisere dypere maskinell resonnering: ideen om at noen oppgaver drar nytte av intern, trinnvis overveielse og integrert verktøybruk i stedet for enkeltstående svar.