I den raskt utviklende verdenen av kunstig intelligens representerer utgivelsen av hver nye store språkmodell (LLM) mer enn en numerisk versjonsløft – den signaliserer fremgang innen resonnering, kodeevne og samarbeid mellom menneske og maskin. Sent i september 2025, Zhipu AI (Z.ai) avduket GLM-4.6, det nyeste medlemmet av General Language Model-familien. Byggende på den robuste arkitekturen og det sterke resonnementsfundamentet i GLM-4.5, forbedrer denne oppdateringen modellens funksjoner i agentisk resonnering, kodeintelligens og forståelse av lang kontekst, samtidig som den forblir åpen og tilgjengelig for både utviklere og bedrifter.

Hva er GLM-4.6?

GLM-4.6 er en større utgivelse i GLM-serien (General Language Model), som er utviklet for å balansere resonnement med høy kapasitet med praktiske arbeidsflyter for utviklere. På et overordnet nivå retter utgivelsen seg mot tre tett beslektede brukstilfeller: (1) avansert kodegenerering og resonnement om kode, (2) oppgaver med utvidet kontekst som krever modellforståelse på tvers av svært lange input, og (3) agentiske arbeidsflyter der modellen må planlegge, kalle verktøy og orkestrere flertrinnsprosesser. Modellen leveres i varianter beregnet for sky-API-er og fellesskapsmodellhuber, noe som muliggjør både vertsbaserte og selvhostede distribusjonsmønstre.

I praksis er GLM-4.6 posisjonert som et flaggskip som fokuserer på «utviklere først»: forbedringene handler ikke bare om rå referansetall, men også om funksjoner som vesentlig endrer hvordan utviklere bygger assistenter, kodepiloter og dokument- eller kunnskapsdrevne agenter. Forvent en utgivelse som legger vekt på instruksjonsjustering for verktøybruk, finjusterte forbedringer for kodekvalitet og feilsøking, og infrastrukturvalg som muliggjør svært lange kontekster uten lineær degenerasjon i ytelse.

Hva har GLM-4.6 som mål å løse?

- Reduser friksjonen ved å jobbe med lange kodebaser og store dokumenter ved å støtte lengre effektive kontekstvinduer.

- Forbedre påliteligheten til kodegenerering og feilsøking, og produsere mer idiomatiske, testbare resultater.

- Øk robustheten til agentisk atferd – planlegging, verktøybruk og utførelse av oppgaver i flere trinn – gjennom målrettet instruksjon og justering av forsterkningsstil.

Fra GLM-4.5 til GLM-4.6, hva endret seg i praksis?

- Kontekstskalering: 128 000 hopp til 200 XNUMX tokens er den største enkeltstående endringen i UX/arkitektur for brukere: lange dokumenter, hele kodebaser eller utvidede agenttranskripter kan nå behandles som ett enkelt kontekstvindu. Dette reduserer behovet for ad hoc-chunking eller dyre henteløkker for mange arbeidsflyter.

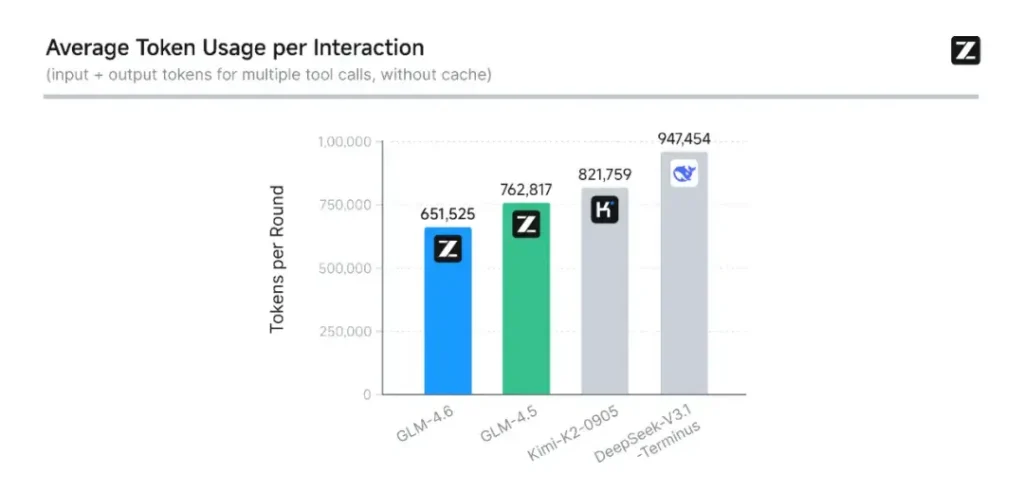

- Koding og evaluering i den virkelige verden: Z.ai utvidet CC-Bench (deres referansepunkt for koding og fullføring) med vanskeligere, reelle oppgavebaner og rapporterer at GLM-4.6 fullfører oppgaver med ~15 % færre tokens enn GLM-4.5, samtidig som suksessratene i komplekse flerturn-ingeniøroppgaver forbedres. Dette signaliserer bedre tokeneffektivitet samt forbedringer av råkapasitet i anvendte kodescenarier. Z.ai

- Agent- og verktøyintegrasjon: GLM-4.6 inkluderer bedre støttemønstre for verktøykall og søkeagenter – viktig for produkter som er avhengige av modellen for å orkestrere nettsøk, kodekjøring eller andre mikrotjenester.

Hva er hovedfunksjonene til GLM-4.6?

1. Utvidet kontekstvindu til 200 000 tokens

En av de mest oppsiktsvekkende funksjonene ved GLM-4.6 er dens massivt utvidet kontekstvinduUtvidelse fra 128 000 i forrige generasjon til 200 XNUMX tokens, GLM-4.6 kan behandle hele bøker, komplekse datasett med flere dokumenter eller timevis med dialog i én økt. Denne utvidelsen forbedrer ikke bare forståelsen, men muliggjør også konsistent resonnement over lange innspill – et stort sprang for arbeidsflyter innen dokumentoppsummering, juridisk analyse og programvareutvikling.

2. Forbedret kodeintelligens

Zhipu AIs interne CC-benk benchmark, en serie med programmeringsoppgaver fra den virkelige verden, viser at GLM-4.6 oppnår merkbare forbedringer i kodingens nøyaktighet og effektivitetModellen kan produsere syntaktisk korrekt og logisk forsvarlig kode ved bruk av omtrent 15 % færre tokens enn GLM-4.5 for tilsvarende oppgaver. Denne tokeneffektiviteten betyr raskere og billigere fullføringer uten at det går på bekostning av kvaliteten – en viktig faktor for bedriftsdistribusjon.

3. Avansert resonnering og verktøyintegrasjon

Utover generering av rå tekst, skinner GLM-4.6 inn verktøyutvidet resonnementDen har blitt trent og justert for flertrinnsplanlegging og for å orkestrere eksterne systemer – fra databaser til søkeverktøy til utførelsesmiljøer. I praksis betyr dette at GLM-4.6 kan fungere som «hjernen» til en autonom AI-agent, bestemme når eksterne API-er skal kalles, hvordan resultater skal tolkes og hvordan oppgavekontinuitet skal opprettholdes på tvers av økter.

4. Forbedret justering av naturlig språk

Gjennom kontinuerlig forsterkningslæring og preferanseoptimalisering leverer GLM-4.6 jevnere samtaleflyt, bedre stiltilpasning og sterkere sikkerhetstilpasningModellen tilpasser tone og struktur til konteksten – enten det er formell dokumentasjon, pedagogisk veiledning eller kreativ skriving – noe som forbedrer brukertilliten og lesbarheten.

Hvilken arkitektur driver GLM-4.6?

Er GLM-4.6 en blanding av eksperter-modell?

Kontinuitet i inferensmetode: GLM-teamet indikerer at GLM-4.5 og GLM-4.6 deler den samme grunnleggende inferensprosessen, noe som gjør at eksisterende distribusjonsoppsett kan oppgraderes med minimal friksjon. Dette reduserer driftsrisikoen for team som allerede bruker GLM-4.x. – skaleringsparametere og modelldesignvalg som vektlegger spesialisering for agentisk resonnering, koding og effektiv inferens. GLM-4.5-rapporten gir den klareste offentlige beskrivelsen av familiens MoE-strategi og treningsregime (flertrinns forhåndstrening, ekspertmodelliterasjon, forsterkningslæring for justering); GLM-4.6 anvender disse lærdommene samtidig som den justerer kontekstlengde og oppgavespesifikke funksjoner.

Praktiske arkitekturnotater for ingeniører

- Parameteravtrykk vs. aktivert beregning: Store parametertotaler (hundrevis av milliarder) oversettes ikke direkte til tilsvarende aktiveringskostnad på hver forespørsel – MoE betyr at bare et delsett av eksperter aktiveres per tokensekvens, noe som gir en gunstigere avveining mellom kostnad og gjennomstrømning for mange arbeidsbelastninger.

- Tokenpresisjon og formater: De offentlige vektene er distribuert i BF16- og F32-formater, og fellesskapskvantiseringer (GGUF, 4-/8-/bits) dukker opp raskt; disse lar team kjøre GLM-4.6 på varierte maskinvareprofiler.

- Kompatibilitet med inferensstabel: Z.ai dokumenterer vLLM og andre moderne LLM-kjøretider som kompatible inferens-backends, noe som gjør GLM-4.6 mulig for både sky- og lokale distribusjoner.

Referanseytelse: hvordan presterer GLM-4.6?

Hvilke referansepunkter ble rapportert?

Z.ai evaluerte GLM-4.6 på tvers av en serie med åtte offentlige referansepunkter som spenner over agentoppgaver, resonnement og koding. De utvidet også CC-Bench (en menneskelig evaluert, reell oppgavekodingsbenchmark som kjøres i Docker-isolerte miljøer) for å bedre simulere produksjonstekniske oppgaver (frontend-utvikling, testing, algoritmisk problemløsning). På disse oppgavene viste GLM-4.6 konsistente forbedringer i forhold til GLM-4.5.

Kodingsytelse

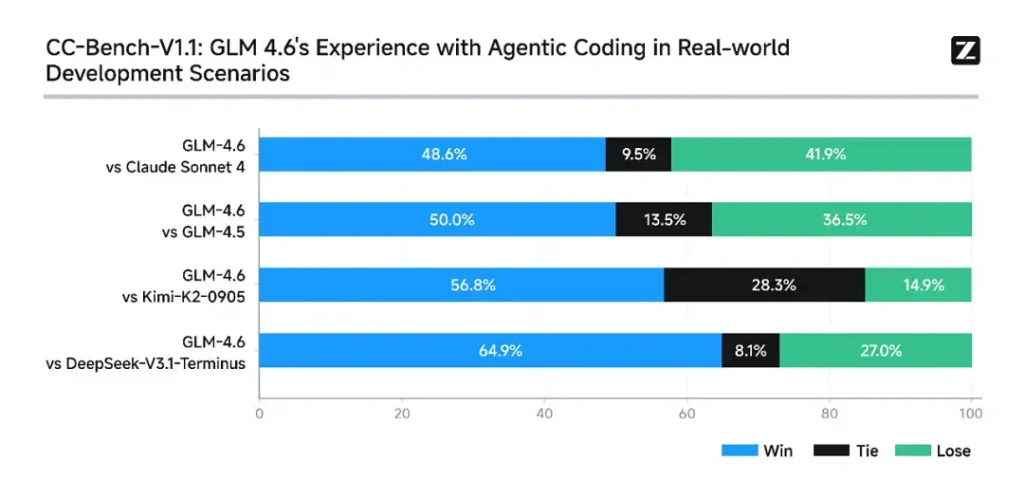

- Seire med virkelige oppgaver: I CC-Bench menneskelige evalueringer nådde GLM-4.6 nær paritet med Anthropics Claude Sonnet 4 i direkte, flertrinnsoppgaver – Z.ai rapporterer en 48.6% vinne prisen i deres Docker-isolerte, menneskebedømte evalueringer (tolkning: nær 50/50 med Claude Sonnet 4 på deres kuraterte sett). Samtidig overgikk GLM-4.6 en rekke innenlandske åpne modeller (f.eks. DeepSeek-varianter) på sine oppgaver.

- Token-effektivitet: Z.ai rapporterer ~15 % færre tokens brukes til å fullføre oppgaver sammenlignet med GLM-4.5 i CC-Bench-baner – dette har betydning for både latens og kostnad.

Resonnement og matematikk

GLM-4.6 hevder forbedret resonneringsevne og sterkere ytelse ved bruk av verktøy sammenlignet med GLM-4.5. Der GLM-4.5 vektla hybrid «tenkning» og direkte svarmoduser, øker GLM-4.6 robustheten for flertrinnsresonnement – spesielt når det integreres med søke- eller utførelsesverktøy.

Z.ais offentlige meldinger posisjonerer GLM-4.6 som konkurransedyktig med ledende internasjonale og nasjonale modeller på sine valgte referansepunkter – nærmere bestemt konkurransedyktig med Claude Sonnet 4 og bedre enn visse innenlandske alternativer som DeepSeek-varianter i kode-/agentoppgaver. Men i noen kodespesifikke delreferansepunkter ligger GLM-4.6 fortsatt bak Claude Sonnet 4.5 (en nyere Anthropic-utgivelse), noe som gjør landskapet til et landskap med tett konkurranse snarere enn direkte dominans.

Slik får du tilgang til GLM-4.6

- 1. Gjennom Z.ai-plattformen: Utviklere kan få tilgang til GLM-4.6 direkte via Z.ais API or **chat-grensesnitt (chat.z.ai)**Disse vertsbaserte tjenestene muliggjør rask eksperimentering og integrering uten lokal distribusjon. API-et støtter både standard tekstfullføring og strukturerte verktøyanropsmoduser – viktig for agentarbeidsflyter.

- 2. Åpne vekter på det klemmende ansiktet og modellskopet: For de som foretrekker lokal kontroll, har Zhipu AI gitt ut GLM-4.6 modellfiler på Klemme ansiktet og ModelScope, inkludert safetensor-versjoner i BF16 og F32 presisjon. Fellesskapsutviklere har allerede produsert kvantiserte GGUF-versjoner, noe som muliggjør inferens på GPU-er i forbrukerklassen.

- 3. Integrasjonsrammeverk: GLM-4.6 integreres problemfritt med store inferensmotorer som vLLM, SGLangog LMDeploy, noe som gjør den tilpasningsdyktig til moderne serveringsstabler. Denne allsidigheten lar bedrifter velge mellom sky, kantog distribusjon på stedet avhengig av samsvars- eller latenskrav.

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering, forenkler CometAPI dramatisk integreringen av AI-funksjoner i applikasjonene dine. Enten du bygger chatboter, bildegeneratorer, musikkomponister eller datadrevne analysepipeliner, lar CometAPI deg iterere raskere, kontrollere kostnader og forbli leverandøruavhengig – alt samtidig som du utnytter de nyeste gjennombruddene på tvers av AI-økosystemet.

Den nyeste integrasjonen GLM-4.6 vil snart dukke opp på CometAPI, så følg med! Mens vi ferdigstiller opplastingen av GLM 4.6-modellen, kan du utforske de andre modellene våre på modellsiden eller prøve dem i AI-lekeplassen.

Utviklere har tilgang GLM‑4.5 API gjennom Comet API, den nyeste modellversjonen er alltid oppdatert med den offisielle nettsiden. For å begynne, utforsk modellens muligheter i lekeplass og konsulter API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Klar til å dra? → Registrer deg for CometAPI i dag !

Konklusjon – Hvorfor GLM-4.6 er viktig nå

GLM-4.6 er en viktig milepæl i GLM-serien fordi den kombinerer praktiske forbedringer for utviklere – lengre kontekstvinduer, målrettet koding og agentoptimaliseringer, og konkrete gevinster innen referanseindeksen – med åpenheten og økosystemfleksibiliteten som mange organisasjoner ønsker. For team som bygger kodeassistenter, agenter for lange dokumenter eller verktøybaserte automatiseringer, er GLM-4.6 verdt å vurdere som en toppkandidat.