Kimi K2 representerer et betydelig sprang innen store språkmodeller med åpen kildekode, og kombinerer en toppmoderne arkitektur med en blanding av eksperter og spesialisert opplæring for agentoppgaver. Nedenfor utforsker vi dens opprinnelse, design, ytelse og praktiske hensyn for tilgang og bruk.

Hva er Kimi K2?

Kimi K2 er en språkmodell med billioner av parametere og en blanding av eksperter (MoE) utviklet av Moonshot AI. Den har 32 milliarder «aktiverte» parametere – de som er engasjert per token – og et totalt antall ekspertparametere på 1 billion, noe som muliggjør massiv kapasitet uten lineære inferenskostnader. Kimi K2, som er bygget på Muon-optimalisatoren, ble trent på over 15.5 billioner tokens, og oppnådde stabilitet i skalaer som tidligere ble ansett som upraktiske. Modellen tilbys i to hovedvarianter:

Kimi‑K2‑Instruksjon: Forhåndsinnstilt for konversasjons- og agentapplikasjoner, klar for umiddelbar distribusjon i dialogsystemer og verktøyaktiverte arbeidsflyter.

Kimi‑K2‑Base: En grunnleggende modell som er egnet for forskning, tilpasset finjustering og eksperimentering på lavt nivå.

Hvordan fungerer arkitekturen dens?

- Ekspertmiks (MoE): På hvert lag velger en portmekanisme et lite delsett av eksperter (8 av 384) for å behandle hvert token, noe som reduserer beregningsbehovet for inferens dramatisk samtidig som en massiv kunnskapsbase opprettholdes.

- Spesialiserte lag: Inneholder et enkelt tett lag sammen med totalt 61 lag, med 64 oppmerksomhetshoder og skjulte dimensjoner skreddersydd for MoE-effektivitet.

- Kontekst og ordforråd: Støtter opptil 128 160 tokener i kontekstlengde og et vokabular på XNUMX XNUMX tokener, noe som muliggjør forståelse og generering av lange formater.

Hvorfor er Kimi K2 viktig?

Kimi K2 flytter grensene for åpen kildekode-AI ved å levere ytelse på nivå med ledende proprietære modeller, spesielt innen koding og resonnement.

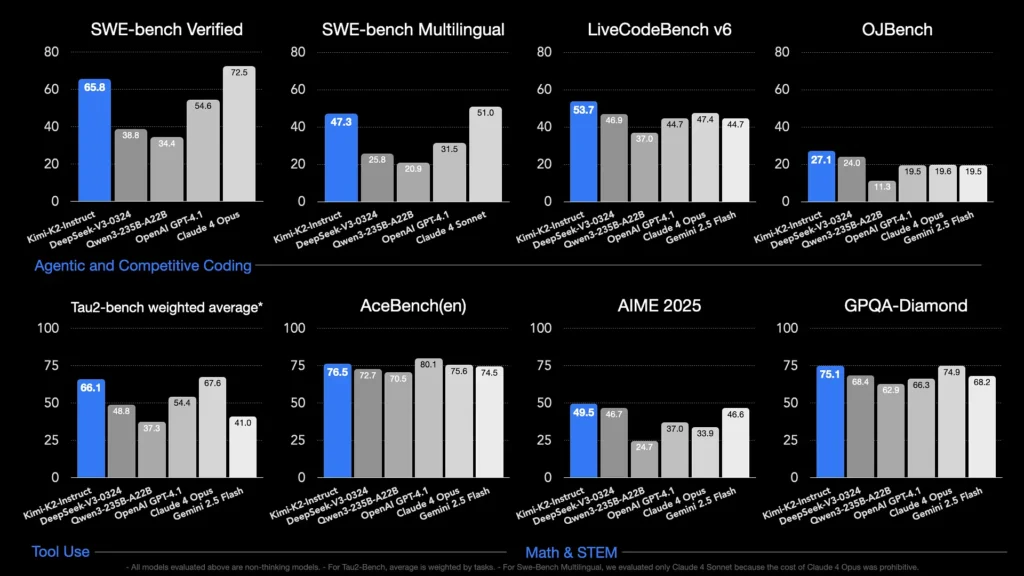

Hvilke benchmarks viser dens evner?

- LiveCodeBench v6: Oppnår en beståttprosent på 1 %, og er ledende innen åpen kildekode-modeller og konkurrerer med lukkede systemer som GPT-53.7 (4.1 %).

- SWE-benk verifisert: Scorer 65.8 %, og overgår dermed GPT-4.1s 54.6 %, og er nest etter Claude Sonnet 4 i offentlig tilgjengelige sammenligningstester.

- MultiPL-E og OJBench: Demonstrerer robust flerspråklig kodeevne (85.7 % på MultiPL-E) og pålitelig ytelse på tvers av programmeringsutfordringer i den virkelige verden.

- Matte-500Oppnår 97.4 %, og overgår GPT-4.1s 92.4 %, og viser dermed dens dyktighet innen formell matematisk resonnering.

Hvordan er det optimalisert for agentoppgaver?

Utover rå generering ble Kimi K2 trent med syntetiske verktøybruksscenarier – Model Context Protocol (MCP)-data – for å kalle eksterne verktøy, resonnere gjennom flertrinnsprosesser og løse problemer autonomt. Dette gjør den spesielt dyktig i miljøer som Cline, hvor den kan orkestrere kodeutførelse, API-interaksjon og arbeidsflytautomatisering sømløst.

Hvordan får jeg tilgang til Kimi K2?

Tilgangsalternativene spenner over offisielle plattformer, distribusjoner med åpen kildekode og tredjepartsintegrasjoner, og dekker behovene til forskning, utvikling og bedrifter.

Offisiell Moonshot AI-plattform

Moonshot AI tilbyr vertsbasert inferens via plattformen sin, og gir API-tilgang med lav latens til både Kimi-K2-Base- og Kimi-K2-Instruct-variantene. Prisene er nivåbaserte basert på databehandlingsforbruk, med bedriftsplaner som inkluderer prioritert støtte og lokale distribusjoner. Brukere kan registrere seg på Moonshot AI-nettstedet og hente API-nøkler for umiddelbar integrering.

CometAPI

CometAPI har allerede integrert K2 i tilbudene sine. Den kombinerer K2-inferens med administrert GPU-infrastruktur, tjenestenivåavtalegarantier og skalerbare prisnivåer, slik at organisasjoner kan velge mellom API-bruk med betaling etter forbruk eller reservert kapasitet med volumrabatter.

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering forenkler CometAPI integreringen av AI-funksjoner i applikasjonene dine dramatisk.

Utviklere har tilgang Kimi K2 API(kimi-k2-0711-preview)gjennom CometAPIFor å begynne, utforsk modellens muligheter i lekeplass og konsulter API-veiledningfor detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen.

Integrasjoner med tredjepartsverktøy

- Kline: En populær kodesentrisk IDE som støtter Kimi K2 via

cline:moonshotai/kimi-k2leverandør, som gir utviklere ettklikkstilgang til chat, kodegenerering og agentiske arbeidsflyter i editoren sin. - Hugging Face Spaces: Fellesskapsdrevne demoer og minimalistiske brukergrensesnitt lar brukere samhandle med K2-Instruct-modeller direkte i nettleseren. En Hugging Face-konto er nødvendig, og ytelsen kan variere basert på delte backend-ressurser.

Hvordan bruker jeg Kimi K2?

Når du har valgt en tilgangsmetode, kan du bruke K2 til en rekke oppgaver – fra chat til kodekjøring og autonome agenter.

Via API eller plattform-SDK

- Godkjenne: Hent API-nøkkelen din fra Moonshot AI eller CometAPI.

- Initialiser klient: Bruk den offisielle SDK-en (Python/JavaScript) eller standard HTTP-forespørsler.

- Velg modellvariant:

- Kimi‑K2‑Base for finjustering og forskning.

- Kimi‑K2‑Instruksjon for plug-and-play-chat og agenter.

- CometAPIs modell:

kimi-k2-0711-preview

- Send instruksjoner: Formater inndata i henhold til chatmalen (system, bruker, assistentroller) for å utnytte optimalisert instruksjonsfølgeatferd.

Kjører lokalt med llama.cpp

For offline eller selvhostede oppsett, bruk Unsloth-kvantiserte GGUF-vekter (245 GB for 1.8-bit dynamisk kvantitet).

- Last ned vekter: Fra Moonshot AI GitHub eller Hugging Face-repositoriet.

- Installer llama.cpp: Sørg for at du har tilstrekkelig diskplass (≥ 250 GB) og kombinert RAM+VRAM (≥ 250 GB) for en gjennomstrømning på ~5 tokens/s.

- Lanseringsmodell:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Juster innstillinger: Bruk anbefalte parametere (

rope_freq_base,context_len) dokumentert i Unsloth-veiledningen for stabil ytelse.

Integrasjoner med utviklingsverktøy

- IDE-pluginer: Flere fellesskapspluginer aktiverer K2 i VS Code-, Neovim- og JetBrains IDE-er. Konfigurasjon innebærer vanligvis å spesifisere API-endepunktet og modell-ID-en i innstillingene.

- Automatiseringsrammeverk: Utnytt K2s agentkjerne med rammeverk som LangChain eller Haystack for å kjede ledetekster, API-kall og kodekjøringstrinn inn i komplekse automatiseringer.

Hva er de typiske bruksområdene for Kimi K2?

K2s kombinasjon av skala, agentisk opplæring og åpen tilgang gjør den allsidig på tvers av domener.

Kodehjelp

Fra standardisert generering og refaktorering til feilretting og ytelsesprofilering, oversettes K2s SOTA-kodingsbenchmarks til produktivitetsforbedringer i den virkelige verden – ofte bedre enn alternativer når det gjelder lesbarhet og enkelhet.

Kunnskap og resonnement

Med en kontekstlengde på 128 K håndterer K2 lange dokumenter, spørsmål og svar i flere dokumenter og tankekjeder. MoE-arkitekturen sikrer bevaring av mangfoldig kunnskap uten katastrofal glemsel.

Agentiske arbeidsflyter

K2 utmerker seg ved å orkestrere flertrinnsoppgaver – hente data, aktivere API-er, oppdatere kodebaser og oppsummere resultater – noe som gjør den ideell for autonome assistenter innen kundesupport, dataanalyse og DevOps.

Hvordan er Kimi K2 sammenlignet med andre modeller med åpen kildekode?

Mens DeepSeeks V3 og Metas nylige åpne utgivelser har dominert overskriftene tidligere i 2025, skiller Kimi K2 seg ut gjennom:

Agentintelligens

Kimi K2 ble eksplisitt designet for «agentiske» arbeidsflyter – automatisering av oppgaver via verktøykall, skallkommandoer, webautomatisering og API-integrasjoner. Det selvspillende og utvidede treningsdatasettet inkluderer diverse eksempler på verktøykall, noe som muliggjør sømløs integrering med virkelige systemer.

Kostnadseffektivitet

Med omtrent 80–90 % lavere slutningskostnad per token sammenlignet med modeller som Claude Sonnet 4, tilbyr Kimi K2 ytelse i bedriftsklassen uten blockbuster-priser, noe som katalyserer rask adopsjon blant prissensitive utviklere.

Lisenser og tilgjengelighet

I motsetning til visse utgivelser med åpen kildekode som er beheftet med restriktive lisenser, er Kimi K2 tilgjengelig under en permissiv lisens som tillater kommersiell bruk, avledede verk og lokale distribusjoner, i samsvar med Moonshot AIs åpen kildekode-etos.

- Ved å forene banebrytende MoE-design, grundig agentisk opplæring og tilgjengelighet med åpen kildekode, gir Kimi K2 utviklere og forskere muligheten til å bygge intelligente, autonome applikasjoner uten uoverkommelige kostnader eller lukkede økosystemer. Enten du skriver kode, lager komplekse flertrinns arbeidsflyter eller eksperimenterer med storskala resonnement, tilbyr K2 et allsidig og høytytende fundament.