Bilderedigering med kunstig intelligens har gått fra å være et morsomt leketøy til et faktisk arbeidsflytverktøy på måneder – ikke år. Hvis du trenger å fjerne bakgrunner, bytte ansikter, bevare en karakter på tvers av bilder eller gjøre flertrinns komposisjon med instruksjoner i naturlig språk, lover flere nye modeller å gjøre det raskere og med færre manuelle reparasjoner. I dette innlegget sammenligner jeg tre av verktøyene folk snakker om akkurat nå: OpenAIs GPT-bilde-1, Qwen-Bilderedigering, viral Nano-banan modeller (Gemini-2.5-Flash-Image), og Flux-kontekstJeg vil gå gjennom hva hver enkelt er god på, hvor de ikke lykkes, og gi en praktisk anbefaling avhengig av hva du ønsker å oppnå.

Hva er kjernefunksjonene som definerer fortreffelighet innen bilde-AI?

«Best» avhenger av hva du trenger. Evalueringen min bruker sju praktiske kriterier. Før vi dissekerer individuelle modeller, er det avgjørende å forstå de grunnleggende egenskapene som definerer fortreffelighet innen bildegenerering og redigering av kunstig intelligens. Disse kan grovt sett kategoriseres i:

- Generasjonskvalitet og -troskap: Dette refererer til AI-ens evne til å produsere svært realistiske, estetisk tiltalende og sammenhengende bilder fra tekstmeldinger. Faktorer inkluderer detaljer, belysning, komposisjon og fravær av artefakter eller forvrengninger.

- Redigeringsallsidighet og presisjon: Utover den første generasjonen bør en overlegen AI tilby robuste redigeringsfunksjoner. Dette inkluderer innmaling (fylling av manglende deler), utmaling (utvidelse av bilder), fjerning/tilføyelse av objekter, stiloverføring og presis kontroll over spesifikke elementer.

- Hastighet og effektivitet: For profesjonelle arbeidsflyter er tiden det tar å generere eller redigere bilder avgjørende. Raskere behandling uten at det går på bekostning av kvaliteten er en betydelig fordel.

- Brukeropplevelse og tilgjengelighet: Et intuitivt grensesnitt, tydelige kontroller og enkel integrering i eksisterende arbeidsflyter er avgjørende for bred adopsjon og brukertilfredshet.

- Etiske hensyn og sikkerhetsfunksjoner: Etter hvert som AI blir kraftigere, er ansvarlig utvikling og utrulling avgjørende. Dette inkluderer sikkerhetstiltak mot generering av skadelig eller partisk innhold.

- Kostnadseffektivitet og prismodeller: Selv om noen verktøy tilbyr gratisnivåer, er det viktig for budsjettbevisste brukere å forstå prisstrukturen for avanserte funksjoner og kommersiell bruk.

- Konsekvente flertrinnsredigeringer — bevare identitet/objekter på tvers av flere redigeringer eller bilder.

Jeg heller på det praktiske: en modell som produserer litt mindre "wow-faktor"-bilder, men som lar deg få reproduserbare, raske og pålitelige redigeringer, vil slå en prangende en som trenger mye opprydding.

Hvilke modeller vurderes, og hva gjør dem forskjellige?

Raskt modelløyeblikksbilde

- gpt-bilde-1 (OpenAI) – en innebygd multimodal modell utgitt til API-et i april 2025 som direkte støtter iterativ bildegenerering og -redigering i det samme multimodale Responses/Images API-et.

- Gemini 2.5 Flash-bilde (Google) — annonsert 26. august 2025 («nano-banana»); designet for rask generering med lav latens og rik redigering (fusjon av flere bilder, tegnkonsistens); inkluderer SynthID-vannmerking for proveniens.

- Qwen-Bilderedigering (QwenLM / Alibaba-gruppen) — en bilderedigeringsversjon av Qwen-Image (20B-grunnleggende) med vekt på tospråklig, presis tekstredigering og kombinert semantisk + utseenderedigering.

- FLUX.1 Kontext (Flux / Black Forest Labs / Flux-plattformvarianter) — en modellfamilie (Dev / Pro / Max) med fokus på rask, lokal og kontekstbevisst redigering med tegnkonsistens og iterative arbeidsflyter.

Hvorfor disse fire?

De dekker de mest relevante designpunktene som utøvere spør om i 2025: multimodal integrasjon (OpenAI), skalering + produksjon pluss verdenskunnskap (Google), presisjonsredigering og åpen forskning (Qwen), og UX-først iterativ redigering (Flux). Hver av dem har forskjellige avveininger når det gjelder kostnad, latens og hvor de skinner (tekstgjengivelse, flerbildefusjon, iterativ redigering, bevaring av uendrede områder).

GPT-Image-1 (OpenAI) – utviklerens tunge oppgave

Hva det er: OpenAIs GPT-Image-1 er en innebygd multimodal modell som godtar både tekst- og bildeinndata og støtter generering og bilderedigering (innmaling, bilde-til-bilde) via deres Images API. Den er posisjonert som en produksjonsmodell for integrering på tvers av apper og tjenester. Den er designet som en innebygd tekst+bilde-modell som kan godta bildeinndata og tekstmeldinger og utføre redigeringer med fin kontroll.

Hva er styrkene til GPT-image-1?

- Eksepsjonell semantisk forståelse: En av GPT-image-1s primære styrker ligger i evnen til å tolke nyanserte og forseggjorte tekstmeldinger. Brukere kan beskrive intrikate scener, spesifikke stemninger og abstrakte konsepter med bemerkelsesverdig nøyaktighet, og AI-en produserer ofte bilder som gjenspeiler disse beskrivelsene på en troverdig måte.

- Fotorealisme av høy kvalitet: Når GPT-image-1 blir bedt om å lage realistiske bilder, leverer den ofte resultater som er slående naturtro, med imponerende fokus på teksturer, belysning og naturlige komposisjoner. Dette gjør det til et formidabelt verktøy for fotorealistisk rendering og konseptkunst.

- Kreativ tolkning: Utover bare bokstavelig oversettelse, viser GPT-image-1 en viss grad av kreativ tolkning, og legger ofte til subtile detaljer eller stilistiske utsmykninger som forsterker den generelle kunstneriske appellen til det genererte bildet. Dette kan være spesielt gunstig for idéutvikling og utforskning av ulike visuelle konsepter.

- Sterkt grunnlag for iterasjon: Evnen til å generere innledende konsepter av høy kvalitet gir et utmerket utgangspunkt for videre forbedring, enten innenfor AI-ens redigeringsmuligheter (hvis tilgjengelig) eller gjennom tradisjonell grafisk designprogramvare.

Hva er begrensningene til GPT-image-1?

- Kontroll over fine detaljer: Selv om de er utmerkede på brede konsepter, kan det noen ganger være utfordrende å oppnå absolutt kontroll på pikselnivå eller presis manipulering av svært små elementer. Dette er en vanlig hindring for mange generative AI-er, der resultatet er noe deterministisk basert på prompten.

- Tilgjengelighet og integrasjon: Avhengig av den spesifikke implementeringen, kan GPT-image-1s direkte redigeringsfunksjoner være mindre robuste eller integrerte sammenlignet med dedikerte bilderedigeringsplattformer. Brukere må kanskje eksportere og bruke andre verktøy for intensiv redigering etter generering.

- Beregningskrav: Det kan være beregningskrevende å generere svært detaljerte bilder med komplekse instruksjoner, noe som potensielt kan føre til lengre behandlingstider sammenlignet med mer spesialiserte, lettere modeller for raske redigeringer.

Nano Banana (Google / Gemini 2.5 Flash-bilde)

Hva det er: «Nano Banana» er det lekne navnet på Googles nylige Gemini-bildeoppgradering (Gemini 2.5 Flash Image). Den har blitt posisjonert som en neste generasjons bildegenerator/-redigerer i Googles Gemini-økosystem, markedsført for sterkere, mer nyanserte flertrinnsredigeringer og overlegen konsistens i fotoredigeringer.

Hvor skinner Gemini-2.5-Flash-Image i det visuelle AI-landskapet?

Gemini-2.5-Flash-Image, en nyere iterasjon designet for hastighet og effektivitet, er Googles konkurrent som sikter mot en balanse mellom høykvalitetsutdata og rask prosessering. Betegnelsen «Flash» peker spesifikt på den optimaliserte arkitekturen for raskere responser, noe som gjør den svært egnet for applikasjoner der generering og redigering i sanntid eller nær sanntid er avgjørende.

Hva gjør Gemini-2.5-Flash-Image til en sterk kandidat?

- Lynrask generasjon: Som navnet antyder, er hastighet en sentral fordel. Gemini-2.5-Flash-Image utmerker seg ved rask generering av bilder, noe som er uvurderlig for kreative fagfolk med stramme tidsfrister eller for interaktive applikasjoner.

- Solid bildekvalitet: Til tross for hastigheten går ikke modellen nevneverdig på bekostning av bildekvaliteten. Den produserer sammenhengende, visuelt tiltalende bilder som generelt er fri for større artefakter, noe som gjør den konkurransedyktig med tregere og mer ressurskrevende modeller for mange bruksområder.

- Multimodal forståelse: Ved å utnytte det bredere Gemini-rammeverket drar det ofte nytte av avansert multimodal forståelse, noe som betyr at det potensielt kan tolke ikke bare tekst, men også andre former for input for å veilede bildegenerering og redigering, selv om dette varierer fra API til API.

- Integrerte redigeringsmuligheter: Gemini-2.5-Flash-Image kommer vanligvis med integrerte redigeringsfunksjoner som inpainting (fylle ut manglende deler av et bilde), outpainting (utvide et bilde utover de opprinnelige grensene) og objektmanipulering, noe som gjør det til en mer komplett løsning for ende-til-ende bildearbeidsflyter.

Hva er forbedringsområdene for Gemini-2.5-Flash-Image?

- Topp fotorealisme: Selv om det er bra, når det kanskje ikke alltid den absolutte toppen av fotorealisme som man ser i noen av de tregere, større modellene for svært intrikate og nyanserte scener. Det kan være en liten avveining mellom hastighet og ultimat gjengivelse.

- Kunstnerisk nyanse for komplekse stiler: For svært spesifikke kunstneriske stiler eller ekstremt abstrakte forespørsler, kan noen brukere synes at den er litt mindre kapabel til å fange opp de mest subtile kunstneriske nyansene sammenlignet med modeller trent på enorme kunsthistoriske datasett.

- Kontroll over generert tekst (i bilder): Som mange generative modeller kan det fortsatt være en utfordring å generere perfekt sammenhengende og korrekt stavet tekst i et bilde.

Hva er Qwen-Bilderedigering?

Hva det er: Qwen-Bilderedigering (Alibaba / Qwen-teamet) — bilderedigeringsmodell bygget på Qwen-Image-familien; hevder sterk tospråklig tekstredigering (kinesisk og engelsk), semantisk og utseendemessig kontroll, og direkte bilderedigeringsgjengivelse.

Hva er de unike styrkene til Qwen-Image Edit?

- Overlegen redigeringspresisjon: Qwen-Image Edit kan ofte skryte av avanserte algoritmer for innmaling, utmaling og objektmanipulering som muliggjør svært presise og sømløse redigeringer. Den utmerker seg ved å opprettholde visuell sammenheng selv når man gjør betydelige endringer.

- Kontekstbevisst redigering: En viktig styrke er kontekstbevisstheten. Når man for eksempel fjerner et objekt, fyller den intelligent tomrommet med innhold som logisk blander seg med omgivelsene, noe som gjør redigeringen praktisk talt usynlig.

- Stiloverføring og harmonisering: Qwen-Image Edit kan være svært effektivt for å overføre stiler fra ett bilde til et annet eller harmonisere ulike elementer i et bilde for å skape et helhetlig utseende. Dette er uvurderlig for designere som jobber med ulike visuelle ressurser.

- Robust fjerning/tilføying av objekter: Evnen til å legge til eller fjerne objekter samtidig som lys, skygger og perspektiv opprettholdes er svært imponerende, noe som muliggjør komplekse scenekonstruksjoner eller opprydding.

- Bildeoppskalering og -forbedring: Inkluderer ofte avanserte funksjoner for oppskalering av bilder uten tap av kvalitet, og for å forbedre detaljer, farger og den generelle visuelle appellen.

Hva er de potensielle svakhetene ved Qwen-Image Edit?

- Fokus for første generasjon: Selv om den kan generere bilder, ligger dens primære styrke og optimalisering ofte i redigering. Den innledende tekst-til-bilde-genereringen kan være god, men potensielt ikke like kreativt mangfoldig eller fotorealistisk som modeller som utelukkende fokuserer på generering, avhengig av den spesifikke versjonen.

- Læringskurve for avanserte funksjoner: Presisjonen og dybden til redigeringsverktøyene kan kreve en litt brattere læringskurve for brukere som ikke er kjent med avanserte bildemanipuleringskonsepter.

- Ressursintensitet for komplekse redigeringer: Svært komplekse redigeringer med flere lag kan fortsatt være beregningskrevende, noe som potensielt kan føre til lengre behandlingstider for svært store eller intrikate oppgaver.

Hvilke innovasjoner bringer Flux Kontext til bilde-AI?

Hva det er: Flux' Kontext (noen ganger markedsført som FLUX.1 Kontext) er et verktøy for bilderedigering/generering laget for designere og merkevareteam. Det legger vekt på kontekstbevisst redigering, presis typografi, stiloverføringer og et stramt brukergrensesnitt/brukeropplevelse for iterativt designarbeid.

Hva er styrkene til Flux Kontext?

- Kontekstuell kohesjon: Flux Kontexts primære styrke er evnen til å forstå og opprettholde kontekst på tvers av flere bildegenerasjoner eller redigeringer. Dette er uvurderlig for å skape konsistente visuelle fortellinger, karakterdesign eller produktlinjer der visuell harmoni er avgjørende.

- Forbedret konsistens i serier: Hvis du trenger å generere en serie bilder som deler en felles stil, karakter eller miljø, har Flux Kontext som mål å redusere inkonsekvenser som kan plage andre modeller.

- Adaptiv styling: Den kan tilpasse resultatet basert på tidligere genererte bilder eller en definert stilguide, noe som fører til en mer strømlinjeformet og mindre iterativ kreativ prosess.

- Spesialisert for merkevare og narrativ: Spesielt gunstig for markedsføring, merkevarebygging og historiefortelling, der en enhetlig visuell identitet er avgjørende.

- Rask forståelse i kontekst: Den raske forståelsen handler ikke bare om det aktuelle bildet, men hvordan det passer inn i en større kontekst eller et instruksjonssett.

Hva er begrensningene til Flux Kontext?

- Potensial for nisjefokus: Dens vekt på kontekst og konsistens kan bety at den ikke alltid er den absolutte lederen innen rå, frittstående fotorealisme eller ekstremt kunstnerisk mangfold hvis det er det eneste kravet.

- Mindre offentlig dokumenterte referansepunkter: Som en nyere eller mer spesialisert aktør kan omfattende offentlige referansedata være mindre tilgjengelige sammenlignet med mer etablerte modeller.

- Avhengig av tydelig kontekstuell input: For å utnytte styrkene må brukerne gi tydelig kontekstuell informasjon eller definere narrativrammeverket effektivt, noe som kan kreve en annen tilnærming til spørsmål.

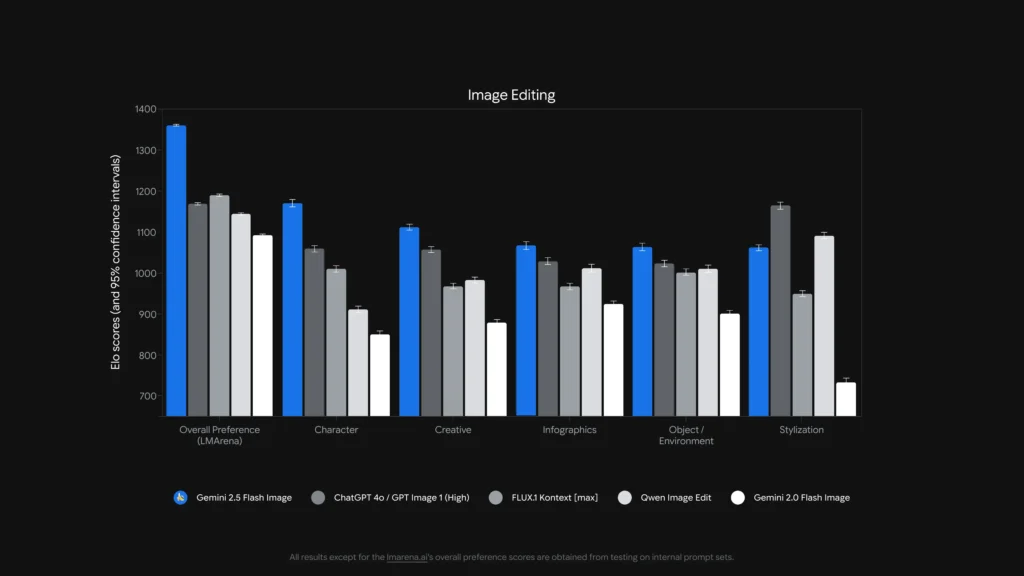

Hvilken modell er best til bilderedigering?

For enslige, presise maskeløse redigeringer og tekstredigering inni bilder, Qwen-Bilderedigering og Gemini 2.5 Flash-bilde (og spesialiserte modeller som FLUX.1 Kontext) er blant de sterkeste. komplekse flertrinnskjedede redigeringer, å kombinere et instruksjonssterkt LLM-frontend (Gemini- eller GPT-varianter) med en bildemodell gir ofte det beste resultatet – noe benchmark-arbeid har vist at Chain-of-Thought-stilprompting (Gemini-CoT) forbedrer suksess med redigering i flere trinn.

lokale redigeringer, tegnkonsistens, teksthåndtering

- Qwen-Bilderedigering retter seg eksplisitt mot begge deler semantisk og utseende redigeringer – f.eks. erstatte objekt, rotere, presis tekstutskifting – eksplisitt bygget som en bilderedigering modell med doble signalveier (semantisk kontroll via Qwen2.5-VL + utseendekontroll via VAE-koder). Den annonserer robust tospråklig (kinesisk/engelsk) tekstredigering i bilder (f.eks. endre skilttekst, produktetiketter) samtidig som stilen bevares, noe som er sjeldent og verdifullt for lokalisering og pakkearbeid.

- Gemini 2.5 Flash-bilde støtter maskerte redigeringer, promptdrevne lokale modifikasjoner (uskarp bakgrunn, fjern person, endre positur) og flerbildefusjon. Google annonserer promptbaserte regionbevisste redigeringer pluss fordeler med verdenskunnskap (f.eks. bedre objektsemantikk i den virkelige verden). Modellen legger også til en usynlig SynthID-vannmerke til genererte/redigerte bilder for å hjelpe med opprinnelse og deteksjon.

- FLUX.1 Kontekst: posisjonerer seg som en bilde-til-bilde-kontekstløser – den er optimalisert for presise, kontekstbevisste lokale redigeringer og iterativ eksperimentering. Anmeldere roser dens evne til å bevare kontekst og scenesemantikk samtidig som den gjør lokale endringer. FLUX.1 Kontext og Flux Kontext UI får skryt i praktiske tester for iterative redigeringsarbeidsflyter og tekstlesbarhet, noe som gjør den til et praktisk valg for arbeidsflyter som trenger mange raske iterasjoner (markedsføringsressurser, miniatyrbilder).

- GPT-bilde-1: støtter redigeringsoperasjoner (tekst + bilde-ledetekster for redigeringer), og OpenAIs verktøy integrerer kjede- og ledetekstutviklingsmønstre; ytelsen er sterk, men avhenger av ledetekstutvikling og kan henge etter spesialiserte redigerings-først-modeller i finkornet redigering (f.eks. nøyaktig tospråklig teksterstatning) i noen tester.

Referansepunkter som ComplexBench-Edit og CompBench viser at mange modeller fortsatt mislykkes når redigeringer er kjedet eller gjensidig avhengige, men at det å kombinere en LLM for instruksjonsparsing med en robust bildemodell (LLM→bildemodellorkestrering) eller bruk av CoT-ledetekster kan redusere feil. Det er derfor noen produksjonsarbeidsflyter setter modeller sammen (f.eks. en resonnerings-LLM pluss en bildegenerator) for harde redigeringer.

Hvem er best på å redigere tekst i bilder?

- Qwen-Bilderedigering ble eksplisitt utviklet for tospråklig (kinesisk + engelsk) presis tekstredigering og rapporterer overlegne resultater i tekstredigeringstester (Qwens offentlige tekniske notater og rapporterte poengsummer). Qwen-artefakter og -demoer med åpen kildekode viser nøyaktig bevaring av skrifttype/størrelse/stil under redigeringer.

- gpt-bilde-1 og Gemini 2.5 Flash-bilde begge gjør fremskritt i tekstgjengivelse, men akademiske referansetester og leverandørnotater indikerer gjenværende utfordringer for liten/detaljert tekst og lange tekstpassasjer – forbedringene er trinnvise og varierer etter ledetekst og løsning.

Komparativ analyse: Funksjon, redigering

For å gi et klarere bilde, la oss konsolidere de viktigste aspektene ved disse ledende AI-modellene i en sammenligningstabell.

| Funksjon / evne | GPT-bilde-1 (OpenAI) | Gemini-2.5-Flash-bilde (Google) | Qwen-Bilderedigering (Alibaba) | FLUX.1 Kontekst |

|---|---|---|---|---|

| Native generasjon + redigering | Ja. Multimodal tekst + bilde i ett API. | Ja – innebygd generering og målrettet redigering; vekt på flerbildefusjon og karakterkonsistens. | Fokusert på redigering (Qwen-Image-Edit) med semantisk + utseendekontroll. | Fokusert på bilde-til-bilde-redigeringer med høy gjengivelseskvalitet. |

| Redigeringsdybde (lokale justeringer) | Høy (men generalist) | Svært høy (målrettede spørsmål + redigeringer uten maske) | Svært høy for semantiske/tekstredigeringer (støtte for tospråklig tekst). | Svært høy — kontekstbevisste redigeringsrørledninger. |

| Håndtering av tekst i bilde | Bra, avhenger av spørretid | Forbedret (leverandør viser demonstrasjoner av mal- og skiltredigering) | Beste blant disse for endringer i tospråklig lesbar tekst. | Sterk for å bevare stilen; lesbarheten avhenger av varsel. |

| Karakter-/objektkonsistens | Bra med forsiktig oppfordring | Sterk (eksplisitt trekk) | Medium (fokus er redigering snarere enn identitet med flere bilder) | Sterk via iterative redigeringsarbeidsflyter. |

| Latens/gjennomstrømning | Moderat | Lav latens / høy gjennomstrømning (Flash-modell) | Varierer etter hosting (lokal/HF vs. sky) | Utviklet for raske iterative redigeringer i vertsbasert SaaS. |

| Proveniens / vannmerking | Ingen obligatorisk vannmerke (politiske mekanismer) | SynthID usynlig vannmerke for bilder. | Avhenger av verten | Avhenger av verten |

Merknader: «Redigeringsdybde» måler hvor finkornete og pålitelige lokale redigeringer er i praksis; «Teksthåndtering» vurderer evnen til å plassere/endre lesbar tekst i bilder.

Hva med latens, ergonomi for utviklere og bedriftsintegrasjon?

Latens og distribusjonsalternativer

- Gemini 2.5 Flash-bilde legger vekt på lav latency og er tilgjengelig via Gemini API, Google AI Studio og Vertex AI – et sterkt valg for bedriftsapper som trenger forutsigbar gjennomstrømning og skyintegrasjon. Google rapporterer også omtrentlig pris per bilde for tokens (og utviklerbloggen inkluderer et eksempel på pris per bilde).

- gpt-bilde-1 er tilgjengelig via OpenAI Images API og har bred økosystemintegrasjon (Playground, partnere som Adobe/Canva). Prisene er tokenbaserte og varierer etter bildekvalitetsnivå (OpenAI publiserer token-til-dollar-konverteringer).

- Flux-kontekst fokuserer på en rask interaktiv brukeropplevelse og tilbyr kreditter + lave redigeringstider i produktdemoer – praktisk for designere og rask iterasjon. Qwen gir åpne artefakter og tilgang til forskning (ideelt hvis du vil være vert for eller inspisere interne elementer).

Hvor mye koster disse tjenestene – hvilken er best valuta for pengene?

Prisene endres ofte – nedenfor er tall oppgitt av utgivere (august 2025) og representative kostnadsberegninger per bilde der leverandørene publiserte dem.

Publiserte priser (leverandøruttalelser)

| Modell / Leverandør | Offentlig prisoversikt (publisert) | Grovt estimat per bilde |

|---|---|---|

| gpt-bilde-1 (OpenAI) | Tokenisert prising (tekstinndata $5 / 1 mill., bildeinndata $10 / 1 mill., bildeutdata $40 / 1 mill.). OpenAI bemerker at dette tilsvarer omtrent $ $ 0.02 0.19- per generert bilde avhengig av kvalitet/størrelse. | ~$0.02 (lav kvalitet/miniatyrbilde) → ~$0.19 (kvadratisk bilde av høy kvalitet) |

| Gemini 2.5 Flash-bilde (Google) | 30 dollar per 1 million utgangstokener og eksempel: hvert bilde ≈ 1290 utdatatokener (~$0.039 per bilde) i henhold til utviklerens blogg. Priser brukes via Gemini API / Vertex. | ~$0.039 per bilde (Google-eksempel) |

| Flux-kontekst (Flux) | Gratisnivå med kreditter; Flux-produktsider viser 10 gratis studiepoeng og typiske redigeringer priset til 5 studiepoeng; abonnementsnivåer tilgjengelig for storbrukere. (Leverandørens produktside). | Svært lav kostnad for sporadiske redigeringer; abonnement for mye bruk. |

| Qwen-Bilderedigering (QwenLM) | Åpen utgivelse og GitHub-artefakter – åpen tilgang for forskning med gratis eksempler; kommersielle distribusjoner varierer fra integrator til leverandør (egenhostet vs. sky). Ingen enkelt kanonisk pris per bilde; pleier å være lavest hvis egenhostet. |

Verditolkning: Hvis du trenger bilder med høyt volum generasjonen i produksjon og ønsker forutsigbar prising per bilde, er Googles eksempel per bilde ekstremt konkurransedyktig. Hvis kostnadene domineres av menneskelig redigering eller iterativ designertid, kan Flux eller å kjøre Qwen lokalt være mer økonomisk. OpenAI tilbyr et bredt SDK-økosystem og mange partnere, verdt det høyere nivået for enkel integrering.

Pris i CometAPI

| Modell | GPT-bilde-1 | Gemini-2.5-Blitz-Bilde | FLUX.1 Kontekst |

| Pris | Inndata-tokener 8.00 dollar; Utdata-tokener 32.00 dollar | $0.03120 | flux kontekst pro: $0.09600 flux-kontekst-maks: $0.19200 |

Praktiske, raske tips for å få best mulig resultat

Tips for oppfordringer og arbeidsflyt (gjelder alle modeller)

- Vær tydelig om komposisjonkameravinkel, belysning, stemning, brennvidde, objektiv og de romlige forholdene mellom objekter. Eksempel: «35 mm nærbilde, liten dybdeskarphet, motivet sentrert, mykt lys i kanten fra øvre venstre hjørne.»

- Bruk iterativ forbedring for redigeringerGjør grove strukturelle redigeringer først, og følg deretter opp med tekstur-/lysforbedringer. Modeller som FLUX og Gemini er bygget for å støtte flertrinnsforbedring.

- For tekst i bilder: oppgi nøyaktig den teksten du ønsker og legg til «gjengi som et lesbart skilt med høy kontrast og realistisk preging» – for tospråklige redigeringer, bruk Qwen-Image-Edit når du trenger gjengivelse av kinesisk/engelsk tekst.

- Bruk referansebilderFor karakterkonsistens eller produktvarianter, bruk referansebilder av høy kvalitet og ankerprompter som «match karakteren i referanse_01: ansiktstrekk, kostymefarge og belysning». Gemini og Flux vektlegger flerbildefusjon/konsistens.

- Maskering kontra maskeløse redigeringer: der det er mulig, bruk en maske for å begrense redigeringer tett. Når maskeløs redigering brukes, forvent sporadisk spillover. Modeller varierer: Flux/Gemini håndterer maskeløse redigeringer bra, men en maske hjelper fortsatt.

- Bruk GPT-bilde / GPT-4o for komplekse komposisjonsoppgaver med flere objekter, antall og romlige begrensninger. Bruk én enkelt, nøyaktig instruksjon per generasjon når det er mulig.

Tips om kostnader og ventetid

doseringBruk batch-API-er eller skyfunksjoner for å generere mange varianter effektivt. Gemini-2.5-Flash er optimalisert for gjennomstrømning hvis du trenger høyt volum.

Still inn kvalitet kontra prisOpenAI eksponerer lave/middels/høye bildenivåer; genererer grove utkast med lav kvalitet, ferdigstiller med høy kvalitet.

endelige dommen

- Best for produksjon og integrasjon: GPT-bilde-1 – sterkest for API-behov, komposisjon og integrering i profesjonelle verktøy.

- Best for fotoreal konsistens for forbrukere: Nano-banan – Googles Gemini-bildeoppgradering utmerker seg med naturlige, sekvensielle portrettredigeringer og en tilgjengelig brukeropplevelse.

- Beste mobil-/redigeringsopplevelse: Flux-kontekst – flotte samtaleredigeringer på telefonen med lav friksjon.

- Hvis du måler med kirurgiske tekstredigeringer og tospråklig/flerspråklig redigering, er Qwen-Image-Edit** toppspesialisten og et utmerket valg der tekstnøyaktighet i bilder er viktig.

Komme i gang

CometAPI er en enhetlig API-plattform som samler over 500 AI-modeller fra ledende leverandører – som OpenAIs GPT-serie, Googles Gemini, Anthropics Claude, Midjourney, Suno og flere – i ett enkelt, utviklervennlig grensesnitt. Ved å tilby konsistent autentisering, forespørselsformatering og svarhåndtering, forenkler CometAPI dramatisk integreringen av AI-funksjoner i applikasjonene dine. Enten du bygger chatboter, bildegeneratorer, musikkomponister eller datadrevne analysepipeliner, lar CometAPI deg iterere raskere, kontrollere kostnader og forbli leverandøruavhengig – alt samtidig som du utnytter de nyeste gjennombruddene på tvers av AI-økosystemet.

Utviklere har tilgang GPT-bilde-1, FLUX.1 Kontekst og Gemini 2.5 Flash-bilde Gjennom CometAPI er de nyeste modellversjonene som er oppført per artikkelens publiseringsdato. For å begynne, utforsk modellens muligheter i lekeplass og konsulter API-veiledning for detaljerte instruksjoner. Før du får tilgang, må du sørge for at du har logget inn på CometAPI og fått API-nøkkelen. CometAPI tilby en pris som er langt lavere enn den offisielle prisen for å hjelpe deg med å integrere.

Den nyeste integrasjonen Qwen-Bilderedigering vil snart dukke opp på CometAPI, så følg med! Klar til å begynne å redigere bilder? → Registrer deg for CometAPI i dag !

Pris i CometAPI

| Modell | GPT-bilde-1 | Gemini-2.5-Blitz-Bilde | FLUX.1 Kontekst |

| Pris | Inndata-tokener 8.00 dollar; Utdata-tokener 32.00 dollar | $0.03120 | flux kontekst pro: $0.09600 flux-kontekst-maks: $0.19200 |