Sztuczna inteligencja (AI) zrewolucjonizowała wiele branż, a jednym z jej najbardziej fascynujących zastosowań jest generowanie obrazów. Od tworzenia realistycznych ludzkich twarzy po produkcję surrealistycznych dzieł sztuki, zdolność do generowania obrazów AI otworzyła nowe ścieżki w sztuce, projektowaniu i technologii. W tym artykule zagłębiamy się w mechanizmy stojące za obrazami generowanymi przez AI, modele, które je napędzają, oraz szersze implikacje tej technologii.

Podstawy: Jak działa generowanie obrazów za pomocą sztucznej inteligencji?

Czym są modele generatywne?

Modele generatywne to klasa algorytmów AI, które mogą tworzyć nowe instancje danych przypominające dane treningowe. W kontekście generowania obrazu modele te uczą się wzorców z istniejących obrazów i wykorzystują tę wiedzę do tworzenia nowych, podobnych obrazów.

Rola sieci neuronowych

Podstawą generowania obrazów AI są sieci neuronowe, w szczególności modele głębokiego uczenia, takie jak splotowe sieci neuronowe (CNN). Sieci CNN są zaprojektowane do przetwarzania danych z topologią przypominającą siatkę, co czyni je idealnymi do analizy i generowania obrazów. Działają poprzez wykrywanie wzorców, takich jak krawędzie, tekstury i kształty, które są niezbędne do zrozumienia i odtworzenia obrazów.

Kluczowe modele AI w generowaniu obrazu AI

Generatywne sieci przeciwne (GAN)

Wprowadzone przez Iana Goodfellowa w 2014 r. sieci GAN składają się z dwóch sieci neuronowych: generatora i dyskryminatora. Generator tworzy obrazy, a dyskryminator ocenia je w odniesieniu do rzeczywistych obrazów. Poprzez ten proces antagonistyczny generator poprawia swoje wyniki, aby wytwarzać coraz bardziej realistyczne obrazy.

StylGAN

Opracowany przez NVIDIA, StyleGAN jest wariantem GAN znanym z generowania wysokiej jakości ludzkich twarzy. Wprowadza architekturę generatora opartą na stylu, umożliwiającą kontrolę nad różnymi poziomami szczegółowości obrazu. StyleGAN2 i StyleGAN3 dodatkowo poprawiły jakość obrazu i rozwiązały problemy, takie jak przyklejanie się tekstur.

Modele dyfuzyjne

Modele dyfuzyjne generują obrazy, zaczynając od losowego szumu i stopniowo go udoskonalając, aby dopasować go do pożądanego wyniku. Zyskały popularność ze względu na zdolność do generowania obrazów wysokiej jakości i elastyczność w różnych zastosowaniach.

Stabilna dyfuzja

Stable Diffusion to model dyfuzji typu open source, który umożliwia generowanie tekstu do obrazu. Może również wykonywać inpainting i outpainting, umożliwiając edycję i rozszerzanie obrazu. Jego charakter typu open source sprawił, że jest szeroko dostępny dla programistów i artystów.

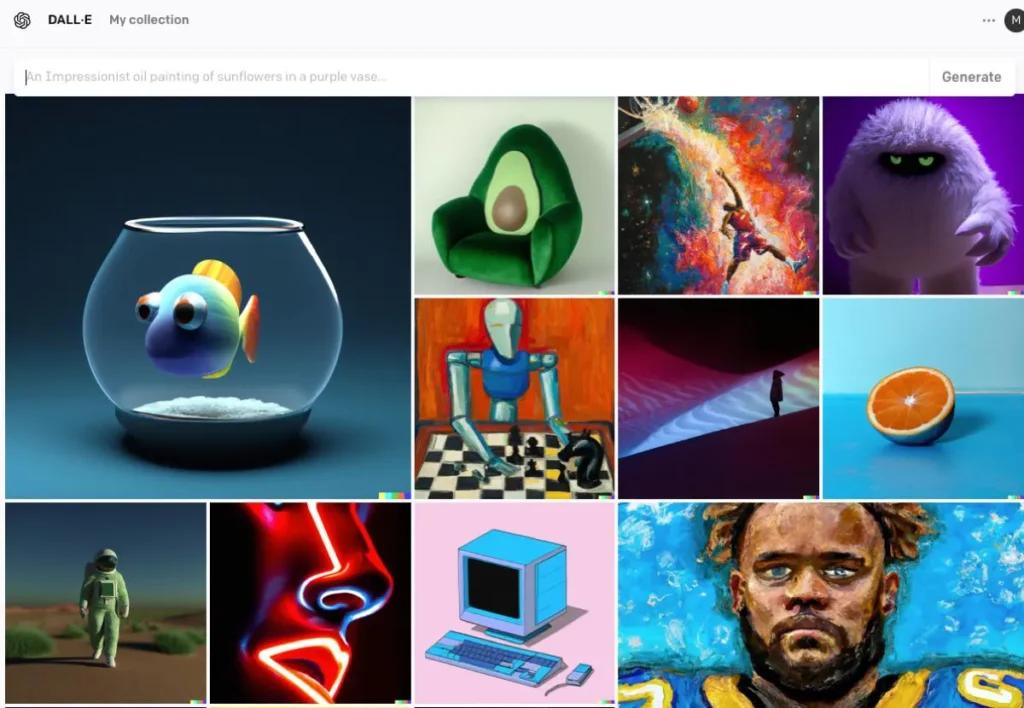

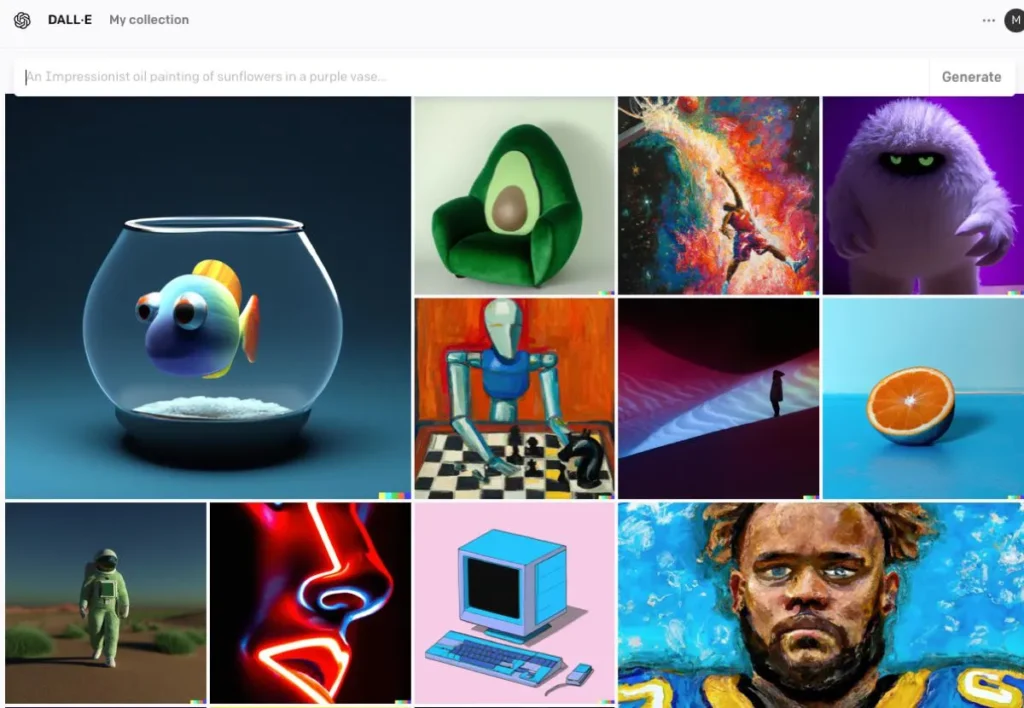

DALL · E

Opracowany przez OpenAI, DALL·E to oparty na transformatorze model, który potrafi generować obrazy z opisów tekstowych. DALL·E 2 i DALL·E 3 zostały ulepszone w stosunku do oryginału, oferując wyższą rozdzielczość i dokładniejsze wyrównanie obrazu i tekstu. DALL·E 3 jest zintegrowany z ChatGPT w celu ulepszonej interakcji użytkownika.

Proces generowania obrazu AI

Trenowanie modelu

Modele AI wymagają rozległego szkolenia na dużych zestawach danych obrazów. Podczas szkolenia model uczy się rozpoznawać wzorce i cechy w obrazach, co umożliwia mu generowanie nowych obrazów, które naśladują dane szkoleniowe.

Generowanie nowych obrazów

Po przeszkoleniu model może generować nowe obrazy poprzez:

- Odbieranie danych wejściowych:Może to być losowy szum (w sieciach GAN), monit tekstowy (w DALL·E) lub istniejący obraz (do edycji). Ten krok przechwytuje semantyczne znaczenie tekstu, umożliwiając sztucznej inteligencji zrozumienie treści i kontekstu.

- Przetwarzanie danych wejściowych:Model przetwarza dane wejściowe za pomocą warstw sieci neuronowej, stosując wyuczone wzorce i cechy. Korzystając z zakodowanego tekstu, sztuczna inteligencja stosuje modele takie jak Generative Adversarial Networks (GAN) lub modele dyfuzyjne, aby tworzyć obrazy. Modele te generują obrazy, zaczynając od losowego szumu i dopracowując go, aby pasował do opisu tekstowego.

- Udoskonalanie i ocena: Następnie wygenerowany obraz jest udoskonalany za pomocą mechanizmów uwagi, aby zapewnić spójność z tekstem. Model dyskryminatora ocenia realizm obrazu i spójność z danymi wejściowymi, zapewniając informacje zwrotne do dalszego udoskonalania.

- Wyjście obrazu:Końcowym wynikiem jest nowy obraz odzwierciedlający charakterystykę danych treningowych i konkretne dostarczone dane wejściowe.

Przykład kodu generowania obrazu AI

Poniżej znajdują się praktyczne przykłady kodu w języku Python, które pokazują, jak generować obrazy przy użyciu trzech popularnych modeli sztucznej inteligencji: generatywnych sieci przeciwstawnych (GAN), stabilnej dyfuzji i DALL·E.

Sieci generatywne przeciwstawne (GAN) z PyTorch

Sieci generatywne przeciwstawne (GAN) składają się z dwóch sieci neuronowych — Generatora i Dyskryminatora — które konkurują ze sobą, aby generować nowe, realistyczne instancje danych. Oto uproszczony przykład użycia PyTorch do generowania obrazów:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Ten kod definiuje prostą sieć generatora, która przyjmuje 100-wymiarowy wektor szumu jako dane wejściowe i generuje 784-wymiarowy wynik, który można przekształcić w obraz o wymiarach 28×28. tanh funkcja aktywacji zapewnia, że wartości wyjściowe mieszczą się w zakresie , co jest typowe dla danych obrazu.

Stabilna dyfuzja dzięki dyfuzorom Hugging Face

Stable Diffusion to potężny model text-to-image, który generuje obrazy na podstawie opisów tekstowych. The Hugging Face diffusers Biblioteka zapewnia łatwy interfejs do korzystania z tego modelu:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Ten skrypt ładuje model Stable Diffusion i generuje obraz na podstawie podanego monitu. Upewnij się, że masz zainstalowane niezbędne zależności i zgodny procesor graficzny, aby uzyskać optymalną wydajność.

DALL·E z API OpenAI

DALL·E to kolejny model text-to-image opracowany przez OpenAI. Możesz z nim wchodzić w interakcję za pomocą API OpenAI:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

zastąpić "your-api-key" z Twoim rzeczywistym kluczem API OpenAI. Ten skrypt wysyła monit do modelu DALL·E i pobiera wygenerowany obraz. Obraz jest następnie zapisywany lokalnie.

CometAPI integruje się również API DALL-E3, możesz również użyć klucza CometAPI, aby uzyskać dostęp API DALL-E3, który jest wygodniejszy i szybszy niż OpenAI.

Aby uzyskać więcej informacji o modelu w interfejsie API Comet, zobacz Dokumentacja API.

Te przykłady stanowią punkt wyjścia do generowania obrazów przy użyciu różnych modeli AI. Każdy model ma swoje unikalne możliwości i wymagania, więc wybierz ten, który najlepiej odpowiada potrzebom Twojego projektu.

Podsumowanie

Generowanie obrazów AI znajduje się na przecięciu technologii i kreatywności, oferując bezprecedensowe możliwości w tworzeniu treści wizualnych. Zrozumienie, w jaki sposób AI generuje obrazy, zaangażowanych modeli i implikacji tej technologii, jest niezbędne, gdy nawigujemy po jej integracji z różnymi aspektami społeczeństwa.

Uzyskaj dostęp do interfejsu API obrazu AI w CometAPI

CometAPI zapewnia dostęp do ponad 500 modeli AI, w tym modeli open source i specjalistycznych modeli multimodalnych dla czatu, obrazów, kodu i nie tylko. Jego główna siła polega na uproszczeniu tradycyjnie złożonego procesu integracji AI. Dzięki niemu dostęp do wiodących narzędzi AI, takich jak Claude, OpenAI, Deepseek i Gemini, jest możliwy za pośrednictwem pojedynczej, ujednoliconej subskrypcji. Możesz użyć API w CometAPI do tworzenia muzyki i dzieł sztuki, generowania filmów i budowania własnych przepływów pracy.

Interfejs API Comet zaoferuj cenę znacznie niższą od oficjalnej, aby ułatwić Ci integrację Interfejs API GPT-4o ,API w trakcie podróży Stabilny interfejs API dyfuzji (Stabilny interfejs API Diffusion XL 1.0) i API Flux(FLUX.1 API itd.), a po zarejestrowaniu się i zalogowaniu na Twoje konto zostanie naliczony 1 dolar!

CometAPI integruje najnowsze Interfejs API obrazu GPT-4o .