Pod koniec sierpnia 2025 r. Google (DeepMind) wydało Obraz Flash Gemini 2.5 — powszechnie nazywany „nano-banan” — model generowania i edycji obrazów o niskim opóźnieniu i wysokiej jakości, zintegrowany z aplikacją Gemini, Google AI Studio, API Gemini i CometAPI. Został zaprojektowany z myślą o tworzeniu fotorealistycznych obrazów, zachowaniu spójności postaci w różnych edycjach, łączeniu wielu obrazów wejściowych oraz wykonywaniu precyzyjnych, zlokalizowanych edycji za pomocą komunikatów głosowych. Model jest dostępny w wersji zapoznawczej/wczesnej wersji GA i już zajmuje pierwsze miejsce w rankingach obrazów (LMArena), a jednocześnie jest oferowany z mechanizmami bezpieczeństwa (znaki wodne SynthID i filtry na poziomie produktu).

Czym jest Gemini 2.5 Flash Image (znany również jako „Nano Banana”)?

Obraz Flash Gemini 2.5 — żartobliwie nazywany Nano Banan — to najnowszy model Google DeepMind do generowania i edycji obrazów w rodzinie Gemini. Zapowiedziany pod koniec sierpnia 2025 roku, model jest pozycjonowany jako wersja zapoznawcza, która oferuje edycję o wyższej wierności, łączenie wielu obrazów, lepszą spójność postaci (zachowanie rozpoznawalności tej samej osoby/zwierzaka/obiektu w wielu edycjach) oraz generowanie obrazów z niskim opóźnieniem w multimodalnym zestawie narzędzi Gemini. Jest on dostępny za pośrednictwem API Gemini, Google AI Studio, aplikacji mobilnych/internetowych Gemini oraz Vertex AI dla klientów korporacyjnych.

Pochodzenie i nazewnictwo

Pseudonim „nano banan” stał się popularnym skrótem w mediach społecznościowych i rankingach społeczności, po tym jak pierwsi testerzy i uczestnicy LMArena używali etykietki z motywem owocowym; Google potwierdziło to powiązanie i publicznie przyjęło ten żartobliwy pseudonim w swoich postach o programistach i produktach. Oficjalna nazwa produktu to Obraz Flash Gemini 2.5 i zazwyczaj zobaczysz identyfikator modelu używany w kodzie i wywołaniach API (w przypadku podglądu wygląda on tak, np. gemini-2.5-flash-image-preview).

Jakie są główne cechy Gemini 2.5 Flash Image?

Co tak naprawdę oznacza „spójność charakteru”?

Jedną z głównych możliwości jest spójność charakteru: możesz poprosić model o ponowne wykorzystanie tego samego obiektu (osoby, zwierzaka, maskotki lub produktu) w wielu edycjach lub nowych scenach, zachowując jednocześnie charakterystyczne cechy wizualne (twarz/kształt, paletę kolorów, znaki rozpoznawcze). Rozwiązuje to częsty problem we wcześniejszych modelach obrazów, gdzie kolejne edycje generowały wizualnie wiarygodne, ale zauważalnie różne osoby/obiekty. Programiści mogą zatem tworzyć przepływy pracy dla katalogów produktów, epizodycznych storytellingów lub generowania zasobów marki z mniejszą liczbą ręcznych poprawek.

Jakie inne elementy sterujące edycją są dostępne?

Gemini 2.5 Flash Image obsługuje:

- Celowane lokalne edycje za pomocą komunikatów w języku zrozumiałym dla użytkownika (usuń obiekt, zmień strój, popraw wygląd skóry, usuń element tła).

- Fuzja wielu obrazów: połącz maksymalnie trzy obrazy wejściowe w jedną spójną kompozycję (np. umieść produkt z obrazu A w scenie B, zachowując oświetlenie).

- Kontrola stylu i formatu: fotorealistyczne instrukcje, atrybuty aparatu i obiektywu, proporcje obrazu oraz stylizowane wyniki (ilustracja, naklejka itp.).

- Wiedza o rodzimym świecie:model wykorzystuje szerszą wiedzę rodziny Gemini, aby wykonywać edycje uwzględniające semantykę (np. zrozumieć, co oznaczają „oświetlenie renesansowe” lub „przejście dla pieszych w Tokio”).

A co z szybkością, kosztami i dostępnością?

Gemini 2.5 Flash Image jest częścią pakietu Flash platformy Gemini 2.5 — zoptymalizowanego pod kątem niskich opóźnień i kosztów przy jednoczesnym zachowaniu wysokiej jakości. Google opublikowało wstępne ceny tokenów wyjściowych obrazów i udostępniło je za pośrednictwem API i AI Studio; klienci korporacyjni mogą uzyskać do nich dostęp za pośrednictwem Vertex AI. W momencie ogłoszenia opublikowano ceny pakietu Gemini 2.5 Flash Image. 30 USD za 1 mln tokenów wyjściowych, z przykładowym kosztem za obraz podanym jako 1290 tokenów wyjściowych ≈ $0.039 za obraz.

Jak działa Gemini 2.5 Flash Image?

Architektura i podejście szkoleniowe

Gemini 2.5 Flash Image dziedziczy architekturę rodziny Gemini 2.5: rozproszony szkielet w stylu „mieszanki ekspertów” (MoE) z treningiem multimodalnym, który łączy tekst, obrazy, dźwięk i inne dane. Google trenował Flash Image na bardzo dużych, filtrowanych korpusach multimodalnych i dostroił model pod kątem zadań związanych z obrazami (generowanie, edycja, łączenie) oraz zachowań bezpieczeństwa. Trening został przeprowadzony w oparciu o infrastrukturę TPU firmy Google i oceniony za pomocą metryk automatycznych i opartych na ocenie ludzkiej.

Edycja oparta na konwersacji

Na wysokim poziomie model wykorzystuje warunkowanie kontekstowe: po dostarczeniu obrazu (lub wielu obrazów) wraz z podpowiedziami tekstowymi, model koduje tożsamość wizualną obiektu w jego wewnętrznej reprezentacji. Podczas kolejnych edycji lub tworzenia nowych scen, model warunkuje generowanie na podstawie tej reprezentacji, tak aby pożądane atrybuty wizualne (geometria twarzy, kluczowe identyfikatory ubrań lub produktów, palety kolorów) zostały zachowane. W praktyce jest to zaimplementowane w ramach multimodalnego potoku treści udostępnianego przez API Gemini: użytkownik wysyła obrazy referencyjne wraz z instrukcjami edycji, a model zwraca edytowane obrazy wyjściowe (lub wiele obrazów kandydujących) w jednej odpowiedzi.

Znak wodny i pochodzenie

Google integruje filtry bezpieczeństwa i polityki treści z Gemini 2.5 Flash Image. Wersja ta kładzie nacisk na ocenę i redteaming, zautomatyzowane kroki filtrowania, nadzorowane dostrajanie i uczenie się przez wzmacnianie w celu przestrzegania instrukcji, jednocześnie minimalizując szkodliwe dane wyjściowe. Dane wyjściowe zawierają niewidoczny znak wodny SynthID, dzięki czemu obrazy wygenerowane lub edytowane przez model można później zidentyfikować jako wygenerowane przez sztuczną inteligencję.

Jak dobrze sobie radzi? (Dane porównawcze)

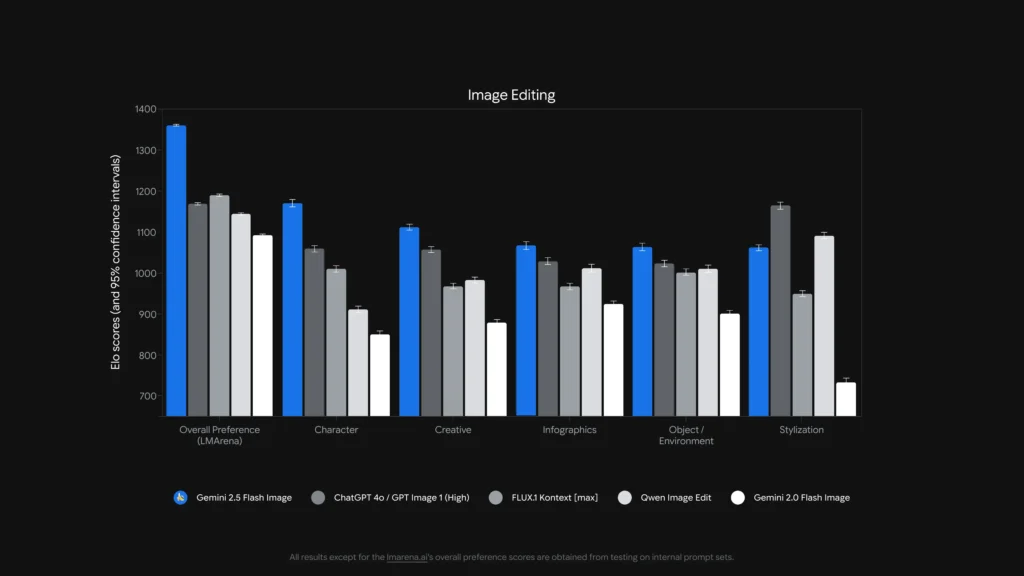

Gemini 2.5 Flash Image (w niektórych kontekstach testów porównawczych określany jako „nano-banan”) osiągnął #1 w rankingach LMArena w kategorii „Image Edit” i „Text-to-Image” Stan na koniec sierpnia 2025 r., z dużą przewagą ELO/preferencji nad konkurencją w raportowanych porównaniach. Powołuję się na wyniki oceny użytkowników LMArena i GenAI-Bench, pokazujące najwyższe wyniki preferencji zarówno dla zadań związanych z konwersją tekstu na obraz, jak i edycją obrazów.

Porównanie tekstu z obrazem

| Benchmark możliwości | Obraz Gemini Flash 2.5 | Obraz 4 Ultra 06-06 | ChatGPT 4o / Obraz GPT 1 (wysoki) | FLUX.1 Kontekst | Obraz Gemini Flash 2.0 |

|---|---|---|---|---|---|

| Ogólna preferencja (LMArena) | 1147 | 1135 | 1129 | 1075 | 988 |

| Jakość wizualna (GenAI-Bench) | 1103 | 1094 | 1013 | 864 | 926 |

| Wyrównanie tekstu do obrazu (GenAI-Bench) | 1042 | 1053 | 1046 | 937 | 922 |

Edycja zdjęć

| Benchmark możliwości | Obraz Gemini Flash 2.5 | ChatGPT 4o / Obraz GPT 1 (wysoki) | FLUX.1 Kontekst | Edycja obrazu Qwen | Obraz Gemini Flash 2.0 |

|---|---|---|---|---|---|

| Ogólna preferencja (LMArena) | 1362 | 1170 | 1191 | 1145 | 1093 |

| Postać | 1170 | 1059 | 1010 | 911 | 850 |

| Twórczy | 1112 | 1057 | 968 | 983 | 879 |

| Infografika | 1067 | 1029 | 967 | 1012 | 925 |

| Obiekt / Środowisko | 1064 | 1023 | 1002 | 1010 | 901 |

| Rekontekstualizacja produktu | 1128 | 1032 | 943 | 1009 | 888 |

| Stylizacja | 1062 | 1165 | 949 | 1091 | 733 |

Co te wskaźniki oznaczają w praktyce?

Benchmarki mówią nam dwie rzeczy: (1) model jest konkurencyjny w generowaniu fotorealistycznym i (2) wyróżnia się w redagowanie zadania, w których liczy się spójność postaci i szybkie reagowanie. Rankingi preferencji wskazują, że użytkownicy przeglądający wyniki Gemini wysoko ocenili realizm i zgodność z instrukcjami w wielu ocenianych podpowiedziach. Jednakże, wyraźnie zaznaczono znane ograniczenia (ryzyko halucynacji w przypadku drobnych szczegółów faktograficznych, renderowanie długiego tekstu wewnątrz obrazów, skrajne przypadki przenoszenia stylu) — testy porównawcze są zatem jedynie wskazówką, a nie gwarancją.

Co można zrobić za pomocą obrazu Gemini 2.5 Flash (przypadki użycia)?

Gemini 2.5 Flash Image został stworzony specjalnie z myślą o zastosowaniach kreatywnych, produktywnych i obrazowaniu użytkowym. Typowe i nowe zastosowania obejmują:

Szybkie makiety produktów i e-commerce

Przeciągaj zdjęcia produktów do scen, generuj spójne obrazy katalogowe w różnych środowiskach lub zamieniaj kolory/materiały w obrębie linii produktów – wszystko to przy jednoczesnym zachowaniu tożsamości produktu. Funkcje łączenia wielu obrazów i spójność postaci/produktu sprawiają, że rozwiązanie to jest atrakcyjne dla procesów katalogowych.

Retusz zdjęć i ukierunkowane edycje

Usuwaj obiekty, naprawiaj skazy, zmieniaj ubrania/akcesoria lub dostosowuj oświetlenie za pomocą podpowiedzi w języku naturalnym. Funkcja edycji lokalnej pozwala osobom niebędącym ekspertami na wykonywanie profesjonalnego retuszu za pomocą poleceń konwersacyjnych.

Storyboarding i wizualne opowiadanie historii

Umieść tę samą postać w różnych scenach i zachowaj spójny wygląd (przydatne w komiksach, storyboardach czy prezentacjach). Iteracyjne edycje pozwalają twórcom dopracować nastrój, kadrowanie i ciągłość narracji bez konieczności ponownego tworzenia zasobów od podstaw.

Edukacja, diagramy i prototypowanie projektów

Ponieważ model może łączyć podpowiedzi tekstowe i obrazy oraz posiada „wiedzę o świecie”, może pomóc w generowaniu diagramów z adnotacjami, materiałów edukacyjnych czy szybkich makiet do prezentacji. Google wyróżnia nawet szablony w AI Studio, przydatne w takich zastosowaniach jak makiety nieruchomości i projektowanie produktów.

Jak używać Nano Banana API?

Poniżej znajdują się praktyczne fragmenty zaadaptowane z Dokumentacja API CometAPI i dokumentacja API Google. Demonstrują one typowe przepływy: tekst na obraz oraz obraz + tekst do obrazu (edycja) korzystając z oficjalnego pakietu GenAI SDK lub punktu końcowego REST.

Uwaga: w dokumentacji CometAPI nazwa modelu podglądu wyświetla się jako

gemini-2.5-flash-image-previewPoniższe przykłady nawiązują do oficjalnych przykładów SDK (Python i JavaScript) oraz przykładu REST curl. Dostosuj klucze i ścieżki plików do swojego środowiska.

Przykład REST curl z CometAPI

Użyj oficjalnego Gemini generateContent punkt końcowy do generowania tekstu na obraz. Umieść monit tekstowy w contents.parts[].text.Przykład (powłoka systemu Windows, użycie ^ (dla kontynuacji linii):

curl --location --request POST "https://api.cometapi.com/v1beta/models/gemini-2.5-flash-image-preview:generateContent" ^

--header "Authorization: sk-xxxx" ^

--header "User-Agent: Apifox/1.0.0 (https://apifox.com)" ^

--header "Content-Type: application/json" ^

--header "Accept: */*" ^

--header "Host: api.cometapi.com" ^

--header "Connection: keep-alive" ^

--data-raw "{ "contents": [{

"parts": [

{"text": "A photorealistic macro shot of a nano-banana on a silver fork, shallow depth of field"}

]

}]

}'}"

| grep -o '"data": "*"' \

| cut -d'"' -f4 \

| base64 --decode > gemini-generated.png

Odpowiedź zawiera bajty obrazu base64; powyższy potok wyodrębnia "data" ciąg i dekoduje go do gemini-generated.png.

Ten punkt końcowy obsługuje generowanie „obraz-do-obrazu”: przesyłasz obraz wejściowy (w formacie Base64) i odbierasz zmodyfikowany nowy obraz (również w formacie Base64).Przykład:

curl --location --request POST "https://api.cometapi.com/v1beta/models/gemini-2.5-flash-image-preview:generateContent" ^

--header "Authorization: sk-xxxx" ^

--header "User-Agent: Apifox/1.0.0 (https://apifox.com)" ^

--header "Content-Type: application/json" ^

--header "Accept: */*" ^

--header "Host: api.cometapi.com" ^

--header "Connection: keep-alive" ^

--data-raw "{ \"contents\": } ], \"generationConfig\": { \"responseModalities\": }}"

**Opis:**Najpierw przekonwertuj plik obrazu źródłowego na ciąg Base64 i umieść go w inline_data.data. Nie dodawaj prefiksów takich jak data:image/jpeg;base64,Wyjście znajduje się również w candidates.content.parts i zawiera: Opcjonalną część tekstową (opis lub monit). Część obrazu jako inline_data (gdzie data jest kodem Base64 obrazu wyjściowego).W przypadku wielu obrazów można je dołączyć bezpośrednio, na przykład:

{

"inline_data": {

"mime_type": "image/jpeg",

"data": "iVBORw0KGgo...",

"data": "iVBORw0KGgo..."

}

}

Poniżej znajdują się przykłady dla programistów zaczerpnięte z oficjalnej dokumentacji i bloga Google. Zastąp dane uwierzytelniające i ścieżki do plików własnymi.

Python (oficjalny styl SDK)

from google import genai

from PIL import Image

from io import BytesIO

client = genai.Client()

prompt = "Create a picture of a nano banana dish in a fancy restaurant with a Gemini theme"

# Text-to-Image

response = client.models.generate_content(

model="gemini-2.5-flash-image-preview",

contents=,

)

for part in response.candidates.content.parts:

if part.text is not None:

print(part.text)

elif part.inline_data is not None:

image = Image.open(BytesIO(part.inline_data.data))

image.save("generated_image.png")

To kanoniczny fragment kodu Pythona z dokumentacji Google (pokazano identyfikator modelu w wersji zapoznawczej). Ten sam wzorzec wywołania SDK obsługuje edycję obrazu i monitu (przekaż obraz jako jeden z contents).Więcej szczegółów znajdziesz tutaj gemini doc.

Podsumowanie

Jeśli Twój produkt wymaga solidnego generowania obrazu o niskim opóźnieniu, a zwłaszcza, niezawodna edycja z zachowaniem spójności tematycznejGemini 2.5 Flash Image to teraz opcja klasy produkcyjnej, którą warto rozważyć: łączy najnowocześniejszą jakość obrazu z interfejsami API zaprojektowanymi do integracji z programistami (AI Studio, Gemini API i Vertex AI). Należy dokładnie rozważyć obecne ograniczenia modelu (drobny tekst na obrazach, niektóre skrajne przypadki stylizacji) i wdrożyć zabezpieczenia dotyczące odpowiedzialnego użytkowania.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Deweloperzy mogą uzyskać dostęp Obraz Flash Gemini 2.5(lista Nano Banana CometAPI gemini-2.5-flash-image-preview/gemini-2.5-flash-image (wpisy w stylu w ich katalogu.) poprzez CometAPI, najnowsze wersje modeli są aktualne na dzień publikacji artykułu. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.