Interfejs API w czasie rzeczywistym GPT-4o: Punkt końcowy przesyłania strumieniowego multimodalnego o niskim opóźnieniu, umożliwiający programistom wysyłanie i odbieranie zsynchronizowanych danych tekstowych, audio i wizualnych za pośrednictwem protokołu WebRTC lub WebSocket (model=gpt-4o-realtime-preview-<date>, stream=true) do interaktywnych aplikacji czasu rzeczywistego.

Podstawowe informacje i funkcje

OpenAI's GPT-4o w czasie rzeczywistym (identyfikator modelu: gpt-4o-podgląd-w-czasie-realtime-2025-06-03) jest pierwszym publicznie dostępnym modelem fundamentu zaprojektowanym dla kompleksowa transmisja mowy (S2S) interakcja z opóźnienie poniżej sekundy. Pochodząca z rodziny „omni” GPT-4o odmiana Realtime łączy w sobie rozpoznawanie mowy, rozumowanie w języku naturalnym i neuronowe przetwarzanie tekstu na mowę w jedną sieć, co pozwala deweloperom na tworzenie agentów głosowych, którzy rozmawiają tak płynnie jak ludzie. Model ten jest udostępniany poprzez specjalnie zbudowane API czasu rzeczywistego i jest ściśle zintegrowany z nowym Agent w czasie rzeczywistym abstrakcja wewnątrz Agenty SDK (TypeScript i Python).

Zestaw podstawowych funkcji — S2S typu end-to-end • Obsługa przerwań • Wywoływanie narzędzi

• Natywny system mowy na mowę: Dane wejściowe audio są pobierane jako ciągłe strumienie, wewnętrznie tokenizowane, racjonalizowane i zwracane jako syntezowana mowa. Nie są potrzebne żadne zewnętrzne bufory STT/TTS, co eliminuje wielosekundowe opóźnienie potoku.

• Opóźnienie w skali milisekund: Przycinanie architektury, destylacja modeli i zoptymalizowany pod kątem GPU stos obsługi umożliwiają Opóźnienia pierwszego tokena ~300–500 ms w typowych wdrożeniach w chmurze, zbliżając się do norm ludzkiej konwersacji.

• Solidne przestrzeganie instrukcji: Dopracowany w oparciu o skrypty konwersacji i ślady wywołań funkcji, GPT-4o Realtime demonstruje >25% redukcja błędów w wykonywaniu zadań w porównaniu z danymi bazowymi GPT-2024o z maja 4 r.

• Deterministyczne wywoływanie narzędzi: Model generuje ustrukturyzowany JSON zgodny ze standardem OpenAI schemat wywoływania funkcji, umożliwiając deterministyczne wywoływanie interfejsów API back-end (systemy rezerwacji, bazy danych, IoT). Wbudowane są ponowne próby uwzględniające błędy i walidacja argumentów.

• Łagodne przerwy: Detektor aktywności głosowej w czasie rzeczywistym połączony z dekodowaniem przyrostowym umożliwia agentowi wstrzymać mowę w środku zdania, absorbować przerwy w działaniu użytkownika i bezproblemowo wznawiać lub ponownie planować odpowiedź.

• Konfigurowalna szybkość mowy: nowa prędkość parametr (0.25–4× w czasie rzeczywistym) umożliwia programistom dostosowanie tempa wyświetlania wyników do potrzeb aplikacji ułatwiających dostęp lub wymagających szybkiego działania.

Architektura techniczna — Zunifikowany transformator multimodalny

Zunifikowany enkoder-dekoder: GPT-4o Realtime dzieli architekturę omni transformator jednostopniowy w którym tokeny audio, tekstowe i (przyszłej) wizji współistnieją w jednej przestrzeni ukrytej. Warstwowo-adaptacyjne obliczenia skracają klatki audio bezpośrednio do późniejszych bloków uwagi, skracając czas przejścia o 20–40 ms.

Hierarchiczna tokenizacja audio: Surowy sygnał PCM 16 kHz jest dzielony na fragmenty log-mel → kwantyzowany do grubych tokenów akustycznych → kompresowany do tokenów semantycznych, co optymalizuje token-na-sekundę budżetu bez poświęcania prozodii.

Jądra wnioskowania niskobitowego: Rozłożone ciężary działają z prędkością Kwantyzacja NF4 4-bitowa poprzez jądra Triton / TensorRT-LLM, podwajając przepustowość w porównaniu do fp16, przy zachowaniu utraty jakości MOS <1 dB.

Uwaga na transmisję strumieniową: Osadzenia obrotowe z przesuwanym oknem i buforowanie wartości kluczowych umożliwiają modelowi przechwycenie ostatnich 15 sekund dźwięku przy użyciu pamięci O(L), co ma kluczowe znaczenie dla dialogów o długości rozmowy telefonicznej.

Dane Techniczne

- Wersja interfejsu API:

2025-06-03-preview - Protokóły transportowe:

- WebRTC:Bardzo niskie opóźnienie (< 80 ms) dla strumieni audio/wideo po stronie klienta

- WebSocket:Streaming serwer-serwer z opóźnieniem poniżej 100 ms

- Kodowanie danych:

- Opus kodek w RTP pakiety audio

- H.264 / H.265 ramki do filmów

- Streaming: Obsługuje

stream: truedostarczyć przyrostowe częściowe odpowiedzi w miarę generowania tokenów - Nowa paleta głosów:Wprowadza osiem nowych głosów —stop, jesion, ballada, koral, przegapić, szałwia, migotać, werset—więcej ekspresyjny, inteligencję zbliżoną interakcje ..

Ewolucja GPT-4o w czasie rzeczywistym

- 2024 maja,: GPT-4o Omni debiutuje z multimodalnym wsparciem dla tekstu, dźwięku i obrazu.

- Październik 2024: API czasu rzeczywistego wchodzi w prywatną wersję beta (

2024-10-01-preview), zoptymalizowany pod kątem dźwięku o niskim opóźnieniu. - Grudzień 2024:Rozszerzona globalna dostępność

gpt-4o-realtime-preview-2024-12-17, Dodając szybkie buforowanie i więcej głosów. - 3 czerwca 2025 r.: Najnowsza aktualizacja (

2025-06-03-preview) wprowadza udoskonalone paleta głosowa i optymalizacja wydajności.

Wydajność wzorcowa

- MMLU: 88.7, wyprzedzając GPT-4 o 86.5 Ogromne, wielozadaniowe zrozumienie języka .

- Rozpoznawanie mowy:Osiąga wiodący w branży współczynniki błędów słownych w hałaśliwym otoczeniu, przewyższające Szept linie bazowe.

- Testy opóźnień:

- Koniec końców (mowa w → tekst na zewnątrz): 50–80 milisekund poprzez WebRTC

- Audio w obie strony (mówienie → mówienie): <100 ms .

Wskaźniki techniczne

- Wydajność:Podtrzymuje 15 tokenów/sek. dla strumieni tekstowych; Kbps 24 Dzieło dla audio.

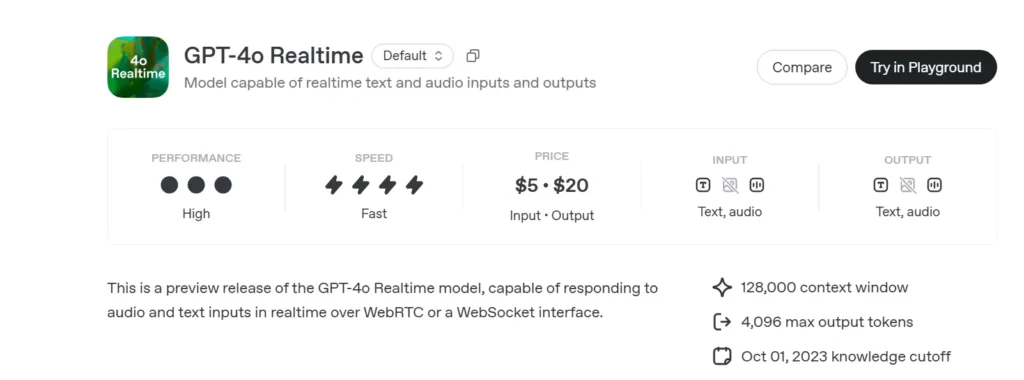

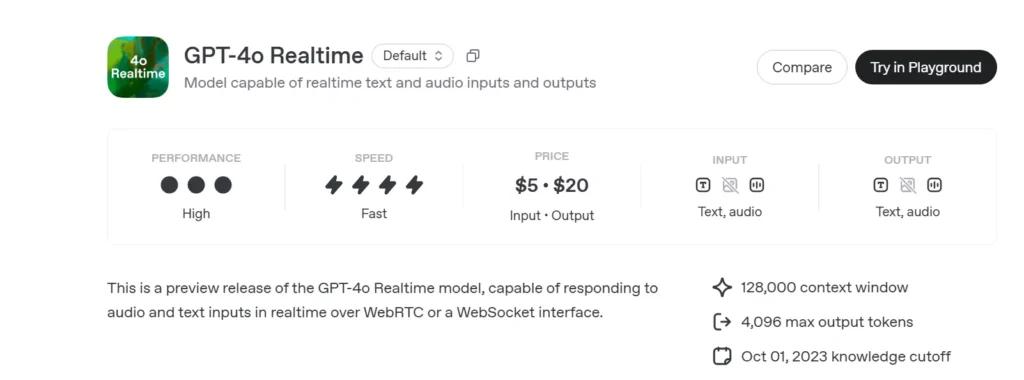

- Ceny:

- Tekst:5 USD za 1 mln tokenów wejściowych; 20 USD za 1 mln tokenów wyjściowych

- Audio:100 USD za 1 mln tokenów wejściowych; 200 USD za 1 mln tokenów wyjściowych.

- Dostępność: :Wdrożono globalnie we wszystkich regionach obsługujących interfejs API w czasie rzeczywistym.

Jak wywołać GPT-4o Realtime API z CometAPI

GPT-4o Realtime Cennik API w CometAPI:

- Żetony wejściowe: 2 USD / mln żetonów

- Tokeny wyjściowe: 8 USD / mln tokenów

Wymagane kroki

- Zaloguj się do pl.com. Jeśli jeszcze nie jesteś naszym użytkownikiem, zarejestruj się najpierw

- Pobierz klucz API uwierzytelniania dostępu do interfejsu. Kliknij „Dodaj token” przy tokenie API w centrum osobistym, pobierz klucz tokena: sk-xxxxx i prześlij.

- Uzyskaj adres URL tej witryny: https://api.cometapi.com/

Metody użytkowania

- Wybierz "

gpt-4o-realtime-preview-2025-06-03” punkt końcowy do wysłania żądania i ustawienia treści żądania. Metoda żądania i treść żądania są pobierane z naszej dokumentacji API witryny. Nasza witryna udostępnia również test Apifox dla Twojej wygody. - Zastępować za pomocą aktualnego klucza CometAPI ze swojego konta.

- Wpisz swoje pytanie lub prośbę w polu treści — model odpowie właśnie na tę wiadomość.

- . Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź.

Informacje na temat dostępu do modelu w interfejsie API Comet można znaleźć tutaj Dokumentacja API.

Informacje o cenie modelu w interfejsie API Comet można znaleźć tutaj https://api.cometapi.com/pricing.

Przykładowy kod i integracja API

import openai

openai.api_key = "YOUR_API_KEY"

# Establish a Realtime WebRTC connection

connection = openai.Realtime.connect(

model="gpt-4o-realtime-preview-2025-06-03",

version="2025-06-03-preview",

transport="webrtc"

)

# Stream audio frames and receive incremental text

with open("user_audio.raw", "rb") as audio_stream:

for chunk in iter(lambda: audio_stream.read(2048), b""):

result = connection.send_audio(chunk)

print("Assistant:", result)

- Kluczowe parametry:

model: „gpt-4o-podgląd-w-czasie-realtime-2025-06-03”version: „2025-06-03-podgląd”transport: „Webrtc” dla minimalne opóźnieniestream:truedla przyrostowe aktualizacje

Poprzez połączenie state-of-the-art rozumowanie multimodalne, krzepki nowa paleta głosów i bardzo niski przesyłanie strumieniowe z opóźnieniem, GPT-4o w czasie rzeczywistym (2025-06-03) umożliwia programistom tworzenie prawdziwie interaktywne, konwersacyjny Zastosowania sztucznej inteligencji.

Zobacz także Interfejs API o3-Pro

Bezpieczeństwo i zgodność

OpenAI dostarcza GPT-4o Realtime z:

• Zabezpieczenia na poziomie systemu: Polityka dostosowana do odrzucania niedozwolonych próśb (ekstremizm, zachowania niezgodne z prawem).

• Filtrowanie treści w czasie rzeczywistym: Klasyfikatory o czasie reakcji krótszym niż 100 ms przeszukują zarówno dane wejściowe użytkownika, jak i dane wyjściowe modelu przed emisją.

• Ścieżki akceptacji przez człowieka: Uruchamiane w przypadku wywołań narzędzi o wysokim ryzyku (płatności, porady prawne) przy wykorzystaniu nowych podstawowych funkcji zatwierdzania pakietu Agents SDK.