Luma AI stała się jednym z najpopularniejszych narzędzi do tworzenia treści dla konsumentów i prosumentów: aplikacja i usługa w chmurze, która konwertuje zdjęcia i filmy ze smartfonów na fotorealistyczne, trójwymiarowe NeRF-y, a za pośrednictwem modeli Dream Machine/Ray3 generuje obrazy i krótkie filmy na podstawie tekstu lub podpowiedzi graficznych. Jednak prędkość to jedno z pierwszych praktycznych pytań, jakie zadają twórcy: ile czasu tak naprawdę zajmie przechwycenie, renderowanie lub wygenerowanie wideo?

Ile czasu zajmuje Luma AI wygenerowanie klipu Dream Machine (tekst → wideo)?

Oficjalne czasy bazowe

Strony produktów i centrum edukacyjne Luma zapewniają szybkie pomiary bazowe dla procesów generowania obrazów i krótkich filmów: partie obrazów są mierzone w dziesiątkach sekund, a zadania z krótkimi filmami w ciągu kilku sekund do kilku minut w normalnych warunkach dla użytkowników płatnych i wewnętrznych testów porównawczych. Te oficjalne wskaźniki odzwierciedlają zoptymalizowane uruchomienie modelu w infrastrukturze Luma (stos Ray2 / Dream Machine) i stanowią najlepsze wartości dla małych, krótkich klipów.

Zakresy rzeczywiste, których należy się spodziewać

Przypadki skrajne / poziom bezpłatny lub obciążenie szczytowe:bezpłatni użytkownicy lub okresy dużego zapotrzebowania spowodowały oczekiwanie godzin lub zadania „utknięte w kolejce” do czasu zwolnienia mocy obliczeniowej; wątki społeczności dokumentują wielogodzinne oczekiwania w okresach szczytowych lub podczas przerw w dostawie prądu. Jeśli niskie opóźnienie ma kluczowe znaczenie, należy uwzględnić tę zmienność i rozważyć płatne/priorytetowe opcje.

Krótkie klipy społecznościowe (5–15 sek.):w wielu przypadkach sam etap generowania może zostać ukończony od niecałej minuty do kilku minut dla użytkowników płacących podczas normalnego obciążenia — jednak całkowity czas zegarowy może być dłuższy, jeśli uwzględnisz kolejkowanie, wstępne przetwarzanie oraz przesyłanie strumieniowe/eksportowanie.

Bardziej szczegółowe lub dłuższe klipy (20–60 sek.):te mogą wziąć od kilku do kilkudziesięciu minut, szczególnie jeśli poprosisz o wyższą rozdzielczość, złożone ruchy kamery lub iteracyjne udoskonalanie. Recenzje osób trzecich i konta użytkowników podają typowe czasy w 5–30 minut zespół przeznaczony do tworzenia bardziej złożonych, krótkich filmów.

Ile czasu zajmuje programowi Luma AI wykonanie przechwytywania 3D (z NeRF / Genie / telefonu)?

Typowe przepływy pracy związane z przechwytywaniem obrazu 3D i ich profile czasowe

Narzędzia Luma do przechwytywania obrazu 3D (aplikacja mobilna do przechwytywania obrazu + funkcje podobne do Genie) przekształcają zestaw zdjęć lub nagrane wideo w model 3D lub siatkę teksturowaną w stylu NeRF. W przeciwieństwie do krótkich klipów Dream Machine, rekonstrukcja obrazu 3D jest bardziej skomplikowana: wymaga przetworzenia wielu klatek, oszacowania pozycji kamery, optymalizacji geometrii wolumetrycznej i syntezy tekstur. Publiczne samouczki i przewodniki praktyczne informują o tym. rzeczywisty czas przetwarzania od kilku minut do wielu godzin, w zależności od długości i jakości przechwytywania. Często cytowany przykład z samouczka pokazał 30 minut do godziny w przypadku umiarkowanego przechwytywania; inne typy przechwytywania (długie przejścia, klatki o wysokiej rozdzielczości) mogą trwać dłużej.

Zakresy reprezentatywne

- Szybkie skanowanie obiektów/produktów (20–80 zdjęć, krótkie ujęcia): od kilku minut do ~30 minut.

- Przechwytywanie obrazu w skali pomieszczenia lub w trybie przejścia (od setek do tysięcy klatek): 30 minut do kilku godzin, w zależności od rozmiaru danych wejściowych i ostatecznej wierności eksportu.

- Eksport wysokiej jakości dla silników gier (siatki, tekstury o wysokiej rozdzielczości):dodaj dodatkowy czas na generowanie siatki, retopologię i pieczenie — może to spowodować przesunięcie zadań do godzin.

Dlaczego filmy 3D trwają dłużej niż krótkie filmy

Rekonstrukcja 3D jest iteracyjna i wymaga dużej optymalizacji: model udoskonala pola wolumetryczne i prognozy tekstur w wielu klatkach, co wymaga dużych nakładów obliczeniowych. Zaplecze Lumy zrównolegla wiele z tych prac, ale skala obliczeń dla każdego zadania pozostaje większa niż w przypadku pojedynczego, krótkiego generowania wideo.

Jakie są główne czynniki wpływające na czas przetwarzania Luma AI?

Wybór modelu i potoku (Ray2, Photon, Genie, Modify Video)

Różne modele i funkcje Luma zostały zaprojektowane z myślą o różnych kompromisach: Ray2 i Dream Machine priorytetowo traktują generowanie fotorealistycznego wideo z interaktywnym sprzężeniem zwrotnym o niskim opóźnieniu, podczas gdy Photon i Genie są zoptymalizowane pod kątem poprawy jakości obrazu lub rekonstrukcji 3D i mogą być bardziej wymagające z założenia. Wybór modelu z ustawieniami wyższej wierności wydłuży czas obliczeń. Oficjalna dokumentacja i interfejs API opisują wiele punktów końcowych modelu i flag jakości, które wpływają na czas wykonania.

Rozmiar i złożoność danych wejściowych

- Liczba klatek/zdjęć:więcej danych wejściowych = więcej kroków optymalizacji.

- Rozkład:wyższa rozdzielczość wyjściowa i wyższa rozdzielczość wejściowa wydłużają czas przetwarzania.

- Długość żądanego klipu:dłuższe klipy wymagają więcej czasu na renderowanie i kontrolę spójności ruchu.

Poziom konta, kolejkowanie i priorytet

Płatne subskrypcje i klienci korporacyjni/API często otrzymują priorytet lub wyższe limity. Użytkownicy darmowego poziomu często doświadczają dłuższych czasów oczekiwania w kolejce, gdy system jest obciążony. Raporty społeczności potwierdzają to: plany płatne zazwyczaj skracają czas oczekiwania i poprawiają przepustowość.

Obciążenie systemu i pora dnia

Wątki rzeczywistych użytkowników pokazują, że czas generacji może gwałtownie wzrosnąć w godzinach szczytu lub gdy wprowadzenie ważnych funkcji powoduje wzrost zapotrzebowania. Zespół Luma stale aktualizuje infrastrukturę (patrz dzienniki zmian), aby sprostać wymaganiom przepustowości, ale przejściowe opóźnienia nadal się zdarzają.

Czas sieci/wysyłania i urządzenie klienckie

W przypadku procesów przechwytywania, szybkość przesyłania i wydajność urządzenia mają znaczenie: przesyłanie dużych, wielogigabajtowych plików wydłuża czas przetwarzania, zanim jeszcze się rozpocznie. Dokumentacja Luma określa maksymalne rozmiary plików i zaleca najlepsze praktyki przechwytywania, aby zminimalizować niepotrzebny transfer danych.

Jak mogę z wyprzedzeniem oszacować czas realizacji zadania i skrócić czas oczekiwania?

Szybka lista kontrolna szacunków

- Sklasyfikuj swoją pracę: obraz, krótki film (<15 s), dłuższy film (>15 s) lub przechwytywanie obrazu 3D.

- Zlicz wejścia: liczba zdjęć / długość filmu (sekundy) / rozmiar pliku przechwytywania.

- Zdecyduj o jakości: niska, standardowa lub wysoka wierność — wyższa wierność = dłuższy czas obliczeń.

- Sprawdź poziom konta:bezpłatne, płatne i korporacyjne; należy wziąć pod uwagę prawdopodobieństwo kolejki.

- Uruchom krótki test:stwórz zadanie testowe trwające od 5 do 10 sekund, aby uzyskać rzeczywiste dane bazowe.

Praktyczne wskazówki, jak przyspieszyć przepustowość

- Użyj zalecanych wzorców przechwytywania (płynny ruch kamery, spójne oświetlenie), dzięki czemu rekonstrukcja przebiega szybciej. Centrum edukacyjne Luma i strony aplikacji mobilnej zawierają najlepsze praktyki w zakresie przechwytywania obrazu.

- Zmniejsz rozmiar wejściowy jeśli jest to dopuszczalne: przytnij, zmniejsz rozdzielczość lub przytnij materiał filmowy przed przesłaniem, aby skrócić czas przetwarzania i obniżyć koszty.

- Wybierz ustawienia wstępne o niższej jakości dla wersji roboczych, a następnie sfinalizuj w wysokiej jakości dopiero wtedy, gdy będziesz zadowolony z kompozycji.

- Zaplanuj intensywne kursy poza szczytem jeśli to możliwe; raporty lokalne wskazują, że kolejki zmniejszają się poza godzinami szczytu.

- Rozważ opcje API/przedsiębiorstwa Jeśli potrzebujesz skali i przewidywalnego SLA, API i rejestr zmian Luma pokazują stałe inwestycje w wydajność i nowe punkty końcowe, takie jak Modify Video, które usprawniają przepływy pracy.

Jak wyniki pomiaru czasu Luma wypadają w porównaniu z innymi narzędziami?

Porównywanie generatywnych usług obrazu/wideo lub NeRF jest skomplikowane, ponieważ każdy dostawca optymalizuje je pod kątem różnych kompromisów (jakość, szybkość, koszt). W przypadku generowania obrazu i bardzo krótkich filmów, Dream Machine firmy Luma — zwłaszcza z pamięcią Ray2 Flash — konkuruje z interaktywnym opóźnieniem poniżej minuty, co jest zgodne z wiodącymi usługami generatywnymi dla konsumentów. W przypadku przechwytywania obrazu NeRF w pełnej scenie i tworzenia modeli 3D o wysokiej wierności, zapotrzebowanie na moc obliczeniową w chmurze i czas oczekiwania na kolejkę są dłuższe niż w przypadku szybkich generatorów obrazu: należy spodziewać się większej zmienności i odpowiednio planować. Dokumentacja partnerów i opracowania firm zewnętrznych często wskazują na to. minut na krótkie, proste rendery i godzin (lub nieprzewidywalnie dłużej) na złożone procesy 3D.

Ostateczny werdykt – jak długo będzie Luma bierze za my stanowisko?

Nie ma jednej wartości, która pasowałaby do każdego użytkownika i każdego zadania. Użyj tych pragmatycznych punktów odniesienia, aby oszacować:

- Generowanie obrazu (Dream Machine): ~20–30 sekund na małą partię przy normalnym obciążeniu.

- Generowanie krótkiego filmu (Dream Machine / Ray2): od kilkudziesięciu sekund do kilku minut w przypadku krótkich klipów; Ray2 Flash może być znacznie szybszy w przypadku obsługiwanych przepływów.

- Przechwytywanie 3D → NeRF: bardzo zmienne. Najlepszy przypadek: minuty na obliczenia małego obiektu i światła; najgorszy przypadek (zgłoszony): Wiele godzin, a nawet dni, w przypadku dużego zapotrzebowania lub bardzo dużych zamówień. Jeśli potrzebujesz sztywnych harmonogramów, kup plany priorytetowe/korporacyjne lub przeprowadź testy pilotażowe przed produkcją i uwzględnij w swoim harmonogramie zaplanowany bufor czasowy.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

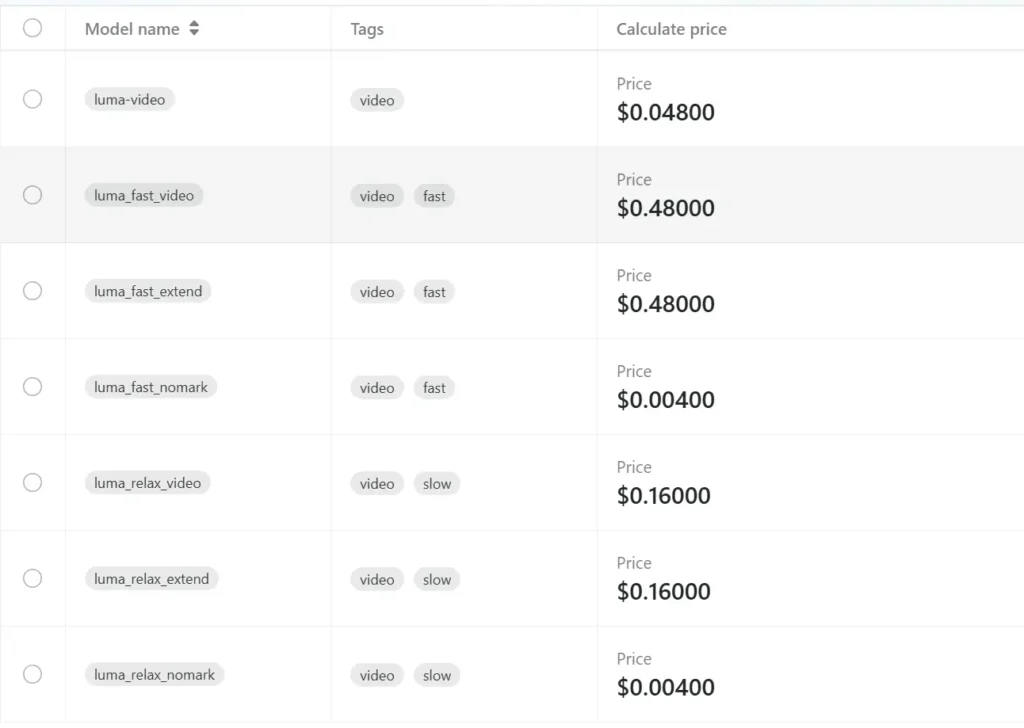

Deweloperzy mogą uzyskać dostęp Interfejs API Luma przez Interfejs API CometNajnowsze wersje modeli podane są na dzień publikacji artykułu. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby pomóc Ci zintegrować: