DeepSeek wydał eksperymentalny model o nazwie DeepSeek-V3.2-Exp on September 29, 2025, wprowadzając nowy mechanizm „sparse-attention” (DeepSeek Sparse Attention, czyli DSA), który zapewnia znacznie niższe koszty wnioskowania w przypadku obciążeń długokontekstowych — a jednocześnie firma obniżyła ceny API o około połowę. Ten przewodnik wyjaśnia, czym jest ten model, najważniejsze informacje o architekturze/funkcjach, jak uzyskać dostęp do API i korzystać z niego (z przykładami kodu), jak wypada w porównaniu z poprzednimi modelami DeepSeek oraz jak analizować i obsługiwać jego odpowiedzi w środowisku produkcyjnym.

Czym jest DeepSeek-V3.2-Exp?

DeepSeek-V3.2-Exp to eksperymentalna iteracja ścieżki V3 DeepSeek. Wydanie – zapowiedziane pod koniec września 2025 roku – jest pozycjonowane jako „przejściowy” krok weryfikujący optymalizacje architektoniczne dla rozszerzonych długości kontekstu, a nie jako duży skok w surowej dokładności. Jego główną innowacją jest DeepSeek Sparse Attention (DSA), wzorzec uwagi, który selektywnie skupia się na częściach długiego sygnału wejściowego, aby zmniejszyć koszty obliczeniowe i pamięci, a jednocześnie zachować jakość danych wyjściowych porównywalną z wersją V3.1-Terminus.

Dlaczego jest to ważne w praktyce:

- Koszt zadań o długim kontekście: DSA koncentruje się na kwadratowym koszcie uwagi, redukując zapotrzebowanie na moc obliczeniową w przypadku bardzo długich danych wejściowych (np. wyszukiwanie wielu dokumentów, długie transkrypcje, duże światy gier). Koszty użytkowania API są znacznie niższe w przypadku typowych zastosowań z długim kontekstem.

- Zgodność i dostępność: Interfejs API DeepSeek wykorzystuje format żądań zgodny ze standardem OpenAI, dzięki czemu możliwe jest szybkie dostosowanie wielu istniejących przepływów pracy pakietu OpenAI SDK.

Jakie są główne cechy i architektura DeepSeek V3.2-Exp?

Czym jest DeepSeek Sparse Attention (DSA) i jak działa?

DSA jest drobnoziarnista, rzadka uwaga Schemat zaprojektowany do selektywnego przetwarzania tokenów, zamiast intensywnego przetwarzania uwagi w całym kontekście. Krótko mówiąc:

- Model dynamicznie wybiera podzbiory tokenów, którymi należy się zająć na każdej warstwie lub bloku, zmniejszając liczbę FLOP-ów w przypadku długich długości danych wejściowych.

- Selekcja ma na celu zachowanie „ważnego” kontekstu dla zadań rozumowania, wykorzystując połączenie wyuczonych zasad selekcji i heurystyki routingu.

DSA jako główna innowacja w wersji 3.2-Exp miała na celu utrzymanie jakości wyników zbliżonej do modeli o dużej koncentracji uwagi, przy jednoczesnym obniżeniu kosztów wnioskowania, zwłaszcza w przypadku wzrostu długości kontekstu. W informacjach o wydaniu i na stronie modelu podkreślono, że konfiguracje treningowe zostały dostosowane do wersji 3.1-Terminus, więc różnice w metrykach benchmarkowych odzwierciedlają mechanizm małej koncentracji uwagi, a nie całkowitą zmianę w treningu.

Jakie inne architektury/funkcje są dostępne w wersji V3.2-Exp?

- Tryby hybrydowe (myślenie kontra niemyślenie): DeepSeek udostępnia dwa identyfikatory modeli:

deepseek-chat(bezmyślne / szybsze odpowiedzi) ideepseek-reasoner(tryb myślenia, który może ujawnić treść dotyczącą łańcucha myśli lub rozumowania pośredniego). Te tryby pozwalają programistom wybierać między szybkością a przejrzystością rozumowania jawnego. - Bardzo duże okna kontekstowe: Rodzina V3.x obsługuje bardzo duże konteksty (linia V3 oferuje w bieżących aktualizacjach 128 KB opcji kontekstowych DeepSeek), co czyni ją odpowiednią do obiegów pracy obejmujących wiele dokumentów, długich dzienników i agentów z dużą ilością wiedzy.

- Dane wyjściowe JSON i wywołanie funkcji stricte (wersja beta): API obsługuje

response_formatObiekt, który może wymusić wyjście JSON (i rygorystyczną wersję beta wywołania funkcji). Przydaje się, gdy potrzebujesz przewidywalnych, parsowalnych przez maszynę wyników do integracji narzędzi. - Tokeny strumieniowe i wnioskowania: Interfejs API obsługuje strumieniowe odpowiedzi i — w przypadku modeli wnioskowania — odrębne tokeny treści wnioskowania (często udostępniane w ramach

reasoning_content), który umożliwia wyświetlanie i audytowanie pośrednich kroków modelu.

Jak uzyskać dostęp do interfejsu API DeepSeek-V3.2-Exp i jak go używać za pośrednictwem CometAPI?

DeepSeek celowo zachowuje format API w stylu OpenAI — dzięki czemu istniejące pakiety SDK OpenAI lub kompatybilne narzędzia można przekierować za pomocą innego adresu URL bazowego. Zalecam korzystanie z CometAPI do dostępu do DeepSeek-V3.2-Exp, ponieważ jest niedrogi i stanowi multimodalną bramkę agregującą. DeepSeek udostępnia nazwy modeli, które odwzorowują zachowanie V3.2-Exp. Przykłady:

DeepSeek-V3.2-Exp-thinking — tryb rozumowania/myślenia odwzorowany na V3.2-Exp.

DeepSeek-V3.2-Exp-thinking — tryb bezrozumny/czatowy odwzorowany na V3.2-Exp.

Jak dokonać uwierzytelnienia i jaki jest adres bazowy URL?

- Uzyskaj klucz API z poziomu konsoli programistycznej CometAPI (aplikuj na ich stronie).

- Adres URL bazowy: (

https://api.cometapi.comorhttps://api.cometapi.com/v1(dla ścieżek zgodnych z OpenAI). Zgodność z OpenAI oznacza, że wiele zestawów SDK OpenAI można przekierować na DeepSeek za pomocą niewielkich zmian.

Jakich identyfikatorów modeli powinienem używać?

DeepSeek-V3.2-Exp-thinking— tryb myślenia, ujawnia treść dotyczącą łańcucha myślowego/rozumowania. Oba zostały zaktualizowane do wersji V3.2-Exp w najnowszych informacjach o wydaniu.DeepSeek-V3.2-Exp-nothinking— brak myślenia, szybsze odpowiedzi, typowe korzystanie z czatu/uzupełnianie.

Przykład: proste żądanie curl (uzupełnienie czatu)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Przykład: Python (wzorzec klienta zgodny z OpenAI)

Ten wzorzec działa po skierowaniu klienta OpenAI na bazowy adres URL CometAPI (lub użyciu zestawu SDK CometAPI). Poniższy przykład jest zgodny ze stylem dokumentacji DeepSeek:

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Nie jest wymagany żaden specjalny zestaw SDK — ale jeśli już korzystasz z pakietu SDK OpenAI, często możesz go ponownie skonfigurować base_url oraz api_key i zachować te same wzorce połączeń.

Zaawansowane zastosowanie: włączanie rozumowania lub reasoning_content

Jeśli potrzebujesz wewnętrznego łańcucha myślowego modelu (do audytu, destylacji lub ekstrakcji etapów pośrednich), przełącz się na DeepSeek-V3.2-Exp-thinking, reasoning_content pole (i powiązany strumień lub tokeny) jest dostępne w odpowiedzi dla trybu wnioskowania; dokumentacja API zapewnia reasoning_content jako pole odpowiedzi, aby sprawdzić CoT wygenerowany przed ostateczną odpowiedzią. Uwaga: ujawnienie tych tokenów może wpłynąć na rozliczenie, ponieważ są one częścią wyników modelu.

Transmisja strumieniowa i częściowe aktualizacje

- Zastosowanie

"stream": truew żądaniach otrzymania delt tokenów poprzez SSE (zdarzenia wysyłane przez serwer). stream_optionsorazinclude_usagepozwala dostosować sposób i czas wyświetlania metadanych dotyczących użytkowania podczas transmisji strumieniowej (przydatne w przypadku przyrostowych interfejsów użytkownika).

Jak DeepSeek-V3.2-Exp wypada w porównaniu z poprzednimi modelami DeepSeek?

Wersja 3.2-Exp vs. wersja 3.1-Terminus

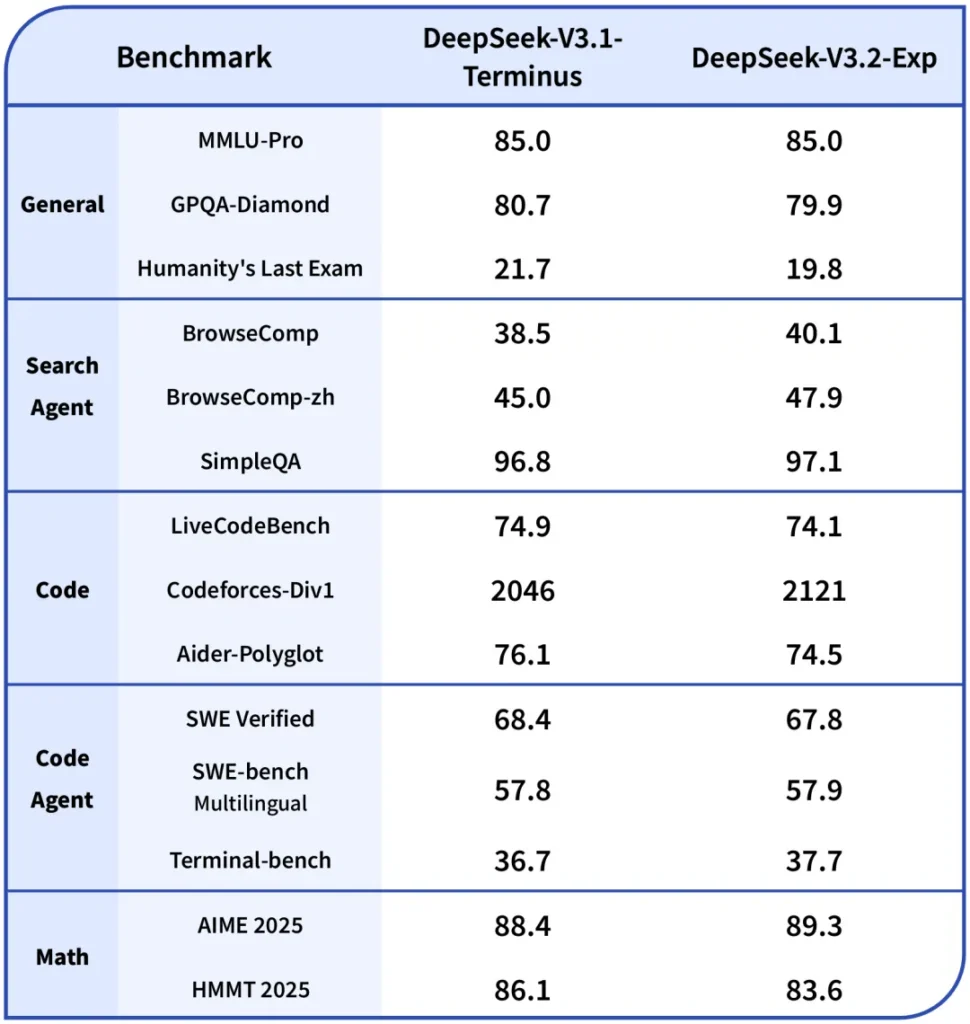

- Podstawowa różnica: Wersja 3.2-Exp wprowadza mechanizm rozproszonej uwagi, który redukuje obliczenia dla długich kontekstów, jednocześnie zachowując zgodność reszty receptury treningowej z wersją 3.1. Dzięki temu DeepSeek mógł dokonać bardziej przejrzystego porównania wzrostu wydajności. ()

- benchmarki: Publiczne notatki wskazują, że V3.2-Exp działa mniej więcej tak samo jak V3.1 w przypadku wielu zadań z zakresu rozumowania/kodowania, a jednocześnie jest zauważalnie tańszy w przypadku długich kontekstów; należy pamiętać, że w przypadku niektórych zadań mogą występować drobne regresje w zależności od tego, w jaki sposób rzadkość uwagi oddziałuje na wymagane interakcje tokenów.

Wersja 3.2-Exp vs R1 / Starsze wersje

- Linie R1 i V3 realizują różne cele projektowe (R1 historycznie koncentrowała się na różnych kompromisach architektonicznych i przepustowości multimodalnej w niektórych gałęziach). V3.2-Exp to udoskonalenie rodziny V3, skoncentrowane na długich kontekstach i przepustowości. Jeśli obciążenie jest duże i wymaga testów dokładności surowych danych w pojedynczych obrotach, różnice mogą być niewielkie; jeśli działasz na potokach wielodokumentowych, profil kosztów V3.2-Exp jest prawdopodobnie bardziej atrakcyjny.

Gdzie uzyskać dostęp do Claude Sonnet 4.5

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Deweloperzy mogą uzyskać dostęp DeepSeek V3.2 Exp poprzez CometAPI, najnowsza wersja modelu jest zawsze aktualizowany na oficjalnej stronie internetowej. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ Zarejestruj się w CometAPI już dziś !

Podsumowanie

DeepSeek-V3.2-Exp to pragmatyczna, eksperymentalna wersja, której celem jest obniżenie kosztów i zwiększenie wykonalności prac z długim kontekstem, przy jednoczesnym zachowaniu jakości wyników klasy V3. Dla zespołów zajmujących się długimi dokumentami, transkrypcjami lub analizą wielu dokumentów, warto przeprowadzić pilotaż: API korzysta z interfejsu w stylu OpenAI, co ułatwia integrację, a także podkreśla mechanizm DSA i znaczące obniżki cen, które zmieniają rachunek ekonomiczny tworzenia oprogramowania na dużą skalę. Jak w przypadku każdego modelu eksperymentalnego, niezbędna jest kompleksowa ewaluacja, instrumentacja i etapowe wdrażanie.