Seria GLM-4.5, opracowana przez Zhipu AI (Z.ai), stanowi znaczący postęp w dziedzinie otwartych modeli językowych (LLM). Zaprojektowana z myślą o ujednoliceniu wnioskowania, kodowania i możliwości agentowych, seria GLM-4.5 oferuje solidną wydajność w różnych aplikacjach. Niezależnie od tego, czy jesteś programistą, badaczem, czy entuzjastą, ten przewodnik zawiera szczegółowe informacje na temat dostępu do serii GLM-4.5 i efektywnego jej wykorzystania.

Czym jest seria GLM-4.5 i dlaczego jest tak ważna?

GLM-4.5 to hybrydowy model rozumowania, który łączy dwa odrębne tryby: „tryb myślenia” do złożonego rozumowania i korzystania z narzędzi oraz „tryb bezmyślenia” do natychmiastowych reakcji. To dwutrybowe podejście pozwala modelowi efektywnie obsługiwać szeroki wachlarz zadań. Seria obejmuje dwa główne warianty:

- GLM-4.5:Model ten, obejmujący łącznie 355 miliardów parametrów, w tym 32 miliardy aktywnych parametrów, jest przeznaczony do wdrożeń na dużą skalę w zakresie wnioskowania, generowania i zadań wieloagentowych.

- GLM-4.5-Powietrze:Lekka wersja zawierająca 106 miliardów parametrów ogółem i 12 miliardów parametrów aktywnych, zoptymalizowana pod kątem wnioskowania na urządzeniach i w chmurze na mniejszą skalę, bez poświęcania podstawowych możliwości.

Oba modele obsługują hybrydowe tryby rozumowania, oferując tryby „myślenia” i „niemyślenia”, aby zrównoważyć złożone zadania wymagające rozumowania i szybkie odpowiedzi. Są one oparte na otwartym kodzie źródłowym i udostępniane na licencji MIT, dzięki czemu są dostępne do użytku komercyjnego i rozwoju wtórnego.

Zasady architektury i projektowania

W swojej istocie GLM-4.5 wykorzystuje MoE do dynamicznego kierowania tokenami przez wyspecjalizowane podsieci eksperckie, co zapewnia wyższą wydajność parametrów i skalowalność (). To podejście oznacza, że mniej parametrów wymaga aktywacji w każdym przejściu do przodu, co obniża koszty operacyjne przy jednoczesnym zachowaniu najwyższej wydajności w zadaniach wnioskowania i kodowania ().

Kluczowe możliwości

- Hybrydowe rozumowanie i kodowanie:GLM-4.5 wykazuje wydajność SOTA zarówno w testach rozumienia języka naturalnego, jak i w testach generowania kodu, często dorównując zastrzeżonym modelom pod względem dokładności i płynności.

- Integracja agentowaWbudowane interfejsy wywoływania narzędzi umożliwiają GLM-4.5 koordynację wieloetapowych przepływów pracy — takich jak zapytania do bazy danych, koordynacja API i generowanie interaktywnego front-endu — w ramach jednej sesji.

- Artefakty multimodalne:GLM-4.5 może tworzyć w pełni funkcjonalne artefakty, od miniaplikacji HTML/CSS po symulacje oparte na Pythonie i interaktywne pliki SVG, zwiększając zaangażowanie użytkowników i produktywność programistów.

Dlaczego GLM-4.5 zmienia zasady gry?

GLM-4.5 został doceniony nie tylko za swoją wydajność, ale także za to, że na nowo zdefiniował wartość propozycji programów LLM typu open source w przedsiębiorstwach i środowisku badawczym.

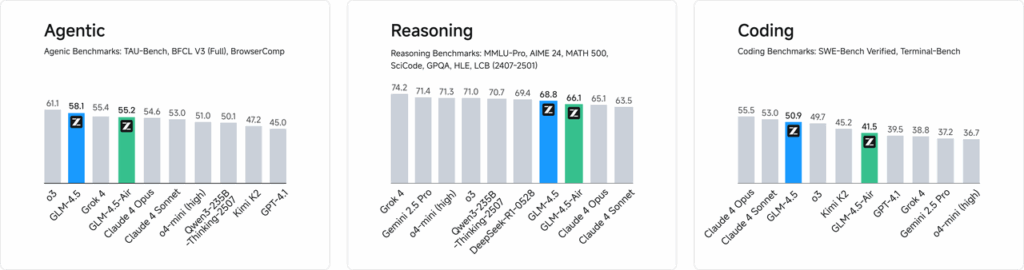

Benchmarki wydajności

W niezależnych ocenach obejmujących 52 zadania programistyczne – obejmujące tworzenie stron internetowych, analizę danych i automatyzację – GLM-4.5 konsekwentnie przewyższał inne wiodące modele open source pod względem niezawodności wywoływania narzędzi i ogólnej realizacji zadań. W testach porównawczych z Claude Code, Kimi-K2 i Qwen3-Coder, GLM-4.5 osiągnął najlepsze w swojej klasie wyniki w testach porównawczych, takich jak ranking „SWE-bench Verified”.

Efektywność kosztowa

Oprócz dokładności, konstrukcja MoE w GLM-4.5 znacząco obniża koszty wnioskowania. Publiczne ceny wywołań API zaczynają się już od 0.8 RMB za milion tokenów wejściowych i 2 RMB za milion tokenów wyjściowych – co stanowi około jedną trzecią kosztów porównywalnych rozwiązań zastrzeżonych. W połączeniu z maksymalną prędkością generowania 100 tokenów/s, model ten obsługuje wdrożenia o wysokiej przepustowości i niskich opóźnieniach bez nadmiernych kosztów.

Jak uzyskać dostęp do GLM-4.5?

1. Bezpośredni dostęp przez platformę Z.ai

Najprostszą metodą interakcji z GLM-4.5 jest platforma Z.ai. Odwiedzając czat.z.aiUżytkownicy mogą wybrać model GLM-4.5 i rozpocząć interakcję za pośrednictwem przyjaznego interfejsu. Platforma ta umożliwia natychmiastowe testowanie i prototypowanie bez konieczności skomplikowanych integracji. Użytkownicy mogą wybrać model GLM-4.5 lub GLM-4.5-Air w lewym górnym rogu i natychmiast rozpocząć rozmowę. Interfejs jest przyjazny dla użytkownika i nie wymaga konfiguracji, co czyni go idealnym do szybkich interakcji i demonstracji.

2. Dostęp do API dla programistów

Platforma API Z.ai zapewnia kompleksowe wsparcie dla programistów, którzy chcą zintegrować GLM-4.5 z aplikacjami. API oferuje interfejsy zgodne z OpenAI dla modeli GLM-4.5 i GLM-4.5-Air, ułatwiając bezproblemową integrację z istniejącymi procesami. Szczegółowa dokumentacja i wytyczne dotyczące integracji są dostępne na stronie: Dokumentacja API Z.ai .

3. Wdrożenie Open Source

Dla osób zainteresowanych wdrożeniem lokalnym modele GLM-4.5 są dostępne na platformach takich jak Hugging Face i ModelScope. Modele te są udostępniane na licencji open source MIT, co pozwala na ich komercyjne wykorzystanie i rozwój wtórny. Można je zintegrować z popularnymi platformami wnioskowania, takimi jak vLLM i SGLang.

4. Integracja z CometAPI

Interfejs API Comet oferuje uproszczony dostęp do modeli GLM-4.5 poprzez swoją ujednoliconą platformę API pod adresem DasboradTa integracja upraszcza uwierzytelnianie, ograniczanie przepustowości i obsługę błędów, co czyni ją doskonałym wyborem dla programistów poszukujących bezproblemowej konfiguracji. Dodatkowo, standardowy format API CometAPI umożliwia łatwe przełączanie modeli i testowanie A/B między GLM-4.5 a innymi dostępnymi modelami.

W jaki sposób deweloperzy mogą uzyskać dostęp do serii GLM-4.5?

Istnieje wiele kanałów umożliwiających uzyskanie i wdrożenie GLM-4.5 — od bezpośredniego pobrania modeli po zarządzane interfejsy API.

Za pośrednictwem Hugging Face i ModelScope

Zarówno Hugging Face, jak i ModelScope hostują pełną serię GLM-4.5 w przestrzeni nazw zai-org. Po zaakceptowaniu licencji MIT programiści mogą:

- Sklonuj repozytorium:

git clone https://huggingface.co/zai-org/GLM-4.5

- Zainstaluj zależności:

pip install transformers accelerate

- Załaduj model:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Przez CometAPI

Interfejs API Comet zapewnia bezserwerowe API dla GLM‑4.5 oraz GLM-4.5 Air API w cenach pay-per-token, dostępnych za pośrednictwem, konfigurując punkty końcowe zgodne z OpenAI, możesz wywołać GLM-4.5 za pomocą klienta Python OpenAI z minimalnymi modyfikacjami istniejących baz kodu. CometAPI udostępnia nie tylko GLM4.5 i GLM-4.5-air, ale także wszystkie oficjalne modele:

| Nazwa modelu | przedstawiać | Cena |

glm-4.5 | Nasz najpotężniejszy model wnioskowania z 355 miliardami parametrów | Tokeny wejściowe 0.48 USD Tokeny wyjściowe 1.92 USD |

glm-4.5-air | Ekonomiczny, lekki, o dużej wydajności | Tokeny wejściowe 0.16 USD Tokeny wyjściowe 1.07 USD |

glm-4.5-x | Wysoka wydajność, silne rozumowanie, ultraszybka reakcja | Tokeny wejściowe 1.60 USD Tokeny wyjściowe 6.40 USD |

glm-4.5-airx | Lekka, wytrzymała, ultraszybka reakcja | Tokeny wejściowe 0.02 USD Tokeny wyjściowe 0.06 USD |

glm-4.5-flash | Wysoka wydajność, doskonała do kodowania wnioskowania i agentów | Tokeny wejściowe 3.20 USD Tokeny wyjściowe 12.80 USD |

Integracja Pythona i REST API

W przypadku wdrożeń niestandardowych organizacje mogą hostować GLM-4.5 na dedykowanych klastrach GPU, korzystając z Dockera lub Kubernetesa. Typowa konfiguracja RESTful obejmuje:

Uruchamianie serwera wnioskowania:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Wysyłanie żądań:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Jakie są najlepsze praktyki integracji GLM-4.5 w aplikacjach?

Aby zmaksymalizować zwrot z inwestycji i zagwarantować solidną wydajność, zespoły powinny wziąć pod uwagę następujące kwestie:

Optymalizacja API i limity przepustowości

- Żądania wsadowe:Grupuj podobne monity, aby zmniejszyć obciążenie i wykorzystać przepustowość GPU.

- Buforowanie typowych zapytań:Przechowuj często uzupełniane dane lokalnie, aby uniknąć zbędnych wywołań wnioskowania.

- Próbkowanie adaptacyjne: Dynamicznie dostosuj

temperatureoraztop_pna podstawie złożoności zapytania, aby zrównoważyć kreatywność i determinizm.

Bezpieczeństwo i zgodność

- Oczyszczanie danych:Wstępnie przetwórz dane wejściowe, aby usunąć poufne informacje przed wysłaniem ich do modelu.

- Kontrola Dostępu:Wdrożenie kluczy API, list dozwolonych adresów IP i ograniczanie przepustowości w celu zapobiegania niewłaściwemu wykorzystaniu i nadużyciom.

- Rejestrowanie audytu:Rejestrowanie monitów, uzupełnień i metadanych w celu zapewnienia zgodności z wymogami korporacyjnymi i regulacyjnymi, zwłaszcza w kontekście finansów lub opieki zdrowotnej.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Platforma CometAPI oferuje solidne rozwiązanie dla programistów, którzy chcą zintegrować GLM-4.5 ze swoimi aplikacjami. API oferuje interfejsy zgodne z OpenAI, umożliwiając bezproblemową integrację z istniejącymi procesami pracy. Szczegółowa dokumentacja i wskazówki dotyczące użytkowania są dostępne na stronie. Strona API Comet.

Deweloperzy mogą uzyskać dostęp GLM‑4.5 oraz GLM-4.5 Air API przez Interfejs API CometNajnowsze wersje modeli podane są na dzień publikacji artykułu. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Podsumowanie

GLM-4.5 stanowi znaczący postęp w dziedzinie dużych modeli językowych, oferując wszechstronne rozwiązanie dla szerokiej gamy aplikacji. Jego hybrydowa architektura wnioskowania, możliwości agentowe i otwartoźródłowy charakter czynią go atrakcyjną opcją dla programistów i organizacji poszukujących możliwości wykorzystania zaawansowanych technologii sztucznej inteligencji. Dzięki poznaniu różnych metod dostępu opisanych w tym przewodniku, użytkownicy mogą skutecznie zintegrować GLM-4.5 ze swoimi projektami i przyczynić się do jego ciągłego rozwoju.