Firma OpenAI niedawno ogłosiła kilka aktualizacji, w tym wydanie modelu GPT-5-Codex-Mini, udoskonalenie limitu szybkości dla hierarchii wielodostępnych oraz optymalizację wydajności przetwarzania modeli.

OpenAI's GPT-5-Codex-Mini to nowo ogłoszony wariant GPT-5-Codex, zorientowany na deweloperów: mniejszy, zoptymalizowany pod kątem kosztów i przepustowości model, który ma zapewnić większość wsparcia kodowania oferowanego przez GPT-5-Codex, ale przy znacznie niższych kosztach i większej użytecznej objętości. Wariant „Mini” jest pozycjonowany jako pragmatyczny wybór dla długich sesji kodowania, automatyzacji w tle i częstych przepływów pracy deweloperów, gdzie surowa wydajność szczytowa jest mniej ważna niż uzyskanie większej liczby tokenów/żądań w ramach tego samego planu.

Czym jest GPT-5-Codex-Mini i jakie ma funkcje?

GPT-5-Codex-Mini to kompaktowa, ekonomiczna wersja rodziny GPT-5-Codex firmy OpenAI, stworzona specjalnie z myślą o produktach Codex (integracja CLI i IDE). Jest ona pozycjonowana jako „mniejszy, bardziej ekonomiczny” model, który oferuje niewielką ilość mocy obliczeniowej w szczytowym momencie, znacznie niższe zużycie zasobów i wyższy limit wykorzystania dla interaktywnych przepływów pracy programistów. Model mini ma umożliwić programistom wykonywanie znacznie większej liczby tury kodowania (OpenAI opisuje około 4× większe wykorzystanie dla tego samego poziomu subskrypcji ChatGPT) przy jednoczesnym zachowaniu niskich opóźnień i kosztów w przypadku typowych, ściśle określonych zadań inżynieryjnych.

Pod względem możliwości, GPT-5-Codex-Mini dziedziczy kluczowe cechy linii produktów Codex: dogłębne zrozumienie bazy kodu i wykonywanie wieloetapowych zadań w sposób „agentowy”. W oparciu o funkcje Codex CLI, programiści mogą przesyłać polecenia w języku naturalnym, fragmenty kodu, zrzuty ekranu lub diagramy projektu interfejsu do Codex w interaktywnym terminalu. Model najpierw dostarczy plan, a następnie automatycznie przegląda pliki, edytuje kod, uruchamia polecenia i testuje po uzyskaniu zgody użytkownika.

Z perspektywy modalnej, produkty Codex umożliwiają dołączanie obrazów (takich jak zrzuty ekranu interfejsu użytkownika, projekty graficzne czy zrzuty ekranu z komunikatami o błędach) do sesji w terminalu lub środowisku IDE. Model ten potrafi interpretować zarówno treść tekstową, jak i graficzną, ale wynik nadal składa się głównie z kodu tekstowego i objaśnień. Dlatego GPT-5-Codex-Mini można traktować jako model proxy kodu, który składa się głównie z tekstu + obrazu wejściowego, tekstu wyjściowego i nie realizuje zadań takich jak generowanie obrazu, dźwięku czy wideo.

Jak GPT-5-Codex-Mini wypada w porównaniu z GPT-5-Codex?

Co nowego w Kodeksie?

Oprócz wydania GPT-5-Codex-Mini, OpenAI jednolicie zwiększyło limit przepustowości Codex o 50% dla użytkowników ChatGPT Plus, Business i Edu, znacząco zwiększając dostępny limit żądań. Jednocześnie użytkownicy ChatGPT Pro otrzymają priorytetowe uprawnienia do przetwarzania, co przyspieszy reakcję i usprawni wykonywanie zadań.

Ponadto OpenAI wprowadziło niewielką aktualizację modelu GPT-5-Codex, optymalizując jego wydajność w scenariuszach współpracy. Zaktualizowany model wykazuje poprawę o kilka punktów procentowych w kluczowych wskaźnikach ewaluacyjnych, około 3% wzrost efektywności wykorzystania tokenów oraz większą niezawodność w obsłudze przypadków brzegowych, zmniejszając tym samym potrzebę korzystania ze wskazówek dla użytkowników.

| poziom użytkownika | Kodeks GPT-5 | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | zwiększa głośność wiadomości odpowiednio o 1.5x. | zwiększa głośność wiadomości odpowiednio o 6x. |

GPT-5-Codex-Mini vs GPT-5-Codex: różnice w testach porównawczych

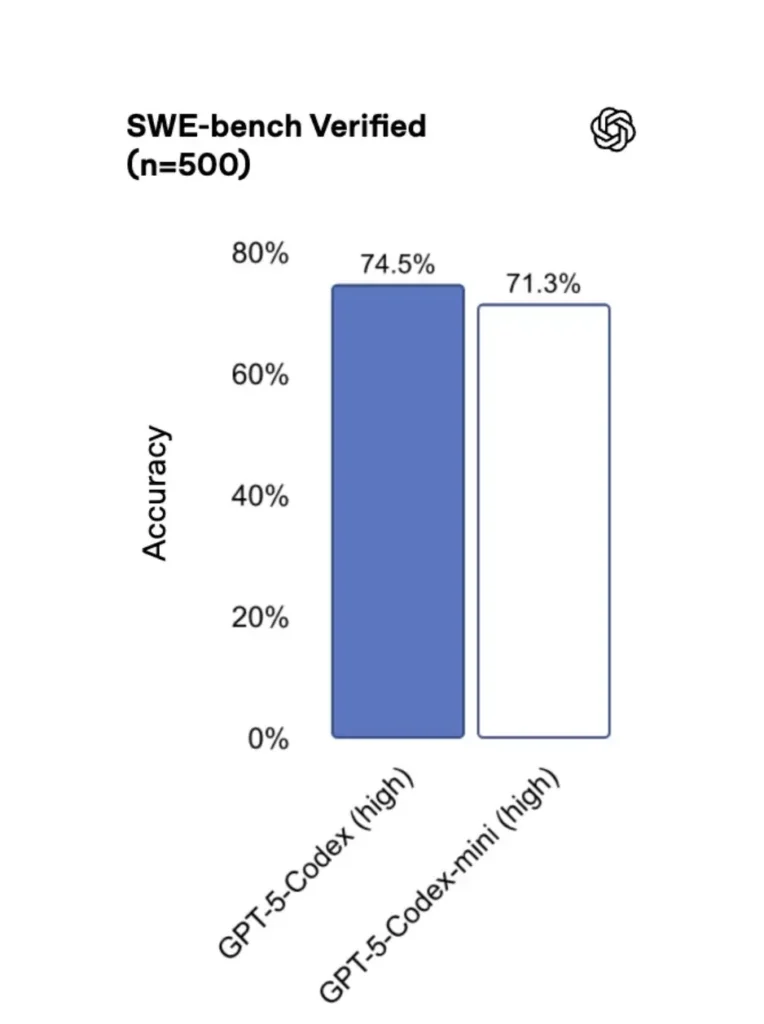

W porównaniu z wersją oryginalną, wydajność GPT-5-Codex-Mini jest nieznacznie niższa, ale programiści otrzymują około czterokrotnie więcej punktów za wykorzystanie. W teście SWE-bench Verified, GPT-5 High uzyskał 72.8%, GPT-5-Codex 74.5%, a GPT-5-Codex-Mini 71.3%.

Codex (i jego miniaturowa wersja) używają znacznie mniej tokenów do lekkich interakcji — materiały OpenAI twierdzą, że w przypadku prostych monitów można zmniejszyć ich liczbę o kilkadziesiąt punktów procentowych (np. cytowana liczba ≈93.7% mniej tokenów na temat lekkich interakcji dla rodziny Codex w porównaniu z GPT-5 w niektórych scenariuszach).

GPT-5-Codex-Mini vs GPT-5-Codex: różnice w funkcjach

- Rozmiar i koszt: Mini jest wyraźnie mniejszy i bardziej ekonomiczny; OpenAI przedstawia go jako rozwiązanie umożliwiające około czterokrotnie większe wykorzystanie przy tych samych ograniczeniach subskrypcji. Jest to optymalizacja limitów/wydajności dla rutynowych zadań programistycznych.

- Zakres możliwości: GPT-5-Codex pozostaje opcją o większych możliwościach w przypadku długich, złożonych zadań agentowych (duże refaktoryzacje, dogłębne przeglądy kodu, wydłużone cykle testowania). Wersja Mini jest dostrojona tak, aby działać szybciej i mniej obciążać zasoby w przypadku częstych, krótkich interakcji.

- Limity opóźnień i szybkości transmisji: Wersja Mini zazwyczaj zapewnia mniejsze opóźnienia i pozwala na wyższe limity przepustowości w ramach planu, dzięki czemu nadaje się do gęstych, interaktywnych przepływów pracy.

- Domyślne powierzchnie: Mini jest dostępny jako model do wyboru w Codex CLI oraz rozszerzeniu IDE; GPT-5-Codex jest modelem domyślnym dla zadań w chmurze oraz przepływów dogłębnego przeglądu kodu w Codex.

Kiedy używać Mini Codexu a kiedy Pełnego Codexu

- Zastosowanie Mini do: tworzenia rusztowań, powtarzalnego generowania kodu, drobnych refaktoryzacji, interaktywnych uzupełnień podczas edycji oraz podczas pracy w ramach limitu lub ograniczeń kosztowych.

- Zastosowanie Kodeks GPT-5 do: kompleksowych przeglądów kodu, wielogodzinnych zadań autonomicznych, złożonych refaktoryzacji i zadań wymagających najsilniejszego wnioskowania modelu i wykonania sterowanego testami.

Jak uzyskać dostęp do GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (najpierw terminal)

Wprowadzono OpenAI gpt-5-codex-mini jako opcja modelu w interfejsie Codex CLI. Typowe schematy użytkowania są zgodne z przepływem pracy w interfejsie Codex CLI: uruchamianie sesji interaktywnej, określanie modelu, dołączanie plików lub zrzutów ekranu, uruchamianie „zadań w chmurze Codex” i wiele więcej. Interfejs CLI obsługuje również szybkie /model przełączanie między pełnym gpt-5-codex oraz gpt-5-codex-miniPodczas pierwszego uruchomienia konieczne będzie uwierzytelnienie za pomocą konta ChatGPT/Pro/Enterprise (lub podanie klucza API). Interfejs wiersza poleceń udostępnia różne polecenia, które umożliwiają Codexowi skanowanie baz kodu, uruchamianie testów, otwieranie plików REPL lub stosowanie rekomendowanych poprawek.

Przykład (interaktywna sesja Codex CLI):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Ten przepływ pracy odzwierciedla nowe domyślne ustawienia Codex CLI, w których narzędzie będzie sugerować tryb Mini w pobliżu limitów użytkowania.

Rozszerzenie VS Code / IDE

Tak — rozszerzenie Codex IDE (VS Code) zawiera już gpt-5-codex-mini Opcjonalnie. Zainstaluj rozszerzenie Codex w Visual Studio Code, aby korzystać z funkcji uzupełniania kodu w tekście, sugestii refaktoryzacji i szybkich poprawek opartych na sztucznej inteligencji. Rozszerzenie udostępnia również szybkie akcje (generowanie kodu, objaśnianie zaznaczonego kodu, refaktoryzacja) i może uruchamiać zadania Codex Cloud z poziomu edytora i kroków VS Code:

- Zainstaluj rozszerzenie OpenAI Codex / ChatGPT dla VS Code.

- Zaloguj się na swoje konto ChatGPT (Plus/Pro/Business).

- Otwórz paletę poleceń:

Cmd/Ctrl+Shift+P → Codex: Set Model→ wybierzgpt-5-codex-mini. - Użyj poleceń wbudowanych (wybierz kod → kliknij prawym przyciskiem myszy → „Wyjaśnij za pomocą Kodeksu” lub naciśnij skonfigurowany klawisz skrótu).

Przykład: polecenie wbudowane w VS Code (pseudokroki)

- Wybierz funkcję w

user_service.py. - Naciśnij przycisk

Cmd/Ctrl+Shift+P → Codex: Explain Selectionlub kliknij prawym przyciskiem myszy → „Wyjaśnij za pomocą Kodeksu”. - Rozszerzenie otwiera panel boczny z wyjaśnieniami Mini, sugerowanymi testami i przyciskiem „Utwórz PR” dostępnym po kliknięciu, który wykorzystuje zadania Codex Cloud do przesłania gałęzi do przeglądu.

A co z API? Czy mogę je wywołać z mojej aplikacji?

Ogłoszenia OpenAI wskazują Obsługa API będzie wkrótce dostępna Dla GPT-5-Codex-Mini; w momencie pisania tego tekstu model jest dostępny najpierw w łańcuchu narzędzi Codex (CLI/IDE). Oznacza to, że klienci API produkcyjnego powinni przygotować się na nazwę modelu. gpt-5-codex-mini w API Żądań/Odpowiedzi po jego opublikowaniu. W międzyczasie możesz tworzyć prototypy za pomocą interfejsów CLI i przepływów IDE Codex.

Gdy dostęp do API jest włączony, typowe wywołanie (w stylu odpowiedzi) może wyglądać następująco:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Jakie są najlepsze praktyki w zakresie szybkiego inżynieringu przy użyciu Codex Mini?

Poniżej przedstawiono konkretne, sprawdzone w praktyce najlepsze praktyki i wzorce pozwalające uzyskać maksymalną wartość z Codex Mini w procesach inżynierii produkcji.

1) Strategia wyboru modelu — mieszaj i dopasowuj

Użyj Mini do zadań o wysokiej częstotliwości i niskiej złożoności (formatowanie, drobne refaktoryzacje, testy automatyczne), a w przypadku złożonych projektów, głębokiego debugowania lub dużych transformacji obejmujących całe repozytorium, skorzystaj z pełnego Codex. Zautomatyzuj przełączanie: interfejs wiersza poleceń Codex sugeruje Mini już przy 90% wykorzystaniu, a Ty możesz tworzyć skrypty. /model przełączanie narzędzi w celu wybrania modelu na podstawie złożoności zadania.

2) Szybkie szablony inżynieryjne

Twórz małe, deterministyczne szablony poleceń dla powtarzalnych zadań: generowania testów, szkiców rejestru zmian, generowania komunikatów commit i opisów żądań zmian (PR). Przechowuj je jako wielokrotnego użytku fragmenty kodu w repozytorium lub jako ustawienia wstępne poleceń w Kodeksie.

Przykładowy szablon monitu dla testów jednostkowych:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Zautomatyzuj sieci bezpieczeństwa — zatwierdzenia i bramki CI

Nigdy nie pozwalaj modelowi na bezpośrednie przesyłanie kodu bez zgody człowieka. Użyj trybów zatwierdzania Codex i zadań Codex Cloud, aby tworzyć różnice i wymagać zatwierdzenia przez człowieka w CI. Interfejs wiersza poleceń Codex obsługuje „tryby zatwierdzania”, więc zmiany muszą zostać zatwierdzone przed zastosowaniem.

4) Wywołania modelu pamięci podręcznej i deduplikacji

W przypadku powtarzających się monitów (np. objaśniających funkcję) zapisz w pamięci podręcznej odpowiedź zapisaną jako monit + skrót pliku. Zmniejsza to liczbę zbędnych wywołań i zapewnia przewidywalność profilu kosztów.

5) Użyj strumieniowania + przyrostowych różnic

W miarę możliwości żądaj strumieniowych wyników i przyrostowych różnic zamiast przepisywania całych plików. Zmniejsza to zużycie tokenów i pomaga recenzentom dostrzec celowe zmiany.

6) Test jednostkowy – przepływ generatora w pierwszej kolejności

Generuj testy i uruchamiaj je lokalnie w środowisku efemerycznym. Jeśli testy zakończą się niepowodzeniem, iteruj z modelem, dostarczając poprawki dla nieudanych testów. Uporządkuj każdą iterację jako oddzielny monit z uwzględnionymi wynikami testów.

Przykładowy fragment kodu automatyzacji Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Podsumowanie

GPT-5-Codex-Mini to pragmatyczne posunięcie produktowe: uwzględnia fakt, że przepływy pracy programistów często opierają się na wielu krótkich interakcjach, w których istotne są opóźnienia, koszty i nieprzerwany przepływ. Zapewniając mini-warstwę przeznaczoną do wykorzystania w środowisku IDE i interfejsie wiersza poleceń, OpenAI daje zespołom możliwość skalowania codziennej pomocy w programowaniu bez konieczności natychmiastowego stosowania modelu o najwyższych kosztach dla każdej interakcji.

Deweloperzy mogą uzyskać dostęp API GPT-5-Codex ,Interfejs API GPT-5 Pro Najnowsze modele CometAPI wymienione w CometAPI są aktualne na dzień publikacji artykułu. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API.Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ Zarejestruj się w CometAPI już dziś !

Jeśli chcesz poznać więcej wskazówek, poradników i nowości na temat sztucznej inteligencji, obserwuj nas na VK, X oraz Discord!