Wiadomości o Gemini 3.0 są od sierpnia jednym z najgłośniejszych tematów wśród deweloperów. Nieustannie pojawiają się doniesienia z ufnością zapowiadające datę premiery, ale okazuje się, że do niej nie doszło. Nadzieje wielokrotnie były rozwiewane, ale oczekiwania wciąż są wysokie – ponieważ wydajność Gemini 2.5 Pro już dawno spadła w porównaniu z konkurencją, Chatgpt i Claude. Teraz przedstawię Wam najnowsze informacje z pierwszej ręki i z przyjemnością ogłaszam, że jest już dostępny na platformie. Interfejs API Comet.

Nowa generacja Gemini 3 firmy Google wywołała więcej przecieków niż większość premier produktów — punkty kontrolne społeczności pojawiły się na publicznych stronach z testami porównawczymi, nazwy modeli pojawiły się w narzędziach Google, a aktywna ścieżka dla programistów umożliwiała testowanie modeli za pośrednictwem interfejsu Gemini CLI i CometAPI.

Czym jest Gemini 3.0 i dlaczego jest tak wyczekiwane?

Ogólnie rzecz biorąc, Gemini 3.0 to następna główna iteracja z rodziny Gemini, dużych, multimodalnych modeli AI opracowanych przez Google DeepMind (i jego spółkę macierzystą Google LLC). Seria Gemini jest pozycjonowana jako flagowa linia modeli AI Google – stworzona nie tylko do rozumienia i generowania tekstu, ale także zadania multimodalne (tekst + obraz + kod + dźwięk/wideo), rozumowanie, używanie narzędzi i ostatecznie bardziej sprawcze zachowanie.

Powodem, dla którego ludzie są tak podekscytowani Gemini 3.0, jest to, że wydaje się on przedstawiać wielki krok naprzód — nie tylko drobna aktualizacja — w zakresie możliwości modelu, długości kontekstu, wnioskowania i praktycznej użyteczności. Przecieki ze społeczności, referencje do kodu, sygnały z testów porównawczych i artykuły sugerują, że Gemini 3.0 wkroczy na nowe terytorium „modeli myślowych”, dłuższych okien kontekstowych, głębszej integracji multimodalnej i orkiestracji narzędzi agentowych.

Poniżej dokładnie opiszę dlaczego to ma znaczenie, co wiemy do tej pory, co jest nadal spekulatywne.

Czym są „lithiumflow” i „orionmist” i dlaczego pojawiły się na LMArena?

Co odkryli LM Arena i społeczność?

W dniach 19–23 października badacze społeczności odkryli dwa nowe punkty kontrolne LM Arena o nazwach lithiumflow i orionmist. Nazwy te wydają się być zgodne z wewnętrznymi konwencjami nazewnictwa Google (nazwa „orion” była używana w poprzednich nazwach kodowych Gemini), a analitycy społeczności interpretują je jako wczesne identyfikatory lub punkty kontrolne wariantów Gemini 3.x — potocznie określanych jako punkty kontrolne Gemini 3 Pro/Flash.

Dlaczego to ma znaczenie?

Jeśli Lithiumflow i Orionmist są prawdziwymi punktami kontrolnymi Gemini 3, podział sugeruje, że Google może przygotowywać wiele podrodzin (Flash i Pro): np. wariant „Lithiumflow” zoptymalizowany pod kątem przepustowości i wydajności oraz wariant „Orionmist” dostrojony do aktualnego wyszukiwania lub możliwości multimodalnych. Lithiumflow wydaje się (według spekulacji społeczności) podstawowym modelem generacji dostrojonym do wnioskowania/generowania (bez uziemienia wyszukiwania). Orionmist wydaje się być wariantem z integracją z danymi zewnętrznymi/wyszukiwaniem w czasie rzeczywistym, prawdopodobnie silniejszym w generowaniu rozszerzonym o wyszukiwanie lub zadaniach „na żywo”.

Mój test

Pokaz meldunkowy w LM Arena bardzo silny Wyniki dla LithiumFlow w zadaniach języka klasycznego (rozumowanie, kodowanie i niektóre zadania SVG/układu). Kilku analityków społeczności opublikowało również porównania, w których stwierdzili, że LithiumFlow przewyższa obecną publiczną wersję Gemini 2.x i inne współczesne wersje w określonych mikrotestach porównawczych.

Korzystanie z Lithiumflow do pisania zapewnia większą kreatywność i jakość literacką niż Gemini 2.5, ale liczba słów pozostaje słabym punktem – zaledwie dwa do trzech tysięcy. W połączeniu z OrionMist, może dorównać Claude 4.5 pod względem wydajności i dokładności kodowania, ale różnica nie jest znacząca.

Oto porównanie tych modeli w dotychczasowych testach porównawczych:

| Benchmark | Gemini 3.0 (przepływ litu) | Gemini 3.0 (orionmist) | Bliźnięta 2.5 Pro | Claude Opus 4.1 | Klaudiusz 3.7 Sonet |

|---|---|---|---|---|---|

| SimpleBench | 80-100% | 80-100% | 62.4% | 60.0% | 46.4% |

Oba modele nadal wykazywały iluzje i niestabilność w niektórych zadaniach opartych na wiedzy – co jest zrozumiałe w przypadku wczesnego podglądu. Ten wzorzec (doskonalenie w zadaniach kreatywnych i generowanie doskonałej struktury/kodu, ale okazjonalne występowanie błędów merytorycznych) jest powszechny, gdy modele są łączone z nowatorskimi możliwościami multimodalnymi lub generowania kodu.

Zakończyły się testy tych dwóch modeli w LM Arena, co potwierdziło, że są to rzeczywiście Gemini 3.0.

Zaangażowanie Apple i wyciek specyfikacji

Różnice w modelach

W połowie 2025 r. Jabłko podobno wyciekły fragmenty kodu w wersji beta systemu iOS, pokazujące takie identyfikatory, jak com.google.gemini_3_pro oraz gemini_3_ultra.

Analitycy wywnioskowali, że Google i Apple przygotowywały się Integracje z „Apple Intelligence” oparte na technologii Gemini, prawdopodobnie dla Siri i podsumowania na urządzeniu:

- Gemini 3 Pro (warstwa wnioskowania oparta na chmurze)

- Gemini 3 Nano (wariant na urządzeniu)

- Wnioskowanie multimodalne w czasie rzeczywistym

Jest to zgodne z dążeniem Google do Tkanina AI łączenie urządzeń mobilnych, interfejsów API w chmurze i ekosystemu internetowego.

Wyciek specyfikacji

Apple i Google negocjują głębszą integrację Gemini dla Apple Intelligence/Siri — informacja o planach Apple dotyczących wykorzystania niestandardowego wariantu Gemini w swoim stosie AI. Apple i Google wspomniały o parametrze 1.2T w swoim wspólnym planie dotyczącym modeli sztucznej inteligencji, który może być specyfikacją Gemini 3.0.

Jak rozpocząć korzystanie z wersji zapoznawczej Gemini 3 Pro

Na podstawie dostępnych informacji i testów przedstawię trzy metody: Vertex, Gemini CLI i API. Programiści mogą wybrać metodę najlepiej odpowiadającą ich potrzebom i środowisku. Modele Gemini 3.0 Pro to gemini-3-pro-preview-11-2025 i gemini-3-pro-preview-11-2025-thinking.

Dostęp do wierzchołka

Gemini 3.0 pro (gemini-3-pro-preview-11-2025) został dodany do listy modeli Vertex, a niektórzy użytkownicy ze społeczności twierdzą, że mogą go przetestować bezpośrednio, pod warunkiem posiadania płatnego konta Vertex i uzyskania do niego dostępu za pomocą danych logowania do konta. Rzeczywiście, ślady można znaleźć w dziennikach sieciowych Vertex:

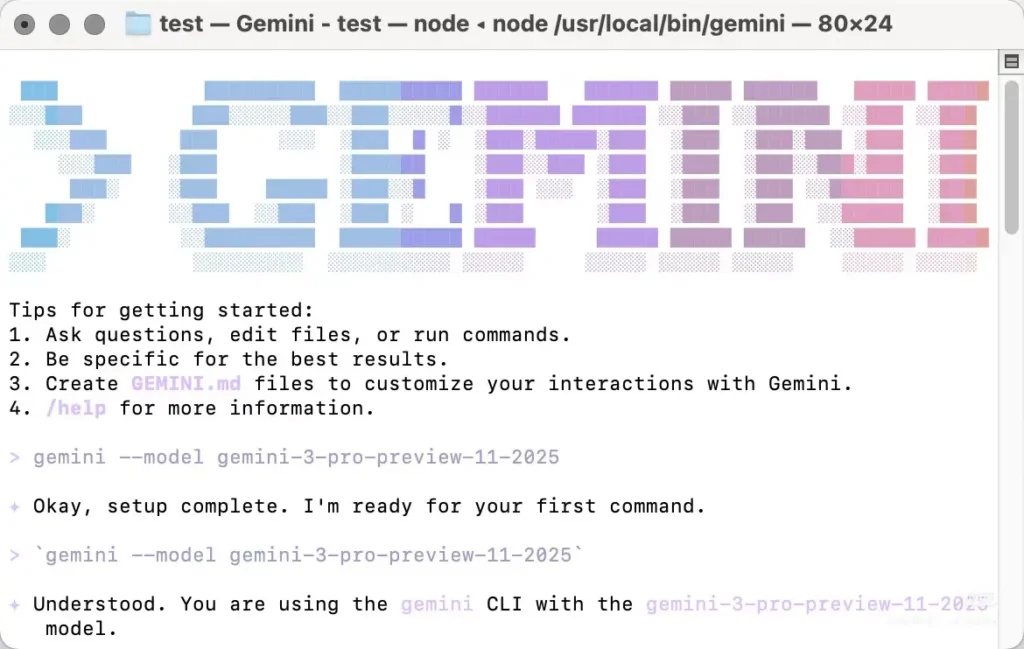

Accoss Gemini cli

Gemini 3.0 Pro można również wywołać z poziomu Gemini CLI, ale model wymaga ręcznego określenia podczas jego używania. Większość najnowszych recenzji Gemini 3.0 Pro pochodzi z użycia Gemini CLI. Ma on jednak pewne wady: działa tylko z niektórymi węzłami w Ameryce Północnej, wymagając ręcznej zmiany lokalnego adresu IP, a próba może wymagać wielokrotnych prób. Nie jest zbyt stabilny i zwraca błąd 404 w przypadku niepowodzenia.

Musisz zainstaluj Gemini CLI lokalnie, a następnie uwierzytelnij się za pomocą konta z uprawnieniami dostępu (konto Google/konto CometAPI) i ręcznie określ nazwę modelu „gemini-3-pro-preview-11-2025„aby użyć Gemini 3.0 pro-preview, Przykład: zainstaluj i uruchom (powłoka)

```bash

# instant run (no install)

npx https://github.com/google-gemini/gemini-cli

or install globally:

npm install -g @google/gemini-cli

# or on macOS/Linux using Homebrew

brew install gemini-cli

Interfejs wiersza poleceń akceptuje identyfikatory modeli w taki sam sposób jak API. W praktyce: ustaw identyfikator modelu (na przykład `model: "gemini-3-pro-preview-11-2025"`) w żądaniu CLI lub konfiguracji i wywołaj je — jeśli Twoje konto ma dostęp, żądanie zostanie zrealizowane pomyślnie.

### Dostęp do interfejsu API CometAPI

[Interfejs API Comet](https://www.cometapi.com/pl/) to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców – takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych – w jednym, przyjaznym dla programistów interfejsie. Oferuje spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi.

CometAPI zintegrował [Gemini 3 Pro Podgląd API](https://www.cometapi.com/pl/gemini-3-pro-api/) , a nazwa wewnętrznego wywołania API to `gemini-3-pro-preview`Podczas wykonywania połączenia wystarczy zmienić adres żądania na `https://api.cometapi.com/v1/chat/completions`.

Wersję zapoznawczą Gemini 3.0 pro można wywołać w taki sam sposób, jak API OpenAI. Z moich testów wynika, że wywołanie przez CometAPI jest stabilniejsze niż za pomocą interfejsu wiersza poleceń Gemini.

## Jakie są przewidywane cechy Gemini 3.0?

Poniżej znajdują się najczęściej omawiane możliwości (z wyraźnym wskazaniem, które elementy zostały potwierdzone, a które nie, zgodnie z oczekiwaniami społeczności/analityków).

### Projekt główny i architektura (potwierdzone a oczekiwane)

- **Fundament multimodalny:** Gemini jest zbudowane jako rodzina multimodalna (tekst, obrazy, kod, audio/wideo), a Google opublikował już modele multimodalne i narzędzia w API Gemini. Jest to potwierdzone i nadal będzie miało kluczowe znaczenie.

- **Zaawansowane rozumowanie/planowanie:** Można spodziewać się głębszej integracji planowania i technik RL, opartej na badaniach DeepMind – co prawdopodobnie będzie różnicą w nacisku na projekt w porównaniu z niektórymi konkurentami. Jest to oczekiwanie oparte na historii DeepMind, a nie na publicznej specyfikacji.

### Okno kontekstowe i pamięć

Dłuższe okna kontekstowe: Gemini 3.0 zwiększy efektywną pojemność kontekstu (dyskusje spekulują na temat milionów tokenów), bazując na wcześniejszych pracach nad dużymi kontekstami. To tylko przewidywanie — Google nie opublikował jeszcze oficjalnych limitów tokenów Gemini 3.0.

### Wydajność, opóźnienie i warianty modelu

- **Wysoka dokładność rozumowania i kodowania:** Posty społeczności na LM Arena dotyczące „lithiumflow” (i „orionmist”) sugerują wysoką wydajność w zadaniach wnioskowania i kodowania. To niezweryfikowane testy porównawcze społeczności, ale stanowią główny powód do ekscytacji. Traktuj je jako wczesne sygnały, a nie ostateczny dowód.

- **Wiele wariantów:** Plotki i przecieki wskazują na różne wersje – wariant „Pro”/surowej generacji (często kojarzony we wpisach z tagiem lithiumflow) oraz wariant uziemiony/z włączoną funkcją wyszukiwania (orionmist). Ponownie, są to wnioski społecznościowe z identyfikatorów modeli i zachowań testowych.

### Multimodalność i nowe możliwości

- **Integracja wideo i obrazu:** Google niedawno udostępniło modele wideo (np. Veo 3) i funkcje obrazowania w API Gemini; Gemini 3.0 ma je wykorzystać i ujednolicić, aby zapewnić bogatsze, multimodalne przepływy pracy. Jest to obsługiwane przez wcześniejsze wersje Google w ekosystemie Gemini.

- **Funkcje na urządzeniu i funkcje prywatności (cel):**Oczekuje się bardziej wydajnych opcji na urządzeniu lub w chmurze prywatnej dla danych wrażliwych, ponieważ Google i partnerzy kładą nacisk na prywatność i niższe opóźnienia. Jest to prognoza oparta na trendach ekosystemu; szczegóły dotyczące Gemini 3.0 nie zostały jeszcze opublikowane.

## Dolna linia

Powszechnie oczekuje się, że Gemini 3.0 w wersji pro-preview będzie przełomem dla multimodalnych modeli Google'a skoncentrowanych na rozumowaniu – potencjalnie oferując szerszy kontekst, skuteczniejsze planowanie i bogatsze możliwości multimodalne. Obecny entuzjazm to mieszanka **potwierdzone narzędzia dla programistów i sygnały produktów Google** (API Gemini, CLI, modele Veo/video) i **nieoficjalne, ale hałaśliwe sygnały społeczności** (Wpisy na LM Arena dotyczące litu/orionmist, przecieki i harmonogramy plotek analityków). Potraktuj benchmarki społeczności jako wczesne wskaźniki i przygotuj się, poznając narzędzia programistyczne Gemini, aby móc obiektywnie ocenić model, gdy Google udostępni oficjalny dostęp.

Przypuszczam, że najbardziej prawdopodobna oficjalna data premiery to 18 listopada, co pokrywa się z planowaną migracją modelu Google na ten sam dzień. Czekamy na więcej informacji o Gemini 3 Pro Preview!

### Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Deweloperzy mogą uzyskać dostęp do wersji zapoznawczej Gemini 3.0 pro za pośrednictwem CometAPI, [najnowsza wersja modelu](https://api.cometapi.com/pricing) jest zawsze aktualizowany na oficjalnej stronie internetowej. Na początek zapoznaj się z możliwościami modelu w [Plac zabaw](https://www.cometapi.com/console/playground) i zapoznaj się z [Przewodnik po API](https://api.cometapi.com/doc) aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. [Interfejs API Comet](https://www.cometapi.com/pl/) zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ [Zarejestruj się w CometAPI już dziś](https://api.cometapi.com/login) !

Jeśli chcesz poznać więcej wskazówek, poradników i nowości na temat sztucznej inteligencji, obserwuj nas na [VK](https://vk.com/id1078176061), [X](https://x.com/cometapi2025) oraz [Discord](https://discord.com/invite/HMpuV6FCrG)!