W latach 2025–2026 krajobraz narzędzi AI nadal się konsolidował: interfejsy API bram (takie jak CometAPI) zostały rozbudowane, aby zapewnić dostęp w stylu OpenAI do setek modeli, podczas gdy aplikacje LLM dla użytkowników końcowych (takie jak AnythingLLM) kontynuowały ulepszanie swojego dostawcy „Generic OpenAI”, aby umożliwić aplikacjom desktopowym i lokalnym wywoływanie dowolnego punktu końcowego zgodnego z OpenAI. Dzięki temu dziś można bez problemu kierować ruch AnythingLLM przez CometAPI i korzystać z zalet wyboru modelu, routingu kosztów i ujednoliconego rozliczeń — przy jednoczesnym korzystaniu z lokalnego interfejsu użytkownika i funkcji RAG/agenta AnythingLLM.

Czym jest AnythingLLM i dlaczego warto połączyć je z CometAPI?

Czym jest AnythingLLM?

AnythingLLM to otwartoźródłowa, kompleksowa aplikacja AI oraz lokalny/chmurowy klient do tworzenia asystentów czatu, przepływów pracy z wykorzystaniem generacji rozszerzonej (RAG) oraz agentów opartych na LLM. Oferuje elegancki interfejs użytkownika, API dla programistów, funkcje obszaru roboczego/agenta oraz obsługę lokalnych i chmurowych LLM — zaprojektowanych z myślą o domyślnej prywatności i rozszerzalności za pomocą wtyczek. AnythingLLM udostępnia Ogólny OpenAI dostawca umożliwiający komunikację z interfejsami API LLM zgodnymi ze standardem OpenAI.

Czym jest CometAPI?

CometAPI to komercyjna platforma agregująca API, która udostępnia 500+ modeli AI poprzez jeden interfejs REST w stylu OpenAI i ujednolicone rozliczenia. W praktyce pozwala to na wywoływanie modeli od wielu dostawców (OpenAI, Anthropic, warianty Google/Gemini, modele graficzne/audio itp.) za pośrednictwem tego samego https://api.cometapi.com/v1 punktów końcowych i pojedynczego klucza API (format sk-xxxxx). CometAPI obsługuje standardowe punkty końcowe w stylu OpenAI, takie jak: /v1/chat/completions, /v1/embeddingsitp., co ułatwia dostosowywanie narzędzi, które już obsługują interfejsy API zgodne ze standardem OpenAI.

Dlaczego warto zintegrować AnythingLLM z CometAPI?

Trzy praktyczne powody:

- Wybór modelu i elastyczność dostawcy: AnythingLLM może korzystać z „dowolnego LLM zgodnego z OpenAI” za pośrednictwem swojego ogólnego wrappera OpenAI. Skierowanie tego wrappera na CometAPI daje natychmiastowy dostęp do setek modeli bez konieczności zmiany interfejsu użytkownika ani przepływów w AnythingLLM.

- Optymalizacja kosztów/operacji: Korzystając z CometAPI możesz centralnie zmieniać modele (lub przechodzić na tańsze) w celu kontroli kosztów i zachować ujednolicone rozliczenia zamiast żonglowania wieloma dostawcami.

- Szybsze eksperymentowanie: Można testować różne modele A/B (np.

gpt-4o,gpt-4.5, warianty Claude'a lub modele multimodalne typu open source) za pośrednictwem tego samego interfejsu użytkownika AnythingLLM — przydatne dla agentów, odpowiedzi RAG, podsumowań i zadań multimodalnych.

Przed integracją należy przygotować środowisko i warunki

Wymagania systemowe i programowe (wysoki poziom)

- Komputer stacjonarny lub serwer z systemem AnythingLLM (Windows, macOS, Linux) — instalacja na komputerze stacjonarnym lub instancja hostowana samodzielnie. Upewnij się, że korzystasz z najnowszej kompilacji, która udostępnia Preferencje LLM / Dostawcy AI ustawienia.

- Konto CometAPI i klucz API (tzw.

sk-xxxxxTen sekret stylu zostanie wykorzystany w ogólnym dostawcy OpenAI firmy AnythingLLM. - Łączność sieciowa z Twojej maszyny do

https://api.cometapi.com(brak zapory blokującej ruch wychodzący HTTPS). - Opcjonalne, ale zalecane: nowoczesne środowisko Python lub Node do testowania (Python 3.10+ lub Node 18+), curl oraz klient HTTP (Postman/HTTPie) w celu sprawdzenia poprawności CometAPI przed podłączeniem go do AnythingLLM.

Specyficzne warunki programu AnythingLLM

Ogólny OpenAI Dostawca LLM to zalecana ścieżka dla punktów końcowych, które naśladują interfejs API OpenAI. Dokumentacja AnythingLLM ostrzega, że ten dostawca jest zorientowany na deweloperów i należy rozumieć dostarczane dane wejściowe. Jeśli korzystasz ze strumieniowania lub Twój punkt końcowy go nie obsługuje, AnythingLLM zawiera ustawienie umożliwiające wyłączenie strumieniowania dla standardowego OpenAI.

Lista kontrolna bezpieczeństwa i operacji

- Klucz CometAPI należy traktować jak każdy inny sekret — nie umieszczaj go w repozytoriach, ale przechowuj go, o ile to możliwe, w pękach kluczy systemu operacyjnego lub zmiennych środowiskowych.

- Jeśli planujesz używać w RAG poufnych dokumentów, upewnij się, że gwarancje prywatności punktów końcowych spełniają Twoje wymagania dotyczące zgodności (sprawdź dokumentację/warunki CometAPI).

- Określ maksymalną liczbę tokenów i limity okna kontekstowego, aby zapobiec niekontrolowanemu wzrostowi rachunków.

Jak skonfigurować AnythingLLM do korzystania z CometAPI (krok po kroku)?

Poniżej przedstawiono konkretną sekwencję kroków — wraz z przykładowymi zmiennymi środowiskowymi i fragmentami kodu służącymi do testowania połączenia przed zapisaniem ustawień w interfejsie użytkownika AnythingLLM.

Krok 1 — Uzyskaj klucz CometAPI

- Zarejestruj się lub zaloguj w CometAPI.

- Przejdź do „Kluczy API” i wygeneruj klucz — otrzymasz ciąg wyglądający tak:

sk-xxxxx. Zachowaj to w tajemnicy.

Krok 2 — Sprawdź, czy CometAPI działa za pomocą szybkiego żądania

Użyj curl lub Pythona do wywołania prostego punktu końcowego czatu w celu potwierdzenia łączności.

Przykład loków

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Jeśli zwróci to 200 i odpowiedź JSON z choices tablica, Twój klucz i sieć działają. (Dokumentacja CometAPI pokazuje powierzchnię i punkty końcowe w stylu OpenAI).

Przykład Pythona (prośby)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

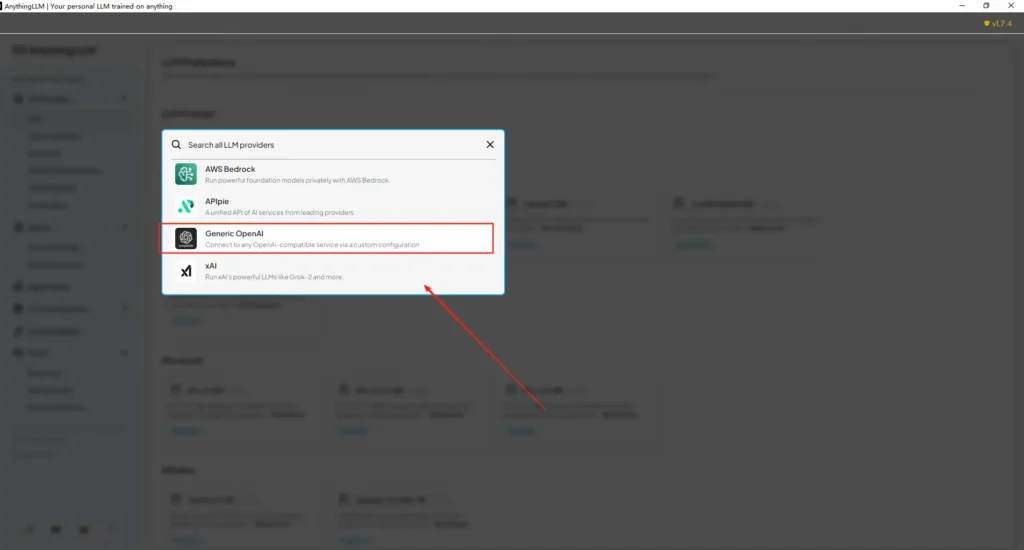

Krok 3 — Konfiguracja AnythingLLM (interfejs użytkownika)

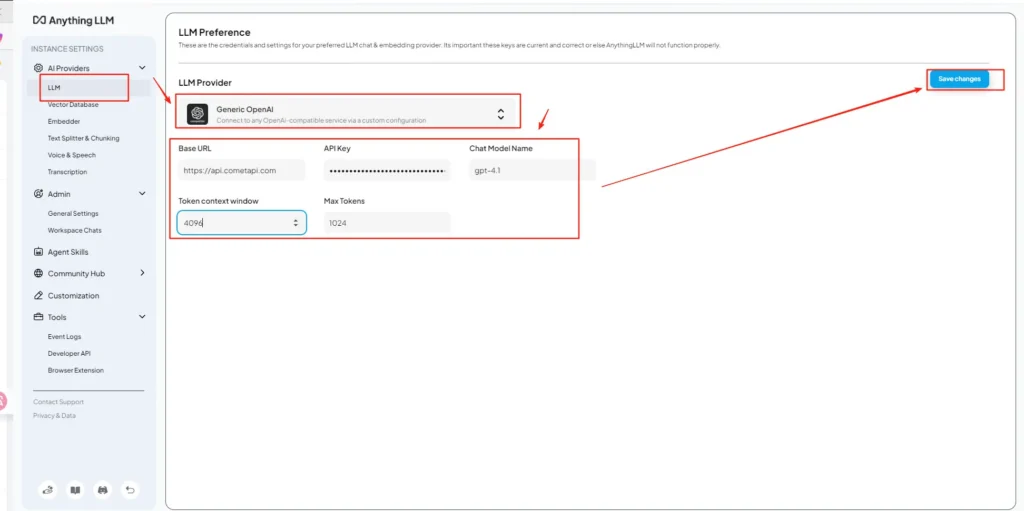

Otwórz AnythingLLM → Ustawienia → Dostawcy AI → Preferencje LLM (lub podobną ścieżkę w Twojej wersji). Użyj Ogólny OpenAI dostawcę i wypełnij pola w następujący sposób:

Konfiguracja API (przykład)

• Wejdź do menu ustawień AnythingLLM, znajdź Preferencje LLM w obszarze Dostawcy AI.

• Wybierz Generic OpenAI jako dostawcę modelu, wprowadźhttps://api.cometapi.com/v1w polu adresu URL.

• Wklejsk-xxxxxz CometAPI w polu wprowadzania klucza API. Wypełnij okno kontekstu tokena i pole Maksymalna liczba tokenów zgodnie z rzeczywistym modelem. Na tej stronie możesz również dostosować nazwy modeli, na przykład dodającgpt-4omodel.

Jest to zgodne z wytycznymi „Generic OpenAI” organizacji AnythingLLM (opakowanie dla programistów) oraz podejściem CometAPI dotyczącym podstawowego adresu URL zgodnego z OpenAI.

Krok 4 — Ustaw nazwy modeli i limity tokenów

Na tym samym ekranie ustawień dodaj lub dostosuj nazwy modeli dokładnie tak, jak publikuje je CometAPI (np. gpt-4o, minimax-m2, kimi-k2-thinking), aby interfejs użytkownika AnythingLLM mógł prezentować te modele użytkownikom. CometAPI publikuje ciągi modeli dla każdego dostawcy.

Krok 5 — Test w AnythingLLM

Rozpocznij nowy czat lub użyj istniejącego obszaru roboczego, wybierz dostawcę Generic OpenAI (jeśli masz wielu dostawców), wybierz jedną z dodanych nazw modeli CometAPI i uruchom prosty monit. Jeśli otrzymasz spójne uzupełnienia, oznacza to, że jesteś zintegrowany.

W jaki sposób AnythingLLM wykorzystuje te ustawienia wewnętrznie

Ogólny wrapper OpenAI programu AnythingLLM tworzy żądania w stylu OpenAI (/v1/chat/completions, /v1/embeddings), więc po wskazaniu adresu URL i podaniu klucza CometAPI, AnythingLLM będzie transparentnie kierować czaty, połączenia z agentami i żądania osadzania przez CometAPI. Jeśli korzystasz z agentów AnythingLLM ( @agent przepływów), odziedziczą tego samego dostawcę.

Jakie są najlepsze praktyki i możliwe pułapki?

Najlepsze praktyki

- Użyj ustawień kontekstowych odpowiednich dla danego modelu: Dopasuj okno kontekstu tokenów i maksymalną liczbę tokenów AnythingLLM do wybranego modelu w CometAPI. Niedopasowanie prowadzi do nieoczekiwanego skrócenia lub nieudanych wywołań.

- Zabezpiecz swoje klucze API: Przechowuj klucze CometAPI w zmiennych środowiskowych i/lub menedżerze Kubernetes/secret; nigdy nie wprowadzaj ich do Gita. AnythingLLM przechowuje klucze w swoich ustawieniach lokalnych, jeśli wprowadzisz je w interfejsie użytkownika — traktuj pamięć hosta jako poufną.

- Zacznij od tańszych/mniejszych modeli przepływów eksperymentalnych: Użyj CometAPI, aby wypróbować tańsze modele rozwoju, a modele premium zarezerwować na produkcję. CometAPI wyraźnie reklamuje przełączanie kosztów i ujednolicone rozliczenia.

- Monitoruj użycie i ustawiaj alerty: CometAPI udostępnia panele informacyjne umożliwiające ustawienie budżetów/alertów w celu uniknięcia nieoczekiwanych rachunków.

- Agentów i narzędzi testowych w izolacji: Agenci AnythingLLM mogą uruchamiać akcje; należy je najpierw przetestować za pomocą bezpiecznych monitów i na instancjach przejściowych.

Typowe pułapki

- Interfejs użytkownika kontra

.envkonflikty: W przypadku samodzielnego hostowania ustawienia interfejsu użytkownika mogą zostać nadpisane.envzmiany (i odwrotnie). Sprawdź wygenerowane/app/server/.envjeśli sytuacja powróci po ponownym uruchomieniu. Raport o problemach społecznościLLM_PROVIDERresetuje. - Niezgodności nazw modeli: Użycie nazwy modelu, która nie jest dostępna w CometAPI, spowoduje błąd 400/404 z bramy. Zawsze sprawdzaj dostępne modele na liście modeli CometAPI.

- Limity tokenów i przesyłanie strumieniowe: Jeśli potrzebujesz odpowiedzi strumieniowych, sprawdź, czy model CometAPI obsługuje strumieniowanie (i czy wersja interfejsu użytkownika AnythingLLM je obsługuje). Niektórzy dostawcy różnią się semantyką strumieniowania.

Jakie zastosowania w świecie rzeczywistym odblokowuje ta integracja?

Generacja wzmocniona odzyskiwaniem (RAG)

Użyj modułów ładujących dokumenty i wektorowej bazy danych AnythingLLM z interfejsem LLM CometAPI, aby generować odpowiedzi uwzględniające kontekst. Możesz eksperymentować z tanim osadzaniem i drogimi modelami czatu lub pozostawić wszystko w CometAPI, aby zapewnić ujednolicone rozliczenia. Przepływy RAG w AnythingLLM to podstawowa wbudowana funkcja.

Automatyzacja agentów

AnythingLLM wspiera @agent Przepływy pracy (przeglądanie stron, wywoływanie narzędzi, uruchamianie automatyzacji). Kierowanie połączeń LLM agentów przez CometAPI umożliwia wybór modeli kroków kontroli/interpretacji bez konieczności modyfikowania kodu agenta.

Wielomodelowe testy A/B i optymalizacja kosztów

Przełączaj modele według obszaru roboczego lub funkcji (np. gpt-4o w celu uzyskania odpowiedzi na pytania produkcyjne, gpt-4o-mini (dla deweloperów). CometAPI ułatwia wymianę modeli i centralizuje koszty.

Rurociągi multimodalne

CometAPI udostępnia modele graficzne, audio i specjalistyczne. Obsługa multimodalna AnythingLLM (za pośrednictwem dostawców) oraz modele CometAPI umożliwiają tworzenie napisów do obrazów, streszczanie multimodalne lub transkrypcję audio za pośrednictwem tego samego interfejsu.

Podsumowanie

CometAPI nadal pozycjonuje się jako brama wielomodelowa (ponad 500 modeli, API w stylu OpenAI) – co czyni go naturalnym partnerem dla aplikacji takich jak AnythingLLM, które już obsługują dostawcę Generic OpenAI. Podobnie, dostawca Generic w AnythingLLM i najnowsze opcje konfiguracji ułatwiają łączenie się z takimi bramami. Ta konwergencja upraszcza eksperymenty i migrację produkcyjną pod koniec 2025 roku.

Jak rozpocząć korzystanie z interfejsu API Comet

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Na początek zapoznaj się z możliwościami modeluInterfejs API Comet Plac zabaw Szczegółowe instrukcje znajdziesz w przewodniku API. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. ZetAPI zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ Zarejestruj się w CometAPI już dziś !

Jeśli chcesz poznać więcej wskazówek, poradników i nowości na temat sztucznej inteligencji, obserwuj nas na VK, X oraz Discord!