Sztuczna inteligencja rozwija się dynamicznie: nowe modele multimodalne i ulepszone interfejsy API czasu rzeczywistego ułatwiają wbudowywanie zaawansowanej sztucznej inteligencji w platformy automatyzacji, a jednocześnie toczące się debaty na temat bezpieczeństwa i obserwowalności zmieniają sposób, w jaki zespoły zarządzają systemami produkcyjnymi. Dla osób tworzących lokalne automatyzacje wyłania się praktyczny wzorzec: korzystanie z ujednoliconej bramy modelowej (np. Interfejs API Comet) aby uzyskać dostęp do wielu modeli i połączyć te wywołania modeli z samodzielnie hostowanym programem automatyzacji (takim jak n8n) dzięki czemu masz kontrolę nad danymi, opóźnieniami i kosztami. Ten przewodnik krok po kroku pokazuje, jak zacząć korzystać z CometAPI + n8n (lokalny), na co zwracać uwagę i jak rozwiązywać problemy, gdy coś pójdzie nie tak.

Czym jest n8n i dlaczego ma znaczenie dla automatyzacji AI?

n8n to narzędzie do automatyzacji przepływów pracy typu open source z edytorem wizualnym i rozbudowanym ekosystemem węzłów (łączników). Zostało zaprojektowane z myślą o łączeniu wyzwalaczy, transformacji i wywołań zewnętrznych API w powtarzalne przepływy pracy (webhooki, zadania zaplanowane, przetwarzanie plików, chatboty itp.). Samodzielne hostowanie n8n lokalnie zapewnia pełną kontrolę nad miejscem przechowywania i wykonywaniem danych, co jest szczególnie cenne podczas wywoływania zewnętrznych modeli AI obsługujących wrażliwe dane wejściowe.

Jak n8n działa w praktyce?

- Wizualna strona internetowa z wyzwalaczami (Webhook, Cron) i węzłami akcji (żądanie HTTP, węzły bazy danych, e-mail).

- Węzły społecznościowe rozszerzają możliwości — możesz instalować pakiety społecznościowe i traktować je jak węzły natywne.

Samodzielny hosting n8n zapewnia:

- Pełna kontrola danych — przepływy pracy i dane uruchomieniowe pozostają w infrastrukturze, którą zarządzasz.

- Personalizacja — dodawaj węzły prywatne lub integracje lokalne bez czekania na funkcje w chmurze.

- Przewidywalność kosztów — brak niespodzianek związanych z rozliczeniami za każde zadanie w chmurze w przypadku intensywnej automatyzacji wewnętrznej.

- Bezpieczeństwo i zgodność — łatwiejsze spełnianie wewnętrznych wymogów polityki i regulacji.

Czym jest CometAPI i dlaczego warto go używać jako bramy modelowej?

Interfejs API Comet to ujednolicona brama API, która udostępnia setki zewnętrznych modeli AI (tekst, osadzenia, generowanie obrazów itp.) za pośrednictwem jednego, zgodnego z OpenAI interfejsu i modelu rozliczeniowego. Oznacza to, że zamiast dodawać niestandardowe integracje dla każdego LLM lub silnika obrazów, który chcesz wypróbować, wywołujesz jedno API i wybierasz żądany model w żądaniu. Upraszcza to eksperymentowanie, kontrolę kosztów i integrację operacyjną.

korzyści:

- Wybór modelu: Wypróbuj wielu dostawców/modele z tą samą ścieżką kodu.

- Pula tokenów / bezpłatne limity: Wiele zunifikowanych bramek oferuje kredyty/poziomy umożliwiające eksperymentowanie.

- Prostsza infrastruktura: Jeden system uwierzytelniania i jeden adres URL bazowy do zarządzania.

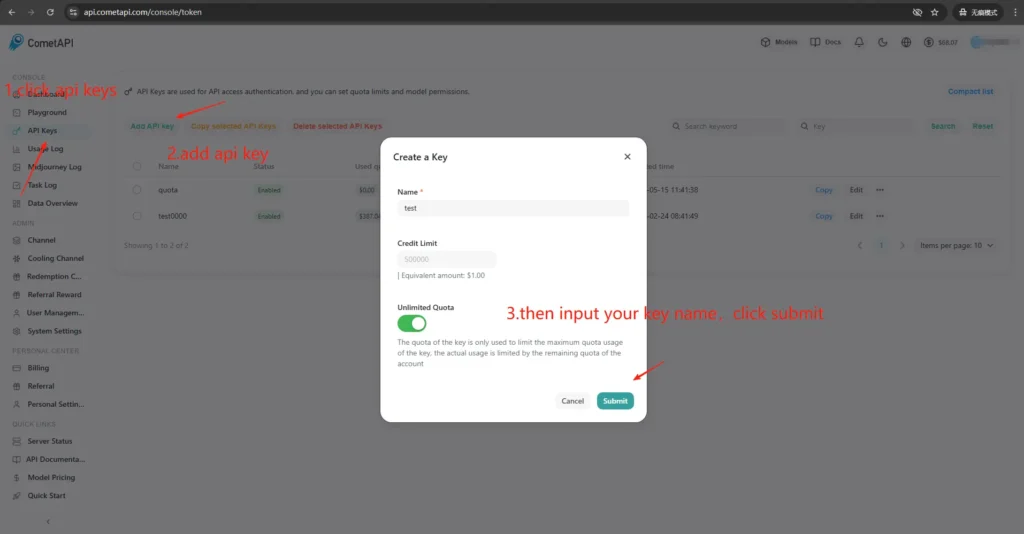

Jak uzyskać dostęp i klucze CometAPI?

- Zarejestruj się w witrynie CometAPI (lub na pulpicie dostawcy). Większość bramek oferuje darmową wersję testową.

- Uzyskaj klucz API z pulpitu nawigacyjnego CometAPI — długi tajny ciąg znaków. Zwróć uwagę na miejsce, w którym dokumentacja zaleca jego umieszczenie (CometAPI używa autoryzacji Bearer w odniesieniu do

https://api.cometapi.com/v1). - Przeczytaj dokumentację API dla punktu końcowego, którego planujesz użyć (uzupełnienia czatu, obrazy, osadzenia). CometAPI dokumentuje punkty końcowe, takie jak

/v1/chat/completionsoraz/v1/images/generations.

Dlaczego wiązanie (integracja) pomiędzy n8n i CometAPI jest ważne?

„Powiązanie” oznacza tutaj niezawodną i bezpieczną ścieżkę integracji między modułem automatyzacji (n8n) a bramką modelu. Prawidłowe powiązanie jest ważne, ponieważ:

- Zachowuje kontekst między połączeniami (historia konwersacji, osadzenia).

- Centralizuje kwalifikacje i sekrety w jednym miejscu, aby zapewnić bezpieczniejszą rotację.

- Zmniejsza opóźnienia i powierzchnię błędów dzięki stosowaniu przewidywalnych punktów końcowych i standardowych formatów żądań.

- To umożliwia obserwowalność i rozwiązywanie problemów — wiedza, który model, monit i odpowiedź doprowadziły do określonego rezultatu.

Krótko mówiąc: dobre łączenie obniża ryzyko operacyjne i przyspiesza iterację.

Jak wdrożyć n8n lokalnie (krótki praktyczny przewodnik)?

Możesz uruchomić n8n lokalnie za pomocą npm lub z Dockerem; Docker Compose to zalecane podejście w większości scenariuszy z własnym hostingiem (jest powtarzalne i izoluje zależności). Poniżej znajduje się minimalny przykład Docker Compose i niezbędne uwagi.

Jak samodzielnie hostować n8n za pomocą Dockera?

Docker (i Docker Compose) to najsolidniejszy i najbardziej powtarzalny sposób uruchamiania n8n w środowisku produkcyjnym. Izoluje aplikację, upraszcza aktualizacje i dobrze współpracuje z odwrotnymi serwerami proxy i orkiestratorami (Docker Swarm, Kubernetes). Oficjalna dokumentacja n8n zawiera referencje dotyczące Docker Compose, które tutaj wykorzystam i dostosuję.

Na potrzeby produkcji zazwyczaj uruchamia się stos składający się z:

- Usługa n8n (oficjalny obraz:

docker.n8n.io/n8nio/n8norn8nio/n8nw zależności od tagu). - PostgreSQL (lub inna obsługiwana baza danych).

- Redis (jeśli planujesz używać trybu kolejki).

- Serwer proxy odwrotny (Traefik, Caddy lub nginx) do obsługi protokołu TLS, routingu hosta i reguł ograniczania przepustowości.

Ta architektura wyraźnie rozdziela kwestie (trwałość bazy danych, kolejkowanie, serwer proxy) i ułatwia skalowanie i tworzenie kopii zapasowych. Oficjalna dokumentacja n8n zawiera wzorce Docker Compose i odniesienia do zmiennych środowiskowych.

Oto przewodnik krok po kroku:

- Utwórz folder i

docker-compose.ymlz kanoniczną usługą n8n. Poniżej znajduje się praktyczny przykład docker-compose, który pokrywa typowe potrzeby produkcyjne: zewnętrzny Postgres, Redis (do trybu kolejkowania/wykonywania), trwałe woluminy i odwrotny serwer proxy Nginx obsługujący TLS:

```yaml

version: "3.8"

services:

n8n:

image: n8nio/n8n:latest

restart: unless-stopped

environment:

- DB_TYPE=postgresdb

- DB_POSTGRESDB_HOST=postgres

- DB_POSTGRESDB_PORT=5432

- DB_POSTGRESDB_DATABASE=n8n

- DB_POSTGRESDB_USER=n8n

- DB_POSTGRESDB_PASSWORD=supersecretpassword

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=anothersecret

- WEBHOOK_TUNNEL_URL=https://n8n.example.com

- EXECUTIONS_MODE=queue

- QUEUE_BULL_REDIS_HOST=redis

ports:

- "5678:5678"

volumes:

- n8n_data:/home/node/.n8n

depends_on:

- postgres

- redis

postgres:

image: postgres:15

environment:

POSTGRES_DB: n8n

POSTGRES_USER: n8n

POSTGRES_PASSWORD: supersecretpassword

volumes:

- pgdata:/var/lib/postgresql/data

redis:

image: redis:7

volumes:

- redisdata:/data

volumes:

n8n_data:

pgdata:

redisdata:

2. Start:

docker compose up -d

3. Odwiedź `http://localhost:5678` i utwórz konto administratora. Do użytku produkcyjnego będziesz potrzebować Postgres, SSL i odpowiednich zmiennych środowiskowych — zapoznaj się z oficjalną dokumentacją Docker Compose.

**Uwagi i hartowanie:**

- Do **nie** przechowuj sekrety w postaci zwykłego tekstu w `docker-compose.yml`; korzystaj z plików środowiskowych, sekretów Dockera lub zewnętrznych menedżerów sekretów w środowisku produkcyjnym.

- zastąpić `WEBHOOK_URL` z Twoim prawdziwym publicznym adresem URL i skonfiguruj odwrotny serwer proxy, aby kierować `n8n.example.com` do pojemnika n8n.

- Zastosowanie `EXECUTIONS_MODE=queue` do wydajnego przetwarzania w tle; wymaga pracowników kolejki i Redis.

## Jak samodzielnie hostować n8n za pomocą npm / Node.js?

Instalacja za pomocą npm (lub pnpm) uruchamia n8n bezpośrednio na hoście. Jest to lżejsze rozwiązanie (brak warstwy kontenerów) i może być pomocne w przypadku instalacji dla jednego użytkownika, instalacji o niskiej złożoności lub na komputerach deweloperskich. Nakłada jednak na administratora większą odpowiedzialność za zarządzanie zależnościami, izolację i nadzór nad usługami. Oficjalna dokumentacja n8n zawiera przewodnik instalacji npm i ostrzeżenia.

### Wymagane pakiety systemu operacyjnego i wersja węzła:

- Użyj stabilnej wersji LTS Node.js (Node 18 lub Node 20+, zgodnej z wymaganiami wydania n8n).

- Zainstalować `build-essential`, `git`oraz menedżera procesów (zalecany jest systemd).

- W środowisku produkcyjnym nadal należy używać PostgreSQL i Redis jako usług zewnętrznych (podobnie jak w przypadku Dockera).

### Jak zainstalować i uruchomić n8n za pomocą npm (krok po kroku)?

1. Zainstaluj Node.js (zalecane: nvm)

Install nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

Reload your shell (adjust to your shell startup file if needed)

source ~/.bashrc # or ~/.zshrc

Install and use the latest LTS (usually 18 or 20)

nvm install --lts

nvm use --lts

Verify

node -v

npm -v

Jeśli później zobaczysz komunikat „n8n: polecenie nie znaleziono”, uruchom ponownie terminal lub upewnij się, że globalna ścieżka bin npm zarządzana przez nvm znajduje się w zmiennej PATH.

---

2. Zainstaluj i uruchom n8n (lokalnie)

npm install -g n8n

n8n -v # verify version

3. Zacznij od pierwszego planu:

n8n start

Domyślny adres URL: <http://localhost:5678/> Jeśli port jest w użyciu:

export N8N_PORT=5679

n8n start

Opcjonalnie: pozostaw go uruchomionym w tle (nadal lokalnym):

npm install -g pm2

pm2 start "n8n" --name n8n

pm2 save

pm2 status

4. Pierwszy dostęp i logowanie:

- Otwórz http://localhost:5678/ w swojej przeglądarce.

- Przy pierwszym uruchomieniu postępuj zgodnie z instrukcjami kreatora, aby utworzyć konto właściciela (adres e-mail i hasło) i się zalogować.

## Jak zainstalować lub skonfigurować węzeł społeczności CometAPI w n8n?

n8n obsługuje zarówno zweryfikowane węzły społecznościowe (instalacja GUI), jak i ręczną instalację z npm w przypadku samodzielnego hostowania. Istnieją dwa sposoby integracji CometAPI z n8n:

### Opcja A — Użyj węzła społeczności CometAPI (jeśli jest dostępny w panelu Węzły)

1. W n8n otwórz panel węzłów (naciśnij `+` or `Tab`).

2. CometAPI to zweryfikowany węzeł społeczności, widoczny w sekcji „Więcej od społeczności”. Kliknij i zainstaluj.

3. Po instalacji uruchom ponownie n8n, jeśli pojawi się monit. Utwórz nowy **Poświadczenie** w Ustawienia → Dane uwierzytelniające (wybierz typ danych uwierzytelniających CometAPI, jeśli węzeł go udostępnia) i wklej swój token CometAPI.

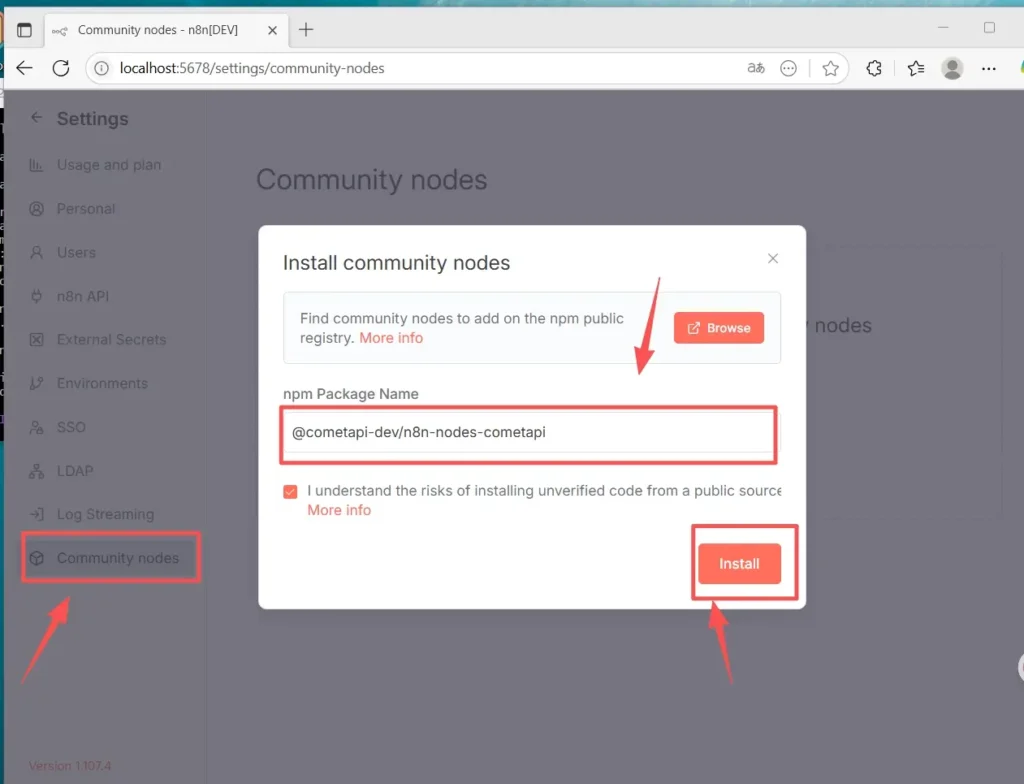

### Opcja B — Instalacja ręczna (gdy instalacja za pomocą interfejsu graficznego jest niedostępna)

1. Nawiąż połączenie SSH do hosta/kontenera n8n.

2. Zainstaluj pakiet w globalnym n8n `node_modules` lub Twój niestandardowy folder:

- Przejdź do Ustawień (lewy dolny róg) > Węzły społeczności Kliknij „

- Zainstaluj węzeł społecznościowy”

- W polu „Nazwa pakietu npm” wpisz: `@cometapi-dev/n8n-nodes-cometapi`Zaznacz pole potwierdzenia ryzykaKliknij „

- „Instaluj”Po instalacji możesz wyszukać „CometAPI” w panelu węzła.

3. Uruchom ponownie n8n. Jeśli Twoja instancja działa w trybie kolejki, musisz postępować zgodnie z instrukcją instalacji ręcznej opisaną w dokumentacji.

### Jak sprawdzić, czy węzeł jest zainstalowany

- Po ponownym uruchomieniu otwórz panel węzłów i wyszukaj „CometAPI” lub „Comet”. Węzeł zostanie oznaczony jako pakiet społecznościowy.

- Jeśli nie widzisz węzła: sprawdź, czy używane jest konto właściciela instancji (instalować mogą tylko właściciele instancji) lub czy pakiet węzła został zainstalowany bez błędów w dziennikach kontenera/obrazu.

## Jak utworzyć przepływ pracy i skonfigurować API

### 1. Utwórz nowy przepływ pracy

- Zaloguj się do swojej instancji n8n (hostowanej samodzielnie).

- Kliknij **„Dodaj przepływ pracy”** aby rozpocząć nowe płótno automatyzacji.

### 2. Dodaj węzeł

- Dodaj węzeł wyzwalacza: wyszukaj „Wyzwalacz ręczny” lub „Po kliknięciu „Wykonaj przepływ pracy””.

- Kliknij „+” po prawej stronie płótna i wyszukaj „CometAPI”, aby dodać węzeł.

- Możesz również wyszukać „CometAPI” na liście węzłów po lewej stronie i przeciągnąć go na płótno.

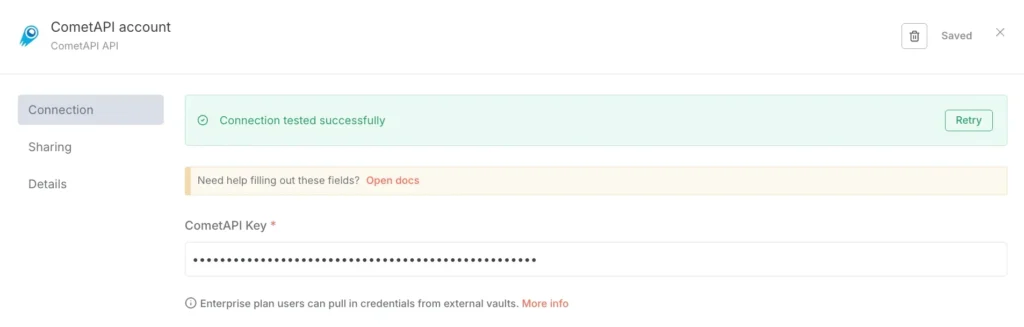

### 3. Skonfiguruj dane uwierzytelniające (tylko za pierwszym razem):

- W węźle CometAPI w sekcji „Dane uwierzytelniające do połączenia” wybierz opcję „Utwórz nowe”.

- Wklej token utworzony w konsoli CometAPI w polu „Klucz CometAPI”.

- Zapisz. Domyślny adres URL to https://www.cometapi.com/console/ i zazwyczaj nie wymaga zmiany.

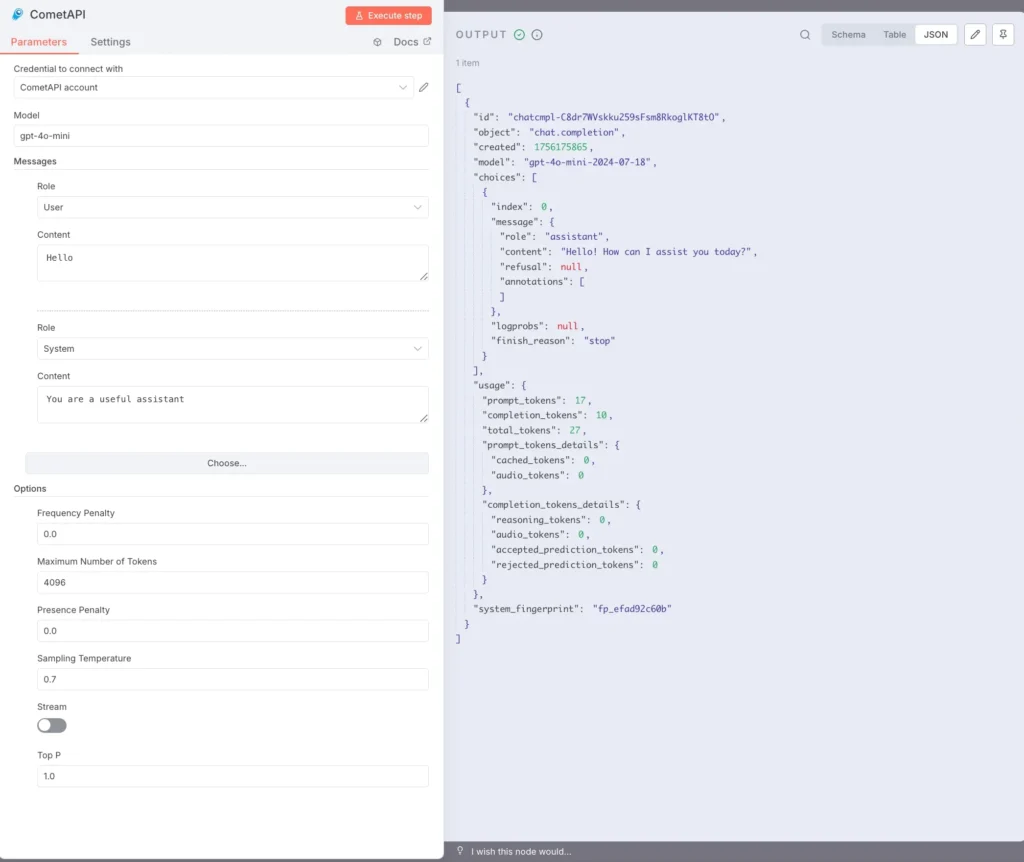

### 4. Skonfiguruj model i wiadomości:

Model: wprowadź obsługiwany model, np. `gpt-4o` or `gpt-4o-mini`.

Wiadomości: Musisz wypełnić rolę i kontekst, możesz wybrać użytkownika lub system dla roli

Parametry opcjonalne (w razie potrzeby): Maksymalna liczba tokenów (np. 4096); Temperatura próbkowania (np. 0.7); Strumień kary (włącz/wyłącz strumieniowanie). Aby uzyskać dokumentację i wyjaśnienia dotyczące konkretnych parametrów, zapoznaj się z [Dokumentacja CometAPI](https://api.cometapi.com/doc).

### 5.Wykonywanie tekstu:

Wybierz węzeł CometAPI i kliknij „Wykonaj krok” lub kliknij „Wykonaj przepływ pracy” na dole.

Panel OUTPUT po prawej stronie powinien pokazywać odpowiedź JSON (w tym wybory, sposób użycia itp.).

Zainstalowałeś już n8n(Recommend) lokalnie w systemie Linux za pomocą npm, zainstalowałeś i skonfigurowałeś węzeł społeczności CometAPI i możesz uruchamiać przepływy pracy wywołujące modele takie jak gpt-4o w celu odbierania odpowiedzi.

## Jakie są najczęstsze problemy i jak je rozwiązać?

### 1) „401 Nieautoryzowany” lub „Nieprawidłowy klucz API”

- Sprawdź dokładny ciąg tokenów w panelu CometAPI (tokeny mogą mieć podobną nazwę). Skopiuj → wklej do poświadczeń n8n i w razie potrzeby uruchom ponownie węzeł.

- Upewnij się, że format nagłówka autoryzacji jest `Bearer sk-xxxxx`.

### 2) Węzeł społecznościowy nie instaluje się / „tryb kolejki”

- Jeśli Twój n8n działa w **tryb kolejki**Instalacja GUI może zostać wyłączona. Postępuj zgodnie z dokumentacją instalacji ręcznej, aby zainstalować węzły społeczności za pomocą npm lub zbudować niestandardowy obraz zawierający węzeł. Po instalacji uruchom ponownie n8n.

### 3) Po instalacji nie znaleziono węzła w palecie

- Uruchom ponownie n8n.

- Upewnij się, że zainstalowałeś pakiet w odpowiednim kontekście (wewnątrz obrazu kontenera lub w `.n8n/custom` ścieżka jeśli używasz tego wzorca).

- Sprawdź logi kontenera pod kątem błędów rozwiązywania modułów.

### 4) Problemy z limitami stawek lub kwotami

- Sprawdź panel CometAPI pod kątem wykorzystania i limitu.

- Wdrażaj wykładniczy model wycofywania i wracaj do tańszych modeli, gdy wykryjesz ostrzeżenia o limitach lub błędy HTTP 429.

## Czy istnieją alternatywy, jeśli węzeł społecznościowy jest niedostępny lub jeśli zależy Ci na większej elastyczności?

Tak — zawsze możesz skorzystać z **Żądanie HTTP** węzeł bezpośrednio (pełna kontrola) lub [Węzeł OpenAI z adresem URL bazowym](https://apidoc.cometapi.com/n8n-965890m0) Przekierowanie (praktyczny skrót). Korzystanie z surowego protokołu HTTP ułatwia również adopcję nowych punktów końcowych CometAPI w miarę ich udostępniania (np. punktów końcowych obrazów/wideo). Zapoznaj się z [Guide](https://apidoc.cometapi.com/n8n-965890m0).

**Zobacz także** [Jak używać n8n z CometAPI](https://www.cometapi.com/pl/how-to-use-n8n-with-cometapi/?utm_source=chatgpt.com)

## Wnioski:

CometAPI oferuje wybór modelu i prostotę operacyjną; n8n zapewnia wizualną orkiestrację i rozszerzalność. Wykorzystaj sztuczkę z poświadczeniami OpenAI do szybkiej integracji czatu/uzupełniania i dołącz do węzłów społecznościowych, jeśli istnieją i są zaufane. Instrumentuj każdy przepływ pracy pod kątem kosztów, opóźnień i bezpieczeństwa; preferuj ludzkie rozwiązania awaryjne w przypadku ważnych decyzji; i zachowaj dynamikę wyboru modelu, aby móc dostosowywać się do szybkich zmian w krajobrazie dostawców sztucznej inteligencji. Połączenie n8n i CometAPI jest potężne, ale jak wszystkie potężne narzędzia, wymaga zabezpieczeń — obserwacji, testów i iteracji.