DeepSeek wydany DeepSeek V3.2 i wariant o dużej mocy obliczeniowej DeepSeek-V3.2-Speciale, z nowym silnikiem rozproszonej uwagi (DSA), ulepszonym zachowaniem agenta/narzędzia oraz trybem „myślenia” (łańcucha myśli), który uwidacznia wewnętrzne rozumowanie. Oba modele są dostępne za pośrednictwem API DeepSeek (punkty końcowe zgodne z OpenAI), a artefakty modeli / raporty techniczne są publikowane publicznie.

Czym jest DeepSeek V3.2?

DeepSeek V3.2 to następca produkcyjny rodziny DeepSeek V3 — dużej rodziny modeli generujących długi kontekst, która została zaprojektowana specjalnie dla rozumowanie-najpierw Przepływy pracy i korzystanie z agentów. Wersja 3.2 konsoliduje wcześniejsze eksperymentalne ulepszenia (wersja 3.2-Exp) w ramach głównego modelu dostępnego za pośrednictwem aplikacji, interfejsu internetowego i interfejsu API DeepSeek. Obsługuje zarówno szybkie, konwersacyjne wyniki, jak i dedykowane myślenia tryb (łańcucha myśli) odpowiedni do zadań wymagających rozumowania wieloetapowego, takich jak obliczenia matematyczne, debugowanie i planowanie.

Dlaczego wersja 3.2 jest ważna (krótki kontekst)

DeepSeek V3.2 wyróżnia się z trzech praktycznych powodów:

- Długi kontekst: Okna kontekstowe tokenów do 128 tys., co sprawia, że rozwiązanie to nadaje się do analizy długich dokumentów, umów prawnych lub badań obejmujących wiele dokumentów.

- Projektowanie oparte na rozumowaniu: Model ten integruje łańcuch myślowy („myślenie”) z przepływami pracy i korzystaniem z narzędzi — przejście w kierunku aplikacji agentowych, które wymagają pośrednich kroków rozumowania.

- Koszt i efektywność: Wprowadzenie DSA (sparse attention) redukuje nakłady obliczeniowe na długie sekwencje, umożliwiając znacznie tańsze wnioskowanie w dużych kontekstach.

Czym jest DeepSeek-V3.2-Speciale i czym różni się od wersji podstawowej v3.2?

Co sprawia, że wariant „Speciale” jest wyjątkowy?

DeepSeek V3.2-Speciale to wysokowydajny, wysokorozumiany Wariant rodziny v3.2. W porównaniu ze zbalansowaną wersją v3.2, Speciale jest dostrojony (i po treningu) specjalnie do rozumowania wieloetapowego, zadań matematycznych i zadań agentowych; wykorzystuje dodatkowe uczenie się przez wzmacnianie z wykorzystaniem informacji zwrotnej od człowieka (RLHF) i rozszerzony wewnętrzny tok rozumowania podczas treningu. Ten tymczasowy punkt końcowy i dostęp do API Speciale zostały ogłoszone jako ograniczone czasowo (w nawiązaniu do wygaśnięcia punktu końcowego ścieżki Speciale 15 grudnia 2025 r.).

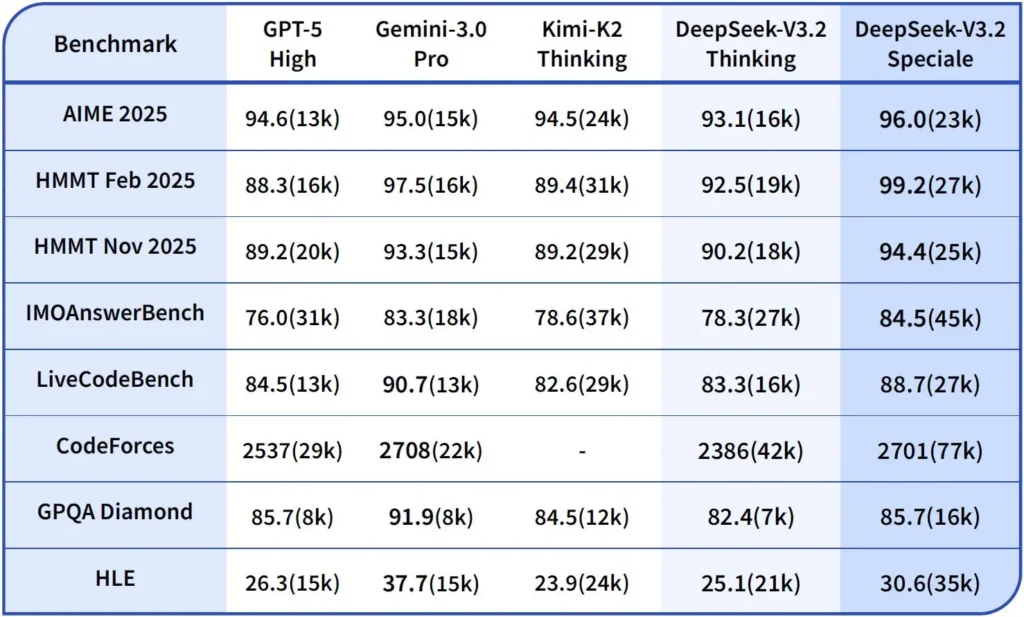

Wydajność i testy porównawcze

DeepSeek-V3.2-Speciale to wysokowydajna, zoptymalizowana pod kątem wnioskowania wersja V3.2. Wersja Speciale integruje poprzedni model matematyczny DeepSeek-Math-V2. Jest ona pozycjonowana jako model do użycia, gdy obciążenie wymaga najgłębszy możliwy łańcuch myśli, rozwiązywanie problemów w wielu etapach, rozumowanie konkurencyjne (np. w stylu olimpiady matematycznej) i złożona orkiestracja agentowa.

Potrafi samodzielnie dowodzić twierdzeń matematycznych i weryfikować rozumowanie logiczne. Osiągnął znakomite wyniki w wielu konkursach światowej klasy:

- Złoty medal IMO (Międzynarodowej Olimpiady Matematycznej)

- Złoty medal CMO (Chińskiej Olimpiady Matematycznej)

- ICPC (Międzynarodowy Konkurs Programowania Komputerowego) 2. miejsce (Konkurs Ludzki)

- IOI (Międzynarodowa Olimpiada Informatyczna) 10. miejsce (Konkurs Ludzki)

Czym jest tryb rozumowania w DeepSeek v3.2?

DeepSeek ujawnia jawne tryb myślenia/rozumowania co powoduje, że model wytwarza Łańcuch myśli (CoT) jako dyskretna część wyjścia zanim Ostateczna odpowiedź. Interfejs API wyświetla ten CoT, aby aplikacje klienckie mogły go przeglądać, wyświetlać lub destylować.

Mechanika — co zapewnia API

reasoning_contentpole:gdy włączony jest tryb myślenia, struktura odpowiedzi obejmujereasoning_contentpole (CoT) na tym samym poziomie co ostatecznecontentDzięki temu klienci mają programowy dostęp do wewnętrznych kroków.- Narzędzie wzywa podczas myśleniaWersja 3.2 twierdzi, że obsługuje wywołania narzędzi w ciągu trajektoria myślenia: model może przeplatać kroki rozumowania i wywoływania narzędzi, co usprawnia realizację złożonych zadań.

W jaki sposób API DeepSeek v3.2 implementuje wnioskowanie

Wersja 3.2 wprowadza ustandaryzowany mechanizm API łańcucha wnioskowania, który ma na celu zachowanie spójnej logiki wnioskowania w konwersacjach wieloetapowych:

- Każde żądanie uzasadnienia zawiera

reasoning_contentpole w modelu; - Jeżeli użytkownik chce, aby model kontynuował wnioskowanie, pole to musi zostać przekazane z powrotem do następnej tury;

- Kiedy zaczyna się nowe pytanie, stare

reasoning_contentmuszą zostać oczyszczone, aby zapobiec zanieczyszczeniu logicznemu; - Model może wielokrotnie wykonywać pętlę „rozumowanie → wywołanie narzędzia → ponowne rozumowanie” w trybie wnioskowania.

Jak uzyskać dostęp do interfejsu API DeepSeek v3.2 i jak go używać?

Krótki: CometAPI to brama w stylu OpenAI, która udostępnia wiele modeli (w tym rodziny DeepSeek) za pośrednictwem https://api.cometapi.com/v1 dzięki czemu możesz zamieniać modele, zmieniając model ciąg w żądaniach. Zarejestruj się w CometAPI i uzyskaj swój klucz API.

Dlaczego warto używać CometAPI zamiast bezpośrednio DeepSeek?

- CometAPI centralizuje rozliczenia, limity stawek i wybór modelu (przydatne, jeśli planujesz zmienić dostawcę bez zmiany kodu).

- Bezpośrednie punkty końcowe DeepSeek (np.

https://api.deepseek.com/v1) nadal istnieją i czasami udostępniają funkcje specyficzne dla dostawcy; wybierz CometAPI dla wygody lub bezpośredni punkt końcowy dostawcy dla kontrolek natywnych dla dostawcy. Sprawdź, które funkcje (np. Speciale, eksperymentalne punkty końcowe) są dostępne za pośrednictwem CometAPI, zanim zaczniesz na nich polegać.

Krok A — Utwórz konto CometAPI i uzyskaj klucz API

- Przejdź do CometAPI (rejestracja/konsola) i wygeneruj klucz API (zwykle jest on wyświetlany na pulpicie nawigacyjnym)

sk-...) Zachowaj to w tajemnicy. Interfejs API Comet

Krok B — Sprawdź, czy dostępna jest dokładna nazwa modelu

- Przeszukaj listę modeli, aby potwierdzić dokładny ciąg modelu udostępniany przez CometAPI (nazwy modeli mogą zawierać sufiksy wariantów). Użyj punktu końcowego modeli przed zakodowaniem nazw na stałe:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Poszukaj wpisu DeepSeek (np. deepseek-v3.2 or deepseek-v3.2-exp) i zanotuj dokładny identyfikator. CometAPI udostępnia /v1/models wymienianie kolejno.

Krok C — Wykonaj podstawową rozmowę na czacie (curl)

zastąpić <COMET_KEY> oraz deepseek-v3.2 z potwierdzonym identyfikatorem modelu:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Jest to ten sam wzorzec wywołań w stylu OpenAI — CometAPI przekierowuje do wybranego dostawcy.

Zgodność i środki ostrożności

- Obsługuje włączanie trybu Think Mode w środowisku Claude Code;

- W wierszu poleceń (CLI) wystarczy wpisać nazwę modelu deepseek-reasoner;

- Na razie jednak może nie być on kompatybilny z niestandardowymi narzędziami, takimi jak Cline i RooCode;

- Zaleca się korzystanie z trybu innego niż Myślenie w przypadku zwykłych zadań, a z trybu Myślenie w przypadku złożonego rozumowania logicznego.

Praktyczne wzorce adopcji: kilka przykładowych architektur

1 — Agent pomocniczy dla przepływów pracy programistów

- Tryb: Tryb Speciale (myślenia) wywoływany w przypadku generowania złożonego kodu i tworzenia testów; tryb szybkiego czatu dla asystenta liniowego.

- Bezpieczeństwo: Użyj kontroli potoku CI i testowania wygenerowanego kodu w środowisku testowym.

- hosting: API lub samodzielne hostowanie w klastrze vLLM + multi-GPU w celu zapewnienia dużego kontekstu.

2 — Analiza dokumentów dla zespołów prawnych/finansowych

- Tryb: Wersja 3.2 z optymalizacjami długiego kontekstu DSA umożliwiającą przetwarzanie długich kontraktów i generowanie uporządkowanych podsumowań oraz list działań.

- Bezpieczeństwo: Podpis prawnika przed podjęciem dalszych decyzji; redagowanie danych osobowych przed wysłaniem do hostowanych punktów końcowych.

3 — Autonomiczny koordynator przepływu danych

- Tryb: Tryb myślenia służący do planowania wieloetapowych zadań ETL, wywoływania narzędzi do wykonywania zapytań w bazach danych i wywoływania testów walidacyjnych.

- Bezpieczeństwo: Przed każdą nieodwracalną operacją (np. niszczącym zapisem bazy danych) wprowadź potwierdzenia działań i weryfikowalne kontrole.

Każdy z powyższych wzorców jest obecnie wykonalny w przypadku modeli rodziny V3.2, ale konieczne jest powiązanie tego modelu z narzędziami weryfikacyjnymi i konserwatywnym zarządzaniem.

Jak zoptymalizować koszty i wydajność w wersji 3.2?

Używaj trybów dualnych rozważnie

- Szybki tryb dla mikrointerakcji: Używaj trybu narzędzia bezmyślnego do krótkich pobrań, konwersji formatów lub bezpośrednich wywołań API, gdzie opóźnienie ma znaczenie.

- Tryb myślenia do planowania i weryfikacji: Kieruj złożone zadania, agentów wykonujących wiele czynności lub decyzje dotyczące bezpieczeństwa do trybu myślenia. Rejestruj kroki pośrednie i przeprowadzaj weryfikację (automatyczną lub ludzką) przed wykonaniem działań krytycznych.

Którą wersję modelu powinienem wybrać?

- deepseek-v3.2 — zbalansowany model produkcji dla ogólnych zadań agentowych.

- deepseek-v3.2-Speciale — specjalistyczna odmiana z rozbudowanym rozumowaniem; początkowo może być dostępna wyłącznie w ramach API i używana, gdy potrzebujesz najlepszej możliwej wydajności rozumowania/testów porównawczych (i akceptujesz potencjalnie wyższe koszty).

Praktyczna kontrola kosztów i wskazówki

- Szybka inżynieria: zachowaj zwięzłość instrukcji systemowych i unikaj wysyłania zbędnego kontekstu. Jawne instrukcje systemowe: używaj monitów systemowych, które deklarują intencję trybu, np. „Jesteś w trybie MYŚLENIA — przed wywołaniem narzędzi wypisz swój plan”. W trybie narzędzi dodaj ograniczenia, takie jak „Podczas interakcji z API kalkulatora generuj dane JSON tylko z następującymi polami”.

- Fragmentowanie i rozszerzenie pobierania: użyj zewnętrznego narzędzia do pobierania, aby wysyłać tylko najistotniejsze segmenty dla każdego pytania użytkownika.

- Temperatura i pobieranie próbek: Obniż temperaturę interakcji narzędzi, aby zwiększyć determinizm; zwiększ ją w przypadku zadań eksploracyjnych lub ideacyjnych.

Punkt odniesienia i pomiar

- Traktuj wyniki jako niewiarygodne do czasu ich weryfikacji: Nawet wyniki wnioskowania mogą być niepoprawne. Dodaj kontrole deterministyczne (testy jednostkowe, kontrole typów) przed podjęciem nieodwracalnych działań.

- Przed zatwierdzeniem wariantu należy przeprowadzić testy A/B na próbnym obciążeniu (opóźnienie, wykorzystanie tokenów, poprawność). Wersja 3.2 przyniosła duże postępy w testach porównawczych wnioskowania, ale rzeczywiste zachowanie aplikacji zależy od szybkiego projektowania i dystrybucji danych wejściowych.

FAQ

P: Jaki jest zalecany sposób uzyskania CoT z modelu?

A: Użyj deepseek-reasoner model lub zestaw thinking/thinking.type = enabled w Twoim żądaniu. Odpowiedź zawiera reasoning_content (CoT) i finał content.

P: Czy model może wywoływać narzędzia zewnętrzne, będąc w trybie myślenia?

O: Tak — wersja 3.2 wprowadziła możliwość korzystania z narzędzi zarówno w trybie myślenia, jak i bez myślenia; model może generować ustrukturyzowane wywołania narzędzi podczas wewnętrznego rozumowania. strict tryb i czyste schematy JSON, aby uniknąć nieprawidłowych wywołań.

P: Czy korzystanie z trybu myślenia zwiększa koszty?

O: Tak — tryb myślenia generuje pośrednie tokeny CoT, co zwiększa ich wykorzystanie, a tym samym koszty. Zaprojektuj system tak, aby myślenie było możliwe tylko wtedy, gdy jest to konieczne.

P: Jakiego punktu końcowego i adresu URL bazowego powinienem użyć?

A: CometAPI zapewnia punkty końcowe zgodne z OpenAI. Domyślny adres URL to https://api.cometapi.com a głównym punktem końcowym czatu jest /v1/chat/completions (lub /chat/completions w zależności od wybranego adresu bazowego).

P: Czy do korzystania z funkcji wywoływania narzędzi potrzebne są specjalne narzędzia?

A: Nie — API obsługuje deklaracje funkcji strukturalnych w formacie JSON. Należy podać tools Parametr, schematy narzędzia i obsługa cyklu życia funkcji JSON w aplikacji: odbieranie wywołań funkcji w formacie JSON, wykonywanie funkcji, a następnie zwracanie wyników do modelu w celu kontynuacji lub zamknięcia. Tryb myślenia dodaje wymóg przekazania z powrotem. reasoning_content obok wyników narzędzi.

Podsumowanie

DeepSeek V3.2 i DeepSeek-V3.2-Speciale stanowią wyraźny krok w kierunku otwarty, skoncentrowany na rozumowaniu LLM-y, które wyraźnie określają łańcuch myślowy i obsługują przepływy pracy z narzędziami agentowymi. Oferują one nowe, zaawansowane prymitywy (DSA, tryb myślenia, szkolenie w zakresie obsługi narzędzi), które mogą uprościć tworzenie godnych zaufania agentów — pod warunkiem uwzględnienia kosztów tokenów, starannego zarządzania stanem i kontroli operacyjnej.

Deweloperzy mogą uzyskać dostęp Deepseek v3.2 API itp. poprzez CometAPI, najnowsza wersja modelu jest zawsze aktualizowany na oficjalnej stronie internetowej. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ Bezpłatna wersja próbna deepseek v3.2 !

Jeśli chcesz poznać więcej wskazówek, poradników i nowości na temat sztucznej inteligencji, obserwuj nas na VK, X oraz Discord!