Google ogłosiło Gemini 3 Flash w dniach 17–18 grudnia 2025 r. jako niskoopóźnieniowy, opłacalny kosztowo model z rodziny Gemini 3. Wprowadza rozumowanie klasy Pro w „footprint” klasy Flash, obsługuje rozbudowane wejścia multimodalne (tekst, obraz, audio, wideo), oferuje kontrolę thinking_level i rozdzielczości mediów, a także jest dostępny przez Google AI Studio, Gemini API (REST / SDKs), Vertex AI, Gemini CLI oraz jako domyślny model w Google Search / aplikacji Gemini.

Czym jest Gemini 3 Flash i dlaczego to ma znaczenie

Gemini 3 Flash jest częścią serii modeli 3. Został zaprojektowany, by przesunąć granicę Pareto pomiędzy jakością, kosztem i opóźnieniem: dostarczając dużą część możliwości rozumowania modelu Gemini 3 Pro, a jednocześnie działając znacząco szybciej i taniej. Takie połączenie sprawia, że świetnie nadaje się do scenariuszy interaktywnych o wysokiej częstotliwości (chatboty, asystenci IDE, strumienie agentowe w czasie zbliżonym do rzeczywistego), masowego generowania treści, gdzie liczy się opóźnienie, oraz aplikacji wymagających multimodalnego rozumowania (obrazy + tekst + audio) przy niskim narzucie.

Kluczowe, wysokopoziomowe punkty:

- Jest wyraźnie zoptymalizowany pod kątem szybkości + niskiego kosztu, zachowując silne rozumowanie i wierność multimodalną (Trzykrotnie szybszy niż stary Gemini 2.5 Pro; zachowuje najwyższej klasy możliwości wnioskowania Gemini 3.).

- Pozycjonowany jako „sweet spot” dla pętli agentowych i iteracyjnych przepływów deweloperskich (np. asysta kodu, wieloturowe agenty).

- Elastyczny: Potrafi „dostosowywać czas myślenia” do złożoności problemu — odpowiadając na proste pytania natychmiast i rozważając więcej kroków przy zadaniach złożonych.

Wydajność techniczna i wyniki benchmarków

Gemini 3 Flash osiąga potrójny przełom w szybkości, inteligencji i koszcie:

1) Pętle agentowe i rozumienie multimodalne

Gemini 3 Flash dziedziczy ulepszenia architektoniczne i treningowe z szerzej pojętej rodziny Gemini 3, zapewniając silne kompetencje multimodalne (wejścia tekstowe, obrazowe, wideo, audio) oraz poprawione rozumowanie względem wcześniejszych modeli Flash. Google pozycjonuje Flash jako zdolny do realizacji zadań takich jak analiza dokumentów (OCR + rozumowanie), streszczanie wideo, pytania-odpowiedzi obraz+tekst oraz multimodalne zadania programistyczne. Ta zdolność multimodalna, połączona z niskim opóźnieniem, jest jednym z kluczowych atutów technicznych modelu.

Google opublikowało wewnętrzne deklaracje benchmarkowe, podkreślając silną wydajność agentowego kodowania (SWE-bench Verified ~78% dla workflowów agentowego kodowania) oraz to, że Flash zbliża się do rozumowania klasy Pro w wielu zadaniach, pozostając wystarczająco szybkim dla pętli agentowych i workflowów niemal w czasie rzeczywistym.

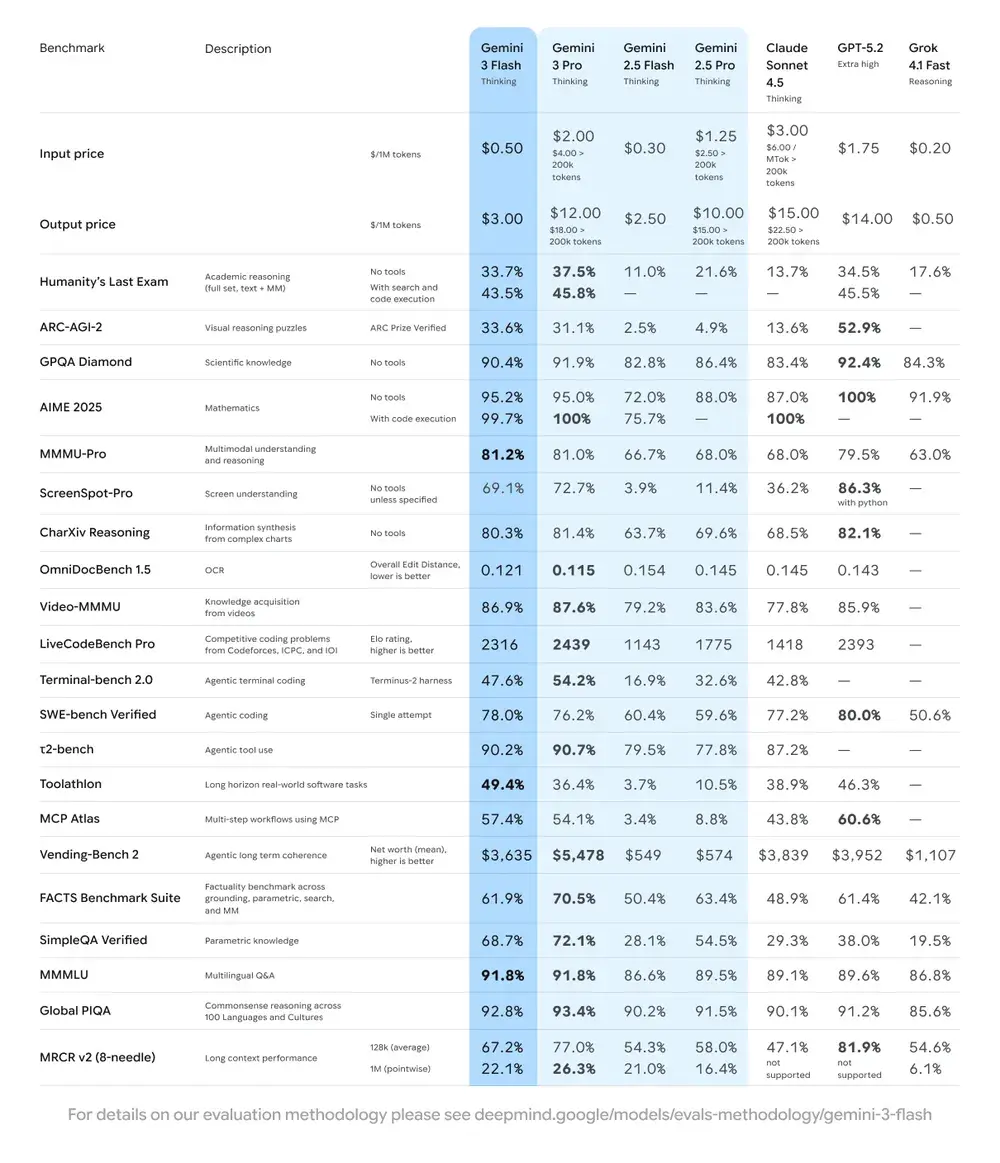

| Benchmark | Wynik Gemini 3 Flash | Model porównawczy | Poprawa |

|---|---|---|---|

| GPQA Diamond (rozumowanie na poziomie PhD) | 90.4% | Przewyższa Gemini 2.5 Pro | Znacząca |

| Humanity’s Last Exam (test wiedzy ogólnej) | 33.7% (bez narzędzi) | Blisko Gemini 3 Pro | Zaawansowane |

| MMMU Pro (rozumienie multimodalne) | 81.2% | Na poziomie Gemini 3 Pro | — |

| SWE-bench Verified (benchmark zdolności kodowania) | 78% | Wyżej niż Gemini 3 Pro i seria 2.5 | Znakomita |

2) Koszt i efektywność

Filozofia rozwoju Gemini 3 Flash to „granica Pareto”: znalezienie optymalnej równowagi między szybkością, jakością a kosztem. Gemini 3 Flash jest wyraźnie zoptymalizowany pod kątem relacji ceny do wydajności. Google podaje ceny Flash znacząco poniżej Pro dla porównywalnych zadań i pozycjonuje go do przetwarzania dużych wolumenów żądań przy niższym koszcie operacyjnym. Dla wielu obciążeń wariant Flash ma być domyślną opcją efektywną kosztowo — na przykład ceny w warstwie preview ok. $0.50 za 1M tokenów wejściowych i $3.00 za 1M tokenów wyjściowych dla warstwy preview Flash. W praktyce czyni to model opłacalnym przy zadaniach o wysokiej częstotliwości, gdzie wyższa opłata za token w Pro byłaby barierą.

Wskaźniki efektywności

- Szybkość: 3x szybciej niż Gemini 2.5 Pro (na podstawie testów Artificial Analysis).

- Efektywność tokenów: Zużywa średnio o 30% mniej tokenów do wykonania tego samego zadania. Innymi słowy, otrzymujesz szybsze, lepsze wyniki za tę samą kwotę.

- Gemini 3 Flash posiada „Dynamic Thinking Mode” — dostosowuje głębokość rozumowania do złożoności zadania, „myśląc nieco więcej”, gdy trzeba, i odpowiadając szybko przy prostych zadaniach.

Implikacje praktyczne: Niższy koszt za token lub wywołanie oznacza, że możesz uruchamiać więcej zapytań, dłuższe konteksty albo wyższe szybkości próbkowania w tym samym budżecie. Zyski efektywności mogą także zmniejszać złożoność infrastruktury (mniej instancji „hot”) i poprawiać gwarancje czasów odpowiedzi.

3) Benchmark wydajności

Gemini 3 Flash osiąga „frontier-class” wydajność w wielu akademickich i aplikacyjnych benchmarkach, zapewniając lepsze opóźnienie i koszt niż wcześniejsze modele Pro. Google prezentuje liczby, takie jak wysokie wyniki w złożonych benchmarkach rozumowania i wiedzy (np. warianty GPQA), aby zilustrować jego kompetencje.

Jak używać Gemini 3 Flash API?

Którą metodę dostępu wybrać?

- Rekomendowana (prosta + odporna): Użyj wzorca integracji SDK pokazywanego przez Comet — kieruje on istniejące SDK GenAI na bazowy URL Comet i dostarcza Twój klucz API Comet. Dzięki temu nie musisz samodzielnie replikować parsowania żądań/strumieniowania.

- Alternatywa (surowe HTTP / curl / własne stosy): Możesz wykonywać POST bezpośrednio na endpointy CometAPI (Comet akceptuje format OpenAI lub kształty specyficzne dla dostawcy). Użyj

Authorization: Bearer <sk-...>(przykłady Comet używają nagłówka Bearer) oraz ciągu modelugemini-3-flashw body. Potwierdź dokładną ścieżkę i parametry zapytania w dokumentacji Comet API dla wybranego modelu.

Szybkie podsumowanie — co zrobisz

- Zarejestruj się w CometAPI i utwórz token API.

- Wybierz metodę dostępu (rekomendowana: wzorzec wrappera SDK pokazany poniżej; alternatywa: surowe HTTP/cURL).

- Wywołaj model

gemini-3-flashprzez bazowy URL CometAPI (Comet przekaże Twoje żądanie do backendu Google Gemini). - Obsłuż strumieniowanie / wywołania funkcji / wejścia multimodalne zgodnie z wymaganiami modelu (szczegóły poniżej).

Poniżej kompaktowy przykład (na bazie wzorców CometAPI), pokazujący, jak wywołać gemini-3-flash przez CometAPI; zamień <YOUR_COMETAPI_KEY> na swój klucz.

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Wyjaśnij, jak działa AI, w kilku słowach",)print(response.text)

Kluczowe parametry żądania, które warto rozważyć

thinking_level— kontroluje wewnętrzną głębokość rozumowania:MINIMAL,LOW,MEDIUM,HIGH. UżywajMINIMAL, aby zyskać najniższe opóźnienie i koszt, gdy nie potrzebujesz głębokiego wieloetapowego rozumowania.media_resolution— dla wejść wizji/wideo:low,medium,high,ultra_high. Niższa rozdzielczość redukuje ekwiwalent tokenów i opóźnienie.streamGenerateContentvsgenerateContent— używaj strumieniowania, aby poprawić postrzegane opóźnienie, gdy chcesz otrzymywać częściowe odpowiedzi w miarę napływu.- Function calling / JSON Mode — korzystaj ze strukturalnych odpowiedzi, gdy potrzebujesz wyników nadających się do parsowania przez maszynę.

Wysyłanie wejść multimodalnych (praktyczne wskazówki)

- Obrazy/PDF-y: preferuj URI Cloud Storage (gs://) dla dużych mediów; wiele API akceptuje base64 dla małych obrazów. Zwracaj uwagę na rozliczanie tokenów względem modalności — PDF-y mogą być liczone do puli obraz/dokument w zależności od endpointu.

- Wideo/audio: dla krótkich klipów możesz przekazywać URI; dla długich mediów używaj workflowów wsadowych lub strumieniuj fragmenty. Sprawdź maksymalne rozmiary wejść i ograniczenia kodowania w dokumentacji API.

- Wywoływanie funkcji / narzędzia: używaj strukturalnych schematów funkcji, aby otrzymywać wyniki JSON i umożliwiać bezpieczne wywołania narzędzi. Gemini 3 Flash obsługuje strumieniowe wywoływanie funkcji dla lepszego UX.

Gdzie mogę uzyskać dostęp do Gemini 3 Flash?

Gemini 3 Flash jest dostępny w produktach konsumenckich i narzędziach deweloperskich Google:

- Google Search i aplikacja Gemini — Flash został wdrożony jako domyślny model dla trybu AI w Search i zintegrowany z doświadczeniem aplikacji Gemini dla użytkowników końcowych.

- Google AI Studio — natychmiastowe miejsce dla deweloperów do eksperymentowania i generowania kluczy API do testów.

- Gemini API (Generative Language / AI Developer API) — dostępny jako

gemini-3-flash-preview(ID modelu używane w dokumentacji/uwagach do wydania) oraz przez standardowe endpointy generateContent / streamGenerateContent. - Vertex AI (Google Cloud) — dostęp produkcyjny przez interfejsy modelu Generative AI Vertex AI oraz cenniki/limity odpowiednie dla obciążeń korporacyjnych.

- Gemini CLI — do tworzenia w terminalu i workflowów skryptowych.

Zewnętrzna bramka CometAPI

CometAPI dodał już gemini-3-flash do swojego katalogu, a strona modelu wyjaśnia, jak wywołać go przez zunifikowany endpoint CometAPI. Udostępniony interfejs API modelu jest wyceniony na 20% oficjalnej ceny.

Najlepsze praktyki przy użyciu Gemini 3 Flash

1) Dobierz thinking_level do zadania i strojenia

- Ustaw

MINIMAL/LOWdla prostego Q&A i interaktywnych zadań o wysokiej częstotliwości. - Używaj

MEDIUM/HIGHwybiórczo dla zadań wymagających głębszego łańcucha rozumowania lub planowania wieloetapowego. - Porównuj koszt vs jakość, gdy zmieniasz

thinking_level. Dokumentacja Google ostrzega, żethinking_levelzmienia wewnętrzne podpisy rozumowania i opóźnienie.

2) Używaj media_resolution, aby kontrolować obliczenia wizji

Jeśli przesyłasz obrazy lub wideo, wybierz najniższą akceptowalną media_resolution dla danego zadania; np. użyj low dla miniaturek i ekstrakcji masowej, high dla krytyki projektów wizualnych. Zmniejsza to ekwiwalent tokenów dla obrazów i obniża opóźnienie.

3) Preferuj strukturalne wyniki dla automatyzacji

Używaj trybu JSON / wywoływania funkcji, gdy Twoja aplikacja potrzebuje wyników możliwych do parsowania przez maszynę (np. ekstrakcja encji, wywoływanie narzędzi). To znacząco upraszcza przetwarzanie downstream. Wymuszaj rygorystyczne schematy JSON, gdy to możliwe, i waliduj po stronie klienta.

4) Szeroko korzystaj ze strumieniowania przy długich odpowiedziach

streamGenerateContent redukuje postrzegane opóźnienie i pozwala na progresywne renderowanie UI. Dla długich zadań multimodalnych strumieniuj częściowe wyniki, aby użytkownicy natychmiast widzieli postęp.

5) Kontroluj koszty dzięki cache’owaniu i zarządzaniu kontekstem

- Używaj cache’owania kontekstu dla powtarzanych odniesień (cenniki i tokeny różnią się między modelami).

- Unikaj wysyłania niepotrzebnie długiego kontekstu, jeśli nie jest wymagany — preferuj zwięzłe prompty i stosuj retrieval + grounding dla dużych baz wiedzy.

Typowe scenariusze użycia Gemini 3 Flash

Agentowe systemy konwersacyjne o dużym wolumenie

Flash naturalnie pasuje do chatbotów i asystentów wsparcia klienta, które potrzebują niskiego opóźnienia i niskiego kosztu na inferencję. Dzięki strumieniowaniu i wysokiej liczbie tokenów/sek. Flash redukuje postrzegany czas oczekiwania i koszty operacyjne.

Asystenci multimodalni i potoki dokumentowe

Ponieważ Flash dobrze obsługuje obrazy, PDF-y i krótkie wideo, częste zastosowania to ekstrakcja z faktur, multimodalne Q&A dotyczące instrukcji, wsparcie klienta z obrazami oraz wczytywanie PDF-ów do baz wiedzy.

Analityka wideo w czasie rzeczywistym i moderacja

Zgłaszana wysoka szybkość generowania wyjść (≈218 t/s w testach prerelease) umożliwia analizę i streszczanie krótkich filmów niemal w czasie rzeczywistym, wykrywanie highlightów i na żywo potoki moderacji treści przy odpowiedniej architekturze.

Agentowe narzędzia deweloperskie i asysta kodowania

Wyniki SWE-bench i raportowana wydajność kodowania czynią Flash dobrym wyborem dla szybkich asystentów kodu, helperów CLI i innych workflowów deweloperskich, które priorytetyzują niskie opóźnienie.

Wnioski — czy warto wdrożyć Gemini 3 Flash już teraz?

Gemini 3 Flash to strategiczna propozycja dla zespołów potrzebujących silnego rozumowania i inteligencji multimodalnej bez opóźnień i kosztów topowych modeli Pro. Model jest szczególnie dobrze dopasowany do agentowych asystentów kodowania, interaktywnych agentów multimodalnych, potoków przetwarzania dokumentów oraz każdego systemu, w którym priorytetem są niskie opóźnienie i skala. Wczesne benchmarki (zarówno Google, jak i niezależne analizy) wskazują, że Flash jest konkurencyjny jakościowo, a jednocześnie oferuje istotne przewagi przepustowości i kosztu.

Aby zacząć, poznaj możliwości Gemini 3 Flash w Playground i zapoznaj się z przewodnikiem API po szczegółowe instrukcje. Przed dostępem upewnij się, że zalogowałeś(-aś) się do CometAPI i uzyskałeś(-aś) klucz API. CometAPI oferuje cenę znacznie niższą od oficjalnej, aby ułatwić integrację.

Gotowy(-a) do startu?→ Darmowy trial Gemini 3 Flash !