Ostatni wzrost automatyzacji opartej na sztucznej inteligencji zapoczątkował potrzebę bardziej dynamicznych i kontekstowych przepływów pracy. n8n, narzędzie do automatyzacji przepływów pracy typu open source, wyłoniło się jako potężna platforma do organizowania złożonych procesów bez rozległej wiedzy z zakresu kodowania. Tymczasem protokół Model Context Protocol (MCP) standaryzuje sposób, w jaki agenci AI wchodzą w interakcje z usługami zewnętrznymi, umożliwiając im odkrywanie narzędzi i wykonywanie operacji w spójny sposób. Poprzez integrację n8n z serwerami MCP organizacje mogą odblokować nowy poziom elastyczności, umożliwiając agentom AI wywoływanie przepływów pracy n8n jako narzędzi i odwrotnie, n8n może bezpośrednio korzystać z usług zgodnych z MCP w ramach swoich przepływów pracy. Ta dwukierunkowa możliwość pozycjonuje n8n jako zarówno producenta, jak i konsumenta zadań opartych na sztucznej inteligencji, usprawniając kompleksową automatyzację i zmniejszając potrzebę niestandardowego kodu integracyjnego.

Co to jest n8n?

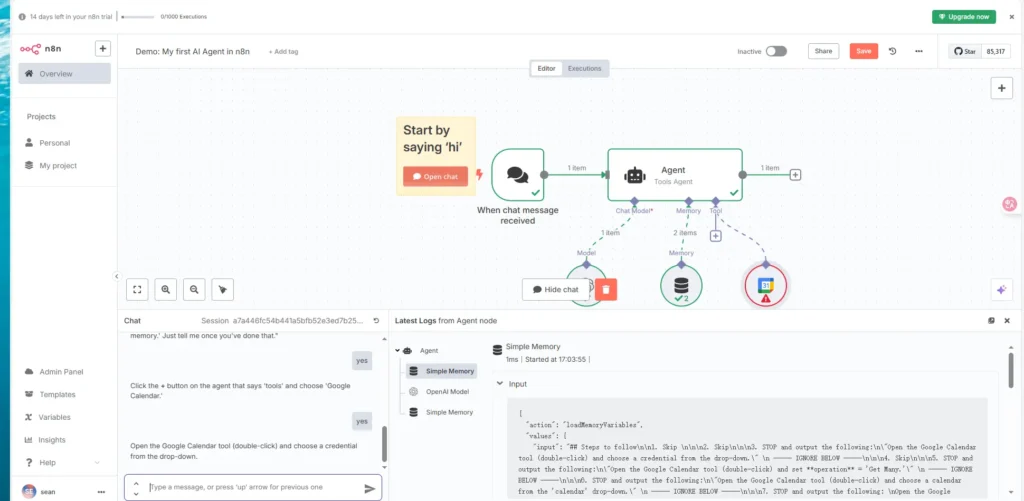

n8n to platforma automatyzacji przepływu pracy charakteryzująca się opartym na węzłach, uczciwym modelem licencjonowania, który pozwala użytkownikom budować sekwencje działań (węzłów), które są wyzwalane na podstawie zdarzeń lub harmonogramów. Obsługuje szeroką gamę integracji od razu, od żądań HTTP i baz danych po platformy komunikatów i usługi w chmurze. W przeciwieństwie do restrykcyjnych narzędzi automatyzacji „black-box”, n8n daje deweloperom pełną kontrolę nad ich przepływami pracy, w tym możliwość samodzielnego hostowania i rozszerzania funkcjonalności za pośrednictwem węzłów społeczności lub niestandardowego kodu.

Czym jest MCP?

Model Context Protocol (MCP) to nowy standard, który definiuje sposób, w jaki modele AI i agenci odkrywają, uzyskują dostęp i organizują zewnętrzne narzędzia i źródła danych. Zapewnia on jednolitą powierzchnię API i schemat metadanych, umożliwiając bezproblemową interoperacyjność między agentami AI — takimi jak duże modele językowe (LLM) — a usługami, które udostępniają wykonalne możliwości. Serwery MCP publikują definicje narzędzi i szablony monitów, podczas gdy klienci MCP — często osadzeni w agentach AI — mogą żądać i wykonywać te narzędzia na podstawie kontekstowych monitów.

Jakie ostatnie aktualizacje sprawiają, że ta integracja jest niezbędna?

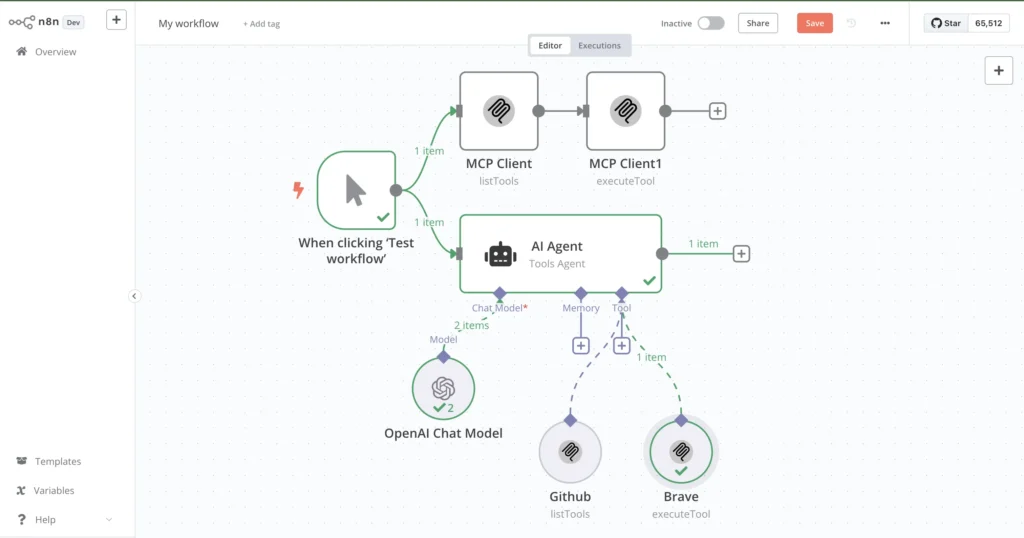

Między lutym a kwietniem 2025 r. zespół n8n oficjalnie wprowadził dwa kluczowe węzły: Narzędzie klienta MCP i Wyzwalacz serwera MCPWęzeł MCP Client Tool umożliwia przepływom pracy n8n wywoływanie zewnętrznych serwerów MCP tak, jakby były węzłami natywnymi, otwierając funkcjonalność obsługiwaną przez AI za pomocą jednego interfejsu. Z kolei węzeł MCP Server Trigger zamienia przepływ pracy n8n w serwer MCP, umożliwiając zewnętrznym agentom AI bezpośrednie wywoływanie działań przepływu pracy. Te udoskonalenia stawiają n8n na czele automatyzacji przepływów pracy AI, zmniejszając złożoność i umożliwiając szybki rozwój inteligentnych potoków automatyzacji.

Jak zainstalować i skonfigurować n8n dla serwerów MCP?

Zanim zagłębisz się w integracje MCP, potrzebujesz funkcjonalnej instancji n8n. Możesz samodzielnie hostować n8n na komputerze lokalnym lub wdrażać na platformach w chmurze za pomocą instalatorów jednym kliknięciem, kontenerów Docker lub usług zarządzanych.

Wymagania wstępne

- node.js:Zalecana jest wersja 18.17.0, 20.x lub 22.x; n8n obecnie nie obsługuje Node.js 23.x.

- git oraz npm/przędza:Do instalacji węzłów n8n i społecznościowych.

- Doker (opcjonalnie): Umożliwia łatwe wdrażanie w kontenerach.

- Środowisko hostingowe:Komputer lokalny, VPS lub usługa w chmurze, taka jak Zeabur, gdzie można udostępnić punkt końcowy HTTP dla ruchu MCP.

Kroki instalacji

Zainstaluj Menedżera wersji węzła (NVM)

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

source ~/.nvm/nvm.sh

nvm install 18.17.0

nvm use 18.17.0

Zapewnia to zgodność z wersjami Node.js obsługiwanymi przez n8n.

Zainstaluj n8n globalnie

npm install -g n8n

Po instalacji wywołaj n8n aby uruchomić interfejs sieciowy w http://localhost:5678 .

Utwórz swoje konto

Przy pierwszym uruchomieniu n8n prosi o utworzenie konta. Wprowadź adres e-mail i hasło — nie jest wymagana karta kredytowa w przypadku bezpłatnej edycji społecznościowej.

Zainstaluj węzeł społeczności MCP (opcjonalnie dla klienta)

W ustawieniach n8n w obszarze „Węzły społeczności” wyszukaj i zainstaluj n8n-węzły-mcpTa wtyczka zapewnia rozszerzone możliwości klienta MCP, jeśli Twoja wersja n8n nie ma wbudowanego węzła.

Jak skonfigurować węzeł wyzwalacza serwera MCP w n8n?

Przekształcenie n8n w serwer MCP umożliwia zewnętrznym agentom AI traktowanie przepływów pracy jako wywoływalnych narzędzi. Wykonaj następujące kroki:

Dodawanie węzła wyzwalacza serwera MCP

- Utwórz nowy przepływ pracy

W edytorze n8n kliknij „Nowy przepływ pracy”. - Dodaj węzeł

Szukaj Wyzwalacz serwera MCP w panelu węzłów i przeciągnij go do obszaru roboczego. - Ustaw aktywację

Przełącz przepływ pracy na „Aktywny” po konfiguracji. Węzeł wyzwalacza serwera MCP wygeneruje unikalny punkt końcowy, zwykle w/mcp/<randomId>.

Konfigurowanie wyzwalacza

- Ścieżka URL MCP: Zaakceptuj domyślną ścieżkę lub określ ścieżkę niestandardową (np.

/mcp/ai-tools). - Uwierzytelnianie: Na potrzeby początkowych testów wybierz opcję „Brak”, ale na potrzeby produkcji skonfiguruj klucze API, OAuth lub weryfikację JWT, aby zabezpieczyć punkt końcowy.

- Schemat wejściowy: Zdefiniuj oczekiwane klucze ładunku JSON (np.

tool,params). n8n przeanalizuje przychodzący JSON i automatycznie zamapuje pola na kolejne węzły.

Po skonfigurowaniu każde żądanie HTTP POST do punktu końcowego (np. http://your-domain.com/mcp/abc123) uruchamia przepływ pracy, umożliwiając agentom AI wywoływanie udostępnionych przez Ciebie narzędzi.

Jak skonfigurować narzędzie klienta MCP w n8n?

Podczas gdy Server Trigger udostępnia n8n jako dostawcę narzędzi, węzeł MCP Client Tool umożliwia n8n korzystanie z zewnętrznych usług MCP w ramach przepływów pracy.

Instalowanie węzła społeczności

Jeśli nie zainstalowałeś n8n-węzły-mcp wcześniej, wykonaj teraz następujące kroki:

- Otwórz Ustawienia → Węzły społeczności

- Zainstaluj nowy węzeł: Szukaj

n8n-nodes-mcpi kliknij „Zainstaluj”. - Uruchom ponownie n8n aby załadować nowy węzeł.

Konfigurowanie narzędzia klienta MCP

- Dodaj węzeł narzędzia klienta MCP

W swoim przepływie pracy wyszukaj Narzędzie klienta MCP i dodaj to. - Konfigurowanie połączenia

- Adres URL serwera: Wprowadź punkt końcowy serwera MCP (np. własny adres URL wyzwalacza MCP n8n lub usługę innej firmy).

- Nazwa narzędzia: Określ identyfikator narzędzia opublikowany przez serwer (np.

sendEmail,fetchData). - Parametry:Mapuj pola wejściowe z poprzednich węzłów lub zmiennych przepływu pracy.

- Zajmij się odpowiedzią

Węzeł narzędzia klienta MCP zwraca ustrukturyzowane dane wyjściowe JSON, które można przekazać do kolejnych węzłów, takich jak „Zestaw” lub „Odpowiedź HTTP” w celu sformatowania lub dalszego przetworzenia.

Jak testować i weryfikować serwer MCP w n8n?

Walidacja jest kluczowa dla zapewnienia, że punkty końcowe MCP i integracje klientów działają niezawodnie w różnych scenariuszach.

Wysyłanie żądań testowych

Użyj narzędzi takich jak curl or Listonosz aby wysłać próbne ładunki:

curl -X POST http://localhost:5678/mcp/abc123 \

-H 'Content-Type: application/json' \

-d '{"tool": "exampleTool", "params": {"message": "Hello, world!"}}'

Pomyślna odpowiedź oznacza, że n8n przeanalizował żądanie, wykonał przepływ pracy i zwrócił oczekiwany wynik.

Debugowanie typowych problemów

- Nieprawidłowy JSON: Upewnij się, że ładunki są poprawnie sformatowane; n8n odrzuci nieprawidłowo sformatowane dane wejściowe i zgłosi błąd 400.

- Niepowodzenia uwierzytelniania: Jeśli używasz kluczy API lub OAuth, sprawdź, czy nagłówki i tokeny są poprawnie skonfigurowane.

- Błędy przepływu pracy:Użyj dziennika wykonania n8n do sprawdzenia danych dotyczących wykonania węzła i komunikatów o błędach.

- Łączność sieciowa: Sprawdź, czy Twoja instancja n8n jest dostępna ze środowiska klienta, zwracając uwagę na reguły zapory i ustawienia DNS.

Jakie są przykładowe przypadki użycia n8n z serwerami MCP?

Zintegrowanie n8n z MCP otwiera różnorodne scenariusze automatyzacji w różnych domenach — oto kilka przykładów.

Automatyzacja przepływów pracy e-mail

Załóżmy, że chcesz, aby agenci AI wysyłali na żądanie spersonalizowane wiadomości e-mail:

- Wyzwalacz serwera MCP:Udostępnia narzędzie o nazwie

sendEmail. - Węzeł e-mail: Podłącz wyzwalacz do węzła „Wyślij e-mail” n8n (SMTP, Gmail itp.).

- Mapowanie parametrów:Mapa

to,subject,bodyz ładunku MCP do pól węzła poczty e-mail.

Agent AI po prostu wywołuje sendEmail narzędzie za pośrednictwem protokołu MCP, eliminując potrzebę zarządzania szczegółami SMTP w samym agencie.

Pobieranie i przekształcanie danych API

Aby umożliwić agentom AI wykonywanie zapytań i przetwarzanie interfejsów API innych firm:

- Wyzwalacz serwera MCP:Narzędzie o nazwie

fetchData. - Węzeł żądania HTTP:Skonfigurowano do wywołania zewnętrznego interfejsu API (np.https://api.cometapi.com/v1/chat/completions).

- Ustaw węzeł:Formatuje i filtruje odpowiedź API.

- Powrót:Wysyła do klienta ustrukturyzowany plik JSON.

Agenci AI mogą żądać określonych zestawów danych bez konieczności zajmowania się paginacją, uwierzytelnianiem ani ograniczaniem przepustowości.

Tworzenie agentów głosowych AI

Asystenci głosowi mogą wykorzystywać n8n jako zaplecze:

- Wyzwalacz serwera MCP udostępnia narzędzia takie jak

createTaskorcheckCalendar. - Moduł głosowy tłumaczy polecenia głosowe na żądania MCP (np. „Utwórz spotkanie jutro o 3:XNUMX”).

- Przepływy pracy n8n współpracują z Kalendarzem Google, bazami danych lub funkcjami niestandardowymi, a następnie zwracają potwierdzenie do agenta.

Takie podejście oddziela logikę interfejsu głosowego od integracji zaplecza, co upraszcza konserwację i rozwój.

Jakie są najlepsze praktyki i kwestie bezpieczeństwa?

Integracje MCP gotowe do produkcji wymagają solidnych środków bezpieczeństwa, monitorowania i skalowalności.

Uwierzytelnianie i kontrola dostępu

- Klucze API: Wydawaj klucze dla każdego klienta z zakresami szczegółowymi (np. zezwalaj tylko na

readorwrite(operacje). - OAuth 2.0 / JWT: W środowiskach korporacyjnych możliwa jest integracja z dostawcami tożsamości (Okta, Auth0).

- Ograniczanie tempa:Używaj odwrotnych serwerów proxy (NGINX, Traefik) lub bram API w chmurze, aby ograniczać żądania i zapobiegać nadużyciom.

Skalowalność i wydajność

- Skalowanie poziome:Wdróż wiele wystąpień n8n za modułem równoważenia obciążenia w celu rozłożenia ruchu MCP.

- Kolejki Redis/Bazy Danych: Przenieś ciężkie lub długotrwałe zadania do kolejek w tle, zapewniając szybką reakcję MCP.

- Monitorowanie:Wdrożenie rejestrowania (np. Elastic Stack) i metryk (Prometheus, Grafana) w celu śledzenia czasu wykonywania przepływów pracy i wskaźników błędów.

Jaka przyszłość czeka integrację n8n i MCP?

Ekosystem wokół MCP i n8n szybko się rozwija, a na horyzoncie widać kilka obiecujących wydarzeń.

Nadchodzące funkcje

- Dynamiczne odkrywanie narzędzi:Agenci mogą w czasie rzeczywistym wyszukiwać w n8n dostępne narzędzia i metadane, co pozwala na jeszcze bardziej elastyczne przepływy pracy.

- Ulepszone węzły bezpieczeństwa:Wprowadzenie wbudowanego szyfrowania, rotacji tokenów i węzłów rejestrujących audyt w ramach n8n.

- Klient MCP o niskim kodzie:Dalsze abstrakcje upraszczające korzystanie z MCP bez konieczności instalowania niestandardowych węzłów.

Rozwój społeczności i ekosystemu

- Rynek przepływów pracy MCP:Platformy takie jak n8n.io/workflows już zawierają przykładowe szablony serwerów MCP, co sprzyja udostępnianiu i ponownemu wykorzystywaniu.

- Usługi firm trzecich:Dostawcy usług w chmurze i platformy SaaS zaczynają publikować punkty końcowe MCP, rozszerzając zasięg automatyzacji opartej na sztucznej inteligencji.

- Współpraca w zakresie otwartych standardówSpecyfikacja MCP jest aktywnie rozwijana przy udziale głównych dostawców rozwiązań z zakresu sztucznej inteligencji i automatyzacji, których celem jest zwiększenie interoperacyjności.

Zobacz także Jak używać n8n z CometAPI

Podsumowanie

Integracja n8n z serwerami MCP przekształca statyczne przepływy pracy w dynamiczne usługi oparte na sztucznej inteligencji i wyposaża n8n w możliwość korzystania z zewnętrznych narzędzi zorientowanych na sztuczną inteligencję. Niedawne wprowadzenie węzła MCP Client Tool i MCP Server Trigger stanowi znaczący krok naprzód, usprawniając zarówno rozwój, jak i konserwację inteligentnych potoków automatyzacji. Postępując zgodnie z najlepszymi praktykami w zakresie instalacji, konfiguracji, bezpieczeństwa i testowania, organizacje mogą wykorzystać pełny potencjał tej integracji, aby szybciej wprowadzać innowacje, zmniejszyć narzut inżynieryjny i dostarczać automatyzację zależną od kontekstu w różnych przypadkach użycia.