Przestrzeń narzędzi do wizualnej sztucznej inteligencji o niskim kodzie dynamicznie się rozwija. Flowise — wizualny kreator open source dla przepływów pracy LLM — stale dodaje integracje ze społecznością i regularnie publikuje aktualizacje; CometAPI jest jednym z kilku ujednolicone API AI Platformy, które obecnie udostępniają setki modeli za pośrednictwem jednego punktu końcowego; a bezkodowe narzędzia do tworzenia backendów, takie jak BuildShip, również udostępniają węzły do wywoływania CometAPI, co pozwala na łączenie tych samych modeli z przepływami pracy na serwerze. Ten przewodnik pokazuje, dlaczego i kiedy łączyć te elementy, a następnie przeprowadza Cię przez konkretną integrację Flowise → CometAPI, jak połączyć Prompt → LLM Chain → CometAPI, zalecane najlepsze praktyki i przykładowe przypadki użycia.

Czym jest FlowiseAI i dlaczego jest to ważne?

FlowiseAI to wizualna platforma open source do tworzenia przepływów pracy LLM, asystentów czatu i potoków agentowych. Oferuje ona platformę typu „przeciągnij i upuść” zbudowaną z węzłów (integracji), które reprezentują monity, łańcuchy, łączniki LLM, programy do pobierania, pamięć, narzędzia i dane wyjściowe – umożliwiając zespołom prototypowanie i wdrażanie systemów opartych na LLM bez konieczności ręcznego okablowania wszystkiego. Flowise udostępnia również interfejsy API, narzędzia do śledzenia, narzędzia ewaluacyjne i węzły utrzymywane przez społeczność, dzięki czemu jest przydatna zarówno do szybkiego prototypowania, jak i eksperymentów produkcyjnych.

Dlaczego to ma znaczenie: Korzystając z Flowise, zyskujesz wizualną obserwację i szybką iterację w łańcuchach poleceń i wyborach modeli — a dodając łączniki innych firm (takie jak CometAPI), możesz przełączać się lub eksperymentować z wieloma modelami bazowymi przy minimalnych zmianach.

Czym jest CometAPI i co zapewnia?

CometAPI to ujednolicona warstwa API, która agreguje dostęp do setki modeli AI (OpenAI, Anthropic/Claude, Google/Gemini, modele Replicate, dostawcy obrazów i audio itp.) oparte na jednym, spójnym formacie żądań i schemacie uwierzytelniania. Oznacza to, że można wybierać lub zamieniać modele, porównywać koszty/opóźnienia lub programowo przełączać się między dostawcami bez konieczności przepisywania kodu aplikacji. Platforma jest pozycjonowana jako niezależna od dostawcy warstwa dostępu do modeli LLM i modeli multimodalnych, umożliwiająca zarządzanie kosztami.

Co to daje w praktyce: prostsze zarządzanie uprawnieniami na potrzeby oceny wielomodelowej, możliwość szybkiego przeprowadzania testów A/B różnych modeli oraz (często) optymalizacja kosztów poprzez wybieranie tańszych wariantów modelu, gdy jest to właściwe.

Dlaczego warto zintegrować FlowiseAI z CometAPI?

Integracja Flowise z CometAPI zapewnia wygodę wizualnego kreatora Flowise oraz scentralizowany dostęp do wielu zapleczy modeli za pośrednictwem CometAPI. Korzyści obejmują:

- Pojedyncze zarządzanie poświadczeniami dla wielu punktów końcowych modelu (przez CometAPI).

- Łatwy model A/Bing i routing na poziomie dostawcy w łańcuchu wizualnym (przełączanie modeli bez zmiany okablowania węzła).

- Szybsze eksperymentowanie: zamieniaj modele, dostosowuj monity i porównuj wyniki w przepływach Flowise.

- Mniejsze tarcie inżynieryjne dla zespołów, które potrzebują wizualnej warstwy orkiestracji, ale w tle potrzebują wielu dostawców modeli.

- Dlaczego warto zintegrować FlowiseAI z CometAPI?

- Integracja Flowise z CometAPI zapewnia wygodę wizualnego kreatora Flowise oraz scentralizowany dostęp do wielu zapleczy modeli za pośrednictwem CometAPI. Korzyści obejmują:

- Pojedyncze zarządzanie poświadczeniami dla wielu punktów końcowych modelu (przez CometAPI).

- Łatwy model A/Bing i routing na poziomie dostawcy w łańcuchu wizualnym (przełączanie modeli bez zmiany okablowania węzła).

- Szybsze eksperymentowanie: zamieniaj modele, dostosowuj monity i porównuj wyniki w przepływach Flowise.

- Mniejsze tarcie inżynieryjne dla zespołów, które potrzebują wizualnej warstwy orkiestracji, ale w tle potrzebują wielu dostawców modeli.

- Te możliwości przyspieszają konfigurację RAG, koordynację agentów i przepływy pracy kompozycji modeli, jednocześnie zachowując wizualną historię pochodzenia i możliwość śledzenia, jakie zapewnia Flowise.

Te możliwości przyspieszają konfiguracje RAG, koordynację agentów i przepływy pracy związane z komponowaniem modeli, zachowując jednocześnie wizualne pochodzenie i śledzenie Flowise zapewnia.

Jakie środowisko i warunki wstępne są potrzebne przed integracją?

Lista kontrolna (minimum):

- Zaloguj się do Przepływ AI

- A Interfejs API Comet Konto + klucz API (pobierzesz go z konsoli CometAPI). Uwaga: CometAPI używa ścieżki bazowej (np.

https://api.cometapi.com/v1/) w przypadku żądań — podasz je w ustawieniach węzła Flowise.

Przygotowania operacyjne i bezpieczeństwa:

- Przechowuj klucze API w Flowise Credentials — nie umieszczaj kluczy w szablonach monitów ani kodzie węzła.

- Limity przepustowości i szybkości planu: zarówno CometAPI, jak i dostawcy bazowych modeli mogą narzucać limity — sprawdź swój plan i w razie potrzeby zastosuj ograniczanie przepustowości lub ponowne próby po stronie klienta.

- Zwróć uwagę na koszty: zmieniając modele, możesz znacząco zmienić sposób wykorzystania tokenów i koszty — metryki instrumentów i ustalić zabezpieczenia.

Jak zintegrować CometAPI z FlowiseAI? (Znajdź i dodaj węzeł CometAPI — jakie są kroki?)

Aby dodać, wykonaj poniższe praktyczne kroki ChatCometAPI węzeł i skonfiguruj dane uwierzytelniające.

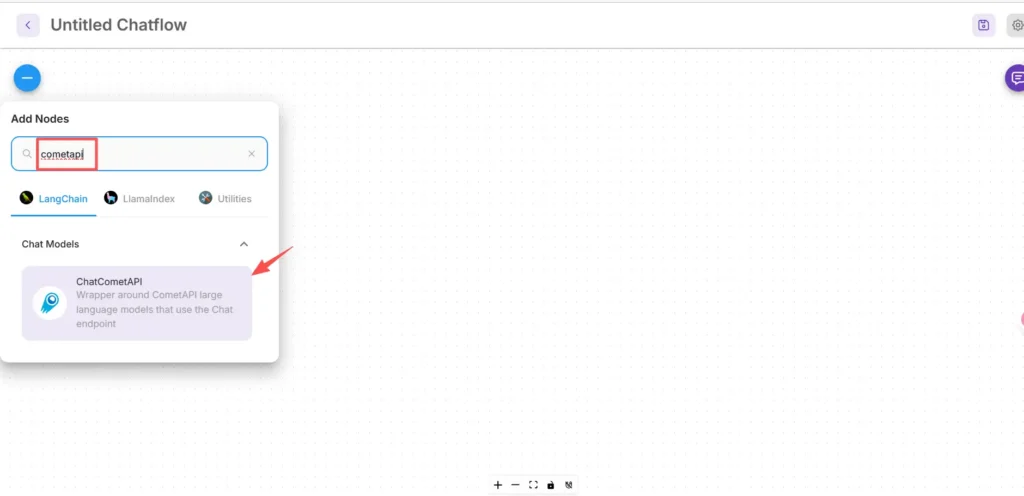

Krok 1 — Sprawdź, czy węzeł jest dostępny

- Na płótnie FlowiseAI kliknij Dodaj nowy.

- W polu wyszukiwania wpisz „cometapi”, aby znaleźć pole CometAPI. Niektóre węzły społeczności pojawiają się w sekcji LangChain → Modele czatu.

Krok 2 — Dodaj węzeł CometAPI do swojego przepływu

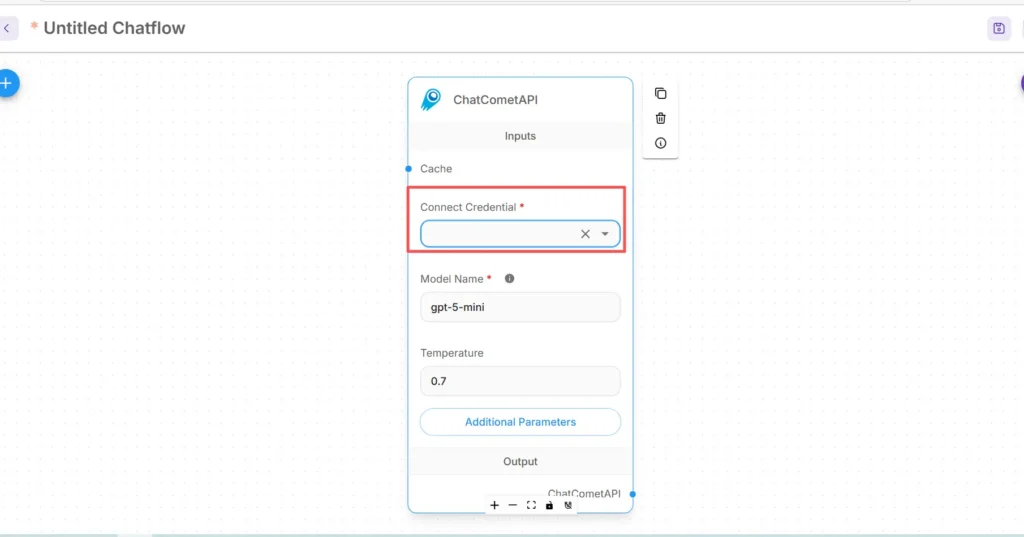

- Przeciągnij ChatCometAPI Węzeł do swojego obszaru roboczego. Węzeł udostępnia wybór modelu, temperaturę, maksymalne tokeny i inne parametry wnioskowania.

- Ustawiać Start/Wprowadzenie węzeł (lub węzeł frontowy Twojego chatbota) powyżej węzła CometAPI.

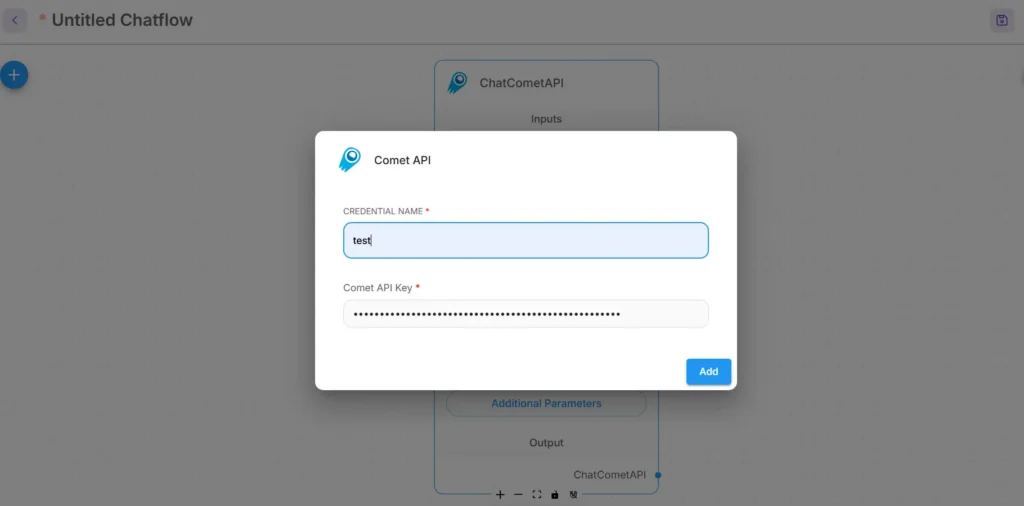

Krok 3 — Skonfiguruj dane uwierzytelniające dla CometAPI

- W menu rozwijanym Połącz poświadczenia węzła CometAPI wybierz opcję Utwórz nowy i znajdź Klucz API / Listy uwierzytelniające pole. (W Flowise lub otwarte Listy uwierzytelniające)

- Wpisz swój Klucz API CometAPI (najlepiej za pośrednictwem menedżera uprawnień Flowise lub jako zmienna środowiskowa). Na produkcji użyj zarządzania sekretami

- Wybierz domyślny model bazowy (lub pozostaw go regulowany z poziomu danych wejściowych węzła, jeśli chcesz przełączać się między modelami w czasie wykonywania). CometAPI zazwyczaj akceptuje

modelparametr wskazujący, którego dostawcę/model użyć.

Krok 4 — Ustaw ścieżkę bazową i dodatkowe parametry.

W ustawieniach węzła ChatCometAPI rozwiń Dodatkowe parametry i ustaw Ścieżka bazowa do https://api.cometapi.com/v1/ (jest to wymagane, aby węzeł wskazywał na bramę CometAPI v1). Opcjonalnie dostosuj domyślną nazwę modelu lub parametry dostawcy obsługiwane przez CometAPI.

Wskazówki dotyczące rozwiązywania problemów:

- Jeśli połączenia się nie powiodą, sprawdź wyjście sieciowe i wszelkie reguły zapory/NAT między punktami końcowymi Flowise i CometAPI.

- Sprawdź limity szybkości i odpowiedzi błędów zwracane przez CometAPI; wprowadź wykładniczy odliczanie dla 429/5xx.

Jak dodać węzeł Prompt i skonfigurować łańcuch LLM w Flowise?

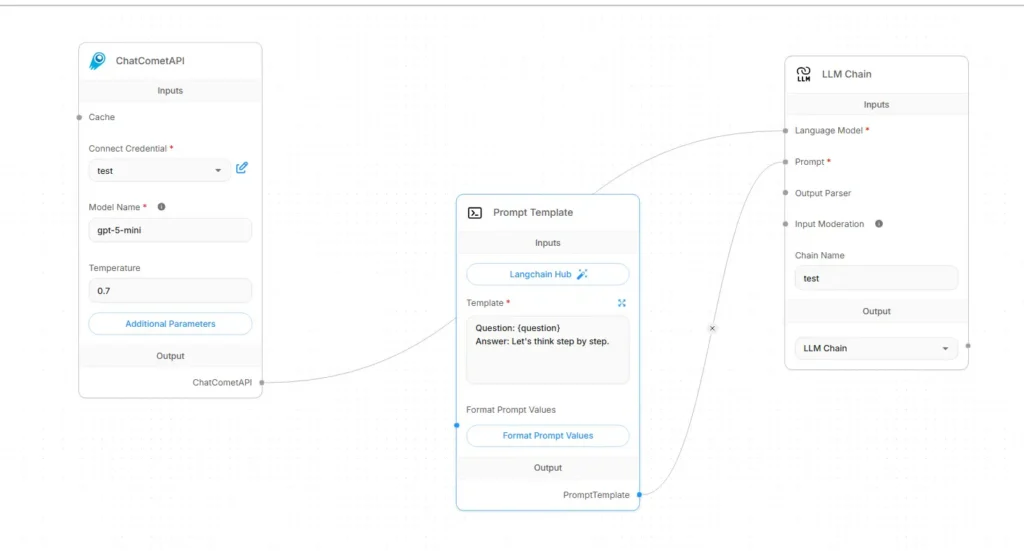

Przepływy Flowise LLM są zazwyczaj montowane jako Wejście → Szablon monitu → Łańcuch LLM → WyjścieOto konkretny przepis na okablowanie wykorzystujący CometAPI jako model językowy:

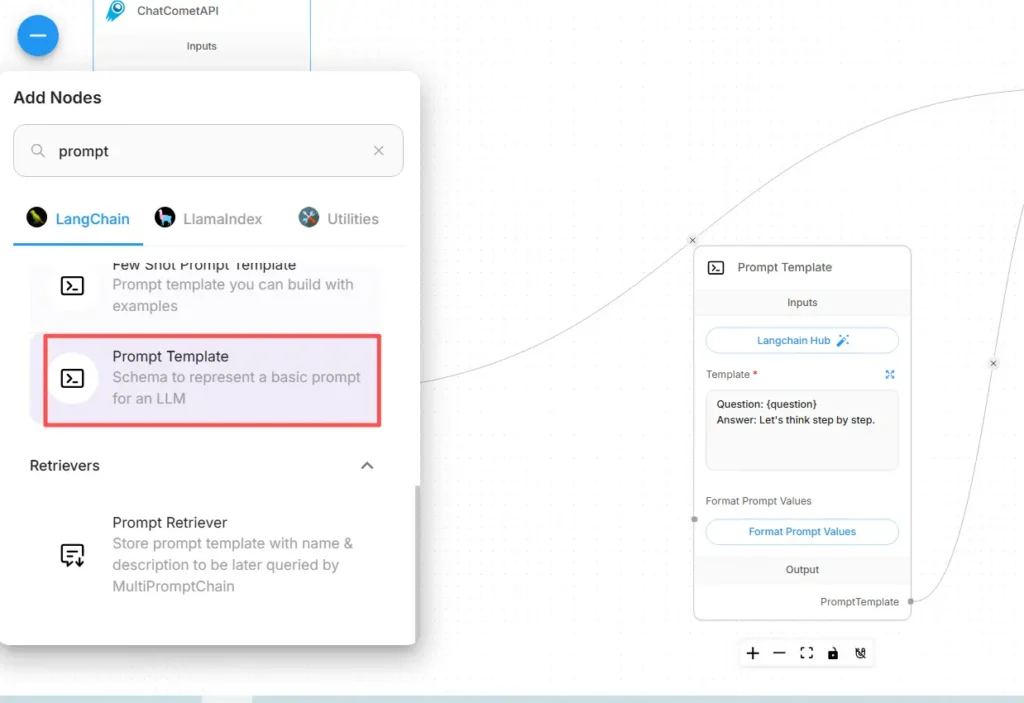

Krok A — Utwórz węzeł szablonu monitu

- dodaj Szablon zachęty węzeł (lub węzeł „Monit”) do płótna.

- W węźle Prompt utwórz szablon, używając zmiennych dla dynamicznej zawartości, np.:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- Expose

user_inputjako zmienna, która ma zostać wypełniona z węzła Start/Wejście.

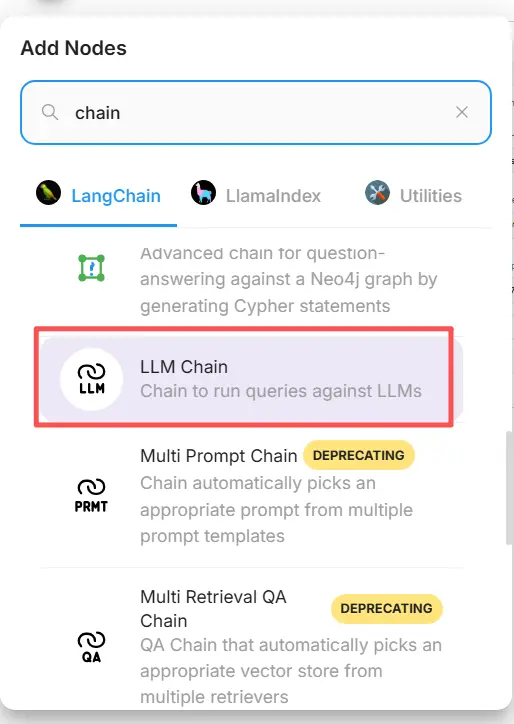

Krok B — Dodaj węzeł łańcucha LLM (otoczkę LLM)

Dodaj Łańcuch LLM or LLM Węzeł reprezentujący wywołanie modelu → monit. W Flowise węzeł łańcucha LLM ma zazwyczaj dwa główne wejścia: Model języka (węzeł modelu/wnioskowania) i Skłonić (szablon monitu).

Krok C — Podłącz węzły (okablowanie jawne)

- Połącz węzeł CometAPI z łańcuchem LLM Model języka wkład.

Informuje łańcuch, który model ma wywołać w celu generacji. (CometAPI staje się dostawcą modelu.) - Połącz węzeł szablonu monitu z łańcuchem LLM Skłonić wkład.

Łańcuch połączy szablon monitu z wartościami zmiennych i wyśle wynikowy monit do CometAPI. - Połącz węzeł Start/Wprowadzenie z szablonem monitu

user_inputzmienna. - Połącz wyjście łańcucha LLM z węzłem wyjściowym (odpowiedź interfejsu użytkownika lub narzędzie podrzędne).

Wizualnie przepływ powinien wyglądać następująco:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

Krok D — Przeprowadź test na sucho

- Uruchom przepływ w konsoli testowej Flowise. Sprawdź monit wysłany do CometAPI, tokeny odpowiedzi i opóźnienie. Dostosuj temperaturę, maksymalną wartość tokenów lub górny p w ustawieniach węzła CometAPI, aby dopasować kreatywność do determinizmu.

Jakie praktyczne zastosowania umożliwia ta integracja?

Poniżej przedstawiono konkretne przypadki użycia, w których Flowise + CometAPI daje wymierne korzyści:

1) Trasowanie wielomodelowe / wybór najlepszego narzędzia

Twórz przepływy, które wybierają modele dla każdego podzadania: szybkie podsumowanie przy użyciu niedrogiego modelu, faktyczne uzasadnienie przy użyciu modelu o wysokiej dokładności oraz generowanie obrazu za pośrednictwem modelu obrazu — wszystko za pośrednictwem parametrów CometAPI bez konieczności zmiany okablowania Flowise.

2) Testowanie i ocena modelu A/B

Utwórz dwa równoległe łańcuchy LLM w Flowise (A vs. B), przekieruj ten sam komunikat do różnych modeli CometAPI i przekaż wyniki do małego węzła porównawczego, który ocenia wyniki. Użyj metryk, aby zdecydować, który model zastosować.

3) Hybrydowy RAG (Retriever + LLM)

Użyj magazynu dokumentów i modułu wyszukiwania wektorów Flowise, aby zebrać kontekst, a następnie wyślij połączony szablon monitu do modelu CometAPI. Zunifikowane API upraszcza zamianę LLM używanego do końcowej syntezy.

4) Narzędzia agentowe (API, bazy danych, kod)

Narzędzia do tworzenia (HTTP GET/POST, wywołania DB) w agentach Flowise, wykorzystanie CometAPI do wnioskowania językowego i wyboru akcji oraz kierowanie danych wyjściowych do konektorów/narzędzi. Flowise obsługuje w tym celu narzędzia do obsługi żądań i wzorce agentów.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Na początek zapoznaj się z możliwościami modelu w Plac zabaw i skonsultuj się z Flowise Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ Zarejestruj się w CometAPI już dziś !

Ostateczne zalecenia i podsumowanie

Integracja Flowise z CometAPI to pragmatyczny sposób na połączenie szybkiej orkiestracji wizualnej (Flowise) z elastycznym dostępem do wielu dostawców modeli (CometAPI). Ten schemat — przechowywanie monitów jako szablonów, rozdzielanie węzłów modeli i ostrożne uruchamianie instrumentów — pozwala zespołom na szybkie iterowanie i przełączanie dostawców bez konieczności przepisywania przepływów. Pamiętaj o bezpiecznym zarządzaniu danymi uwierzytelniającymi, uwzględnieniu opóźnień i kosztów oraz instrumentacji przepływów w celu zapewnienia możliwości obserwacji i zarządzania.