Interfejs API Llama 4 to potężny interfejs umożliwiający programistom integrację MetaNajnowsze multimodalne modele językowe firmy, umożliwiające zaawansowane przetwarzanie tekstu, obrazów i wideo w różnych aplikacjach.

Przegląd serii Llama 4

Seria Llama 4 firmy Meta wprowadza najnowocześniejsze modele AI zaprojektowane do przetwarzania i tłumaczenia różnych formatów danych, w tym tekstu, wideo, obrazów i dźwięku, zwiększając tym samym wszechstronność w różnych aplikacjach. Seria obejmuje:

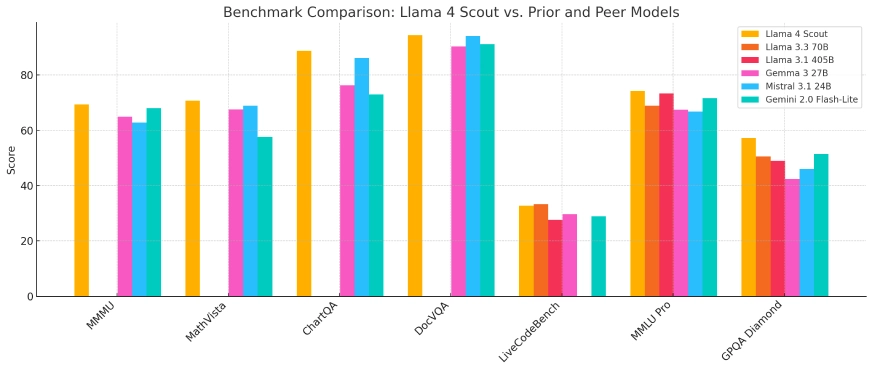

- Lama 4 Scout: Kompaktowy model zoptymalizowany do wdrożenia na pojedynczym procesorze graficznym Nvidia H100, wyposażony w okno kontekstowe o pojemności 10 milionów tokenów. Przewyższa konkurentów, takich jak Google Gemma 3 i Mistral 3.1 w różnych testach porównawczych.

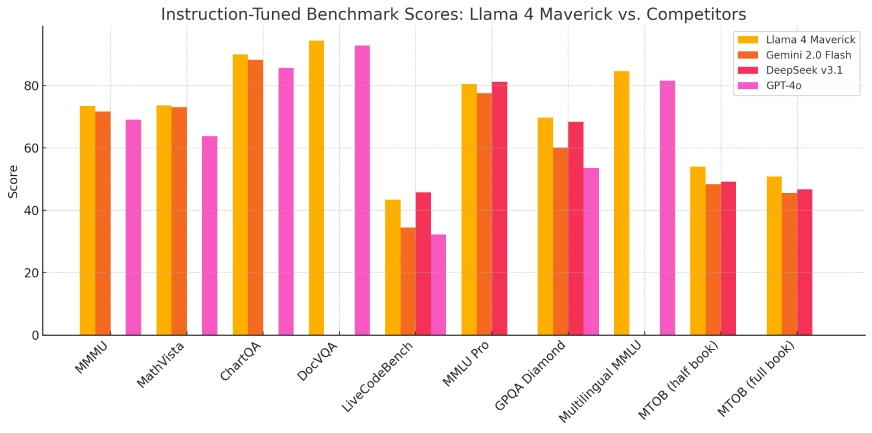

- Lama 4 Maverick:Większy model, którego wydajność w zakresie kodowania i wnioskowania jest porównywalna z wydajnością modeli OpenAI GPT-4o i DeepSeek-V3, przy jednoczesnym wykorzystaniu mniejszej liczby aktywnych parametrów.

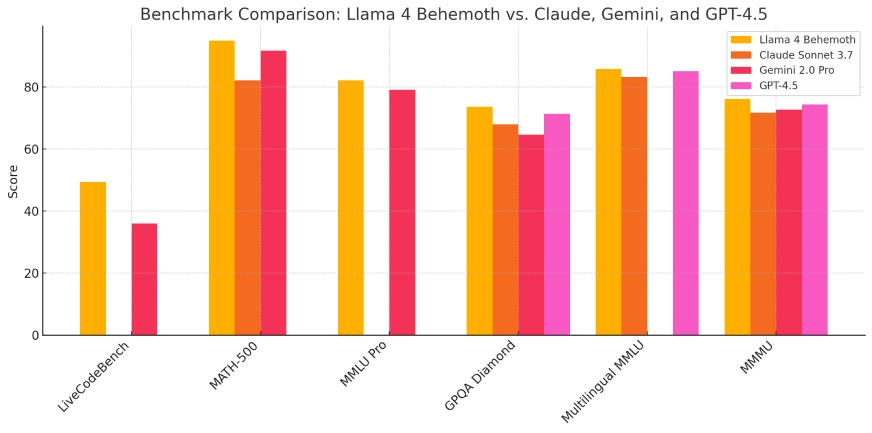

- Lama 4 Behemoth:Ten obecnie rozwijany model może pochwalić się 288 miliardami aktywnych parametrów i łączną liczbą 2 bilionów. Jego celem jest prześcignięcie modeli takich jak GPT-4.5 i Claude Sonnet 3.7 w testach porównawczych STEM.

Modele te są zintegrowane z asystentem AI firmy Meta na platformach takich jak WhatsApp, Messenger, Instagram i w Internecie, co pozwala na ulepszenie interakcji użytkowników dzięki zaawansowanym możliwościom sztucznej inteligencji.

| Model | Całkowite parametry | Aktywne parametry | . | Długość kontekstu | Działa dalej | Dostęp publiczny | Idealne dla |

|---|---|---|---|---|---|---|---|

| Zwiadowca | 109B | 17B | 16 | 10 mln tokenów | Pojedyncza karta Nvidia H100 | ✅ Tak | Lekkie zadania AI, aplikacje o długim kontekście |

| Maverick | 400B | 17B | 128 | Nieokreślony | Pojedynczy lub wielokrotny procesor graficzny | ✅ Tak | Badania, aplikacje korporacyjne, kodowanie |

| potwór | ~2T | 288B | 16 | Nieokreślony | Meta wewnętrzna infrastruktura | ❌ Nie | Wewnętrzne szkolenie modeli i testy porównawcze |

Architektura techniczna i innowacje

Seria Llama 4 wykorzystuje architekturę „mixture of experts” (MoE), innowacyjne podejście, które optymalizuje wykorzystanie zasobów poprzez aktywowanie tylko odpowiednich podzbiorów parametrów modelu podczas określonych zadań. Ta konstrukcja zwiększa wydajność obliczeniową i wydajność, umożliwiając modelom skuteczniejsze radzenie sobie ze złożonymi zadaniami.

Szkolenie tych modeli wymagało znacznych zasobów obliczeniowych. Meta wykorzystała klaster GPU składający się z ponad 100,000 100 chipów Nvidia HXNUMX, co stanowi jedną z największych dotychczas infrastruktur szkoleniowych AI. Ta rozległa moc obliczeniowa ułatwiła rozwój modeli o ulepszonych możliwościach i metrykach wydajności.

Ewolucja w stosunku do poprzednich modeli

Opierając się na fundamencie położonym przez wcześniejsze iteracje, seria Llama 4 stanowi znaczącą ewolucję w rozwoju modelu AI Meta. Integracja możliwości przetwarzania multimodalnego i przyjęcie architektury MoE rozwiązują ograniczenia zaobserwowane w poprzednich modelach, takie jak wyzwania w rozumowaniu i zadaniach matematycznych. Te postępy pozycjonują Llama 4 jako groźnego konkurenta w krajobrazie AI.

Wydajność benchmarku i wskaźniki techniczne

W ocenach porównawczych Llama 4 Scout wykazała lepszą wydajność niż modele takie jak Google Gemma 3 i Mistral 3.1, szczególnie w zadaniach wymagających rozległego przetwarzania kontekstu. Llama 4 Maverick wykazała możliwości porównywalne z wiodącymi modelami takimi jak OpenAI's GPT-4o, szczególnie w zadaniach kodowania i rozumowania, przy jednoczesnym utrzymaniu bardziej wydajnego wykorzystania parametrów. Wyniki te podkreślają skuteczność architektury MoE i rozległego zastosowanego programu szkoleniowego.

Lama 4 Scout

Lama 4 Maverick

Lama 4 Behemoth:

Scenariusze aplikacji

Wszechstronność serii Llama 4 pozwala na jej zastosowanie w różnych dziedzinach:

- Integracja z Mediami Społecznymi:Ulepszanie interakcji użytkowników na platformach takich jak WhatsApp, Messenger i Instagram dzięki zaawansowanym funkcjom opartym na sztucznej inteligencji, w tym ulepszonym rekomendacjom treści i agentom konwersacyjnym.

- Tworzenie treści:Pomaganie twórcom w tworzeniu wysokiej jakości treści multimodalnych poprzez przetwarzanie i syntezę tekstu, obrazów i filmów, a tym samym usprawnianie procesu twórczego.

- Narzędzia edukacyjne:Ułatwianie rozwoju inteligentnych systemów nauczania, które potrafią interpretować i reagować na różne formaty danych, zapewniając bardziej wciągające doświadczenie edukacyjne.

- Analiza firmy:Umożliwia przedsiębiorstwom analizowanie i interpretowanie złożonych zbiorów danych, obejmujących informacje tekstowe i wizualne, w celu uzyskania użytecznych informacji i wspierania procesów decyzyjnych.

Integracja modeli Llama 4 z platformami Meta pokazuje ich praktyczną użyteczność i potencjał w zakresie ulepszania doświadczeń użytkowników w różnych aplikacjach.

Rozważania etyczne i strategia Open Source

Podczas gdy Meta promuje serię Llama 4 jako open-source, warunki licencji obejmują ograniczenia dla podmiotów komercyjnych z ponad 700 milionami użytkowników. To podejście wywołało krytykę ze strony Open Source Initiative, podkreślając trwającą debatę dotyczącą równowagi między otwartym dostępem a interesami komercyjnymi w rozwoju AI.

Znaczna inwestycja Meta, sięgająca podobno 65 miliardów dolarów w infrastrukturę AI, podkreśla zaangażowanie firmy w rozwijanie możliwości AI i utrzymanie przewagi konkurencyjnej w szybko zmieniającym się środowisku AI.

Podsumowanie

Wprowadzenie serii Llama 4 firmy Meta oznacza kluczowy postęp w dziedzinie sztucznej inteligencji, pokazując znaczące ulepszenia w zakresie przetwarzania multimodalnego, wydajności i wydajności. Dzięki innowacyjnym projektom architektonicznym i znacznym inwestycjom obliczeniowym modele te wyznaczają nowe standardy w zakresie możliwości AI. W miarę jak Meta kontynuuje integrowanie tych modeli na swoich platformach i eksploruje dalsze rozwiązania, seria Llama 4 jest gotowa odegrać kluczową rolę w kształtowaniu przyszłej trajektorii aplikacji i usług AI.

Jak wywołać API Llama 4 z CometAPI

1.Zaloguj Się do pl.com. Jeśli jeszcze nie jesteś naszym użytkownikiem, zarejestruj się najpierw

2.Uzyskaj klucz API danych uwierzytelniających dostęp interfejsu. Kliknij „Dodaj token” przy tokenie API w centrum osobistym, pobierz klucz tokena: sk-xxxxx i prześlij.

-

Uzyskaj adres URL tej witryny: https://api.cometapi.com/

-

Wybierz Lamę 4 (nazwa modelu: lama-4-maverick; lama-4-zwiadowca) punkt końcowy do wysłania żądania API i ustawienia treści żądania. Metoda żądania i treść żądania są uzyskiwane z dokumentacja API naszej witryny internetowej. Nasza strona internetowa udostępnia również test Apifox dla Twojej wygody.

- Aby uzyskać informacje o modelu uruchomionym w interfejsie API Comet, zobacz https://api.cometapi.com/new-model.

- Informacje o cenie modelu w interfejsie API Comet można znaleźć tutaj https://api.cometapi.com/pricing

| Kategoria | lama-4-maverick | lama-4-zwiadowca |

| Ceny API | Żetony wejściowe: 0.48 USD / mln żetonów | Tokeny wejściowe: 0.216 USD / mln tokenów |

| Żetony wyjściowe: 1.44 USD/M żetonów | Żetony wyjściowe: 1.152 USD/M żetonów |

- Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź. Po wysłaniu żądania API otrzymasz obiekt JSON zawierający wygenerowane uzupełnienie.