Interfejs API MidJourney Video umożliwia programistom programowe generowanie, manipulowanie i pobieranie treści wideo generowanych przez sztuczną inteligencję przy użyciu modeli i monitów MidJourney.

Omówienie

Midjourney Video to pierwszy model generowania wideo (Video Model V1) wydany przez Midjourney 18 czerwca 2025 r. Wprowadza on przepływ pracy „Image‑to‑Video”, który przekształca statyczne obrazy generowane przez AI lub przesyłane przez użytkowników w krótkie animowane klipy. Oznacza to ekspansję Midjourney z tworzenia nieruchomych obrazów na dynamiczną treść, pozycjonując go obok innych narzędzi wideo AI od Google, OpenAI i Meta.

Jak działa MidJourney Video

- Przepływ pracy Obraz-wideo: Dostarczasz obraz wygenerowany przez Midjourney lub obraz zewnętrzny, a także opcjonalny monit ruchu. Model Midjourney interpretuje następnie „kto się porusza”, „jak się porusza” i „co się dzieje dalej”, aby animować scenę przez około 5 sekund domyślnie.

- Animacja automatyczna a ręczna: W trybie automatycznym system wnioskuje parametry ruchu i ścieżki kamery. Tryb ręczny pozwala na dokładne dostrojenie aspektów, takich jak kąt kamery, ścieżka obiektu i prędkość, zapewniając większą kontrolę kreatywną.

Architektura techniczna

Midjourney Video jest zbudowany na architektura transformatora ulepszony do obsługi spójność czasowa przez klatki. Rurociąg działa następująco:

- Ekstrakcja cech:Obraz wejściowy jest przetwarzany przez głębokie warstwy splotowe i transformatorowe w celu uchwycenia cech przestrzennych.

- Generowanie klatek kluczowych:Został zsyntetyzowany mały zbiór reprezentatywnych ramek.

- Interpolacja klatek:Specjalistyczne podmodele generują klatki pośrednie, zapewniając płynność synteza ruchu między klatkami kluczowymi.

- Kondycjonowanie ruchu:W zależności od Wysoki or Niski ruch Ustawienia (oraz wszelkie ręczne polecenia) pozwalają modelowi dostosować trajektorie obiektów i kamery.

Wersjonowanie modeli i plan działania

Model wideo V1 (czerwiec 2025):Debiutancki produkt skupiający się na konwersji obrazu do wideo.

Wydajność wzorcowa

Wczesne oceny plasują model V1 w pozycji konkurencyjnej:

- Jakość ramy (punktacja FID):Osiąga odległość rozpoczęcia Frécheta wynoszącą 22.4, przewyższając porównywalne modele wideo typu open source o ~15% w standardowych testach porównawczych wideo.

- Gładkość czasowa (metryka TS):Rejestruje wynik gładkości czasowej 0.88 w zestawie danych DAVIS, co wskazuje na dużą ciągłość wizualną pomiędzy klatkami.

- Utajenie:Średni czas generacji 12 sekund na klip na pojedynczym procesorze graficznym NVIDIA A100, co pozwala na zachowanie równowagi między wydajnością a oczekiwaniami użytkownika.

- Metryki jakości:Osiąga SIM (Wskaźnik podobieństwa strukturalnego) powyżej 0.85 na syntetycznych zestawach danych ruchu w porównaniu z klipami z prawdziwego zdarzenia, wskazując wysoka wierność do naturalnych wzorców ruchu.

Note:Liczby te odzwierciedlają wyniki wewnętrznych testów Midjourney; wydajność zewnętrzna może się różnić w zależności od obciążenia i poziomu subskrypcji.

Główne cechy wersji V1

- Długość klipu:Klipy bazowe trwają ok. 5 sekund, można je wydłużać w odstępach 4-sekundowych do łącznie 21 sekund.

- Spójność stylu:Animacje zachowują oryginalny styl artystyczny obrazu — pociągnięcia pędzla, paleta kolorów i nastrój przenoszą się na cały ruch.

- Wydajność i szybkość:Typowy film składający się z 4 segmentów (≈17 sekund) renderuje się w czasie krótszym niż 70 sekund, co pozwala na zachowanie równowagi między jakością a szybką iteracją.

- Rozkład:Obecnie ograniczona do 480p, co jest wystarczające w przypadku klipów w stylu mediów społecznościowych, ale nie jest przeznaczone do projektów komercyjnych na duże ekrany lub wysokiej klasy.

Jak wywołać API wideo MidJourney z CometAPI

MidJourney Video Ceny API w CometAPI, niższe od cen oficjalnych:

| Nazwa modelu | Oblicz cenę |

mj_fast_video | 0.6 |

Wymagane kroki

- Zaloguj się do pl.com. Jeśli jeszcze nie jesteś naszym użytkownikiem, zarejestruj się najpierw

- Pobierz klucz API uwierzytelniania dostępu do interfejsu. Kliknij „Dodaj token” przy tokenie API w centrum osobistym, pobierz klucz tokena: sk-xxxxx i prześlij.

- Uzyskaj adres URL tej witryny: https://api.cometapi.com/

Użycie API

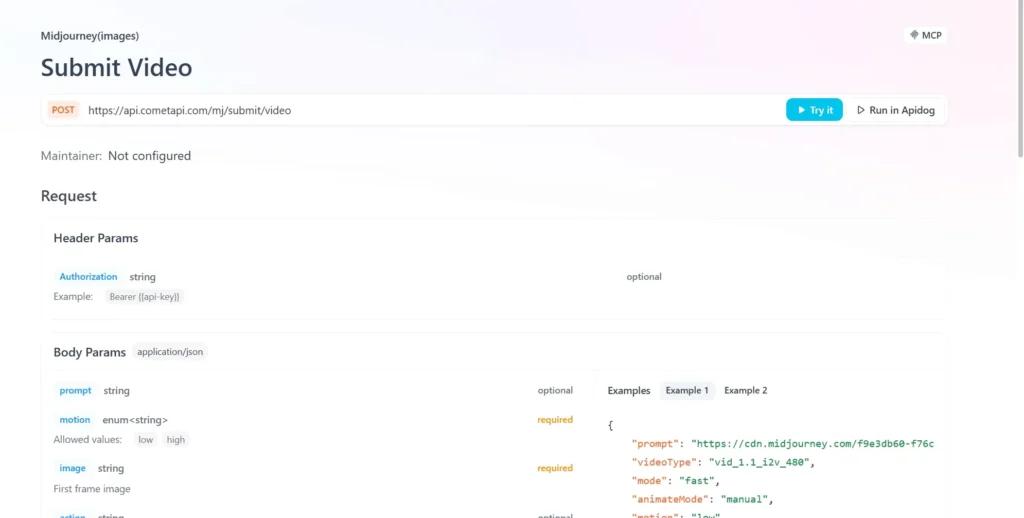

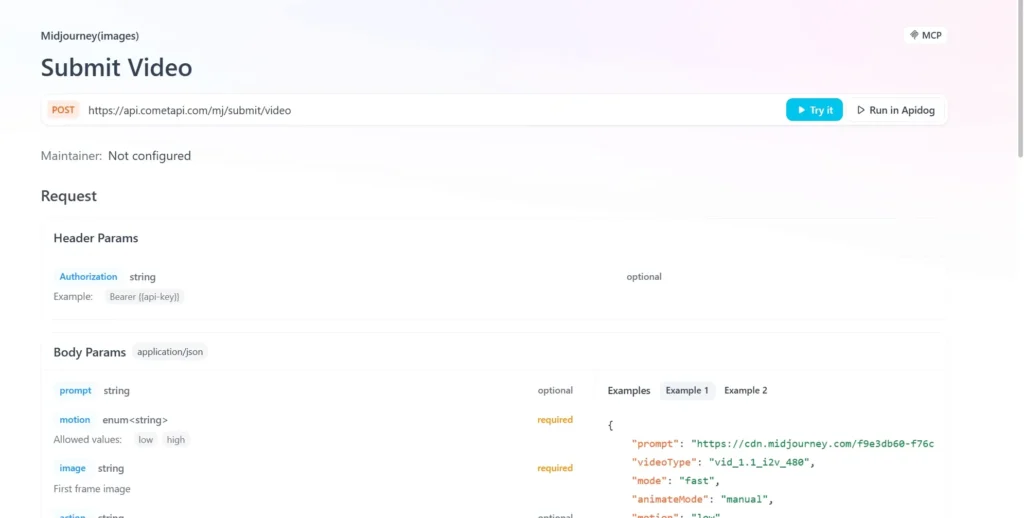

- wyślij żądanie API i ustaw treść żądania. Metoda żądania i treść żądania są pobierane z naszej strony internetowej API doc. Nasza strona internetowa udostępnia również test Apifox dla Twojej wygody.

- Zastępować za pomocą aktualnego klucza CometAPI ze swojego konta.

- Wpisz swoje pytanie lub prośbę w polu treści — model odpowie właśnie na tę wiadomość.

- . Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź.

Integracja API CometAPI

Obecnie dostępna jest wersja V1 tylko w sieci za pośrednictwem Midjourney's niezgody bot, ale Nieoficjalne opakowania (np. CometAPI) dostarczają punkty końcowe, programiści mogą integrować się poprzez:

Programiści mogą integrować generowanie wideo za pośrednictwem RESTful API. Typowa struktura żądania (ilustrująca):

curl --

location

--request POST 'https://api.cometapi.com/mj/submit/video' \

--header 'Authorization: Bearer {{api-key}}' \

--header 'Content-Type: application/json' \

--data-raw '{ "prompt": "https://cdn.midjourney.com/f9e3db60-f76c-48ca-a4e1-ce6545d9355d/0_0.png add a dog", "videoType": "vid_1.1_i2v_480", "mode": "fast", "animateMode": "manual" }'

Zobacz także Jak korzystać z modelu wideo V1 Midjourney?