Czym jest API GPT-5.2

API GPT-5.2 jest tym samym co GPT-5.2 Thinking w ChatGPT. GPT-5.2 Thinking to wariant ze środkowej półki w rodzinie OpenAI GPT-5.2 zaprojektowany do głębszej pracy: wielostopniowego rozumowania, streszczania długich dokumentów, wysokiej jakości generowania kodu oraz profesjonalnej pracy opartej na wiedzy, gdzie dokładność i użyteczna struktura są ważniejsze niż czysta przepustowość. W API jest udostępniany jako model gpt-5.2 (Responses API / Chat Completions) i plasuje się między niskolatencyjnym wariantem Instant a bardziej jakościowym, lecz droższym wariantem Pro.

Główne funkcje

- Bardzo długi kontekst i kompresja: efektywne okno 400K oraz narzędzia kompresji do zarządzania relewantnością w długich rozmowach i dokumentach.

- Konfigurowalny nakład rozumowania:

none | medium | high | xhigh(xhigh umożliwia maksymalne obliczenia wewnętrzne dla trudnego rozumowania).xhighjest dostępne w wariantach Thinking/Pro. - Silniejsze wsparcie dla narzędzi i funkcji: pierwszorzędne wywoływanie narzędzi, gramatyki (CFG/Lark) do ograniczania wyjść do zdefiniowanej struktury oraz ulepszone zachowania agentowe upraszczające złożoną, wieloetapową automatyzację.

- Wielomodalne rozumienie: bogatsze rozumienie obrazu + tekstu oraz integracja w wieloetapowych zadaniach.

- Ulepszone bezpieczeństwo / obsługa treści wrażliwych: ukierunkowane interwencje ograniczające niepożądane odpowiedzi w obszarach takich jak samookaleczenie i inne wrażliwe konteksty.

Możliwości techniczne i specyfikacje (perspektywa dewelopera)

- Punkty końcowe API i identyfikatory modeli:

gpt-5.2dla Thinking (Responses API),gpt-5.2-chat-latestdla przepływów chat/instant orazgpt-5.2-prodla poziomu Pro; dostępne przez Responses API i Chat Completions tam, gdzie wskazano. - Tokeny rozumowania i zarządzanie nakładem: API obsługuje jawne parametry przydzielania mocy obliczeniowej (nakładu rozumowania) na żądanie; większy nakład zwiększa opóźnienie i koszt, ale poprawia jakość wyjścia w złożonych zadaniach.

- Narzędzia strukturyzowanych wyjść: obsługa gramatyk (Lark / CFG) do ograniczania wyjścia modelu do DSL lub dokładnej składni (przydatne dla SQL, JSON, generowania DSL).

- Równoległe wywoływanie narzędzi i koordynacja agentowa: ulepszona równoległość i czystsza orkiestracja narzędzi zmniejszają potrzebę rozbudowanych promptów systemowych oraz wieloagentowego szkieletu.

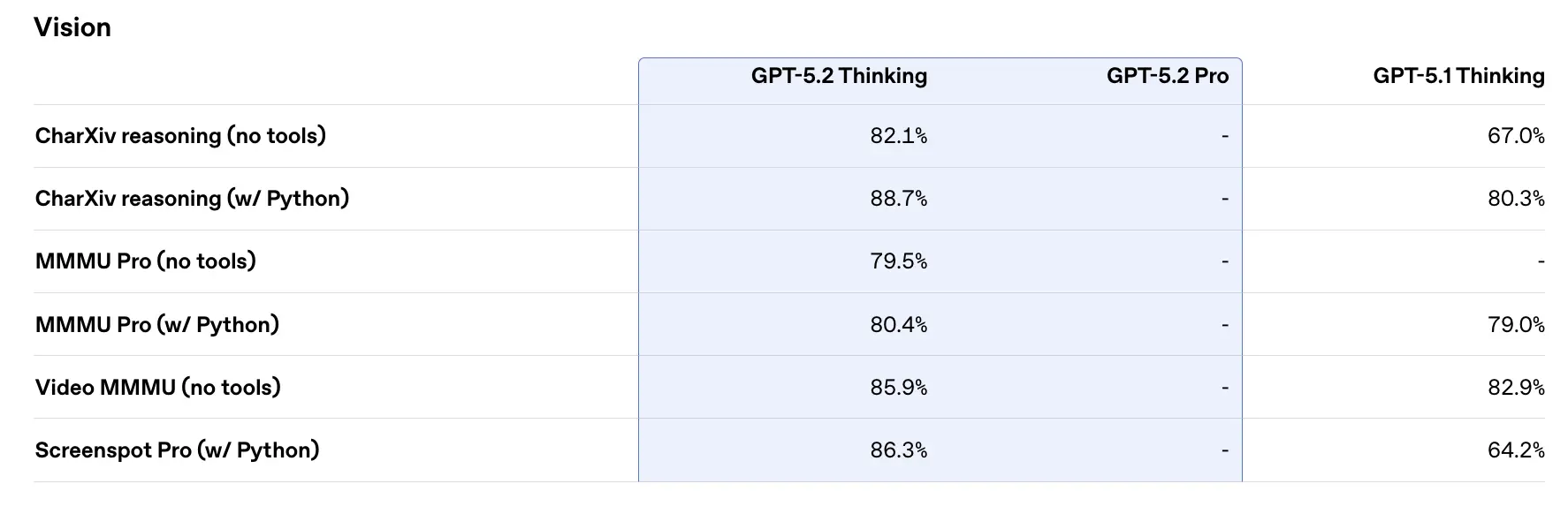

Wydajność w benchmarkach i dane wspierające

OpenAI opublikowało szereg wewnętrznych i zewnętrznych wyników benchmarków dla GPT-5.2. Wybrane najważniejsze (liczby raportowane przez OpenAI):

- GDPval (44 zawodów, praca wiedzo-centryczna) — GPT-5.2 Thinking „pokonuje lub dorównuje czołowym profesjonalistom branżowym w 70.9% porównań”; OpenAI podaje, że wyniki zostały uzyskane z >11× szybkością i <1% kosztem względem ekspertów na zadaniach GDPval (szacunki szybkości i kosztów są oparte historycznie). Zadania obejmują modele arkuszy kalkulacyjnych, prezentacje i krótkie filmy.

- SWE-Bench Pro (kodowanie) — GPT-5.2 Thinking osiąga ≈55.6% na SWE-Bench Pro oraz ~80% na SWE-Bench Verified (tylko Python) według OpenAI, ustanawiając nowy stan sztuki dla oceny generowania kodu/inżynierii w ich testach. Przekłada się to na bardziej niezawodne debugowanie i poprawki end-to-end w praktyce, zgodnie z przykładami OpenAI.

- GPQA Diamond (graduate-level science Q&A) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% na GPQA Diamond (bez narzędzi, maksymalne rozumowanie).

- Seria ARC-AGI — Na ARC-AGI-2 (bardziej wymagający benchmark płynnego rozumowania) GPT-5.2 Thinking uzyskał 52.9%, a GPT-5.2 Pro 54.2% (OpenAI mówi, że to nowe wyniki SOTA dla modeli w stylu chain-of-thought).

- Długi kontekst (OpenAI MRCRv2) — GPT-5.2 Thinking wykazuje niemal 100% dokładności w wariancie 4-needle MRCR do 256k tokenów oraz znacząco lepsze wyniki względem GPT-5.1 w ustawieniach długiego kontekstu. (OpenAI opublikowało wykresy i tabele MRCRv2.)

Porównanie z konkurentami

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro zostało upublicznione z ~1,048,576 (≈1M) token oknem kontekstu oraz szerokimi multimodalnymi wejściami (tekst, obraz, audio, wideo, PDF-y) i silnymi integracjami agentowymi przez Vertex AI / AI Studio. Na papierze większe okno kontekstu Gemini 3 wyróżnia się dla ekstremalnie dużych obciążeń w pojedynczej sesji; kompromisy obejmują zakres narzędzi i dopasowanie do ekosystemu.

- vs Anthropic Claude Opus 4.5: Opus 4.5 akcentuje korporacyjne przepływy pracy związane z kodowaniem/agentami i raportuje silne wyniki SWE-bench oraz odporność w długich sesjach agentowych; Anthropic pozycjonuje Opus pod automatyzację i generowanie kodu z oknem kontekstu 200k oraz wyspecjalizowane integracje agent/Excel. Opus 4.5 to silny konkurent w automatyzacji i zadaniach kodowych w środowisku korporacyjnym.

Wniosek praktyczny: GPT-5.2 celuje w zrównoważony zestaw ulepszeń (kontekst 400k, wysokie wyjścia tokenów, ulepszone rozumowanie/kodowanie). Gemini 3 celuje w absolutnie największe konteksty pojedynczej sesji (≈1M), a Claude Opus skupia się na korporacyjnym inżynierstwie i odporności agentów. Wybieraj, dopasowując rozmiar kontekstu, potrzeby modalności, dopasowanie funkcji/narzędzi oraz kompromisy koszt/opóźnienie.

Jak uzyskać dostęp i korzystać z API GPT-5.2

Krok 1: Zarejestruj się po klucz API

Zaloguj się do cometapi.com. Jeśli nie jesteś jeszcze naszym użytkownikiem, zarejestruj się najpierw. Zaloguj się do swojej Konsola CometAPI. Uzyskaj klucz API (poświadczenie dostępu) do interfejsu. Kliknij „Add Token” przy tokenie API w centrum osobistym, pobierz klucz tokena: sk-xxxxx i zatwierdź.

Krok 2: Wyślij żądania do API GPT-5.2

Wybierz endpoint „gpt-5.2”, aby wysłać żądanie API i ustaw treść żądania. Metodę żądania i treść żądania znajdziesz w dokumentacji API na naszej stronie. Nasza strona udostępnia także test w Apifox dla Twojej wygody. Zastąp <YOUR_API_KEY> swoim rzeczywistym kluczem CometAPI z konta. Deweloperzy wywołują je przez Responses API / Chat endpoints.

Wstaw swoje pytanie lub prośbę do pola content — na to odpowie model. Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź.

Krok 3: Pobierz i zweryfikuj wyniki

Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź. Po przetworzeniu interfejs API odpowiada statusem zadania i danymi wyjściowymi.

Zobacz też Gemini 3 Pro Preview API