Kluczowe funkcje

- Dwie wersje:

grok-4-1-fast-reasoning(myślenie / tryb agentowy) igrok-4-1-fast-non-reasoning(natychmiastowe odpowiedzi „Fast”). - Ogromne okno kontekstu: 2,000,000 tokenów — zaprojektowane dla wielogodzinnych transkrypcji, dużych zbiorów dokumentów i długiego planowania wieloturowego.

- First-party Agent Tools API: wbudowane przeglądanie sieci/X, wykonywanie kodu po stronie serwera, wyszukiwanie plików oraz konektory „MCP”, dzięki czemu model może działać jako autonomiczny agent bez dodatkowego klejenia.

- Modalności: Multimodalny (tekst + obrazy oraz ulepszone możliwości wizualne, w tym analiza wykresów i ekstrakcja na poziomie OCR).

Jak działa Grok 4.1 Fast?

- Architektura i tryby: Grok 4.1 Fast jest przedstawiany jako jedna rodzina modeli, którą można skonfigurować do trybu „reasoning” (wewnętrzne łańcuchy rozumowania i większa deliberacja) lub trybu „fast” bez rozumowania dla niższych opóźnień. Tryb reasoning można włączać/wyłączać parametrami API (np.

reasoning.enabled) na warstwach dostawcy takich jak CometAPI. - Sygnał treningowy: xAI raportuje uczenie ze wzmocnieniem w symulowanych środowiskach agentowych (szkolenie silnie narzędziowe) w celu poprawy wydajności w zadaniach wywoływania narzędzi o długim horyzoncie i wieloturowym przebiegu (odnoszą się do treningu na τ²-bench Telecom oraz long-context RL).

- Orkiestracja narzędzi: Narzędzia działają na infrastrukturze xAI; Grok może wywoływać wiele narzędzi równolegle i podejmować agentowe plany w kolejnych turach (wyszukiwanie w sieci, wyszukiwanie w X, wykonywanie kodu, pobieranie plików, serwery MCP).

- Przepustowość i limity: przykładowo opublikowane limity obejmują 480 żądań/minutę oraz 4,000,000 tokenów/minutę dla klastra

grok-4-1-fast-reasoning.

Wersje modelu Grok 4.1 fast i nazewnictwo

grok-4-1-fast-reasoning— tryb agentowy „thinking”: wewnętrzne tokeny rozumowania, orkiestracja narzędzi, najlepszy do złożonych, wieloetapowych przepływów pracy.grok-4-1-fast-non-reasoning— natychmiastowy tryb „Fast”: minimalna liczba wewnętrznych tokenów myślenia, niższe opóźnienia dla czatu, burzy mózgów i krótkich form pisemnych.

Wyniki benchmarków Grok 4.1 fast

xAI podkreśla kilka zwycięstw w benchmarkach i zmierzone ulepszenia względem wcześniejszych wydań Grok oraz niektórych konkurencyjnych modeli. Kluczowe opublikowane liczby:

- τ²-bench (benchmark narzędzi agentowych w telekomunikacji): zgłoszony 100% wynik przy całkowitym koszcie $105.

- Berkeley Function Calling v4: zgłoszona 72% łączna dokładność (wartość opublikowana przez xAI) przy całkowitym zgłoszonym koszcie ~$400 w kontekście tego benchmarku.

- Badania i wyszukiwanie agentowe (Research-Eval / Reka / X Browse): xAI raportuje lepsze wyniki i niższe koszty niż u kilku konkurentów na wewnętrznych/przemysłowych benchmarkach wyszukiwania agentowego (przykłady: Grok 4.1 Fast — wyniki Research-Eval i X Browse znacznie wyższe niż GPT-5 i Claude Sonnet 4.5 w tabelach opublikowanych przez xAI).

- Faktyczność / halucynacje: Grok 4.1 Fast zmniejsza o połowę wskaźnik halucynacji w porównaniu z Grok 4 Fast na FActScore i powiązanych wewnętrznych metrykach.

Ograniczenia i ryzyka Grok 4.1 fast

- Halucynacje są ograniczone, nie wyeliminowane. Opublikowane redukcje są istotne (xAI podaje znaczące obniżenie współczynników halucynacji względem poprzedniego Grok 4 Fast), jednak błędy faktograficzne nadal występują w przypadkach brzegowych i szybkich przepływach pracy — weryfikuj krytyczne wyniki niezależnie.

- Powierzchnia zaufania do narzędzi: narzędzia po stronie serwera zwiększają wygodę, ale także rozszerzają powierzchnię ataku (nadużycie narzędzi, błędne wyniki zewnętrzne lub nieaktualne źródła). Stosuj weryfikację pochodzenia i zabezpieczenia; traktuj zautomatyzowane wyniki narzędzi jako materiał dowodowy wymagający weryfikacji.

- Nie „SOTA” do wszystkiego: recenzje wskazują, że seria Grok wyróżnia się w STEM, rozumowaniu i zadaniach agentowych z długim kontekstem, ale może ustępować najnowszym ofertom multimodalnym innych dostawców w niektórych zadaniach związanych z rozumieniem wizualnym i twórczym generowaniem.

Jak Grok 4.1 fast wypada na tle innych wiodących modeli

- W porównaniu z Grok 4 / Grok 4.1 (non-Fast): Fast wymienia część wewnętrznej pracy/„myślenia” na niższe opóźnienia i oszczędność tokenów, dążąc do utrzymania jakości rozumowania blisko poziomu Grok 4; jest zoptymalizowany pod produkcyjne użycie agentowe, a nie pod maksymalną jakość rozumowania na ciężkich offline’owych benchmarkach. ([xAI][5])

- W porównaniu z rodziną Google Gemini / rodziną OpenAI GPT / Anthropic Claude: niezależne recenzje i media technologiczne wskazują na mocne strony Groka w logicznym rozumowaniu, wywoływaniu narzędzi i obsłudze długiego kontekstu, podczas gdy inni dostawcy czasem prowadzą w multimodalnej wizji, twórczym generowaniu lub różnych kompromisach cena/wydajność.

- Jak uzyskać dostęp do API Grok 4.1 fast

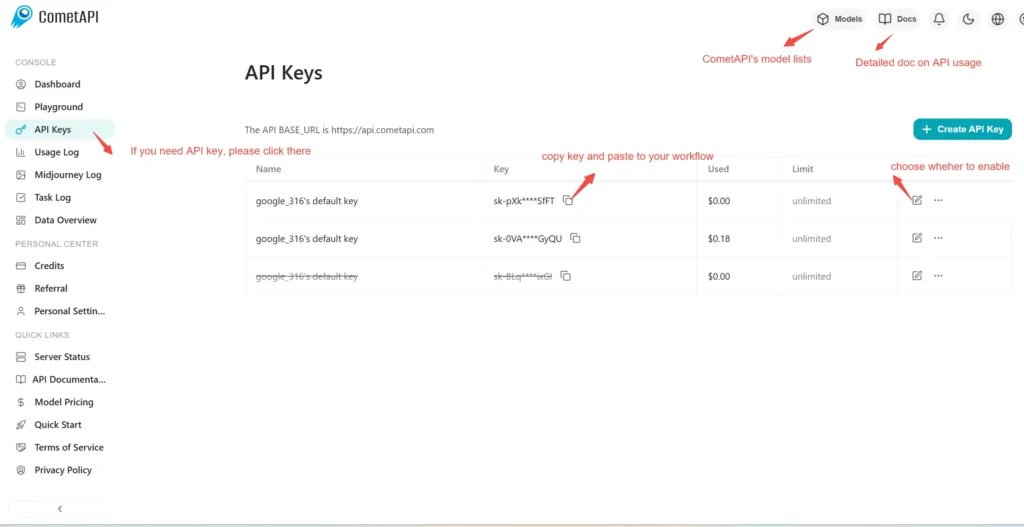

Krok 1: Zarejestruj się po klucz API

Zaloguj się na cometapi.com. Jeśli nie jesteś jeszcze naszym użytkownikiem, zarejestruj się najpierw. Zaloguj się do swojej konsoli CometAPI. Uzyskaj klucz API poświadczeń dostępu do interfejsu. Kliknij „Add Token” przy tokenie API w centrum osobistym, pobierz klucz tokena: sk-xxxxx i zatwierdź.

Krok 2: Wyślij żądania do API Grok 4.1 fast

Wybierz endpoint „\grok-4-1-fast-reasoning/ grok-4-1-fast-non-reasoning\”, aby wysłać żądanie API i ustawić treść żądania. Metoda żądania i treść żądania są dostępne w dokumentacji API na naszej stronie. Nasza strona oferuje też test w Apifox dla Twojej wygody. Zastąp <YOUR_API_KEY> swoim rzeczywistym kluczem CometAPI z konta. Bazowy URL to [Chat] format([https://api.cometapi.com/v1/chat/completions]).

Wstaw swoje pytanie lub prośbę do pola content — na to odpowie model. Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź.

Krok 3: Pobierz i zweryfikuj wyniki

Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź. Po przetworzeniu API zwraca status zadania i dane wyjściowe.