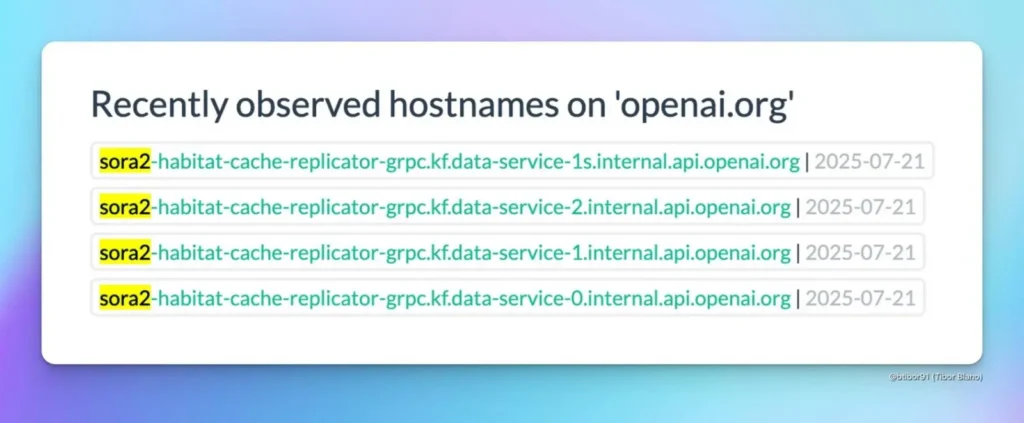

SAN FRANCISCO, 25 lipca 2025 r. — Według doniesień OpenAI przygotowuje się do uruchomienia Sora 2, kolejna generacja modelu zamiany tekstu na wideo, mająca na celu wyprzedzenie konkurencji, takiej jak Google Veo 3. Plotki o aktualizacji pojawiły się po analizie publicznych plików OpenAI i odniesień do serwerów „Sora 2”, choć firma nie wydała jeszcze oficjalnego komunikatu.

Oczekiwane ulepszenia Sora 2

Zintegrowany dźwięk i mowa

Kluczową funkcją, której można się spodziewać w Sora 2, jest dźwięk generowany przez sztuczną inteligencję – narracja, odgłosy otoczenia i efekty dźwiękowe – które idealnie współgrają z akcją na ekranie. Wczesne przecieki sugerują, że OpenAI ma na celu nauczenie Sora 2 „mówienia” w filmach, zapewniając realistyczną intonację, atmosferę otoczenia i precyzyjną synchronizację ruchu warg, aby uniknąć ograniczeń „filmu niemego” swojego poprzednika.

Ulepszony ruch człowieka

Obecne modele Sora czasami prezentują zdeformowane lub „rozpływające się” postacie ludzkie ze względu na ograniczenia w modelowaniu fizyki i ruchu. Oczekuje się, że Sora 2 wykorzysta zaawansowane techniki treningowe, aby lepiej symulować realistyczny ruch człowieka – redukując zniekształcenia kończyn i ułożenia ciała oraz zapewniając bardziej naturalne, płynne ruchy.

Dłuższe i lepszej jakości klipy

Podczas gdy konkurenci zazwyczaj ograniczają długość filmów do mniej niż dziesięciu sekund, OpenAI zademonstrowało możliwości Sora w zakresie klipów trwających 20 sekund lub więcej. Sora 2 może wydłużyć te limity, potencjalnie sięgając 30 sekund lub więcej, dzięki stopniowym poprawom rozdzielczości i wierności obrazu. Funkcje te prawdopodobnie będą dostępne w ramach wyższych planów abonamentowych ze względu na ich wysokie wymagania obliczeniowe.

Strategia integracji i ustalania cen

OpenAI może zaplanować premierę Sora 2 w czasie z nadchodzącym wdrożeniem GPT‑5, wykorzystując synergię między zaawansowanymi modelami wideo i języka. Obserwatorzy branży zauważają, że dołączenie Sora 2 do ekosystemu ChatGPT mogłoby zapewnić konkurencyjne ceny w porównaniu z subskrypcyjnym dostępem Google do Veo 3, co byłoby atrakcyjne zarówno dla twórców, jak i użytkowników korporacyjnych. Strategia cenowa pozostaje jednak niepewna, a OpenAI rozważa szersze limity użytkowania w kontekście kosztów infrastruktury.

Środowisko konkurencyjne

OpenAI stoi w obliczu silnej konkurencji ze strony Google Wideo 3, który już może pochwalić się zintegrowanym dźwiękiem i dopracowaną synchronizacją ruchu warg, a także z wyspecjalizowanych platform, takich jak Kling, Pas startowy, Księżycowa Dolina, z których każda dokonuje szybkich postępów w zakresie realizmu wideo i zestawu funkcji. Dlatego Sora 2 będzie musiała wyróżniać się nie tylko jakością i funkcjami, ale także dostępnością – potencjalnie poprzez korzystne ceny i integrację z szerszym ekosystemem ChatGPT.

Patrząc w przyszłość, sukces Sora 2 będzie zależał od jej zdolności do płynnego, etycznego i ekonomicznego generowania wideo. W obliczu krytyki technologii generatywnego wideo pod kątem potencjalnych nadużyć, oczekuje się, że OpenAI wdroży zabezpieczenia podobne do tych zastosowanych podczas pierwszej premiery Sora, w tym filtry treści i zasady użytkowania, mające na celu zapobieganie szkodliwym lub wprowadzającym w błąd treściom. W obliczu zaostrzającej się konkurencji, Sora 2 stanowi kluczowy test wiodącej pozycji OpenAI w przestrzeni mediów opartych na sztucznej inteligencji.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Deweloperzy mogą uzyskać dostęp poprzez Interfejs API CometNajnowsze wersje modeli podane są na dzień publikacji artykułu. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.