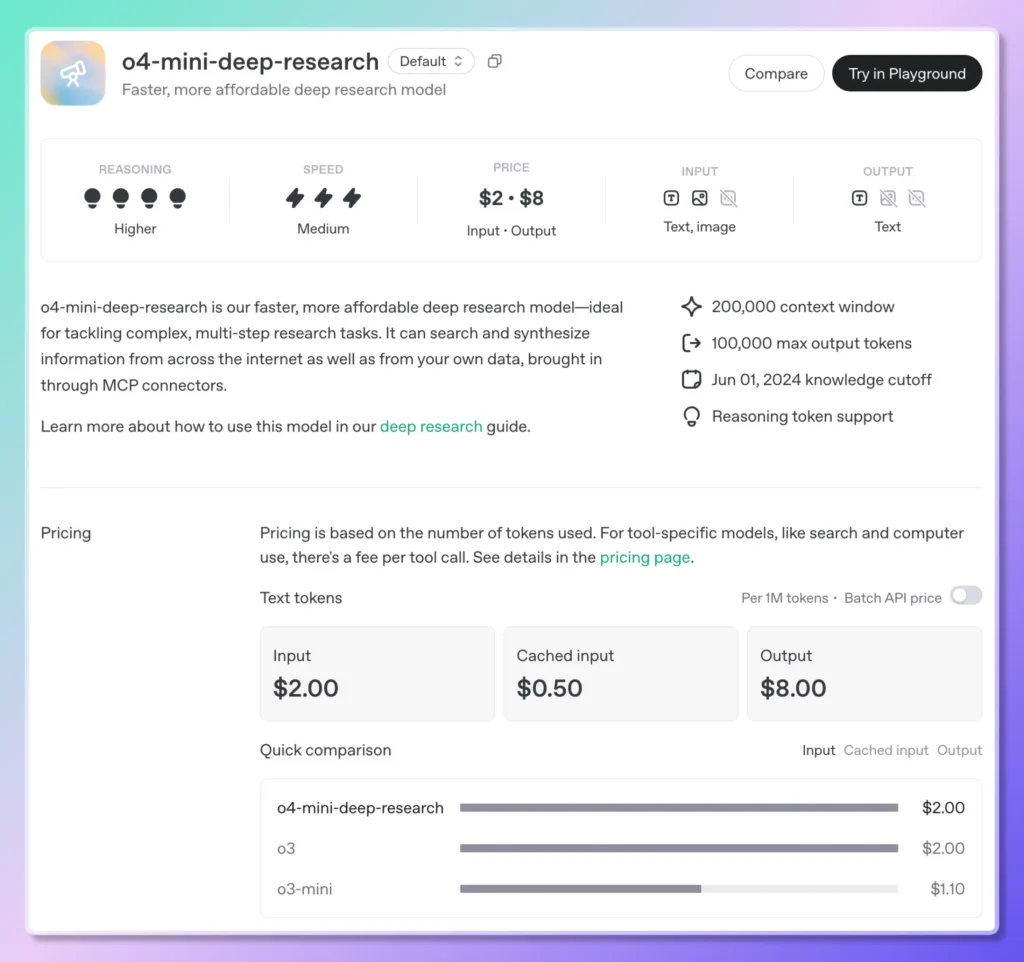

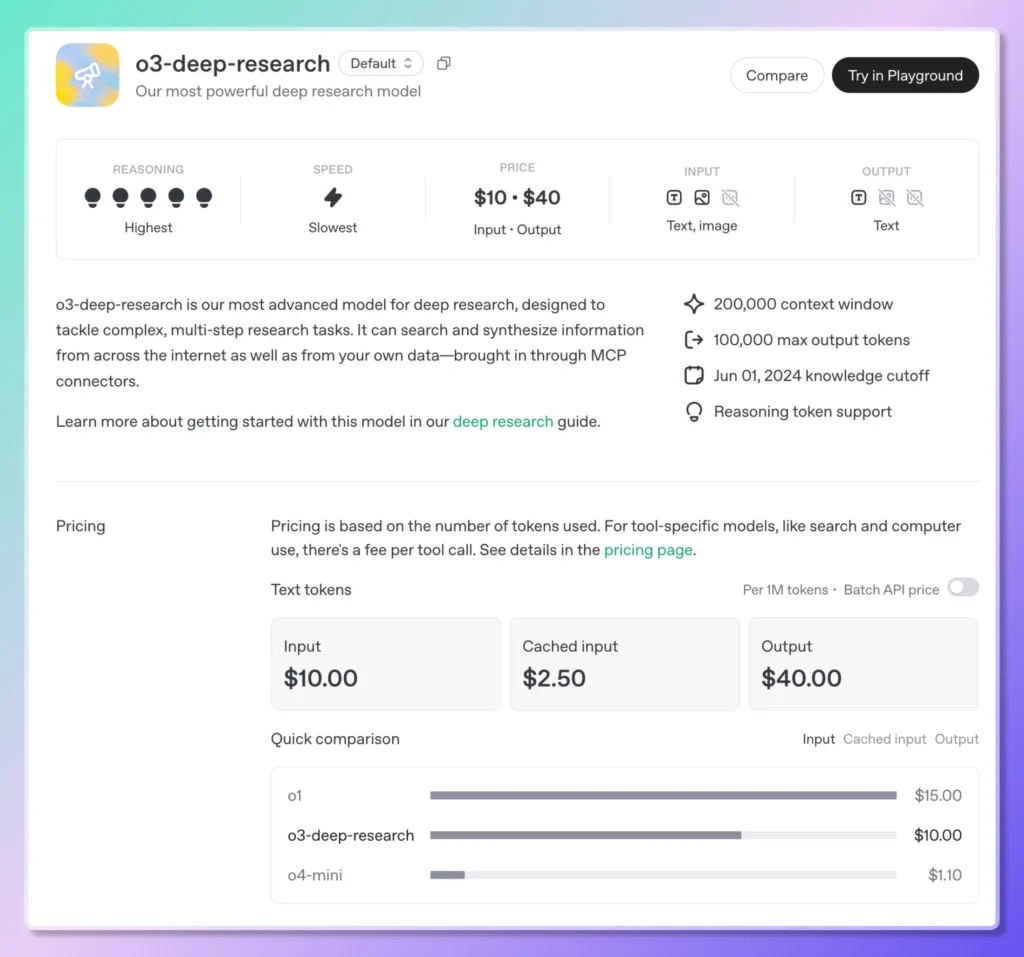

27 czerwca 2025 r. OpenAI oficjalnie otworzyło dostęp API do swoich możliwości Deep Research, umożliwiając programistom automatyzację złożonych, wieloetapowych przepływów pracy badawczej w sposób programowy. Nazwano je Głębokie API badawcze, ta nowa usługa udostępnia dwa specjalnie zaprojektowane modele:o3-deep-research-2025-06-26 do dogłębnej syntezy i „wyższej jakości” wyjścia, a także lżejszego, o niższym opóźnieniu o4-mini-deep-research-2025-06-26—za pośrednictwem standardowego punktu końcowego Chat Completions. Modele te bazują na silnikach wnioskowania wprowadzonych po raz pierwszy w agencie Deep Research ChatGPT na początku tego roku, ale teraz przyznają programistom pełną kontrolę nad projektowaniem komunikatów, konfiguracją narzędzi i asynchronicznym wykonywaniem za pośrednictwem trybu tła.

Oprócz udostępnienia specjalistycznych wersji Deep Research o3 i o4-mini, OpenAI udoskonaliło również swoje główne modele wnioskowania —o3, o3-pro, o4-mini—z wbudowanymi możliwościami wyszukiwania w sieci. Ta integracja umożliwia modelom przeprowadzanie wyszukiwań na żywo, pobieranie aktualnych informacji i syntezę wyników bezpośrednio w jednym połączeniu. Ceny nowej usługi „rozumowania wyszukiwania w sieci” zaczynają się od 10$ za 1,000 połączeń, co odzwierciedlało wymaganą najwyższą wydajność obliczeniową i koordynację interfejsu API; jednocześnie OpenAI obniżyło koszt wyszukiwania w sieci w swoich flagowych modelach multimodalnych (GPT-4o i GPT-4.1) 25$ za 1,000 połączeń .

Aby usprawnić długotrwałe zadania badawcze, interfejs API obsługuje teraz haki internetowe: programiści mogą rejestrować punkty końcowe wywołania zwrotnego, aby otrzymywać automatyczne powiadomienia po zakończeniu zadania Deep Research, eliminując potrzebę sondowania lub ręcznego sprawdzania statusu. Ten mechanizm webhook jest szczególnie zalecany w przypadku przepływów pracy, które działają asynchronicznie — takich jak wielogodzinne analizy rynku lub przeglądy zasad — zapewniając niezawodność i efektywne wykorzystanie zasobów w systemach produkcyjnych.

Dostęp do Deep Research API jest prosty. Po zainstalowaniu najnowszego OpenAI SDK i uwierzytelnieniu za pomocą klucza API, programiści po prostu określają jedną z dwóch nowych nazw modeli Deep Research w swoim żądaniu Chat Completions. Włączając narzędzia lubić web_search_preview oraz code_interpreter i ustawienie background Po ustawieniu flagi na wartość true model autonomicznie rozkłada zapytania wysokiego poziomu na podpytania, uruchamia wyszukiwania, wykonuje analizy i zwraca ustrukturyzowany raport z dużą ilością cytowań — w komplecie z wbudowanymi metadanymi i adresami URL źródeł.

To uruchomienie stanowi znaczącą ewolucję w planie rozwoju produktu OpenAI. Na początku tego roku, w lutym 2025 r., agent Deep Research zadebiutował w ChatGPT jako funkcja „następnej generacji” — obsługiwana przez zoptymalizowaną wersję o3 — do zadań, które kiedyś pochłaniały analityków ludzkich dziesiątki godzin. Łączył przeglądanie, korzystanie z narzędzi Python i iteracyjne rozumowanie, aby generować dokładne, weryfikowalne wyniki w mniej niż pół godziny. Dzięki wydaniu API przedsiębiorstwa i startupy mogą osadzić tę moc analityczną we własnych aplikacjach, napędzając przypadki użycia od wywiadu konkurencyjnego i przeglądów literatury po techniczną należytą staranność i nie tylko.

Co więcej, szersze wdrożenie wyszukiwania w sieci w modelach o3, o3-pro i o4-mini zaciera granicę między wiedzą statyczną a wyszukiwaniem informacji w czasie rzeczywistym. Deweloperzy mogą teraz tworzyć monity, które instruują model, aby „znaleźć najnowsze kwartalne ogłoszenie o zarobkach” lub „podsumować bieżące zmiany regulacyjne w zakresie prywatności danych w UE”, a model będzie autonomicznie pobierał, interpretował i cytował odpowiednie źródła — wszystko w ramach jednej transakcji API. To ujednolicone podejście kontrastuje z wcześniejszymi wzorcami, w których wymagane były oddzielne potoki wyszukiwania i podsumowywania, co zmniejszało złożoność integracji i opóźnienia.

Z perspektywy biznesowej, korekty cen towarzyszące tym funkcjom odzwierciedlają dążenie OpenAI do demokratyzacji zaawansowanego rozumowania przy jednoczesnym zarządzaniu kosztami infrastruktury. Stawka 10 USD/1 tys. za połączenie z wyszukiwaniem w sieci rozumowania pozycjonuje usługę konkurencyjnie w stosunku do wyspecjalizowanych dostawców danych, podczas gdy obniżona stawka 25 USD/1 tys. za wyszukiwanie w sieci GPT-4o/4.1 podkreśla zaangażowanie OpenAI w uczynienie dynamicznej, opartej na narzędziach AI przystępną cenowo na dużą skalę.

Patrząc w przyszłość, OpenAI zasygnalizowało trwające inwestycje w ekosystem Deep Research: aktualizacje modeli, rozszerzone wsparcie narzędzi (w tym bezpośrednie łączniki baz danych i prywatne integracje dokumentów za pośrednictwem MCP) oraz głębsze funkcje analizy multimodalnej są na mapie drogowej. W miarę dojrzewania tych możliwości granica między AI jako partnerem konwersacyjnym a AI jako autonomicznym asystentem badawczym będzie się nadal zacierać — zapowiadając nową erę aplikacji agentowych, które mogą badać, rozumować i dostarczać praktycznych spostrzeżeń przy minimalnej ingerencji człowieka.

Jak zacząć

CometAPI zapewnia ujednolicony interfejs REST, który agreguje setki modeli AI — w ramach spójnego punktu końcowego, z wbudowanym zarządzaniem kluczami API, limitami wykorzystania i panelami rozliczeniowymi. Zamiast żonglować wieloma adresami URL dostawców i poświadczeniami.

Deweloperzy mogą uzyskać dostęp Interfejs API o3-Pro(model: o3-pro; o3-pro-2025-06-10), Interfejs API O3 (model:o3;o3-2025-04-16 )I Interfejs API O4-Mini(model: o4-mini;o4-mini-2025-04-16) Poprzez Interfejs API Comet, najnowsze wymienione modele są z dnia publikacji artykułu. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Najnowsza integracja o3-deep-research(model:

o3-deep-research-2025-06-26) i o4-mini-deep-research (model: o4-mini-deep-research-2025-06-26) wkrótce pojawi się w CometAPI, więc bądźcie czujni! Podczas gdy my finalizujemy przesyłanie modelu Gemini 2.5 Flash‑Lite, zapoznajcie się z naszymi innymi modelami na stronie Modele lub wypróbujcie je w AI Playground.