Interfejs API Qwen2.5-Omni-7B udostępnia programistom zgodne ze standardem OpenAI metody interakcji z modelem, umożliwiając przetwarzanie tekstu, obrazów, dźwięku i wideo oraz generowanie odpowiedzi tekstowych i mowy naturalnej w czasie rzeczywistym.

Czym jest Qwen2.5-Omni-7B?

Qwen2.5-Omni-7B to flagowy multimodalny model AI firmy Alibaba, który może pochwalić się 7 miliardami parametrów. Zaprojektowany do przetwarzania i rozumienia wielu modalności danych, obsługuje dane wejściowe tekstowe, graficzne, audio i wideo. Model ułatwia interakcje mowy i wideo w czasie rzeczywistym, co czyni go wszechstronnym narzędziem do różnych zastosowań.

Główne cechy Qwen2.5-Omni-7B

- Przetwarzanie multimodalne: Potrafi obsługiwać różnorodne dane wejściowe, w tym tekst, obrazy, dźwięki i wideo, umożliwiając kompleksowe zrozumienie danych.

- Interakcja w czasie rzeczywistym: Obsługuje przetwarzanie o niskim opóźnieniu, umożliwiając prowadzenie rozmów głosowych i wideo w czasie rzeczywistym.

- Architektura myśliciela-mówcy: Wykorzystuje system o podwójnej architekturze, w którym „Myśliciel” zarządza przetwarzaniem i zrozumieniem danych, natomiast „Mówca” generuje płynne wypowiedzi.

- Multimodalny system RoPE z wyrównanym czasem (TMRoPE): Wykorzystuje TMRoPE do precyzyjnej synchronizacji danych czasowych w różnych modalnościach, zapewniając spójne zrozumienie i generowanie odpowiedzi.

Wskaźniki wydajności

Osiągnięcia wzorcowe

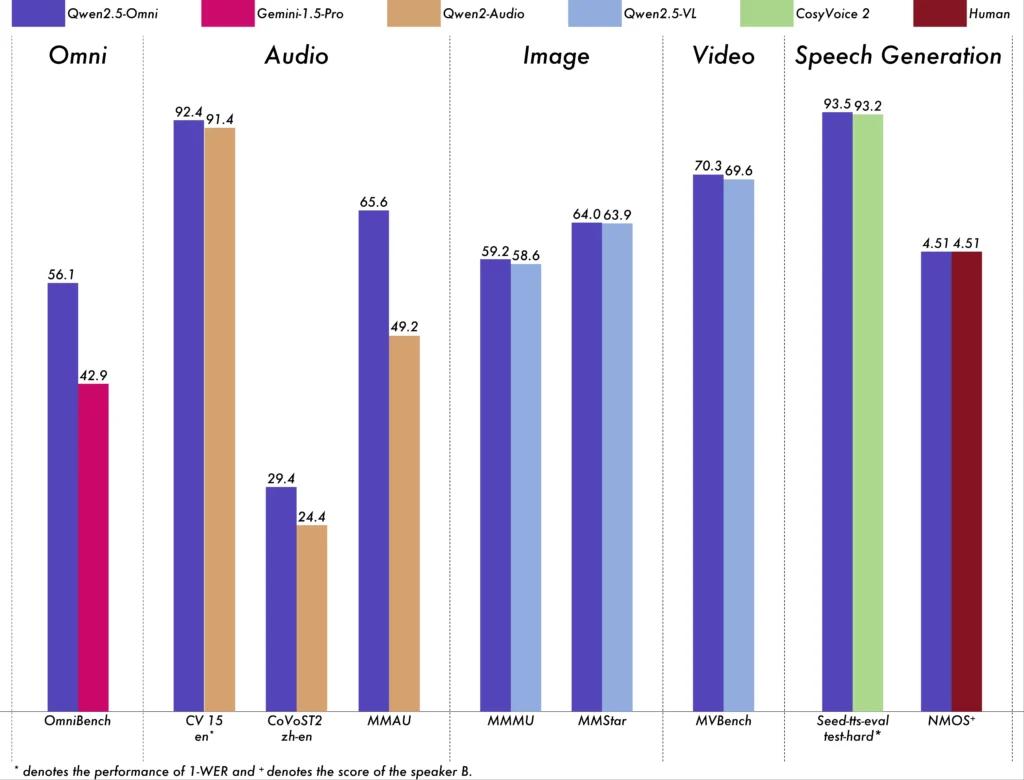

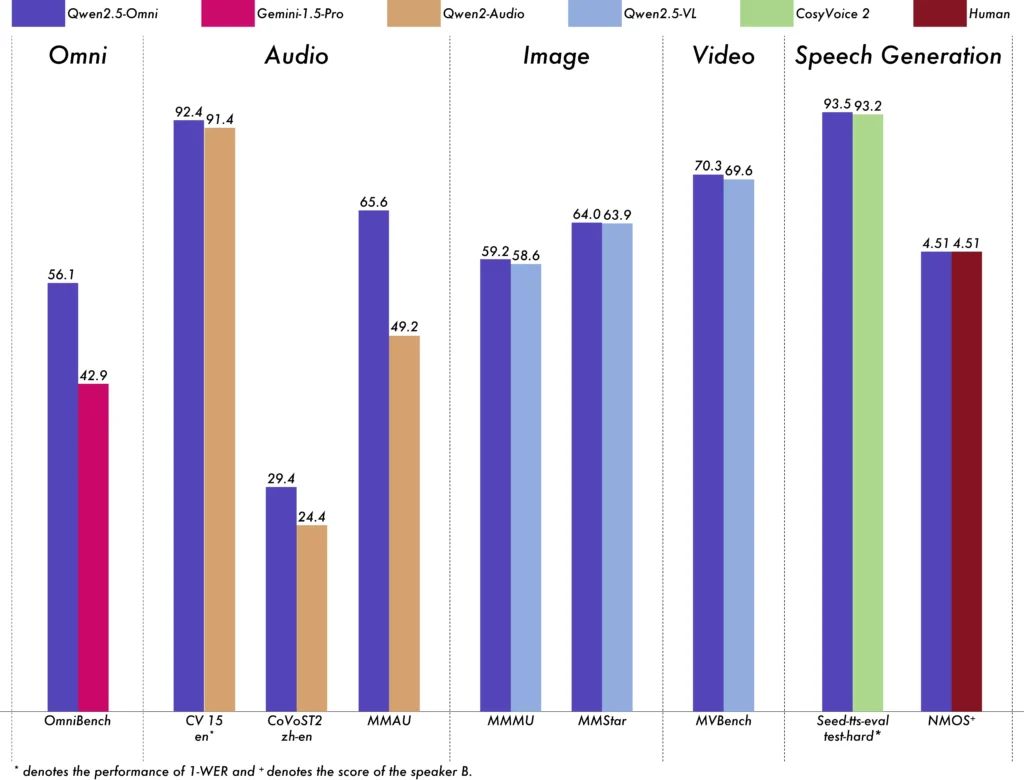

Qwen2.5-Omni-7B wykazał wyjątkową wydajność w różnych testach porównawczych:

- OmniBench: Osiągnął średni wynik na poziomie 56.13%, przewyższając takie modele jak Gemini-1.5-Pro (42.91%) i MIO-Instruct (33.80%).

- Rozpoznawanie mowy: W zbiorze danych Librispeech osiągnięto współczynnik błędów słownych na poziomie od 1.6% do 3.5%, co jest wartością porównywalną ze specjalistycznymi modelami, takimi jak Whisper-large-v3.

- Rozpoznawanie zdarzeń dźwiękowych: Uzyskano wynik 0.570 w zestawie danych Meld, co stanowi nowy punkt odniesienia w tej dziedzinie.

- Rozumienie muzyki: Osiągnął wynik 0.88 w teście GiantSteps Tempo, co potwierdza jego biegłość w rozumieniu muzyki.

Możliwości przetwarzania w czasie rzeczywistym

Zaprojektowany do aplikacji w czasie rzeczywistym, Qwen2.5-Omni-7B obsługuje strumieniowanie blok po bloku, umożliwiając natychmiastową generację dźwięku z minimalnym opóźnieniem. Ta funkcja jest szczególnie korzystna dla aplikacji wymagających szybkich odpowiedzi, takich jak wirtualni asystenci i interaktywne systemy AI.

Specyfikacja techniczna

Styl architektoniczny

- Model myślenia-mówienia: Komponent „Thinker” przetwarza i rozumie multimodalne dane wejściowe, generując semantyczne reprezentacje wysokiego poziomu i tekstowe dane wyjściowe. „Talker” konwertuje te reprezentacje na naturalną, płynną mowę, zapewniając bezproblemową komunikację między systemem AI a użytkownikami.

- Mechanizm TMRoPE: Rozwiązuje problem synchronizacji danych czasowych z różnych źródeł poprzez dopasowywanie znaczników czasu sygnałów wejściowych wideo i audio, ułatwiając spójne zrozumienie multimodalne.

Metodologia szkolenia

Model przeszedł trzyetapowy proces szkolenia:

- Faza pierwsza: Naprawiono parametry modelu języka podczas szkolenia koderów wizualnych i dźwiękowych, wykorzystując rozbudowane pary dźwięk-tekst i obraz-tekst, aby poprawić zrozumienie multimodalne.

- Faza druga: Odmrożono wszystkie parametry i przeprowadzono trening na zróżnicowanym zestawie danych obejmującym obrazy, wideo, dźwięk i tekst, co jeszcze bardziej poprawiło kompleksowe rozumienie multimodalne.

- Faza trzecia: Skupiono się na szkoleniu danych długich sekwencji, aby zwiększyć zdolność modelu do obsługi złożonych, rozszerzonych danych wejściowych.

Ewolucja modeli Qwen

Progresja z Qwen do Qwen2.5

Ewolucja od Qwen do Qwen2.5 oznacza znaczący skok w rozwoju modeli sztucznej inteligencji:

- Ulepszone parametry: Qwen2.5 rozszerzono do modeli obsługujących nawet 72 miliardy parametrów, oferując skalowalne rozwiązania dla różnych zastosowań.

- Rozszerzone przetwarzanie kontekstu: Wprowadzono możliwość przetwarzania do 128,000 XNUMX tokenów, co ułatwia obsługę obszernych dokumentów i prowadzenie skomplikowanych konwersacji.

- Możliwości kodowania: Wersja Qwen2.5-Coder obsługuje ponad 92 języki programowania, wspomagając generowanie kodu, debugowanie i optymalizację.

Zalety Qwen2.5-Omni-7B

Kompleksowa integracja multimodalna

Dzięki efektywnemu przetwarzaniu tekstu, obrazów, dźwięku i wideo Qwen2.5-Omni-7B zapewnia kompleksowe rozwiązanie z zakresu sztucznej inteligencji, odpowiednie do szerokiej gamy zastosowań.

Interakcja w czasie rzeczywistym

Niskie opóźnienie przetwarzania gwarantuje natychmiastowe reakcje, zwiększając komfort korzystania z aplikacji interaktywnych.

Dostępność Open Source

Jako model typu open source, Qwen2.5-Omni-7B promuje przejrzystość i pozwala programistom dostosowywać i integrować model na różnych platformach bez ograniczeń własnościowych.

Wskaźniki techniczne

- Parametry modelu: 7 miliardów

- Sposoby wprowadzania danych: Tekst, Obraz, Dźwięk, Wideo

- Sposoby wyprowadzania danych: Tekst, Mowa

- Zdolność przetwarzania: Interakcja głosowa i wideo w czasie rzeczywistym

- Testy wydajności:

- OmniBench: 56.13% średnia ocena

- Librispeech (współczynnik błędów w słowach): Test-czysty: 1.8%, Test-inny: 3.4%

Scenariusze aplikacji

Interaktywni wirtualni asystenci

Przetwarzanie w czasie rzeczywistym i multimodalne rozumienie Qwen2.5-Omni-7B sprawiają, że urządzenie to idealnie nadaje się dla wirtualnych asystentów, którzy potrafią widzieć, słyszeć i reagować w sposób naturalny.

Tworzenie treści multimedialnych

Twórcy treści mogą wykorzystać ten model do generowania angażujących treści multimedialnych, płynnie łączących tekst, obrazy i dźwięk.

Technologie wspomagające

Możliwości tego modelu mogą pomóc osobom niepełnosprawnym, np. poprzez zapewnienie opisowego dźwięku do treści wizualnych.

Wskazówki dotyczące użytkowania

Optymalizacja wydajności

Aby uzyskać optymalną wydajność, zwłaszcza w aplikacjach czasu rzeczywistego, zaleca się wykorzystanie akceleratorów sprzętowych i zapewnienie odpowiedniej ilości pamięci GPU.

Integracja z istniejącymi systemami

Podczas integracji z istniejącymi aplikacjami programiści powinni brać pod uwagę formaty wejściowe i wyjściowe modelu, aby zapewnić zgodność i zmaksymalizować wydajność.

Bądź na bieżąco

Regularnie sprawdzaj oficjalne repozytoria i dokumentację w celu zapoznania się z aktualizacjami i najlepszymi praktykami, aby w pełni wykorzystać możliwości Qwen2.5-Omni-7B.

Tematy pokrewne Jak uruchomić model Qwen2.5-Omni-7B

Podsumowanie

Qwen2.5-Omni-7B jest przykładem konwergencji zaawansowanych badań nad sztuczną inteligencją i praktycznych zastosowań, oferując wszechstronne i wydajne rozwiązanie dla wielu zadań w różnych branżach. Jego charakter open source zapewnia, że pozostaje dostępny i adaptowalny, torując drogę przyszłym innowacjom w multimodalnej sztucznej inteligencji.

Jak wywołać Qwen2.5-Omni-7B API z CometAPI

1.Zaloguj Się do pl.com. Jeśli jeszcze nie jesteś naszym użytkownikiem, zarejestruj się najpierw

2.Uzyskaj klucz API danych uwierzytelniających dostęp interfejsu. Kliknij „Dodaj token” przy tokenie API w centrum osobistym, pobierz klucz tokena: sk-xxxxx i prześlij.

-

Uzyskaj adres URL tej witryny: https://api.cometapi.com/

-

Wybierz punkt końcowy Qwen2.5-Omni-7B, aby wysłać żądanie API i ustawić treść żądania. Metoda żądania i treść żądania są uzyskiwane z dokumentacja API naszej witryny internetowej. Nasza strona internetowa udostępnia również test Apifox dla Twojej wygody.

-

Przetwórz odpowiedź API, aby uzyskać wygenerowaną odpowiedź. Po wysłaniu żądania API otrzymasz obiekt JSON zawierający wygenerowane uzupełnienie.