Interfejs API Comet pojawia się jako platforma jednocząca, gdy deweloperzy i firmy stają w obliczu rosnącej złożoności podczas integrowania i zarządzania różnymi modelami AI, oferując pojedynczą bramę do ponad 500 modeli AI na całym świecie. Poprzez agregację wiodących usług — od dużych modeli językowych po najnowocześniejsze systemy multimodalne — CometAPI usprawnia przepływy pracy programistycznej, obniża koszty i przyspiesza czas wprowadzania na rynek. Ten artykuł zagłębia się w podstawy CometAPI, bada jego wewnętrzne działanie, prowadzi przez kroki użytkowania i podkreśla najnowsze aktualizacje modeli zasilające jego ekosystem.

Czym jest CometAPI?

Zunifikowana platforma agregacji modeli AI

CometAPI to platforma agregacji API zorientowana na deweloperów, która ujednolica dostęp do ponad 500 modeli sztucznej inteligencji w ramach jednego, spójnego interfejsu. Zamiast integrować się oddzielnie z serią GPT OpenAI, Claude, Midjourney, Suno, Gemini firmy Google i innymi, deweloperzy wysyłają żądania do punktu końcowego CometAPI i określają żądany model według nazwy. Ta konsolidacja radykalnie upraszcza działania integracyjne, zmniejszając narzut związany z zarządzaniem wieloma kluczami API, punktami końcowymi i systemami rozliczeniowymi.

Kluczowe zalety dla deweloperów i przedsiębiorstw

Centralizując modele na jednej platformie, CometAPI zapewnia:

- Uproszczone rozliczanie:Jedna ujednolicona faktura obejmująca wykorzystanie wszystkich modeli, co pozwala uniknąć rozproszonych rachunków od dostawców.

- Niezależność dostawców:Łatwa zmiana modeli bez blokowania, co zapewnia długoterminową elastyczność.

- Wysoka współbieżność i niskie opóźnienie:Bezserwerowa sieć szkieletowa zapewnia nieograniczoną liczbę transakcji na minutę i czas reakcji poniżej 200 ms dla większości połączeń tekstowych.

- Optymalizacja kosztów:Rabaty ilościowe sięgające 20% na popularne modele pomagają zespołom kontrolować wydatki na sztuczną inteligencję.

Jak działa CometAPI?

Architektura i kluczowe komponenty

Rdzeniem CometAPI jest wydajna, bezserwerowa infrastruktura, która automatycznie skaluje się, aby sprostać zapotrzebowaniu. Przychodzące żądania przechodzą przez globalny moduł równoważenia obciążenia i są kierowane do najbardziej odpowiedniego punktu końcowego dostawcy modelu — OpenAI, Anthropic, Google Cloud i innych — na podstawie czynników takich jak opóźnienie i koszt. W tle CometAPI utrzymuje:

- Zarządzanie kluczami API:Bezpieczne przechowywanie kluczy użytkowników i obsługa automatycznej rotacji.

- Silnik mnożnika szybkości:Przejrzyste mnożniki cenowe dostosowane do oficjalnych cenników modelowych, zapewniające spójność kosztów.

- Śledzenie użytkowania i rozliczenia:Panele pomiarowe w czasie rzeczywistym wyświetlające zużycie tokenów, wykorzystanie modeli i alerty dotyczące wydatków.

Jak korzystać z CometAPI?

1. Zdobądź klucz API

Zarejestruj się, aby otrzymać bezpłatny CometAPI konto, aby otrzymać token (sformatowany jako sk-XXXXX) w Twoim panelu. Ten token zapewnia dostęp do wszystkich zintegrowanych modeli i jest używany w Authorization nagłówek żądania API.

2. Skonfiguruj adres URL bazowy

W swojej bazie kodu ustaw adres URL bazy na:

https://www.cometapi.com/console/

Wszystkie kolejne wywołania — niezależnie od tego, czy dotyczą uzupełniania tekstu, generowania obrazów czy wyszukiwania plików — są kierowane przez ten pojedynczy punkt końcowy.

Różni klienci mogą musieć wypróbować następujące adresy:

- https://www.cometapi.com/console/

- https://api.cometapi.com/v1

- https://api.cometapi.com/v1/chat/completions

3. Wykonaj wywołania API w formacie OpenAI

CometAPI akceptuje żądania zgodnie ze schematem API OpenAI. Na przykład, aby wygenerować tekst z GPT-4.1:

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-XXXXX" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4.1",

"messages":

}'

Odpowiedzi i kody błędów odzwierciedlają te pochodzące od oryginalnych dostawców modeli, co umożliwia bezproblemową migrację istniejących integracji opartych na OpenAI.

zastąpić

YOUR_API_KEYza pomocą klucza API uzyskanego podczas rejestracji.

Przykład kodu:

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.cometapi.com/v1/chat/completions",

api_key=os.getenv("COMETAPI_KEY"),

)

response = client.chat.completions.create(

model="claude-opus-4-20250514",

messages=[

{"role": "system", "content": "You are a coding assistant."},

{"role": "user", "content": "Refactor this function to improve performance."},

],

)

print(response.choices.message.content)

Ten fragment kodu inicjuje klienta Anthropic za pośrednictwem CometAPI, wysyła żądanie ukończenia czatu do trybu natychmiastowego Claude Opus 4 i drukuje odpowiedź asystenta.

4. Przewodnik integracji oprogramowania

Zintegrowanie CometAPI z platformami innych firm (takimi jak n8n, Cherry Studio, Zapier, Cursor itp.) może znacznie zwiększyć wydajność rozwoju, obniżyć koszty i wzmocnić możliwości zarządzania. Jego zaleta:

- Narzędzia innych firm zazwyczaj obsługują wywoływanie interfejsów zgodnych z OpenAI za pośrednictwem HTTP/REST lub dedykowanych węzłów. Dzięki CometAPI jako dostawcy „za kulisami” możesz ponownie wykorzystać istniejące przepływy pracy lub ustawienia asystenta bez żadnych zmian, po prostu wskazując adres URL bazowy na https://www.cometapi.com/console/

- Po połączeniu z CometAPI nie ma potrzeby przełączania się między wieloma dostawcami. Możesz wypróbować różne modele (takie jak GPT-4o, Claude 3.7, Midjourney itp.) w tym samym środowisku za pomocą jednego kliknięcia, co znacznie przyspiesza postęp od koncepcji do weryfikowalnego prototypu.

- W porównaniu do rozliczania się z każdym dostawcą modelu osobno, CometAPI agreguje rachunki od każdego dostawcy i oferuje rabaty uzależnione od wykorzystania, co pozwala zaoszczędzić średnio 10–20% kosztów.

Można skorzystać z samouczków dotyczących popularnych aplikacji programowych:

- Przewodnik po konfiguracji kursora za pomocą CometAPI

- Jak używać Cherrystudio z CometAPI

- Jak używać n8n z CometAPI

Typowe scenariusze zastosowań:

- Zautomatyzowane procesy w n8n: najpierw użyj węzła żądania HTTP do wygenerowania obrazów (Midjourney), a następnie wywołaj GPT-4.1, aby utworzyć dla nich podpisy, co pozwoli na uzyskanie multimodalnego wyjścia za pomocą jednego kliknięcia.

- Asystent pulpitu w Cherry Studio: zarejestruj CometAPI jako niestandardowego dostawcę OpenAI, a administratorzy będą mogli precyzyjnie włączać/wyłączać wymagane modele w interfejsie graficznym, umożliwiając użytkownikom końcowym swobodne przełączanie się w tym samym oknie dialogowym. Cherry Studio automatycznie pobiera najnowszą listę modeli z /v1/models, a wszystkie nowo podłączone modele CometAPI będą wyświetlane w czasie rzeczywistym, co eliminuje konieczność ręcznych aktualizacji.

Jakie modele obsługuje CometAPI?

Łącząc dostawców, CometAPI oferuje szeroką i stale rozwijającą się bibliotekę możliwości sztucznej inteligencji.

Kategorie modeli

- Duże modele językowe: GPT (o4mini, o3, GPT-4o, GPT-4.1 itd.), Claude (claude 4 Sonnet, Opus itd.).Seria Google Gemini (Gemini 2.5).Qwen (Qwen 3, qwq),Modele oparte na Mistral i LLaMA (seria mistral-large .llama 4),Modele Deepseeka itd.

- Wizja i multimodalność:Midjourney (Fast Imagine, Custom Zoom), Luma, GPT-image-1, modele stable-diffusion.(sdxl itp.)

- Dźwięk i muzyka:Suno (Muzyka, Teksty), Udio.

- Inżynieria specjalistyczna i odwrotna: Grok, FLUX, Kling.text-embedding-ada-002 itp.

Najnowsze wydania modeli

Podgląd Gemini 2.5 Pro (2025-06-06):Wprowadza okno kontekstowe o pojemności 1 miliona tokenów i natywne możliwości multimodalne dla zaawansowanych zadań rozumowania. Oficjalna najnowsza wersja Gemini 2.5 Gemini 2.5 Pro Podgląd API (model: gemini-2.5-pro-preview-06-05) w CometAPI można uzyskać dostęp.

DeepSeek R1 (2025-05-28): Oferuje wydajność rozumowania na dużą skalę dla złożonych zadań zapytań, teraz dostępnych za pośrednictwem standardowego punktu końcowego czatu. Najnowsza oficjalna wersja DeepSeek R1 ——Interfejs API DeepSeek R1 (model: deepseek-r1-0528) w CometAPI można uzyskać dostęp.

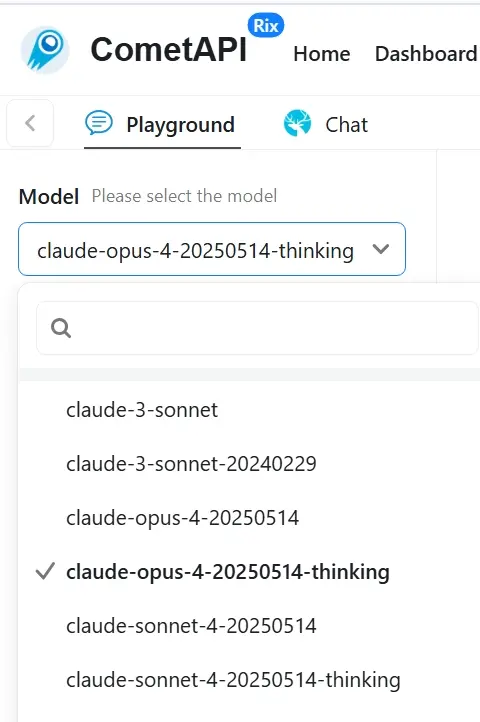

Klauzula 4 (2025-05-23): Ulepsza kodowanie i logiczne rozumowanie w serii Claude firmy Anthropic, zoptymalizowane pod kątem opłacalnego użytkowania w przedsiębiorstwach. Claude 4 oficjalna najnowsza wersja ——Claude Opus 4 API (model: claud; claude-opus-4-20250514-thinking)I Claude Sonnet 4 API (model: claude-sonnet-4-20250514 ;claude-sonnet-4-20250514-thinking) w CometAPI można uzyskać dostęp. Dodaliśmy również cometapi-sonnet-4-20250514-thinking specjalnie do użytku w Cursor.

GPT-Obraz-1 (2025-04-27):Zapewnia dostęp deweloperów do możliwości generowania obrazu GPT-4o, obsługując wysokiej jakości wyniki i zróżnicowane stylistyczne renderowanie. Interfejs API GPT-image-1 jest trzecim najlepszym modelem pod względem liczby odwiedzin na stronie internetowej

Seria GPT-4.1 (2025-04-15):Zawiera warianty mini i nano, które równoważą wydajność z obniżonym opóźnieniem i kosztami, ustanawiając nowe standardy dla zadań długiego kontekstu. Oficjalna najnowsza wersja GPT 4.1 ——API GPT-4.1 (model: gpt-4.1;gpt-4.1-nano;gpt-4.1-mini) w CometAPI.

Jednolity dostęp do nowych modeli

CometAPI ogłosiło wsparcie zaawansowanych modeli inżynierii wstecznej i rozszerzyło dostęp do Midjourney i Suno dla aplikacji sztuki generatywnej i muzyki. Użytkownicy mogą teraz wywoływać te modele bezpośrednio za pośrednictwem ujednoliconego API CometAPI, korzystając ze zniżek do 20 procent na popularne oferty.

Na chwilę obecną cometAPI podąża za oficjalnym tempem. API muzyki Suno został zaktualizowany do wersji v4.5 i API w trakcie podróży został zaktualizowany do wersji v7. Aby uzyskać szczegółowe informacje o API i wywołaniach, zapoznaj się z dokumentacją API napisaną specjalnie dla w połowie podróży oraz słońce. Jeśli chcesz wywołać inne modele wizualne w celu wygenerowania obrazów lub filmów, takich jak sora, runway itp., zapoznaj się z dedykowanymi dokumentami referencyjnymi na stronie internetowej.

Uwaga: Ta lista ma charakter poglądowy, a nie wyczerpujący. CometAPI stale dodaje nowych dostawców i wersje modeli, gdy tylko staną się publicznie dostępne — często w ciągu kilku dni od oficjalnego uruchomienia — więc zawsze będziesz mieć natychmiastowy dostęp do najnowszych przełomów bez zmiany kodu.

Aby zobaczyć pełną, aktualną listę wszystkich 500+ modeli, uzyskaj dostęp Strona modelu

FAQ

1. Jakiego modelu cenowego używa CometAPI?

CometAPI stosuje transparentne mnożniki do oficjalnych cen modelowych — mnożniki są spójne u różnych dostawców. Rozliczanie odbywa się w trybie pay-as-you-go ze szczegółowym pomiarem opartym na tokenach i opcjonalnymi rabatami ilościowymi dla kont o dużym wykorzystaniu.

2. Czy mogę monitorować wykorzystanie w czasie rzeczywistym?

Tak. Pulpit CometAPI wyświetla bieżące metryki wywołań API, wykorzystania tokenów i wydatków. Możesz ustawić niestandardowe alerty, aby powiadomić zespół o osiągnięciu progów.

3. Jak obsługiwać duże okna kontekstowe?

CometAPI obsługuje modele z oknami kontekstowymi do 1 miliona tokenów (np. Gemini 2.5 Pro, GPT-4.1-nano), umożliwiając złożone zadania o długiej formie. Wystarczy podać nazwę modelu w wywołaniu API, a CometAPI odpowiednio przekieruje żądanie.

4. Jakie środki bezpieczeństwa obowiązują?

Cały ruch API jest szyfrowany za pomocą TLS 1.3. Klucze API są bezpiecznie przechowywane w sprzętowych sejfach kluczy. W przypadku klientów korporacyjnych zaszyfrowane elementy rozumowania i kontrole retencji danych spełniają standardy zgodności z zerowym retencją.

5. Jak mogę uzyskać pomoc lub zgłosić problem?

CometAPI zapewnia szczegółową dokumentację, aktywną społeczność Discord i pomoc techniczną pod adresem . Klienci korporacyjni otrzymują również dedykowane zarządzanie kontem oraz umowy SLA dotyczące czasu sprawności i wydajności.

Podsumowanie

Konsolidując setki modeli AI w ramach jednego interfejsu API, CometAPI umożliwia programistom szybsze iterowanie, kontrolowanie kosztów i pozostawanie niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów. Niezależnie od tego, czy budujesz kolejną generację chatbotów, generatorów treści multimedialnych czy opartych na danych potoków analitycznych, CometAPI zapewnia ujednolicone podstawy, których potrzebujesz, aby przyspieszyć swoje ambicje w zakresie AI.